介绍1×1卷积核作用

一.升维/降维(改变特征图通道数)

池化层压缩特征图的高度和宽度,1×1卷积核可压缩通道数!

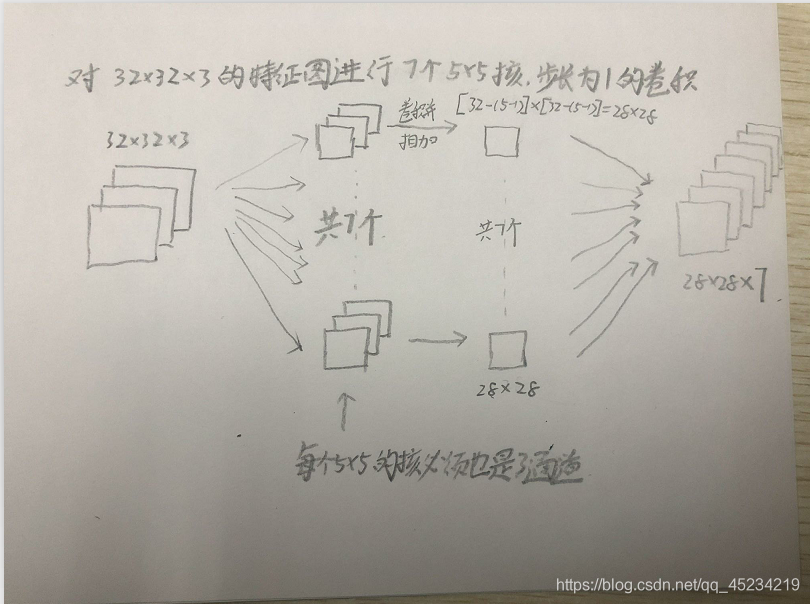

假设有一个32×32×3的特征图,可以使用池化层压缩它的高度和宽度。但如果通道数量很大,该如何把它压缩为28×28×7的特征图?可以用7个大小为1×1的过滤器,每个过滤器大小都是1×1×3维,因为过滤器中通道数量必须与输入层中通道的数量保持一致。

二.可以实现多个feature map 线性叠加实现特征组合

在1×1核的个数与特征图通道数相同时,卷积后不改变特征图的通道数,但是由于卷积核中的数值是权重b,且每个1×1卷积核中的权重值都不同,所以用1×1卷积核进行卷积后可以实现多个feature map 线性叠加实现特征组合。

三. 可给网络加入了非线性

后接非线性激活函数如ReLU,可以在保持特征图尺度不变的前提下大幅增加非线性特性。非线性允许网络学习更复杂的功能,并且使得整个网络能够进一步加深。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?