tensorflow1.0入门学习

一、 简介:

tensorflow版本:2.3

在2.x 版本下学习1.0的内容

二、 实现简单的梯度下降

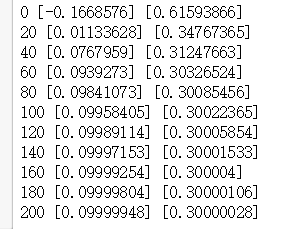

拟合线性函数:y=0.1*x+0.3

效果:

代码:

import tensorflow.compat.v1 as tf

tf.disable_eager_execution() #禁用Tensorflow2 默认的即时执行模式

import numpy as np

# 自定义真实数据:

# x_data:自定义一组数据,在tf中多使用float32,所以定制时也用float32

x_input = np.random.rand(100).astype(np.float32) #随机生成一组data

# 我们给定的正确函数,w=0.1,b=0.3 目的想要tf能够学习并更新其模型参数接近这个值

y_data = x_input*0.1+0.3

# 构建tf结构:

# 定义权值变量,维度为1,初始值范围-0.1~1.0

Weight = tf.Variable(tf.random_uniform([1],-1.0,1.0))

# 定义偏置变量,初始值为0

biases = tf.Variable(tf.zeros([1]))

# 定义预测的y

y = x_input*Weight + biases

# 定义loss函数(mean square),预测的y与实际y_data之间的差别

loss = tf.reduce_mean(tf.square(y_data-y))

# 定义优化器,更新网络中的权值

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.5)

train = optimizer.minimize(loss)

# 初始化模型图中设定的参数

init = tf.initialize_all_variables()

# 建立会话,控制图的流动

sess = tf.Session()

sess.run(init)

# 开始训练

for step in range(201):

sess.run(train)

if step % 20 == 0:

print(step,sess.run(Weight),sess.run(biases))

三、实现自动拟合绘制曲线

绘制曲线拟合近似抛物线函数:y=x^2 -0.5

效果:

代码:

import tensorflow.compat.v1 as tf

tf.disable_eager_execution() #禁用Tensorflow2 默认的即时执行模式

import numpy as np

# 输入数据的特征维度决定in_size

# 层中单元个数决定out_size

# 指定激活函数af

def add_layer(inputs,in_size,out_size,af=None):

Weights = tf.Variable(tf.random_normal([in_size,out_size]))

biases = tf.Variable(tf.zeros([1,out_size])+0.1)

# 输入的数据乘权值再加偏置

Wx_plus_b = tf.matmul(inputs,Weights)+biases

if af is None:

outputs = Wx_plus_b

else:

outputs = af(Wx_plus_b)

return outputs

import numpy as np

import matplotlib.pyplot as plt

# 构造输入数据

x_data = np.linspace(-1,1,300)[:,np.newaxis]

# 构造噪点

noise = np.random.normal(0,0.05,x_data.shape)

# 真实输出数据与输入data之间的关系:y=x^2-0.5

#为了更接近于实际的数据添加一些噪点noise

y_data = np.square(x_data)-0.5+noise

# 构建模型

# 定义占位符:

# None表示无论给多少个例子都ok,1表示数据的维度只有1

xs = tf.placeholder(tf.float32,[None,1])

ys = tf.placeholder(tf.float32,[None,1])

# 第二层(隐藏层):输入数据特征维度为1,隐藏层含10个单元数,

# 用relu函数激活。每个单元需要1个w和1个b,params=20

layer1 = add_layer(xs,1,10,af=tf.nn.relu)

# 第三层(输出层):输入数据特征维度与前一层的单元个数一致,输出层含1个单元数

pre = add_layer(layer1,10,1,af=None)

# 定义损失

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys-pre),reduction_indices=[1]))

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

fig = plt.figure() # 生成一个图片框来显示数据

ax = fig.add_subplot(1,1,1)

ax.scatter(x_data,y_data)

# 想要连续的绘制曲线得调用

plt.ion()

plt.show()

# 初始所有变量

init = tf.initialize_all_variables()

sess = tf.Session()

sess.run(init)

for i in range(1000):

sess.run(train_step, feed_dict={xs: x_data, ys: y_data})

if i % 20 == 0:

try:

ax.lines.remove(lines[0]) # 先抹除上一条线再绘制新的曲线

except Exception:

pass

# print(sess.run(loss,feed_dict={xs:x_data,ys:y_data}))

# 每训练50步就获取一次模型的预测值

pre_value = sess.run(pre, feed_dict={xs: x_data, ys: y_data})

# 将预测的值用曲线的方式绘制到图像框中

lines = ax.plot(x_data, pre_value, 'r-', lw=5)

plt.pause(0.1) # 暂停0.1秒

plt.pause(-1)

其中涉及到一些 matplotlib.pyplot绘图的内容

四、 利用Tensorboard可视化模型

tensorflow是核心是构建图,利用tensorboard工具可显示出我们构造的图。

利用tf.name_scope()可指定模块的名称

代码:

- 构建模型

import tensorflow as tf

import numpy as np

def add_layer(inputs,in_size,out_size,af=None,layer_name):

#利用tf.name_scope()可指定模块的名称

with tf.name_scope(layer_name):

with tf.name_scope("wights"): #模块间可以嵌套

Weights = tf.Variable(tf.random_normal([in_size,out_size]))

with tf.name_scope("biases"):

biases = tf.Variable(tf.zeros([1,out_size])+0.1)

# 输入的数据乘权值再加偏置

Wx_plus_b = tf.matmul(inputs,Weights)+biases

if af is None:

outputs = Wx_plus_b

else:

outputs = af(Wx_plus_b)

return outputs

# 构建模型

# 定义占位符:

with tf.name_scope("inputs"):

xs = tf.placeholder(tf.float32,[None,1],name="x_input") #指定名字“x_input”

ys = tf.placeholder(tf.float32,[None,1],name="y_input")

layer1 = add_layer(xs,1,10,layer_name="layer_1",af=tf.nn.relu)

pre = add_layer(layer1,10,"layer_2",1,af=None

# 定义损失

with tf.name_scope("loss"):

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys-pre),reduction_indices=[1]))

with tf.name_scope("train"):

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

- 初始化并保存图

sess = tf.Session()

# 指定图形化保存路径

writer = tf.summary.FileWriter("logs/",sess.graph)

# 初始所有变量

sess.run(tf.initialize_all_variables())

运行完成之后,图默认保存在当前项目目录下的”logs/“文件夹中。

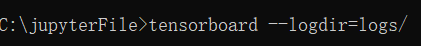

- 查看图

命令行下:先进入’logs/‘上一层目录,输入tensorboard --logdir=logs/,后回车

显示:

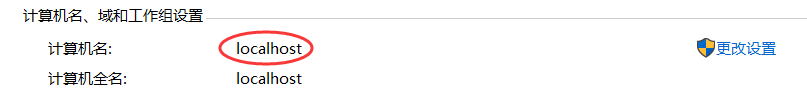

将该网址复制粘贴到游览器中。注意如果显示的不是’localhost’需要先将此电脑更名为”localhost“

我们构建的模型图就显示出来了!通过双击可查看各模块内的详细内容。 - Tensorboard记录参数、loss训练中的变化

1). 参数:

利用 tf.summary.histogram()方法

def add_layer(inputs,in_size,out_size,layer_name,af=None):

#利用tf.name_scope()可指定模块的名称

with tf.name_scope(layer_name):

with tf.name_scope("wights"):

Weights = tf.Variable(tf.random_normal([in_size,out_size]))

# 记录的该参数训练过程

tf.summary.histogram(layer_name+'/weights',Weights)

with tf.name_scope("biases"):

biases = tf.Variable(tf.zeros([1,out_size])+0.1)

tf.summary.histogram(layer_name+'/biases',biases)

# 输入的数据乘权值再加偏置

Wx_plus_b = tf.matmul(inputs,Weights)+biases

if af is None:

outputs = Wx_plus_b

else:

outputs = af(Wx_plus_b)

return outputs

2). loss

loss与其它参数不同,利用 tf.summary.scalar()方法

# 定义损失

with tf.name_scope("loss"):

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys-pre),reduction_indices=[1]))

# 记录的该loss训练过程中的变化

tf.summary.scalar('loss',loss)

with tf.name_scope("train"):

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

3). 合并与训练

sess = tf.Session()

# 将之前定义好的各种summary合并在一起,打包放在summary writer上

merged = tf.summary.merge_all()

# 指定图形化保存路径

writer = tf.summary.FileWriter("logs/",sess.graph)

# 初始所有变量

sess.run(tf.initialize_all_variables())

# 开始训练

for i in range(1000):

sess.run(train_step,feed_dict={xs:x_data,ys:y_data})

if i % 50 == 0:

result = sess.run(merged,feed_dict={xs:x_data,ys:y_data})

writer.add_summary(result,i) #每隔i步记录一次训练数据(w、b、loss)

然后利用同样的方法查看图

四、 Classification 分类学习

线性回归针对的是一系列连续的预测值,如房子价格等。

分类问题针对的是某些特定的分类,如手写体识别。

五、卷积神经网络

559

559

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?