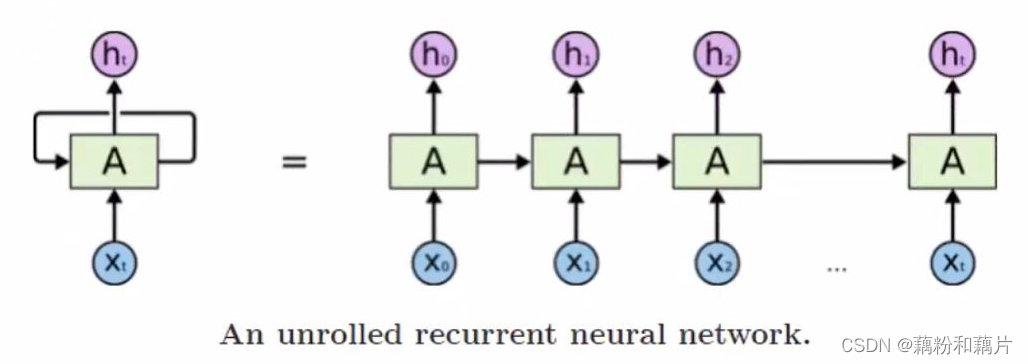

1.背景引入——RNN

适用于依赖时间序列来建模的行为;RNN的输入和输出并不是相互独立的,输出依赖于先前的计算。

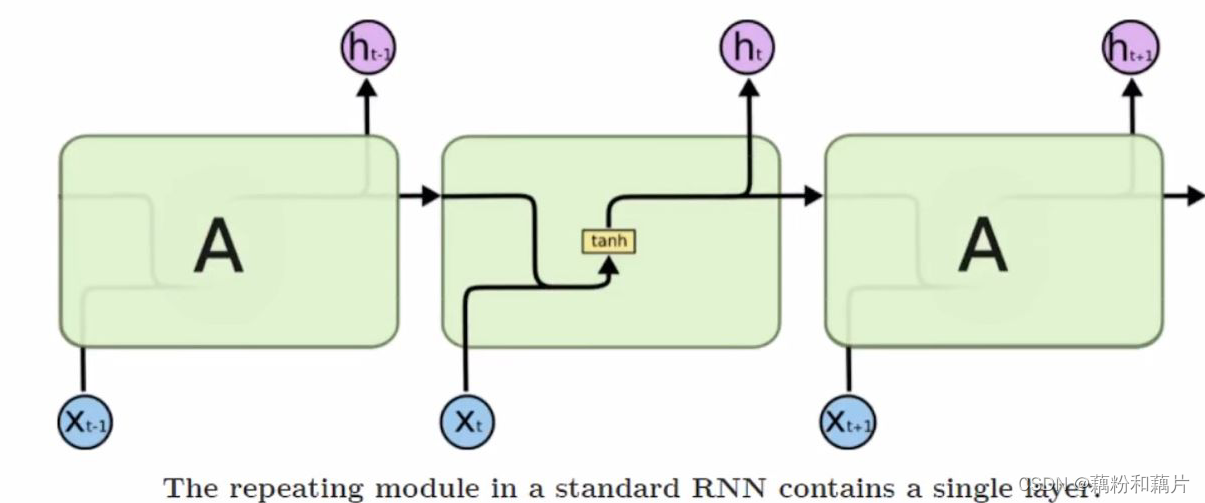

cell详情图

为什么RNN的激活函数用tanh,而不用CNN中效果比较好的激活函数ReLU?

为了避免梯度消失或爆炸。用ReLU的话初始化参数的值应该在1附近,否则随着长距离传递会导致梯度爆炸或者梯度消失。

优点

能够将先前的信息与当前任务联系起来。

缺点

RNN很难学习长距离依赖关系。

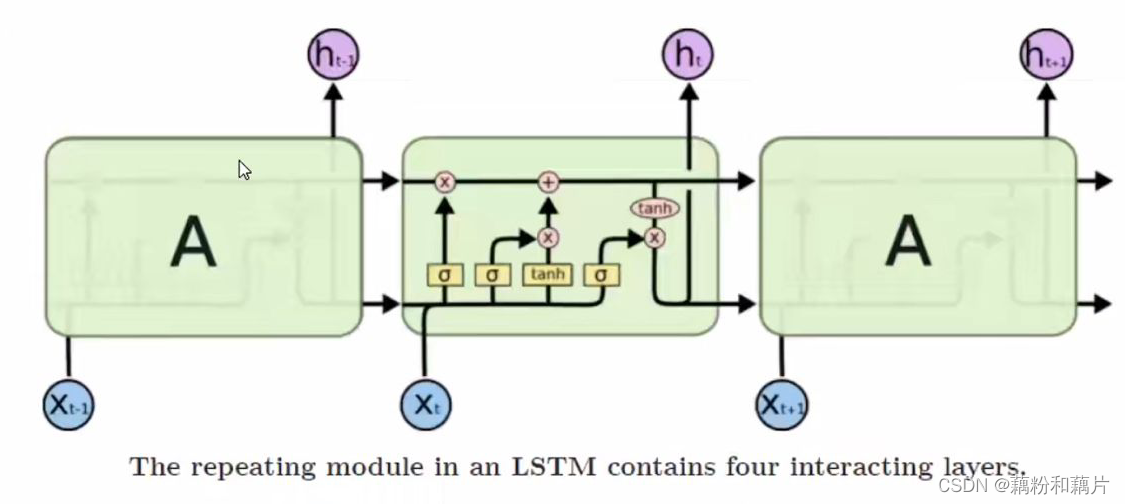

2.LSTM

序列中并不是每个观察值对于结果都是同等重要的。所以LSTM将记忆分为了长期记忆和短期记忆两部分。

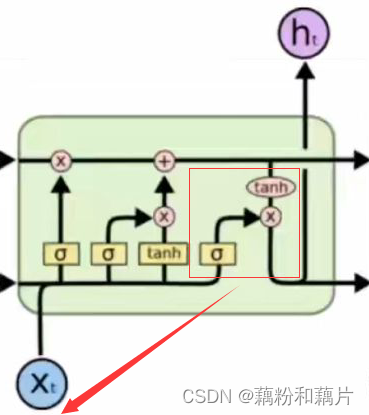

2.1长期记忆

如图,上方的线类似传送带,它沿着整个链条运行,贯穿始终,只有一些较小的线性相互作用,使得信息可以沿着它不变的流动。

2.2短期记忆(隐藏状态ht)

也就是图中每个cell都会输出的ht,也称为隐藏状态。它和下一个时刻的信息一起作为下一个时间节点的输入。可以把其理解为当前的记忆状态,是长期记忆当中在当前时刻需要被考虑的那部分记忆。

2.3门控调节单元

这部分决定了信息是被保留还是被遗忘,保留有效信息而去掉无用信息。

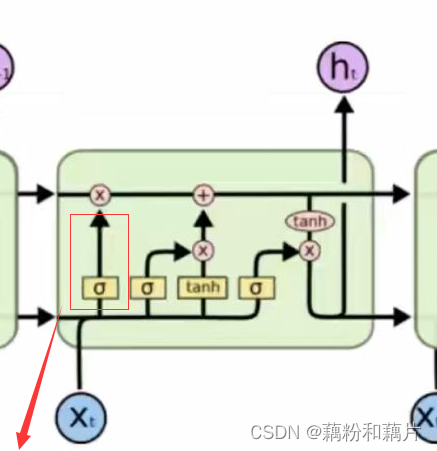

遗忘门

根据短期记忆的信息与目前的输入信息决定长期记忆中的信息是否需要被遗忘。简单来说,它将会输出长期记忆中所保留的百分比。

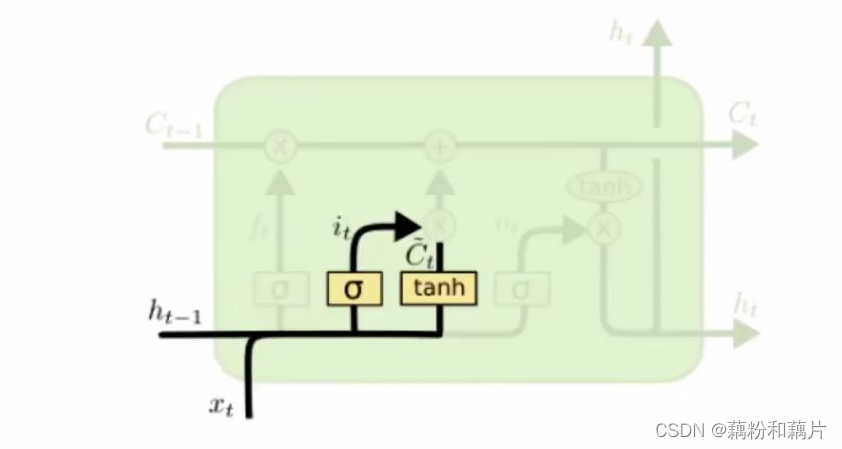

输入门

①sigmoid层决定将更新哪些值,换句话说,它决定长期记忆中哪些位置的信息会被替换。

②tanh层创建一个新的候选值向量,也就是用来替换长期记忆中部分信息的新的信息。

简单来说,输入门的作用是为了添加潜在长期记忆。

输出门

①sigmoid层决定保留当前时刻输入的哪些信息作为下一个时间节点的输入 ,也就是决定被保留的位置。

②将单元状态通过tanh(将值映射到-1和1之间)并将其乘以sigmoid,得到过滤后的信息,给下一个时间节点使用。

8298

8298

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?