为什么要用分布式事务

在微服务项目中,我们经常会用A服务先去调B服务执行持久化操作在执行自己的操作,这时候就会出现一个问题,B服务的持久化操作成功了,但A的失败了,事务回滚了,又因为这种调用关系到B服务返回的时候就已经结束了,就会导致A,B两个数据库不同步的问题,这时候就需要用到分布式事务了。

基于Seata的2pc解决方案

2PC即两阶段提交协议,是将整个事务流程分为两个阶段,准备阶段( Prepare phase).提交阶段( commit phase ) , 2是指两个阶段, P是指准备阶段, C是指提交阶段。

2PC

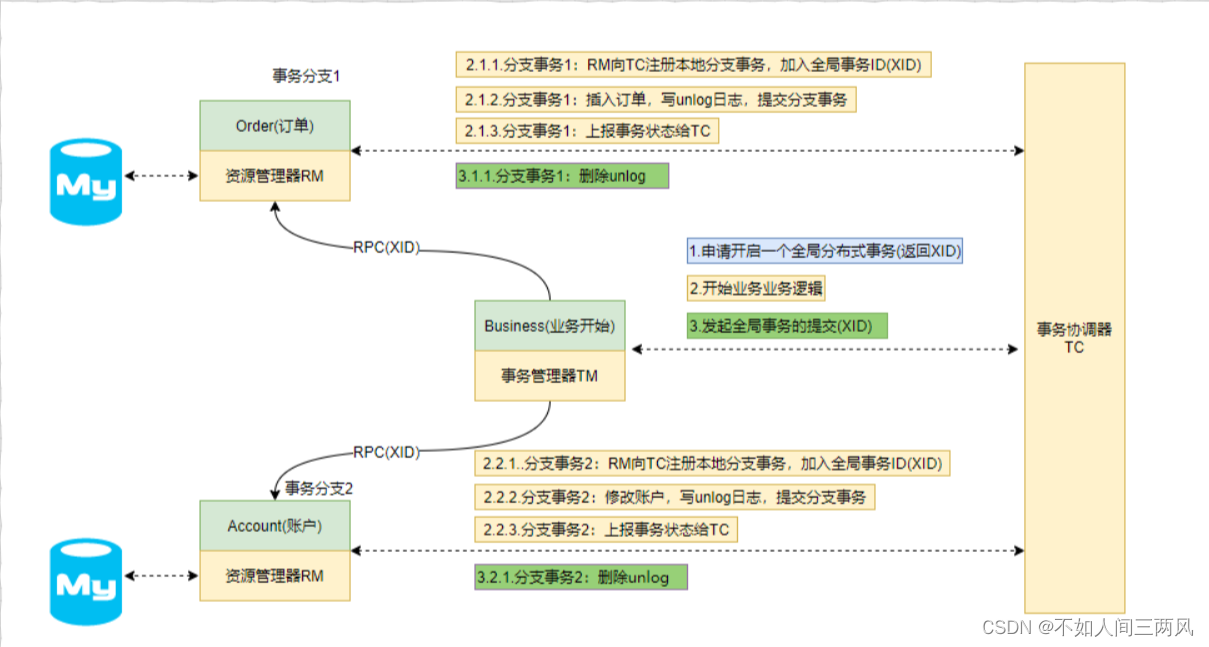

成功执行流程

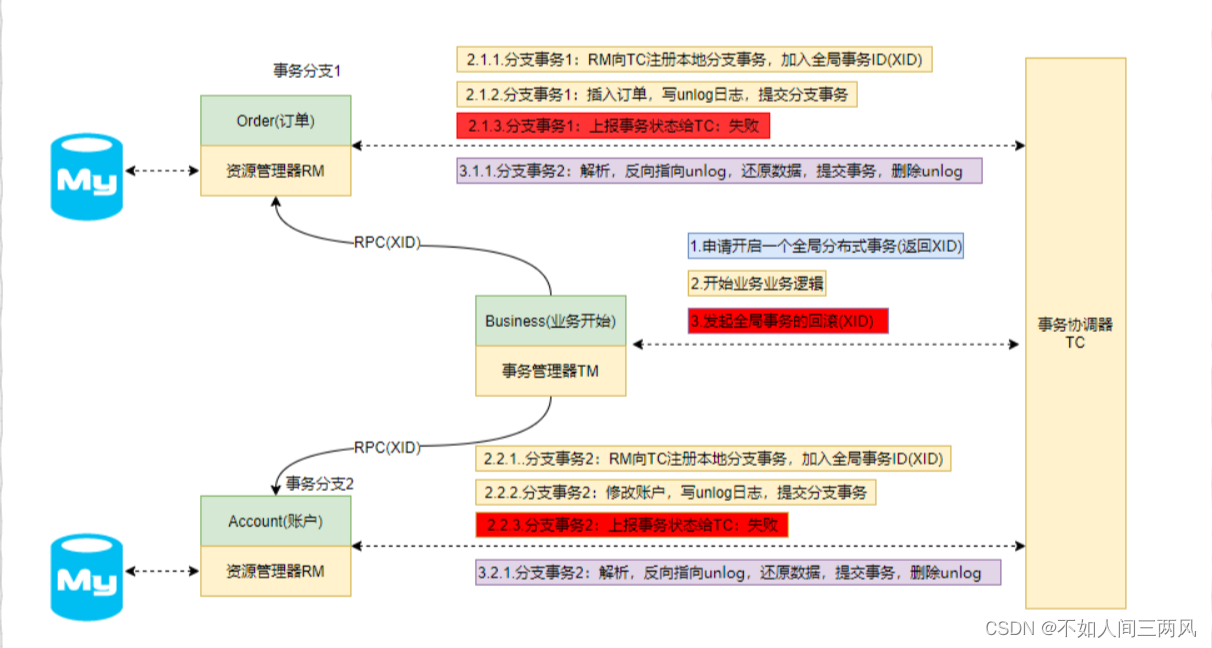

异常执行流程

缺点

-

在第一阶段,如果参与者迟迟不回复协调者,就会造成事务的阻塞,性能不好。

-

单节点故障,如果协调器挂了,参与者会阻塞,比如在第二阶段,如果事务协调器宕机,参与者没办法回复信息,长时间处于事务资源锁定,造成阻塞(事务操作是要加锁的)。

-

在第二阶段,如果在事务协调器发出“commit”执行后宕机,一部和参与者收到了消息提交了事务,而一部分没有消息没法做出事务提交操作,这样就出现了数据不一致。

-

在第二阶段,如果事务事务协调器发出“commit”指令后宕机,收到“commmit”指令的参与者也宕机了,那么事务最终变成了什么效果,提交了还是没提交?没有谁知道。

基于Seata的2pc

Seata是由阿里中间件团队发起的开源项目Fescar ,后更名为Seata ,它是一个是开源的分布式事务框架。传统2PC的问题在Seata中得到了解决,它通过对本地关系数据库的分支事务的协调来驱动完成全局事务,是工作在应用层的中间件。主要优点是性能较好,且不长时间占用连接资源,它以高效并且对业务0侵入的方式解决微服务场景下面临的分布式事务问题,它目前提供AT模式(即2PC)及TCC模式的分布式事务解决方案。

Transaction Coordinator(TC):事务协调器,它是独立的中间件,需要独立部署运行,它维护全局事务的运行状态,接收TM指令发起全局事务的提交与回滚,负责与RM通信协调各各分支事务的提交或回滚。 相当于是一个软件需要单独部署

Transaction Manager (TM):事务管理器, TM需要嵌入应用程序中工作,它负责开启一个全局事务,并最终 向TC发起全局提交或全局回滚的指令。

Resource Manager (RM):资源管理器控制分支事务, 负责分支注册、状态汇报,并接收事务协调器TC的指令, 驱动 分支(本地)事务的提交和回滚。

执行流程

-

用户服务的TM向TC申请开启一个全局事务,全局事务创建成功并生成一个全局唯一的XID。

-

用户服务的RM向TC注册分支事务,该分支事务在用户服务执行新增用户逻辑,并将其纳入XID对应全局事务的管辖。

-

用户服务执行分支事务,向用户表插入一条记录。

-

逻辑执行到远程调用积分服务时(XID在微服务调用链路的,上下文中传播)。积分服务的RM向TC注册分支事务,该分支事务执行增加积分的逻辑,并将其纳入XID对应全局事务的管辖。

-

积分服务执行分支事务,向积分记录表插入一条记录,执行完毕后,返回用户服务。

强一致性和最终一致性

这里需要了解两个概念:强一致性,最终一致性

强一致性:就像上面,A先调B在执行自己的操作,需要B完成后,A立即完成,是同步

最终一致性:A先调B在执行自己的操作,需要B完成后,A可能需要几秒或者几分钟才完成,不知道具体时间,但是会成功。

而openFeign就是强一致性采用seata方案,RocketMQ就是最终一致性可以用RocketMQ的事务消息,这个比较简单。这就要看具体需求了

具体操作

1.安装下载

下载安装seata,网上有很多,直接执行 seata-server.bat 就可以了

先从服务A开始:

2.导入依赖

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-seata</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid</artifactId>

<version>1.1.9</version>

</dependency>3.yml配置

seata:

enableAutoDataSourceProxy: false #关闭DataSource代理的自动配置,我们要手动配置

spring:

cloud:

alibaba:

seata:

tx-service-group: fsp_tx_group #这里和file.conf中事务组名一样4.在resources下创建两个conf文件

file.conf:

transport {

# tcp udt unix-domain-socket

type = "TCP"

#NIO NATIVE

server = "NIO"

#enable heartbeat

heartbeat = true

# the client batch send request enable

enableClientBatchSendRequest = true

#thread factory for netty

threadFactory {

bossThreadPrefix = "NettyBoss"

workerThreadPrefix = "NettyServerNIOWorker"

serverExecutorThread-prefix = "NettyServerBizHandler"

shareBossWorker = false

clientSelectorThreadPrefix = "NettyClientSelector"

clientSelectorThreadSize = 1

clientWorkerThreadPrefix = "NettyClientWorkerThread"

# netty boss thread size,will not be used for UDT

bossThreadSize = 1

#auto default pin or 8

workerThreadSize = "default"

}

shutdown {

# when destroy server, wait seconds

wait = 3

}

serialization = "seata"

compressor = "none"

}

service {

#transaction service group mapping

vgroupMapping.fsp_tx_group = "default"

#only support when registry.type=file, please don't set multiple addresses

default.grouplist = "127.0.0.1:8091"

#degrade, current not support

enableDegrade = false

#disable seata

disableGlobalTransaction = false

}

client {

rm {

asyncCommitBufferLimit = 10000

lock {

retryInterval = 10

retryTimes = 30

retryPolicyBranchRollbackOnConflict = true

}

reportRetryCount = 5

tableMetaCheckEnable = false

reportSuccessEnable = false

}

tm {

commitRetryCount = 5

rollbackRetryCount = 5

}

undo {

dataValidation = true

logSerialization = "jackson"

logTable = "undo_log"

}

log {

exceptionRate = 100

}

}registry.conf

registry {

# file 、nacos 、eureka、redis、zk、consul、etcd3、sofa

type = "file"

nacos {

serverAddr = "localhost"

namespace = ""

cluster = "default"

}

eureka {

serviceUrl = "http://localhost:8761/eureka"

application = "default"

weight = "1"

}

redis {

serverAddr = "localhost:6379"

db = "0"

password = ""

cluster = "default"

timeout = "0"

}

zk {

cluster = "default"

serverAddr = "127.0.0.1:2181"

session.timeout = 6000

connect.timeout = 2000

username = ""

password = ""

}

consul {

cluster = "default"

serverAddr = "127.0.0.1:8500"

}

etcd3 {

cluster = "default"

serverAddr = "http://localhost:2379"

}

sofa {

serverAddr = "127.0.0.1:9603"

application = "default"

region = "DEFAULT_ZONE"

datacenter = "DefaultDataCenter"

cluster = "default"

group = "SEATA_GROUP"

addressWaitTime = "3000"

}

file {

name = "file.conf"

}

}

config {

# file、nacos 、apollo、zk、consul、etcd3、springCloudConfig

type = "file"

nacos {

serverAddr = "localhost"

namespace = ""

group = "SEATA_GROUP"

}

consul {

serverAddr = "127.0.0.1:8500"

}

apollo {

app.id = "seata-server"

apollo.meta = "http://192.168.1.204:8801"

namespace = "application"

}

zk {

serverAddr = "127.0.0.1:2181"

session.timeout = 6000

connect.timeout = 2000

username = ""

password = ""

}

etcd3 {

serverAddr = "http://localhost:2379"

}

file {

name = "file.conf"

}

}

5.启动类注解

改为下面这个:

@SpringBootApplication(exclude = { DataSourceAutoConfiguration.class})

6.把DataSource交给Seata代理

创一个config类:

注意选择版本

mybatis-plus版本

package cn.itsource.ymcc.config;

import com.alibaba.druid.pool.DruidDataSource;

import com.baomidou.mybatisplus.spring.MybatisSqlSessionFactoryBean;

import io.seata.rm.datasource.DataSourceProxy;

import org.mybatis.spring.transaction.SpringManagedTransactionFactory;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.boot.context.properties.ConfigurationProperties;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.context.annotation.Primary;

import org.springframework.core.io.support.PathMatchingResourcePatternResolver;

import javax.sql.DataSource;

/**

* 数据源代理

*/

@Configuration

public class DataSourceConfiguration {

//mapper.xml路径

@Value("${mybatis-plus.mapper-locations}")

private String mapperLocations;

//手动配置bean

@Bean

@ConfigurationProperties("spring.datasource")

public DataSource druidDataSource(){

return new DruidDataSource();

}

@Bean

public MybatisSqlSessionFactoryBean sqlSessionFactoryBean(DataSourceProxy dataSourceProxy) throws Exception {

//处理MybatisPlus

MybatisSqlSessionFactoryBean factory = new MybatisSqlSessionFactoryBean();

factory.setDataSource(dataSourceProxy);

factory.setMapperLocations(new PathMatchingResourcePatternResolver().getResources(mapperLocations));

//事务管理工厂

factory.setTransactionFactory(new SpringManagedTransactionFactory());

return factory;

}

@Primary

@Bean("dataSource")

public DataSourceProxy dataSourceProxy(DataSource druidDataSource) {

return new DataSourceProxy(druidDataSource);

}

}mybatis版本

package cn.itsource.hrm.config;

import com.alibaba.druid.pool.DruidDataSource;

import io.seata.rm.datasource.DataSourceProxy;

import org.apache.ibatis.session.SqlSessionFactory;

import org.mybatis.spring.SqlSessionFactoryBean;

import org.mybatis.spring.transaction.SpringManagedTransactionFactory;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.boot.context.properties.ConfigurationProperties;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.core.io.support.PathMatchingResourcePatternResolver;

import javax.sql.DataSource;

//使用seata对DataSource进行代理

@Configuration

public class DataSourceProxyConfig {

//mapper.xml路径

@Value("${mybatis.mapper-locations}")

private String mapperLocations;

//手动配置bean

@Bean

@ConfigurationProperties(prefix = "spring.datasource")

public DataSource druidDataSource(){

return new DruidDataSource();

}

@Bean

public SqlSessionFactory sessionFactory(DataSourceProxy dataSourceProxy) throws Exception {

SqlSessionFactoryBean sessionFactoryBean = new SqlSessionFactoryBean();

sessionFactoryBean.setDataSource(dataSourceProxy);

sessionFactoryBean.setMapperLocations(new PathMatchingResourcePatternResolver().getResources(mapperLocations));

//事务管理工厂

sessionFactoryBean.setTransactionFactory(new SpringManagedTransactionFactory());

return sessionFactoryBean.getObject();

}

@Bean

public DataSourceProxy dataSource() {

return new DataSourceProxy(druidDataSource());

}

}7.在服务A的业务层方法上添加注解

@GlobalTransactional(rollbackFor = Exception.class) 开启Seata全局事务

注意!!!!!!!!!!!!!!!!!!

不能加@EnableTransactionManagement 注解了 , 也不需要加@Transactional

8.服务B的操作和服务A操作一样,但不执行第7步

这里只讲基于seata的2PC,但分布式事务的方案不止这个还有TCC和基于XA的2PC可以自己去看看

借鉴:十一.SpringCloudAlibaba极简入门-分布式事务实战seata_墨家巨子@俏如来的博客-CSDN博客

168

168

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?