categorization of domain adaptation(域自适应分类)

分类

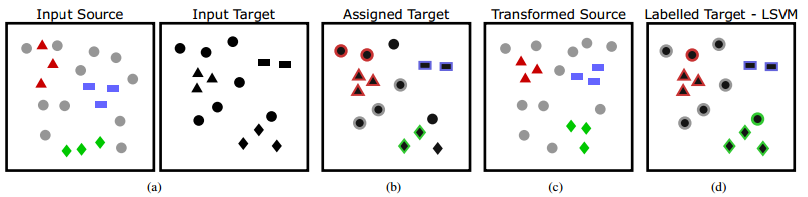

传统的域适应假设特征和标签空间保持不变,而它们的概率分布可能在域之间变化。然而,找到一个具有等效标签空间的源域和目标域是很困难的,甚至是不可能的。当源标签空间和目标标签空间不相同时,匹配整个源分布和目标分布将创建一个标签空间,其中包含属于目标类而不属于源类的数据的特征。目标域将这些类视为离群值类,将它们扩展到目标域会导致负转移,从而严重损害模型的性能。因此,除了边际分布差异之外,我们还需要考虑不同领域不同场景下的标签空间。不同的边缘分布和不同的标签空间分别称为domain gap 和 category gap。根据 category gap,领域适应可分为四大类: closed set, open set, partial, and universal domain adaptation。

Closed set domain

closed set domain adaption是指源域和目标域共享相同的类(即它们的标签集是同一个标签集),而域之间仍然存在域差距的情况。传统的领域适应就属于这一类。

open set domain adaptation

open set domain adaptation中,源域和目标域共享公共标签集中的一些标签,它们也可能有私有标签。Saito 等人定义了新的open set domain adaptation,其中源域私有类中的数据被删除。在修改后的标签集中,源标签集被认为是目标标签集的一个子集。

partial domain adaptation

partial domain adaptation是指目标标签集是源标签集的一个子集的情况。

网络架构:

Gf表示特征提取器, Gy是源域分类器, Gd是域判别器,主要是用来判别输入的样本是不是还在目标域类别中,如果既属于源域类别,又属于目标域类别,其权重就变大,反之就变小。 γ 体现的是源域数据的总体分布权重情况,源域分类器对源域分类后,源域数据总体的分布实际上体现了各个类别的分布情况,而不难发现属于源域而不属于目标域类别的分布与既属于源域又属于目标域类别的分布情况应该是有很大的不同的,所以实际上把属于后者的误分到前者的可能性是很小的, Ly是有监督学习的损失函数,Ld 则是域分类损失。

Gf表示特征提取器, Gy是源域分类器, Gd是域判别器,主要是用来判别输入的样本是不是还在目标域类别中,如果既属于源域类别,又属于目标域类别,其权重就变大,反之就变小。 γ 体现的是源域数据的总体分布权重情况,源域分类器对源域分类后,源域数据总体的分布实际上体现了各个类别的分布情况,而不难发现属于源域而不属于目标域类别的分布与既属于源域又属于目标域类别的分布情况应该是有很大的不同的,所以实际上把属于后者的误分到前者的可能性是很小的, Ly是有监督学习的损失函数,Ld 则是域分类损失。

universal domain adaptation

与上述域自适应需要关于源标签集和目标标签集的先验知识相比,通用域自适应并不局限于任何先验知识。在通用域自适应中,源域和目标域可能共享共同的标签集,而且每个域也可能有一个私有标签集或离群值类。通用域自适应首先倾向于找到跨域的共享标签空间,然后部分域自适应对齐公共标签集中的数据分布。最终,一个分类器将在匹配的源标记数据上进行训练,以安全地应用于未标记的目标数据。在测试阶段,训练过的开放集和通用域自适应的分类器为属于共享标签空间的目标样本分配准确的标签,并将离群值类中的样本标记为未知。

图示

图片中可以很明显的看出四种域自适应的区别。

1463

1463

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?