什么是残差网络?

残差网络之所以叫做残差网络是因为它有一个特点—残差连接(Residual Connection)。这个特点用人话来说就是:本来需要按照层数,逐层进行深度学习,但是在残差网络中,我们跳过连接或使用捷径用于跳过某些层(HighwayNets也可以通过其门的附加权重矩阵自行学习跳过权重)。

为什么会出现残差网络?

为的是避免**梯度消失问题,**从而更容易优化神经网络,其中门控机制促进跨多个层(“信息高速公路”)的信息流动,或减轻退化(准确性饱和)。

它是如何避免梯度消失问题的呢?

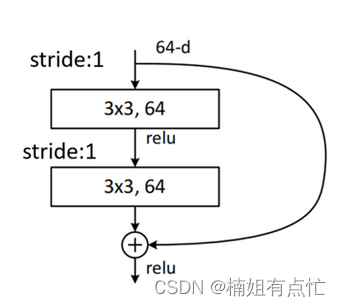

残差网络(Residual Network)通过引入残差连接(Residual Connection)来避免梯度消失的问题。残差连接允许网络直接跨越多层来学习残差函数,从而使网络更加容易训练。

在传统的卷积神经网络中,每个层的输出都是从前一层的输出中学习到的特征。这种串行的结构会导致梯度在反向传播时逐渐变小,从而使得网络难以训练。残差连接允许网络直接跨越多层来学习残差函数,从而使得网络能够更好地适应复杂的数据分布。

具体来说,残差连接将前一层的输出直接添加到当前层的输出中,从而形成残差(即当前层的输出与前一层的输出之间的差)。这个残差可以被后续的层进一步学习,从而使得网络能够更好地适应复杂的数据分布。

通过引入残差连接,残差网络可以在训练过程中轻松地通过反向传播来传递梯度。即使网络变得非常深,梯度也可以从输出层回传到输入层,因此可以避免梯度消失的问题。因此,残差网络可以训练比传统卷积神经网络更深的模型,获得更好的性能。

使用Python和PyTorch实现残差网络

import torch.nn as nn

import torch.nn.functional as F

class ResidualBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1, downsample=None):

super(ResidualBlock, self).__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1, bias=False)

self.bn1 = nn.BatchNorm2d(out_channels)

self.relu = nn.ReLU(inplace=True)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, stride=1, padding=1, bias=False)

self.bn2 = nn.BatchNorm2d(out_channels)

self.downsample = downsample

def forward(self, x):

residual = x

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

if self.downsample is not None:

residual = self.downsample(x)

out += residual

out = self.relu(out)

return out

class ResNet(nn.Module):

def __init__(self, block, layers, num_classes=1000):

super(ResNet, self).__init__()

self.in_channels = 64

self.conv1 = nn.Conv2d(3, 64, kernel_size=7, stride=2, padding=3, bias=False)

self.bn1 = nn.BatchNorm2d(64)

self.relu = nn.ReLU(inplace=True)

self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

self.layer1 = self._make_layer(block, 64, layers[0])

self.layer2 = self._make_layer(block, 128, layers[1], stride=2)

self.layer3 = self._make_layer(block, 256, layers[2], stride=2)

self.layer4 = self._make_layer(block, 512, layers[3], stride=2)

self.avgpool = nn.AdaptiveAvgPool2d((1, 1))

self.fc = nn.Linear(512 * block.expansion, num_classes)

def _make_layer(self, block, out_channels, blocks, stride=1):

downsample = None

if stride != 1 or self.in_channels != out_channels * block.expansion:

downsample = nn.Sequential(

nn.Conv2d(self.in_channels, out_channels * block.expansion, kernel_size=1, stride=stride, bias=False),

nn.BatchNorm2d(out_channels * block.expansion),

)

layers = []

layers.append(block(self.in_channels, out_channels, stride, downsample))

self.in_channels = out_channels * block.expansion

for i in range(1, blocks):

layers.append(block(self.in_channels, out_channels))

return nn.Sequential(*layers)

def forward(self, x):

x = self.conv1(x)

x = self.bn1(x)

x = self.relu(x)

x = self.maxpool(x)

x = self.layer1(x)

x = self.layer2(x)

x = self.layer3(x)

x = self.layer4(x)

x = self.avgpool(x)

x = x.view(x.size(0), -1)

x = self.fc(x)

return x

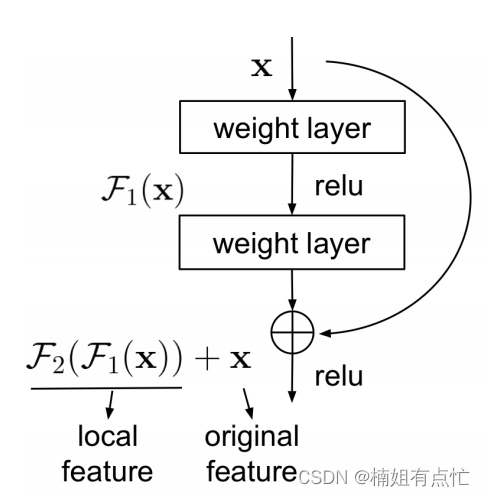

在这个代码中,**ResidualBlock类是残差块的实现,它包含两个卷积层和两个Batch Normalization层,并使用ReLU激活函数进行非线性变换。在forward**函数中,我们计算残差,并将其添加到输出中。

**ResNet类是整个残差网络的主要实现,它由多个ResidualBlock**组成。在构造函数中,我们定义了第一层卷积层,最大池化层和四个残差层。 **_make_layer方法用于创建每个残差层,其中每个层由多个ResidualBlock组成。在forward**函数中,我们应用所有的层,并将输出传递给全连接层进行分类。

forward函数形象的表示图如下:

在PyTorch中,我们可以使用这些类创建一个残差网络模型,例如:

pythonCopy code

model = ResNet(ResidualBlock, [2, 2, 2, 2])

这将创建一个具有四个残差层,每个层包含2个残差块的ResNet模型。然后,我们可以使用标准的PyTorch优化程序(例如Adam或SGD)训练和测试该模型。

1090

1090

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?