摘要

多模态图像融合(MMIF)是将不同模态图像中有价值的信息融合到一个融合图像中。然而,在实际的MMIF应用中,不同焦点区域的多幅可见光图像与红外图像的融合是一个前所未有的挑战。这是因为可见光镜头的焦距深度有限,阻碍了同一场景内焦距信息的同时采集。为了解决这个问题,在本文中,我们提出了一个MMIF框架,用于联合聚焦集成和模态信息提取。具体来说,引入了一种基于半稀疏的平滑滤波器,将图像分解为结构和纹理组件。在此基础上,提出了一种融合纹理分量的多尺度算子,通过考虑各模态图像的像素焦点属性和相关数据,能够检测出重要信息。此外,为了实现场景亮度的有效捕获和合理的对比度保持,我们从多向频率方差和信息熵的角度考虑了能量信息在结构部件中的分布。在现有的MMIF数据集以及目标检测和深度估计任务上进行的大量实验一致表明,所提出的算法在视觉感知和定量评估方面可以超越最先进的方法。代码可在https://github.com/ixilai/MFIF-MMIF上获得。

介绍

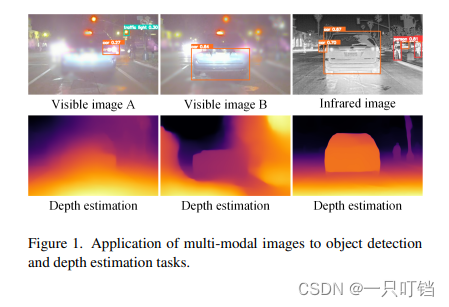

多模态图像融合(MMIF)技术通过整合来自不同传感器的有价值信息,在计算机视觉中发挥着至关重要的作用。这些技术提供了对场景的全面和详细的解释对于高级视觉任务,如目标检测[6,40,47]、语义分割[2,5,32]和行人再识别[12]。以红外和可见光图像融合(IVIF)任务为例,可见光传感器在光线充足的场景中表现良好,可以捕捉到丰富的纹理和细节。然而,在光线不足或烟雾或下雨等恶劣条件下,它们会丢失信息。相比之下,热成像仪不易受外界干扰,可以捕获目标的热辐射,但它们对复杂场景细节缺乏灵敏度。

近年来,在IVIF(输入不同分辨率、输出任意分辨率的图像融合技术)领域发展了许多融合算法。它们可以大致分为基于深度学习(DL)的方法[9,16,36]和一般融合方法[19,20,51]。基于DL的方法使用神经网络来模拟人脑功能。通过从广泛的数据集中学习,这些模型建立连接并利用深度特征来重建具有丰富复杂细节的融合图像。目前,各种最初为低级视觉任务设计的网络模块已经成功地适应了IVIF任务。这些模块包括注意机制[3,24,26],扩张卷积[11],编码器-解码器模型[22,44,49],以及生成模型[13,23,27]。一般的融合算法可分为多尺度变换(MST)算法[4,14]和基于显著性的算法[29,30]。MST算法将源图像分解成多个尺度和方向,利用融合规则进行融合,重建融合系数。这种方法的更好的规模意识也伴随着更高的计算成本。该算法利用显著性图和融合权值来保留不同源图像的显著区域,减少了像素冗余,提高了融合结果的视觉质量。

虽然上述算法[4,15,29,36,37]可以提供高质量的融合结果,但它们通常假设可见光成像设备捕获的场景信息始终是焦点清晰的。然而,在实际情况下,由于光学镜头的限制,只能考虑景深范围内的物体。如图1所示,当可见图像的焦点区域不完整时,就会出现挑战,导致难以准确地为高级任务提供目标和深度信息。因此,当摄像机无法同时捕获场景中的所有目标信息时,必须捕获多组数据,以确保所有目标信息都在聚焦区域内。为了应对这些挑战,我们提出了MMIF的重点信息集成框架。该框架旨在同时整合来自不同聚焦区域的清晰像素信息和来自不同模态捕获的显著像素信息。该方法将源图像分解为纹理和结构两个分量。对于纹理融合,我们采用了一种由高斯和拉普拉斯金字塔层次引导的显著特征提取算子,捕捉跨尺度的显著细节。我们还利用多向频率方差和信息熵来识别结构分量中的高能像素信息。本研究的贡献总结如下:

- 我们提出了一个集中的集成框架MMIF。据我们所知,这是第一次尝试解决多焦点干扰的MMIF任务,准确地实现集中和多模态信息的同时合成。

- 我们提出了一种基于金字塔尺度分离的特征提取算子,该算子充分考虑了像素焦点属性和显著性,有效地捕获了每个源图像中细节的分布。

- 我们生成了一个集多焦点图像融合和MMIF任务于一体的数据集,有效地反映了MMIF实际应用中的离焦融合挑战,并为评估和改进现有算法提供了新的基准。

- 实验结果表明,该方法在多种计算机视觉任务(如MMIF)以及目标检测和深度估计方面具有很强的竞争力,主观和客观的评估都证明了该方法的有效性。

相关工作

-

基于DL的方法

在IVIF(输入不同分辨率、输出任意分辨率的图像融合技术)领域,深度学习凭借其强大的表征学习能力和高适应性已经成为一种强大的工具[24,28,43,48,50]。例如,Tang等人[37]提出了语义感知的实时IVIF框架,利用分割网络来预测融合图像的分割结果,从而构建语义损失。然后利用这种损失来指导融合网络通过反向传播的训练。Ma等人[36]提出了一种无dark -free IVIF算法,该算法解决了源图像中照明特征退化的问题。他们的方法包括设计一个场景照明网络,有效地去除退化的特征。此外,该算法注重利用不同模态图像的独特特征来增强融合结果的视觉质量。Zhao等[49]提出了一种结合卷积神经网络和深度学习模型架构的IVIF算法,该算法可以有效地对跨模态图像进行建模,并区分不同模态图像之间的公共和私有特征。Liu等[23]解决了IVIF在目标检测中的挑战,提出了一种目标感知的双对抗性学习融合网络和一种常用的检测网络,该网络利用生成器和双鉴别器学习不同模态图像之间的共性,以有效保留场景内的显著像素信息。 -

Semi-sparse过滤器

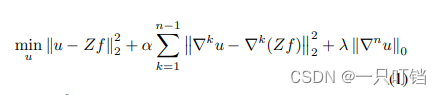

最近的研究[46]表明,边缘保持滤波器中的稀疏先验可以有效地获得分段的常数滤波结果,保留奇异点和边缘等稀疏特征。然而,稀疏性假设可能在具有稀疏特征和多项式平滑表面的区域失效。在此基础上,Huang等[10]证明了使用半稀疏先验构造的平滑函数可以应用于稀疏先验失效的情况,该半稀疏最小化方案表示为:

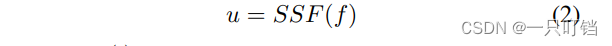

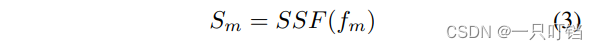

其中f和u分别表示输入和输出图像,权值Z[10]表示平滑度空间变化的置信度图,α和λ为平衡权值,分别设为0.8和0.05。∇n表示第n个(偏)微分算子。在本文提出的算法中,我们将n=2作为正则化的最高阶。最后,我们可以将半稀疏滤波器(SSF)表示为:

公式中SSF(·)表示半稀疏滤波算子;关于该过滤器的详细信息可以在[10]中找到。

提出的方法

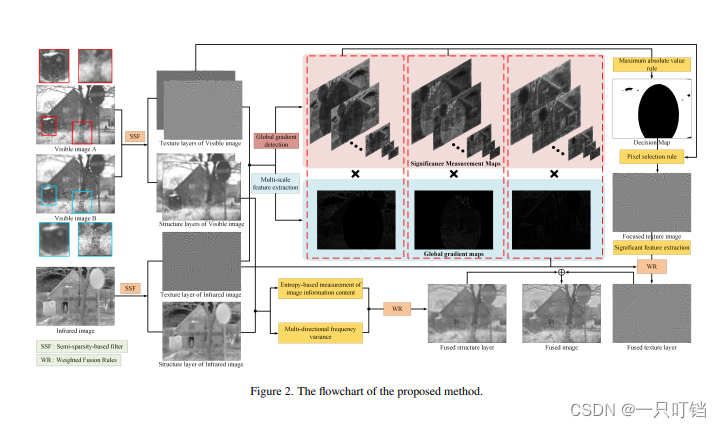

图2显示了所提出算法的流程图;它可以输入两幅不同聚焦区域的可见光图像和一幅相应的红外图像,然后输出一幅全景式清晰、特征信息丰富的融合图像。

-

图像分解

边缘保持滤波器可以有效地平滑源图像中的大部分纹理和结构信息,同时保持结构化边缘的强度。为了更好地区分图像中代表不同特征信息的像素点,我们首先使用SSF对源图像进行分解。输入不同聚焦区域的可见光图像f1和f2以及相应的红外图像f3,进行获取结构层的操作S如下:

式中m∈{1,2,3},Sm表示不同源图像对应的结构层,纹理层计算如下:

其中Tm表示纹理层数。 -

显著特征融合

(1)纹理层融合

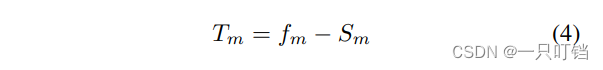

纹理信息的融合依赖于检测聚焦和清晰的细节信息,以及利用不同模态图像之间的互补信息。为了解决这一问题,我们设计了一种新的特征提取算子,该算子由两个关键部分组成:全局梯度信息检测和多尺度特征提取。这些组件一起工作,有效地从输入图像中提取和整合纹理细节。首先,我们使用全局梯度检测算子获取纹理层的梯度信息,表示为:

其中∇T∗(∗∈{x, y})表示T沿x轴或y轴的梯度,p为设为0.8的常数,r = p × e^(p/2−1)。我们利用离散微分算子[−1,1]和[1,−1]T分别计算沿x轴和y轴的梯度。在梯度信息的引导下,我们可以有效地提取出清晰的焦点细节。

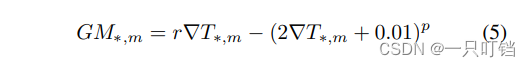

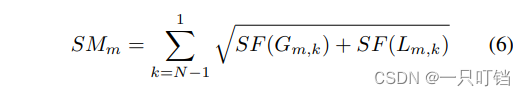

为了检测不同模态图像之间的互补信息,我们提出了一种基于高斯金字塔和拉普拉斯金字塔的尺度特征提取算子。高斯金字塔通过持续地对图像进行下采样来生成多尺度表示。相反,拉普拉斯金字塔是由高斯金字塔推导而来的,它表示高斯金字塔图像与上一层的上采样图像之间的残差。利用高斯金字塔固有的尺度分离特性,可以有效地提取不同尺度的特征信息。给定一个输入图像T,将其分解为N个尺度Gl, l∈{0,1,…, N},其中G0 = t,每一层拉普拉斯金字塔对应于l, l∈{0,1,…, N−1},我们的目标是在尺度k (0 < k < N)的引导下检测图像的重要像素信息,具体过程如下:

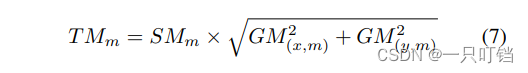

G(m,k) L(m ,k)表示第k个高斯函数和拉普拉斯金字塔分别对应于纹理层Tm。SF(·)表示用于检测重要特征信息和的空间频率算子[8]SM表示显著性测度图。此外,每次特征提取后对G(m,k)和L(m,k)进行上采样,恢复与前一层相同的大小。最后,结合全局梯度和显著性测度,本文提出的新型特征提取算子可表示为:

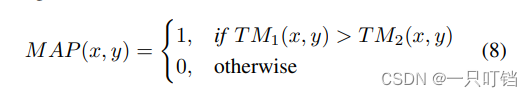

其中TMm表示显著特征映射。在TMm的指导下,首先利用“最大绝对值规则”得到焦点决策图。

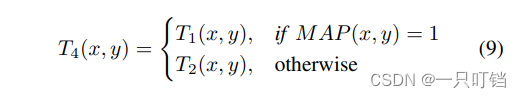

然后,我们引入了一种多尺度一致性验证技术[21],对MAP进行处理,得到OMP,根据OMP可以整合聚焦细节,得到聚焦纹理图T4。

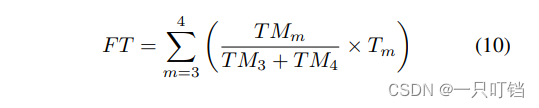

使用上述特征提取算子获得T4的显著特征映射TM4后,按照以下规则构造最终的融合纹理层F T:

(2)结构层融合

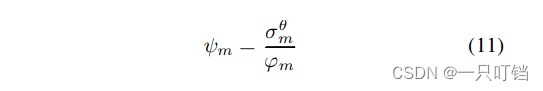

结构层包含来自源图像的低频信息。受[31]的启发,我们的研究从图像的熵和多向频率方差两个方面考虑了能量信息的分布。首先,我们计算结构层中每个3×3大小的离散余弦变换(DCT)[35]块的频率方差ψm。

在σθ m表示DCT块在四个方向上的标准差θ∈{0◦, 45◦,90◦, 135◦},φm表示σ的平均值θ m在四个方向。我们计算所有块的方差,然后计算它们的平均值作为结构层的第一个特征值。

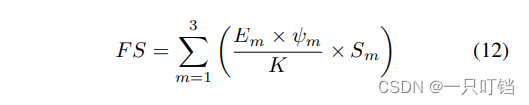

图像的熵是用来衡量其信息丰富度的。为了使算法能够有效地处理更复杂的图像,我们使用熵作为第二个特征值来设计结构层融合规则。因此,熔融结构层fs的构造如下:

其中 Em表示Sm的熵。

- 融合结果构建

基于FT和FS,可以构造最终的融合结果F。

对于所提出的模型,对可见光图像进行融合处理通常情况下,MMIF任务可以使用A和红外图像,多焦点图像融合任务可以使用可见光图像A和可见光图像B的融合过程。

数据集生成

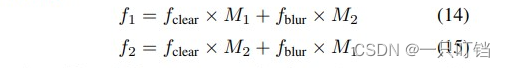

我们基于两个公开可用的mmif数据集TNO[39]和RoadScene[43],通过整合MFIF和MMIF任务生成了一个数据集。受[17]的启发,我们首先随机生成一对基于在源图像的二进制掩码,随后使用它们来模糊可见图像中的两个互补区域,以模拟场景聚焦区域不完整的现实情况。

其中,M1和M2代表一对互补掩模,模糊图像f(blur)是将完全聚焦的可见光图像f(clear)与标准差为5的高斯滤波核进行卷积得到的。这样,我们就可以将一幅完全聚焦的可见图像分解成一组具有互补聚焦区域的多聚焦源图像。图3显示了部分随机生成的二进制掩码。

实验

-

实验装置

我们使用了7种最先进的MMIF图像融合方法进行比较,它们是TarD [23], ReC [11],CDD[49]、LRR[16]、SeA[37]、SDD[50]、U2F[43]。所有方法都在原作者提供的源代码上进行了测试,使用的是带有NVIDIA GeForce的PC RTX 3060Ti GPU和一代英特尔酷睿i7-13700F CPU。此外,我们选择了QG[45]、QM[41]、QS[25]、AG[7]、SF[8]和PSNR[42]六个客观评价指标来评估不同算法的融合性能。这6个指标可以从多个方面综合评价不同融合结果的质量,指标得分越高代表图像质量越好。

此外,为了保证实验的公平性,除了本文算法的输入图像为多聚焦图像和相应的红外图像外,其余比较方法的输入图像均为两幅图像,即全聚焦可见光图像和相应的红外图像。此外,本研究中使用的所有图像均来自TNO和RoadScene数据集。 -

参数分析

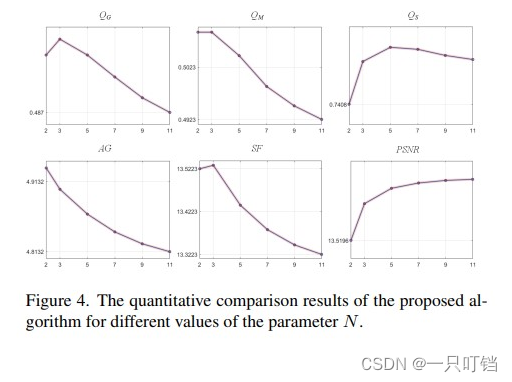

我们对金字塔分解层数进行了分析,记为N。为了进行分析,我们从RoadScene数据集中随机选择了20对图像作为定量比较数据集。采用各种指标对不同N值下的融合性能进行评价,得分如图4所示。横轴表示N个值,纵轴表示每个指标的分数。从图4所示的结果可以看出,当N设置为3时,有三个指标的得分最高。基于这个观察,我们决定在我们的算法中设置N为3。

-

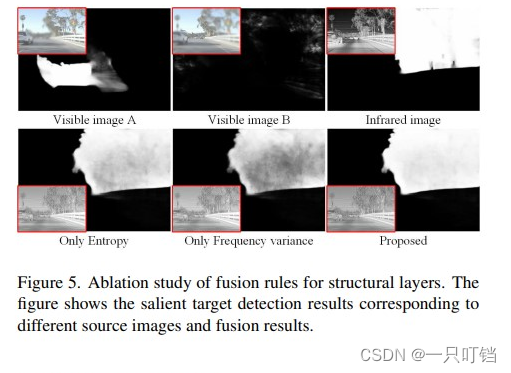

消融分析

在结构层融合过程中,我们从熵和频率方差两个角度仔细考虑了能量信息的分布。我们进行了消融实验来验证该策略的有效性。我们采用显著性目标检测算法[33]对各种融合结果进行分割,评估其显著性像素信息提取的性能,如图5所示,考虑两种视角设计的融合规则表现出最好的性能。

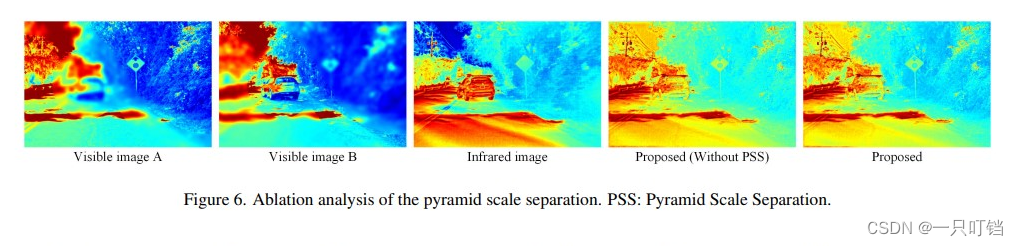

此外,我们还提出了一种新的基于金字塔尺度分离的特征提取算法。进行消融研究以评估该策略的有效性。图6给出了RoadScene数据集上的一系列实验结果。为了便于比较,源图像和融合结果都被赋予了伪颜色。从图6可以清楚地看出,没有金字塔尺度分离的融合结果缺乏一定的细节信息,不能突出某些物体的纹理和层次细节,如树叶。相反,我们提出的算法利用金字塔的多尺度表示,成功地捕获了细微的纹理信息。这一观察结果证实了我们的策略显著提高了所提算法的细节感知性能。

-

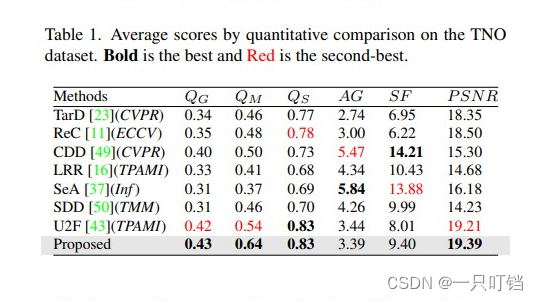

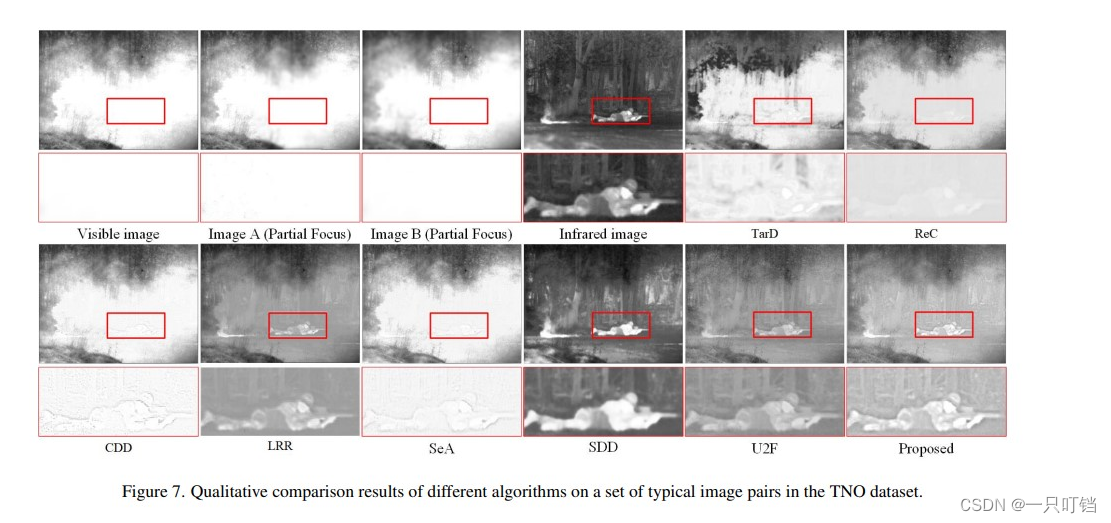

在TNO数据集上的比较结果

图7为典型场景下不同算法的融合结果,为了更好地比较不同算法保留的有用信息,图7将局部区域放大。在这个场景中,每个算法的挑战是捕捉隐藏在烟雾中的士兵,同时最大限度地减少烟雾对可见图像的干扰。在突出显示的放大区域,TarD、ReC、CDD和SeA方法受到烟雾的严重干扰,对比度较差,无法从烟雾中提取目标信息。LRR和SDD方法主要依赖于红外图像像素信息,导致丢失了可见图像细节。相比之下,我们提出的算法有效地从不同的模态图像中提取有用的像素信息,没有烟雾干扰,并具有良好的细节保留。

表1给出了本文算法与其他7种方法在TNO数据集上的定量比较结果。该算法在四个指标上优于其他算法,证明了其能够准确检测不同聚焦区域的清晰像素,并有效整合来自不同模态的信息。它在保留细节和能量信息方面超越了目前最先进的融合算法。

-

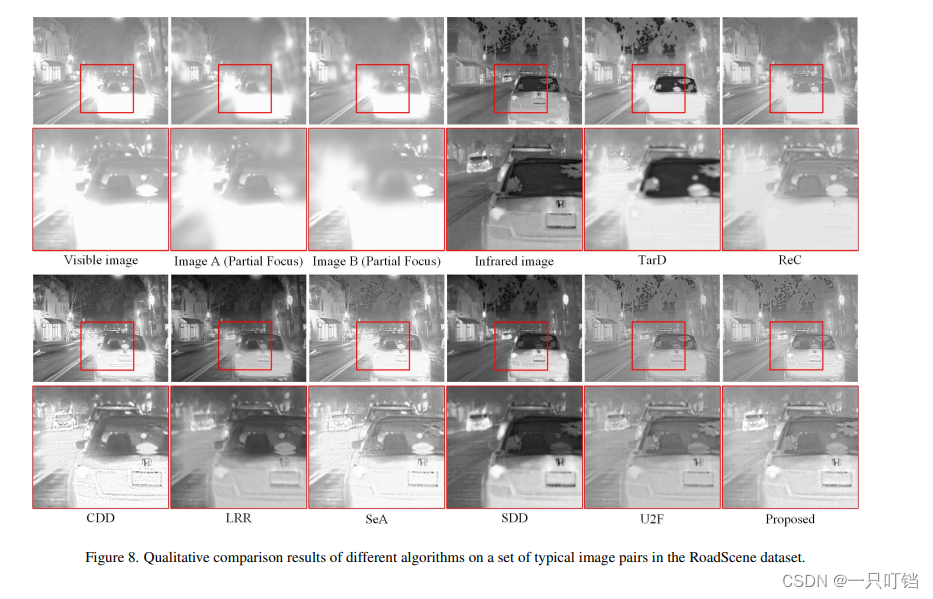

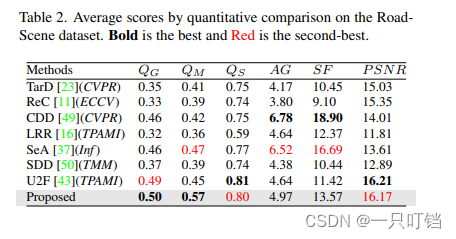

RoadScene数据集的对比结果

图8示出了不同融合算法对一组道路场景数据集图像对的融合结果。在这一组中,可见图像显示过度曝光。如红色放大区域所示,TarD、ReC、CDD和SeA四种方法的融合结果从过曝光区域摄取了过多的像素信息,阻碍了融合结果保持合理的对比度。LRR和U2F方法都无法识别红外图像提供的弱纹理信息,导致场景信息不完整。相反,该算法在复杂场景中表现出鲁棒性(稳定性),即使在存在场景干扰的情况下,也能有效地提取对高级视觉任务至关重要的显著像素信息。

表2给出了所有算法在RoadScene数据集上的定量比较结果。该算法在四个指标中排名前两名,与其他算法相比,显示出优越的融合性能。值得注意的是,CDD、SeA和U2F在该数据集上也表现出了出色的性能,在细节保留和与源图像的相关性方面优于其他方法。

-

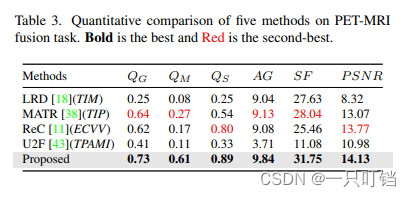

PET-MRI数据集的对比结果

我们将实验扩展到多模态医学图像融合(MEIF),以研究该算法的泛化能力。对于MEIF,我们可以将模型表示为可见光图像a和红外图像的融合过程。我们使用哈佛医学院公共数据库(https://www.med.harvard.edu/aanlib/home.html)作为本实验的数据集,该数据库包含100对磁共振成像(MRI)和正电子发射断层扫描(PET)图像。

表3给出了本文算法与四种最先进的MEIF算法(LRD[18]、ReC[11]、MATR[38]、U2F[43])在PET-MRI融合任务上的定量对比实验。如表3所示,本文方法优于所比较的方法,在各指标上得分最高。结果表明,该算法集成了不同模态医学图像的有用信息,可用于辅助医生进行临床诊断。

-

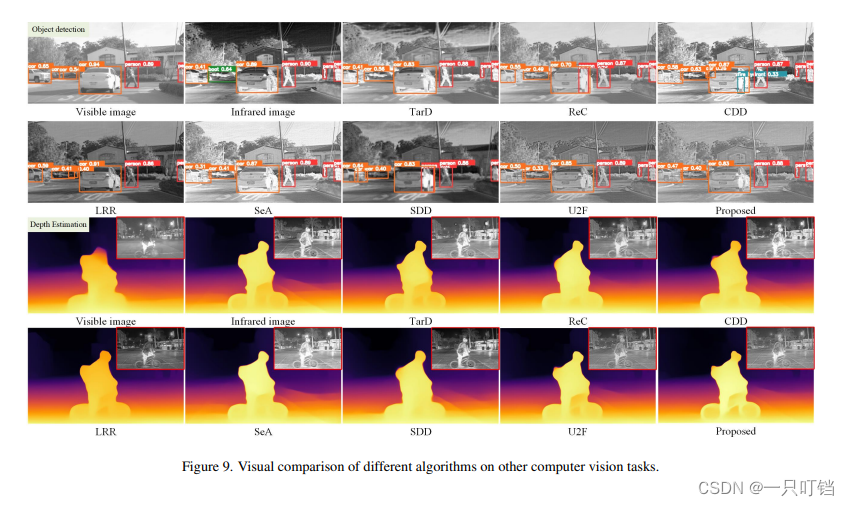

在其他计算机视觉任务中的应用

在本节中,我们评估了所提出的融合方法在其他计算机视觉任务中的有效性:目标检测和深度估计。目标检测任务使用YoloV4[1]实现,深度估计任务基于MiDaS[34]。在评估的算法中,只有SeA、U2F和本文算法能够准确地检测出场景中所有重要的目标信息。其他算法,如ReC、CDD和LRR,表现出不同程度的检测误差。图9说明了CDD、SeA和SDD在提供改进的深度信息方面都存在不足。相比之下,我们提出的算法通过有效地利用先进的任务驱动方法超越了所有比较的算法。它为场景提供全面准确的语义和深度信息,从而极大地辅助高级视觉任务。

结论

为了解决图像聚焦区域不完整和不同模态的显著信息难以同时捕获的问题,本研究提出了一种MMIF聚焦信息集成框架。该方法首先利用SSF将源图像分解为结构分量和纹理分量。为了融合纹理层,我们采用了以金字塔为导向的多尺度特征检测,同时考虑像素在多个方向上的分布,采用基于熵的有效融合策略提取结构层的能量信息。大量的实验结果表明,所提出的方法可以产生比现有技术更先进的性能。该研究不仅有效地综合了多焦点和多模态两种不同类型的图像融合任务,而且在目标检测和深度估计等其他计算机视觉任务中也显示出强大的潜力。

1001

1001

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?