Paper:https://arxiv.org/abs/2103.11832

Code:未开源

1.动机

在最近的文献中,RGB-D SOD方法通常将深度通道作为辅助输入通道,直接送入卷积神经网络(convolutional neural network, CNN)进行特征提取[7,21,31,43,59]。因此,它们不能很好地利用深度先验知识来捕获显著物体的相应几何布局。

由于突出的目标往往分布在几个特定的深度区间内,因此可以通过有规律地滑动深度区间窗口来粗略地检测到。

受此启发,我们认为可以提取RGB特征w.r.t.深度,以有效捕获深度几何先验的显著目标,同时减少背景干扰(例如,杂乱的物体或类似的纹理)。我们提出将原始深度映射分解为多个区域,每个区域包含一组来自相同深度区间的像素。然后,我们提出了一种深度敏感注意模块(DSAM)对不同区域进行RGB特征提取,从而实现了基于深度几何先验的RGB特征增强。

为此,我们构建了一个适用于RGB-D SOD跨多尺度多模态特征融合的搜索空间。采用常用的骨干网VGG-19[53]的自动发现特征融合体系结构。

2.优点/特点

提出了一个深度敏感的注意模块,通过深度先验知识明确地消除背景干扰并增强RGB特征。

为RGB-D SOD中的异构特征融合设计了一个新的搜索空间,并首次尝试将NAS引入到RGB-D SOD中。

在七个基准上进行了广泛的实验,这表明我们的met hod优于其他最先进的方法。

目前已有多模态融合的NAS作品,但其设计目的主要是针对视觉问答任务或图像-音频融合任务。据我们所知,我们的工作是第一次尝试利用NAS算法来解决RGB-D SOD的多模态多尺度特征融合问题。

3.综述

整个网络由RGB分支、深度分支和专门设计的模块组成。

多模态多尺度特征融合模块:为了自动融合增强的RGB特征和深度特征,提出了一种多模态多尺度特征融合模块。在RGB-D SOD文献[21,31,32,47,59,60,63]中,值得注意的是三个一致的原则:

1)同一量表的不同模态特征总是融合,而不同量表的特征是选择性融合。

2)在最终预测之前,低级特征总是与高级特征相结合,因为低级特征具有丰富的空间细节而缺乏语义信息,反之亦然。

3)在进行不同模态特征融合时,注意机制是必要的。在此基础上,设计了一种适合多模态多尺度融合的新搜索空间,该空间包含多模态融合(MM)、多尺度融合(MS)、全局上下文聚合(GA)和空间信息恢复(SR)四种不同的结构单元。

DSAM(包括深度分解和深度敏感注意模块):不仅为RGB特征提供了深度的几何先验知识,而且还消除了难以处理的背景干扰(例如,杂乱的物体或类似的纹理)。

(1) RGB branch(RGB分支)

RGB分支基于VGG-19。

我们在RGB分支的每个向下采样层之后插入一个深度敏感的关注模块(DSAM)。每个DSAM利用一个原始深度图来增强RGB特征。

(2) depth branch(深度分支)

深度分支是一种轻量级的深度网络,可以获取不同尺度的深度特征

具体来说,我们将原始深度映射分解为多个区域。每个区域包含相同深度分布模式下的像素值,作为空间注意力图,提取相应的RGB特征。

(3) specially-designed fusion module(专门设计的融合模块)

为了自动融合增强的RGB特征和深度特征,提出了一种多模态多尺度特征融合模块。该空间包含多模态融合(MM)、多尺度融合(MS)、全局上下文聚合(GA)和空间信息恢复(SR)四种不同的结构单元。

4.Depth-Sensitive Attention

提出了一种深度敏感RGB特征建模方案DSAM,包括深度分解和深度敏感注意模块。

DSAM不仅为RGB特征提供了深度的几何先验知识,而且还**消除了难以处理的背景干扰(**例如,杂乱的物体或类似的纹理)。

首先,我们将原始深度映射量化为深度直方图,并选择深度直方图的T个最大深度分布模式(对应于T个深度区间窗)。 然后利用这些深度区间窗,将原始深度映射分解为T个区域,直方图的剩余部分自然形成最后一个区域,如图3(a)所示。

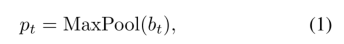

最后,将每个区域归一化为[0,1]作为后续处理的空间注意掩码。在得到这些注意面具之后,我们对深度敏感的注意模块进行了详细的描述。在DSAM中,得到的注意掩码在RGB分支中产生了T + 1个子分支,如图3(b)所示。形式上,让Frgb k∈RCk×Hk×Wkbe为RGB分支第k阶段的RGB特征图,Ck、Hk、wk分别表示通道数、高度、宽度。表示btas为上述深度分解过程中获得的第t个注意掩模。我们利用最大池操作对齐掩码的大小 as

as

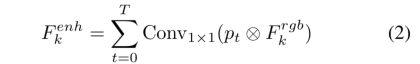

我们利用调整大小的掩模{p1, p2,···,pT+1}提取T+1并行子分支中的深度敏感特征。具体来说,我们将每个mask pt与每个channel of RGB feature Frgb k相乘,并在第t个子分支中使用1 × 1卷积层作为过渡层,从不同的深度间隔中细化RGB特征。然后,我们对T + 1个子分支的所有深度敏感特征进行逐项求和运算

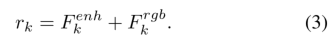

其中 是增强的RGB特征,⊗表示逐项相乘。最后引入一个残差连接,得到最终输出特征。

是增强的RGB特征,⊗表示逐项相乘。最后引入一个残差连接,得到最终输出特征。

Auto Multi-Modal Multi-Scale Feature Fusion(自动多模态多尺度特征融合)

设计的四种类型的单元,即MM、MS、GA、SR单元,它们构建了整个任务特定搜索空间。这四种类型的单元在一个顺序的管道中进行。每个部分都是NAS中可搜索的单元。

首先,利用MM单元直接实现RGB和深度分支之间的多模态特征融合。

其次,利用MS细胞进行密集多尺度特征融合。

然后,利用GA细胞无缝聚合MS细胞的输出,以捕获全局上下文。

最后,引入SR单元来结合低级和高级特性。

MM和MS单元的设计理念既满足相同尺度下多模态特征融合的要求,也满足不同尺度下多模态特征融合的要求。然后,遗传单元将低层空间信息引入到高层特征中。此外,我们将空间注意操作和通道注意操作添加到候选操作集O中,探索注意的配置

总结

我们提出了一个名为DSA2F的双流框架用于RGB-D显著性检测。在该框架中,引入了深度敏感注意模块(DSAM),利用深度几何信息有效增强RGB特征,减少背景干扰。在此基础上,设计了适合多模态多尺度特征融合的任务搜索空间,自动获得了强大的融合体系结构。

2327

2327

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?