提示:文章内容代码部分地方需要根据自身的环境路径进行修改!

目录

2.SimpleAsyncHbaseEventSerializer

编辑 3.RegexHbaseEventSerializer

前言

提示:这里可以添加本文要记录的大概内容:

主要讲述Flume汇入数据到Hive&Hbase的方法及操作。

提示:以下是本篇文章正文内容,下面案例可供参考

一.Flume汇入数据到Hive

方法一:汇入到Hive指定的HDFS路径中:

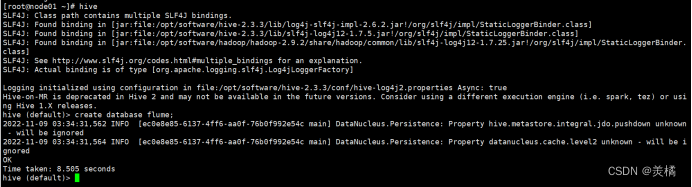

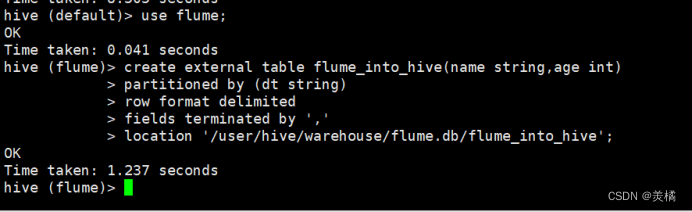

1.在hive中创建数据库和外部表

代码:

create database flume;

代码:

create external table flume_into_hive(name string,age int) partitioned by (dt string) row format delimited fields terminated by ',' location '/user/hive/warehouse/flume.db/flume_into_hive';

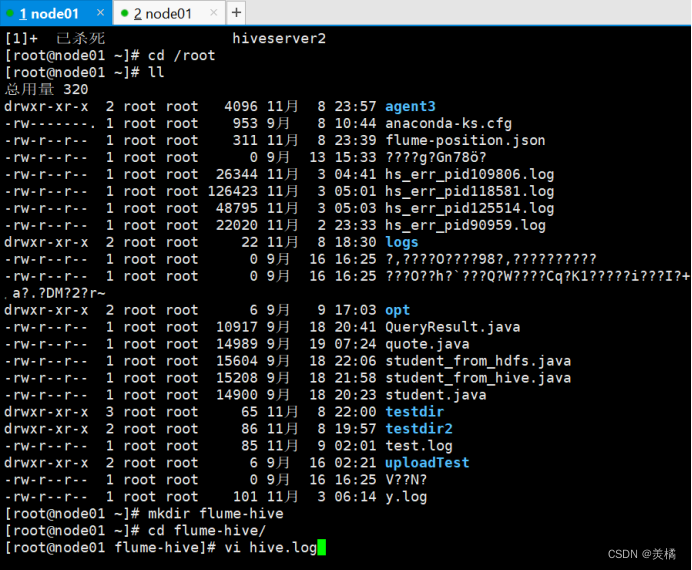

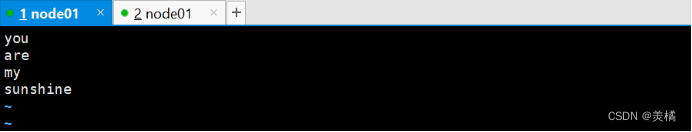

2.在/root中创建hive.log文件

代码:

mkdir flume-hive

cd flume-hive/

vi hive.log

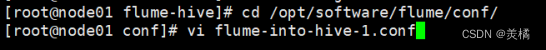

3.在flume的conf路径中编写配置文件

代码:

cd /opt/software/flume/conf/

vi flume-into-hive-1.conf

代码:

agent.sources=r1

agent.channels=c1

agent.sinks=s1

agent.sources.r1.type=exec

agent.sources.r1.command=tail -F /root/flume-hive/hive.log

agent.channels.c1.type=memory

agent.channels.capacity=1000

agent.channels.c1.transactionCapacity=100

agent.sinks.s1.type=hdfs

agent.sinks.s1.hdfs.path = hdfs://node01:9000/user/hive/warehouse/flume.db/flume_into_hive/dt=%Y%m%d

agent.sinks.s1.hdfs.filePrefix = upload-

agent.sinks.s1.hdfs.fileSuffix=.txt

#是否按照时间滚动文件夹

agent.sinks.s1.hdfs.round = true

#多少时间单位创建一个新的文件夹

agent.sinks.s1.hdfs.roundValue = 1

#重新定义时间单位

agent.sinks.s1.hdfs.roundUnit = hour

#是否使用本地时间戳

agent.sinks.s1.hdfs.useLocalTimeStamp = true

#积攒多少个 Event 才 flush 到 HDFS 一次

agent.sinks.s1.hdfs.batchSize = 100

#设置文件类型,可支持压缩

agent.sinks.s1.hdfs.fileType = DataStream

agent.sinks.s1.hdfs.writeFormat=Text

#多久生成一个新的文件

agent.sinks.s1.hdfs.rollInterval = 60

#设置每个文件的滚动大小大概是 128M

agent.sinks.s1.hdfs.rollSize = 134217700

#文件的滚动与 Event 数量无关

agent.sinks.s1.hdfs.rollCount = 0

agent.sources.r1.channels=c1

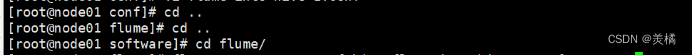

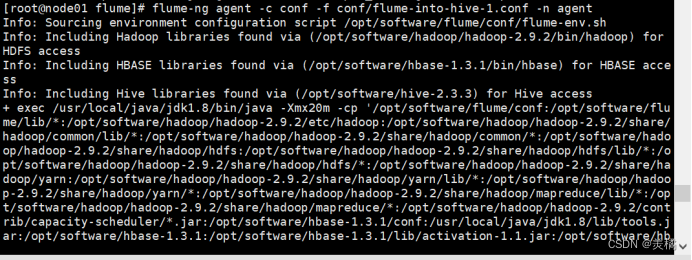

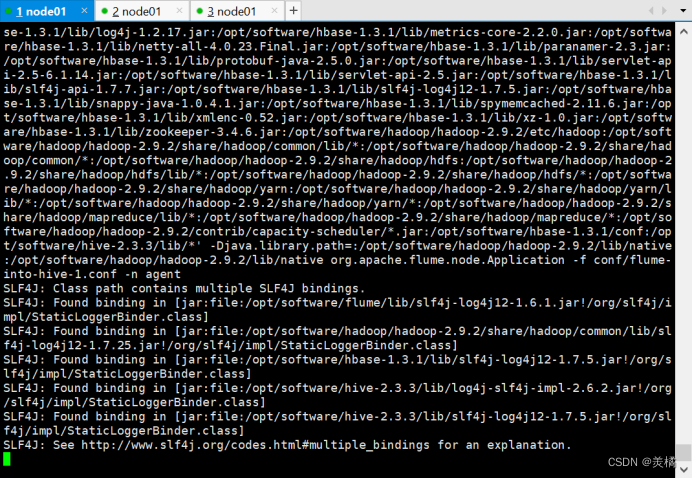

agent.sinks.s1.channel=c14.运行flume

代码:

bin/flume-ng agent -c conf -f conf/hive/flume-into-hive-1.conf -n agent

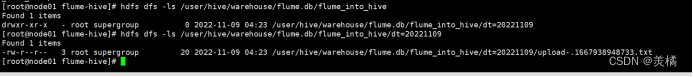

5.查询hdfs中的数据

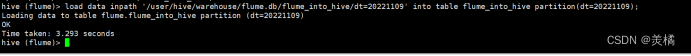

6.在hive表中加载数据

代码:

load data inpath '/user/hive/warehouse/flume.db/flume_into_hive/dt=20221109' into table flume_into_hive partition(dt=20221109);

7.查询hive表中的数据

select * from flume_into_hive;

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1381

1381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?