一、引言

随着大语言模型 (LLM) 的蓬勃发展,我们有了越来越多的 AI 工具选择。Chatbox 凭借其简洁的界面、跨平台支持(Windows, macOS, Linux)以及对用户隐私的重视,成为了许多开发者和 AI 爱好者的本地首选客户端。

2025年3月24日,Deepseek发布新模型“ DeepSeek-V3-0324”。3月25日,谷歌也发布功能强大的“Gemini 2.5 Pro Experiment 0325"模型。接下来我将和大家分享如何将这两个备受欢迎且各具特色的 AI 服务接入 Chatbox。

首先需要说明,这两个模型均可以在其官网进行免费体验:

2、Create Prompt | Google AI Studio,或者Gemini(这两个网站二者均需要科学上网,且需要谷歌账号)

官网体验可能会出现一些问题:

1、DeepSeek由于是国内大模型,能力强,用户较多,官网使用可能会出现“请求繁忙”的问题。

2、Gemini模型在其AI Studio网页输出的内容格式经常会出现问题,尤其是代码、公式等

因此采用Chatbox调用API的方法。

二、安装 Chatbox

1、打开下载网页:https://chatboxai.app/zh#download,点击下载按钮

2、下载好之后如下:

3、双击 开始安装,点击“仅为我安装”点击“下一步”

4、点击“浏览”,选择合适的路径,然后点击“安装”

5、安装完毕

三、创建Deepseek的API

1、调用官网api

1)、打开api官网:DeepSeek 开放平台,然后进行充值

需要说明的是,可以点击上图中“自定义”右侧的“查看价格”。根据需求充值合适的价格(若使用强度不高,充值5块钱也可以用好久)

2)、然后点击“API keys”,创建api。随便输入一个名称,创建即可。可复制到剪贴板。注意这里只能在创建时复制一次,及时备份。

2、调用“siliconflow”的API。

华为硅基流动官网:https://cloud.siliconflow.cn/models,可以看到有很多的模型可以调用或者在线体验。这个官网注册之后会赠送16元的余额,但是这个余额只可用于“支持赠送余额的模型”,也就是图“扣费方式”中需要出现小礼盒的标志。但是在线体验功能较少。不太推荐在线体验。

再者,pro模型相较于免费模型而言,需要付费,但是响应速度更快,价格和官网保持一致。

那为什么官网可以使用API了,还要推荐硅基流动的API呢?因为硅基流动的模型更多,不仅仅只有Deepseek的模型,还有千问的很多模型(比如可以调用与Deepseek-R1相媲美的QwQ-32B)。

接下来介绍调用方法,首先需要完成实名认证。

1)完成实名认证后,进行余额充值。方式与官网类似

2)、 创建API密钥,与官网类似。得到API。

四、创建Gemini的API

谷歌的模型非常强大,而且种类繁多,针对不同要求(响应速度、复杂推理、更长的上下文)推出了不同的模型,Gemini 2.0的各个版本都非常好用,在大模型竞技场名列前茅,主要是质量不低的同时相应速度更快,输出内容更“全面和详细”。API不收取任何费用,当然也可以采用付费的方式,二者区别大概有两个:

- 付费模式的API请求次数更多,但是免费版的次数也不少,完全够日常使用。

- 免费版使用时,输入输出的数据会用于模型的改进,而付费版不会

具体限制可参考:Gemini Developer API 价格 | Gemini API | Google AI for Developers

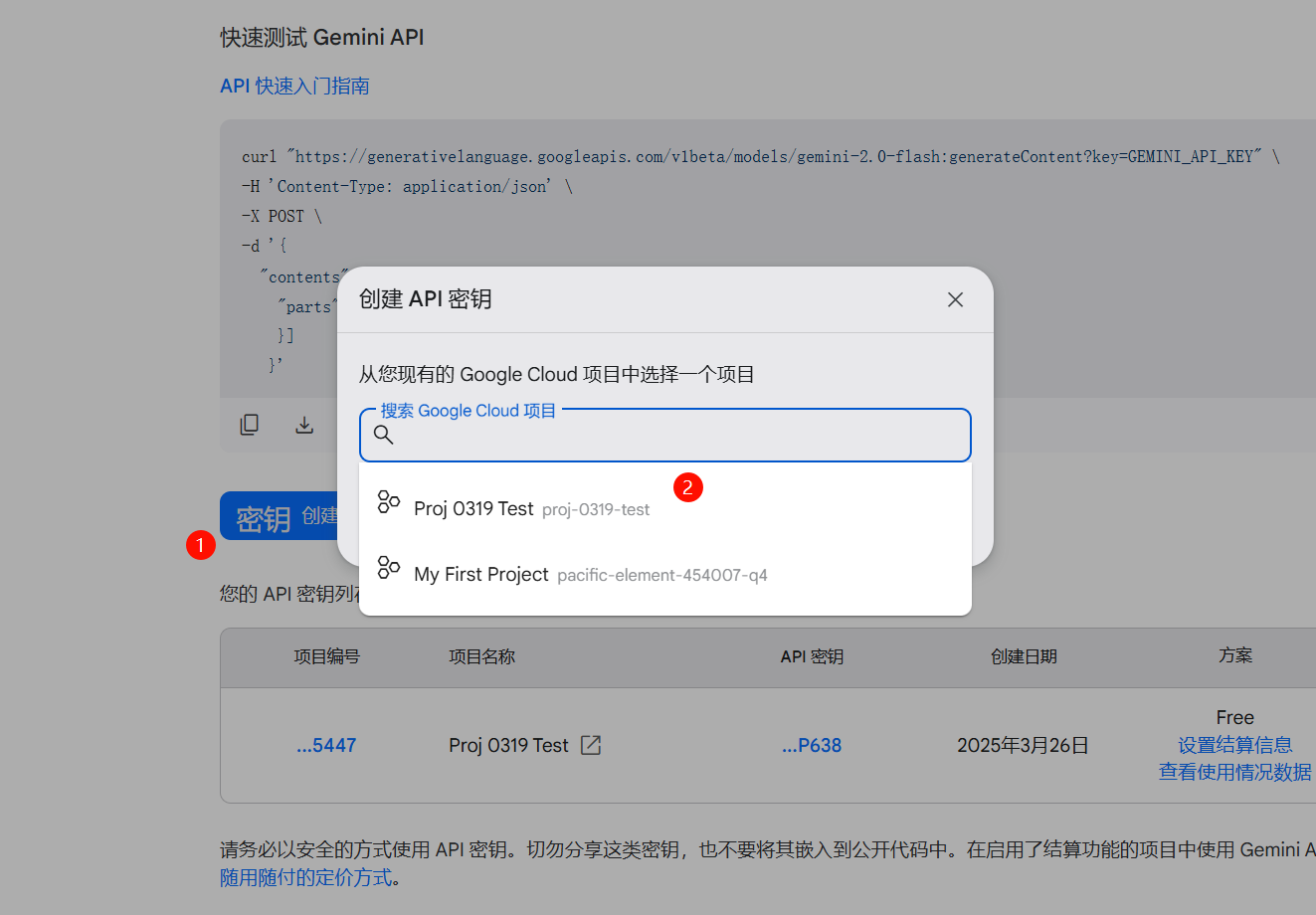

在打开魔法的前提下(节点必须选择“国际节点”),打开API创建页面,点击“创建密钥”,然后选择一个项目。最后复制API密钥即可。

Get API key | Google AI Studio

五、在Chatbox调用API

1、打开Chatbox,删除原有的对话,保持整洁。

2、点击“设置->模型->模型提供方下面的蓝色选项”,选择DeepSeek API,然后输入刚才创建的API序列号输入即可。模型随便选择一个,后面可以修改。

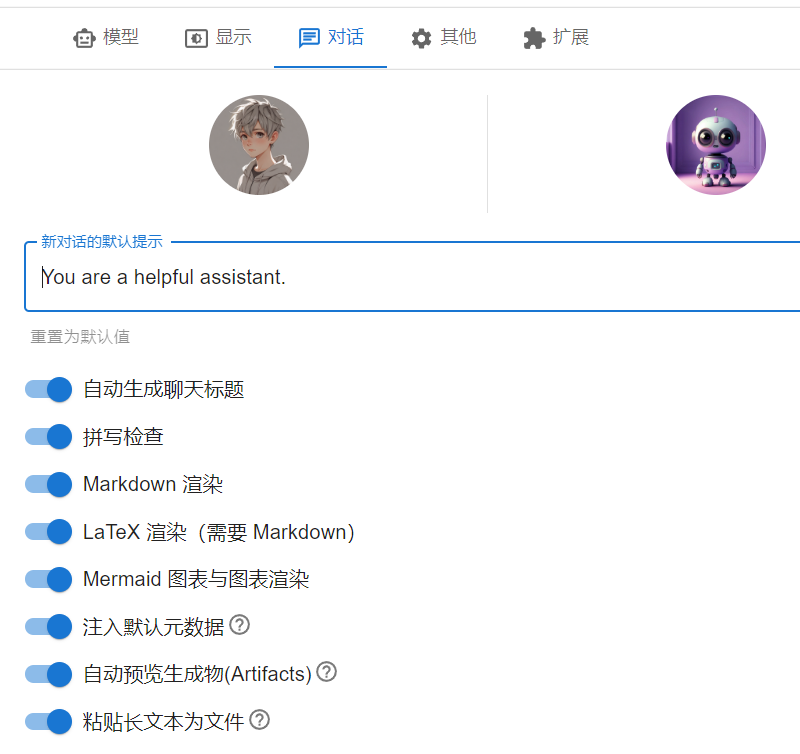

此外,点击“显示”或者“对话”或者“其他”等等模块,可以根据需要进行选择。建议全部开启。尤其是Markdown渲染、Latex渲染等。

3、 新建一个对话,还可以右下角选择适当的模型。chat对应V3,reasoner对应R1。

4、发送问题,进行对话。

可以看到,chatbox自动给这个对话创建了一个标题叫“初次问候”,而且这个对话是自动保存的,直接关闭软件再次打开这个对话还在,上下文也不会丢失,这是chatbox最大的优点。

5、切换模型

在“设置->模型”中选择SILICONFLOW API,输入密钥选择适合的模型即可切换。

Gemini模型同理

在“设置->模型”中选择的模型是“全局模型”,在新建对话时会默认使用全局模型

但是可以点击上方的'Untitled"弹出一个界面,可设置这个对话的特定模型。

六、使用技巧

1、建立多个对话,然后每个对话手动命名。可以根据模型命名,也可以根据需求命名。每个对话设置特定的模型,这样可以根据需求直接进行选择合适的对话。把每个对话看做一个“工作空间”,比如在“文献解析”对话中遇到了一个专有名词,可以直接切换到“名词介绍”对话进行提问。提问完再返回“文献解析”对话,上下文已被自动保存。

2、这几个选项分别是:

- 清除上下文。在某个对话中如果本轮提问结束,或者上下文太长,而且没有必要使用最开始的内容,可以清除上下文。

- 添加图片。这个需要选择的模型支持图像解析功能

- 添加文件

- 添加连接

- 打开联网搜索功能

常用的就是添加文件和清除上下文。当然清除的上下文也可以通过如下按钮找回。

七、总结

本文详细介绍了在Chatbox中配置和调用Deepseek模型与Gemini模型API的方法。选择Deepseek是因为其对中文的良好支持以及在国内获取API的便利性,而Gemini则以其快速的响应速度、强大的功能以及完全免费的特性脱颖而出。当然,Chatbox也支持调用包括OpenAI和Claude在内的其他API,用户可以根据自身需求和偏好自由选择。

1712

1712

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?