目录

准备阶段

1.JDK检查

判断是否已安装JDK,若无则安装,若有则进入正题。

# java -version安装阶段

1.JDK安装

详解https://blog.csdn.net/qq_53715214/article/details/123890380?spm=1001.2014.3001.5502

2.hadoop 安装

进入设置好共享的文件夹下进行解压移动 hadoop

# vmhgfs-fuse .host:/ /mnt/hgfs 挂载共享文件夹

# cd /mnt/hgfs/Downloads 进入共享文件夹

# sudo tar -zxf hadoop-3.1.3.tar.gz -C /usr/local 解压已经下载好的hadoop

# cd /usr/local 进入解压后的目录

# mv hadoop-3.1.3 hadoop 移动到指定目录

# ls 查看是否有对应的目录测试 hadoop 是否可用,hadoop 解压后即可使用,输入以下命令检查是否有版本信息。

# cd /usr/local/hadoop

# ./bin/hadoop version3.hadoop 单机配置(非分布式)

运行下面命令看见 hadoop 所有例子

# ./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar 例子

# cd /usr/local/hadoop

# mkdir ./input

# cp ./etc/hadoop/*.xml ./input

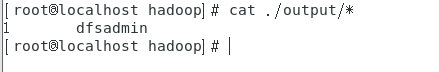

# ./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep ./input ./output 'dfs[a-z.]+'

# cat ./output/* 执行成功后如下显示:

4.hadoop 伪分布式配置

# gedit ./etc/hadoop/core-site.xml修改配置文件

<configuration>

</configuration>

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration># gedit ./etc/hadoop/hdfs-site.xml<configuration>

</configuration>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>配置 hadoop 环境变量

# echo 'export HADOOP_HOME=/usr/local/hadoop/' >> /etc/profile

# echo 'export PATH=$PATH:$HADOOP_HOME/bin' >> /etc/profile

# echo 'export PATH=$PATH:$HADOOP_HOME/sbin' >> /etc/profile

# source /etc/profile

# gedit /etc/profileexport HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root# source /etc/profile配置完成后执行NameNode的格式化

# cd /usr/local/hadoop

# ./bin/hdfs namenode -format如果出现

Error: JAVA_HOME is not set and could not be found.请到 hadoop 的安装目录修改配置文件"/usr/local/hadoop/etc/hadoop/hadoop/hadoop-env.sh"在里面找到

# export JAVA_HOME=把它改为(自己的jdk路径),然后再执行NameNode的格式化

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162能够出现以下结果表示配置完成

root登录,安装SSH,配置SSH 无密码登录,根据提示 y

# sudo yum install openssh-server# ssh localhost

# exit

# cd ~/.ssh/

# ssh-keygen -t rsa以上部分根据提示回车即可

# cat ./id_rsa.pub >> ./authorized_keys 加入授权

# ssh localhost 无密登录

再次进入 Hadoop ,并启动

# cd /usr/local/hadoop

# ./sbin/start-dfs.sh 输入 jps 查看进程

# jps如果出现 jps未找到命令,输入以下进行更新后再输入 jps 查看进程

sudo yum install java-1.8.0-openjdk-devel.x86_64

如上所示:

测试阶段

1.浏览器访问

在centOS 7 的浏览器上访问 localhost:9870 出现以下界面: 伪分布式安装成功

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?