简介

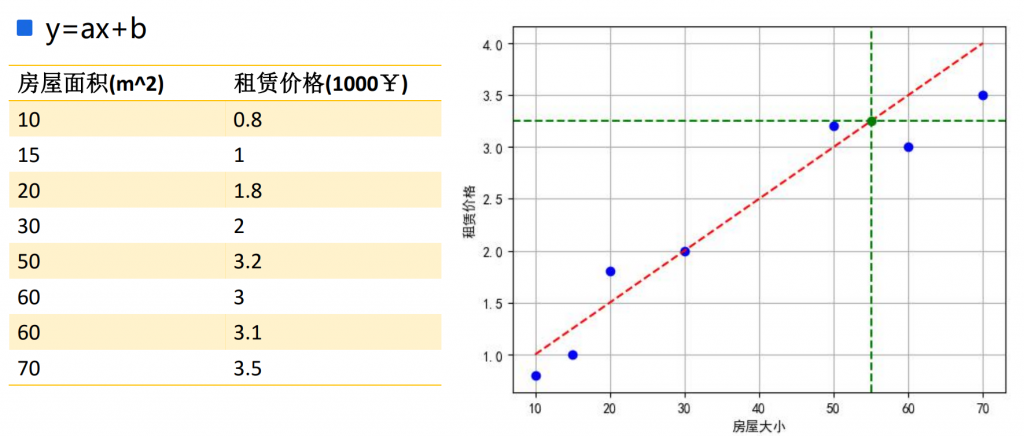

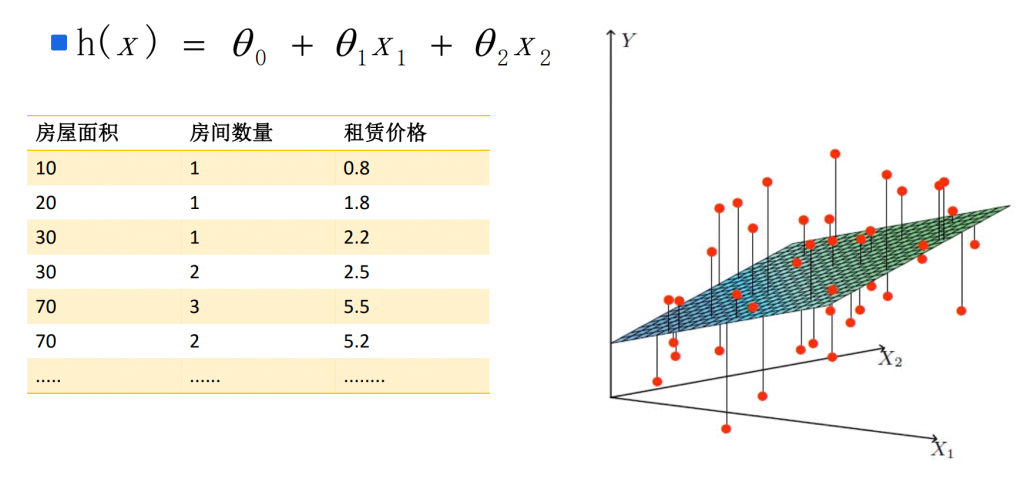

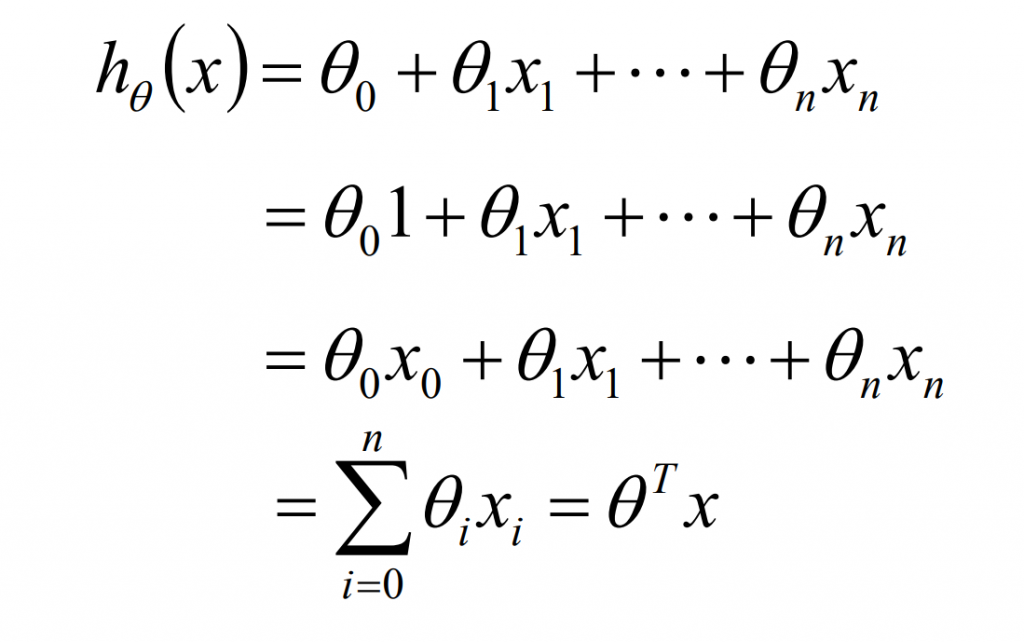

- 线性回归的最终目的就是需要就算出θ的值,并选择最优的θ值构成算法公式

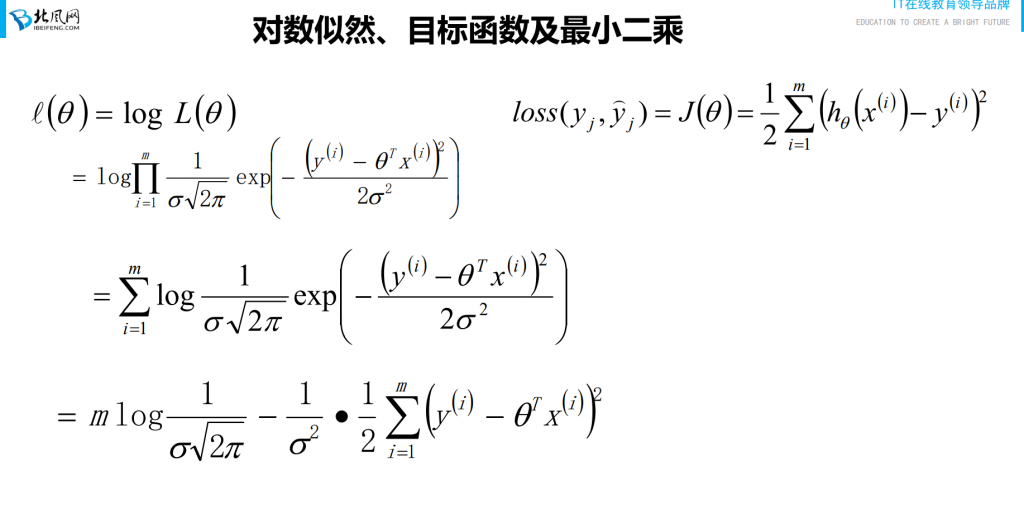

线性回归、最大似然估计及二乘法

y(i) = θT + ε(i)

- 误差 ε(i)(1<=i<=n)是独立分布的,服从均值为0,方差为某定值σ2的高斯分布。

原因:中心极限定理

似然函数

对数似然、目标函数及最小二乘

最小二乘法的参数最优解

- 参数解析式

θ = (XTX)-1XTY - 最小二乘法的使用要矩阵XT是可逆的;为了防止不可逆或者过拟合的问题存在,可以增加额外数据影响,导致最终的矩阵是可逆的:

θ = (XTX + λI)-1XTY - 最小二乘法直接求解的难点:矩阵逆的求解是一个难处# 目标函数(loss/cost function)

线性回归的过拟合

过拟合和正则项

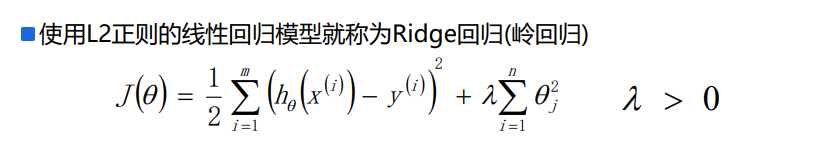

Ridge回归

LASSO回归

Ridge(L2-norm)和LASSO(L1-norm)比较

- L2-norm中,由于对于各个维度的参数缩放是在一个圆内缩放的,不可能导致有维度参数变为0的情况,那么也就不会产生稀疏解;实际应用中,数据的维度中是存在噪音和冗余的,稀疏的解可以找到有用的维度并且减少冗余,提高回归预测的准确性****和鲁棒性(减少了overfitting)(L1-norm可以达到最终解的稀疏性的要求)

- Ridge模型具有较高的准确性、鲁棒性以及稳定性;LASSO模型具有较高的求解速度。

- 如果既要考虑稳定性也考虑求解的速度,就使用Elasitc Net

模型判断效果

- MSE:误差平方和,越趋近于0表示模型越拟合训练数据。

- RMSE:MSE的平方根,作用同MSE

- R2:取值范围(负无穷,1],值越大表示模型越拟合训练数据;最优解是1;当模型预测为随机值的时候,有可能为负;若预测值恒为样本期望,R2为0

- TSS:总平方和TSS(Total Sum of Squares),表示样本之间的差异情况,是伪方差的m倍

- RSS:残差平方和RSS(Residual Sum of Squares),表示预测值和样本值之间的差异情况,是MSE的m倍

机器学习调参

- 在实际工作中,对于各种算法模型(线性回归)来讲,我们需要获取θ、λ、p的值;θ的求解其实就是算法模型的求解,一般不需要开发人员参与(算法已经实现),主要需要求解的是λ和p的值,这个过程就叫做调参(超参)

- 交叉验证:将训练数据分为多份,其中一份进行数据验证并获取最优的超参:λ和p;比如:十折交叉验证、五折交叉验证(scikit-learn中默认)等

819

819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?