这章与前面 一章不同,虽然前一章是线性回归,这样也叫回归,但是我们要清楚这章的内容不是一个回归方程,他是一个分类问题的算法。当然为什么要叫回归,是因为历史的原因,废话不多说,大家只需要记住这是一个分类问题就好。

1.前言

分类问题在我们的日常生活中有很大的用途,例如判断电子邮件是否是垃圾邮件,判断一个肿瘤是良性或恶性的。我们先从二元分类问题来讨论。

首先,对于因变量一般属于两类,正向类(1)或负向类(0)

如果我们规定

现在假如有这么几个案例,

则我们的hθ(x) 应该是这样的曲线,但如果现在又加入了一个案例且,这个案例比较特殊,也就是我们的红色×。如今我们的hθ(x)就变成了红线。

问题就来了。原本的样本我们的判定值在竖蓝线的位置,但如今假如了样本我们的判定就后移到红色线了。并且我们知道分类问题,y值 要么是0,要么是1,那么当我的x非常大,那么我的hθ(x)取值却会远远大于1,这就是一个很奇怪的问题了。

2.模型

我们使用这个模型完全的保证了其hθ(x)永远不会小于0和大于1

3.决策边界

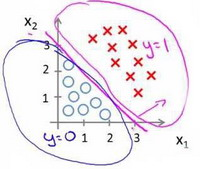

蓝线则为决策边界,他是为了帮助我们将0,1的区域区分开的。

4.代价函数

我们要定义我们的代价函数或者说拟合参数的优化目标。

左图中显示的是所有模型误差的平方和也就是在线性回归中的代价函数,但是我们将此定义带到这里,就会出现一个非凹函数,我们会有很多局部最小值,此函数会防止我们得到全局最小值。这也是为什么我们会在分类问题上使用另一个代价函数的形式。

上述表达式,可以得到右图的凹函数,它可以让我们轻而易举的得到全局最优值。

左图:当实际的y值为1时,而我们的预测值hθ(x)为0时,就会产生很大的cost值惩罚。

右图:如果实际的y值为0时,预测hθ(x)为1时,就会产生很大的cost值惩罚。

将上述式子合并以便于我们写出关于梯度下降的公式。

5.梯度下降

梯度下降的公式:同样线性回归的梯度下降也是适用于这个的

以下是严格的数学证明

979

979

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?