解压文件包

tar -zxvf /root/spark-3.4.2-bin-hadoop3.2.tgz -C /usr/local/src

进入Spark安装目录的/bin目录,使用SparkPi计算Pi的值

cd /usr/local/spark-3.4.2-bin-hadoop3.2/bin/

./run-example SparkPi 2

如果执行时输出非常多的运行日志信息,输出结果找不到,就使用grep命令进行过滤(命令中的 2>&1 可以将所有的信息都输出到 stdout 中,否则由于输出日志的性质,还是会输出到屏幕中)

./bin/run-example SparkPi 2>&1 | grep "Pi is"

搭建单机伪分布式集群

cd /usr/local/src/spark-3.4.2-bin-hadoop3.2/conf/

cp spark-env.sh.template spark-env.sh

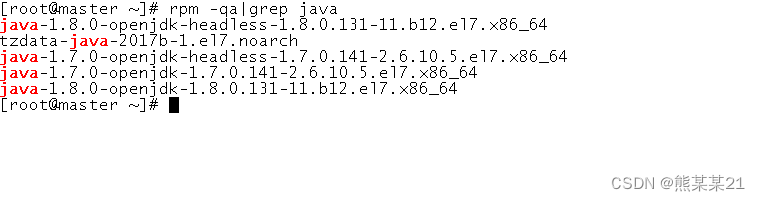

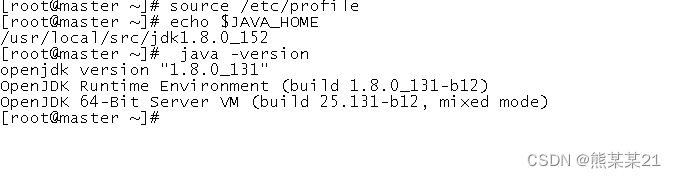

准备好Java环境

检查是否能用

打开在spark文件下面打开spark-env.sh文件,在文件末尾添加代码:

vim spark-env.sh

export SCALA_HOME=/usr/local/srcscala

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export SPARK_MASTER_IP=master

export SPARK_WOKER_CORES=2

export SPARK_WOKER_MEMORY=2g

export HADOOP_CONF_DIR=/usr/opt/module/hadoop/etc/hadoop

#export SPARK_MASTER_WEBUI_PORT=8080

#export SPARK_MASTER_PORT=7070

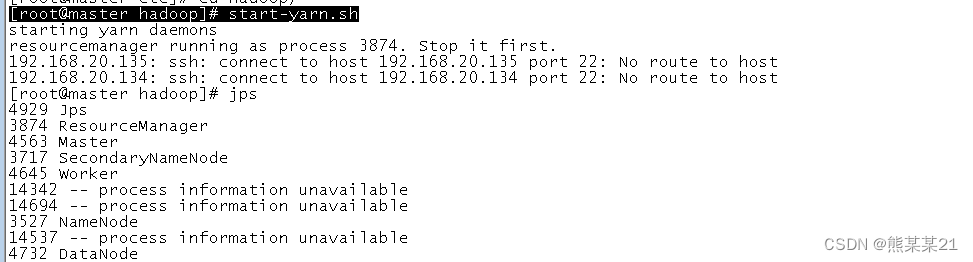

进入spark/sbin 启动spark ./start-all.sh

cd /opt/module/spark/sbin

./start-all.sh

jps查看

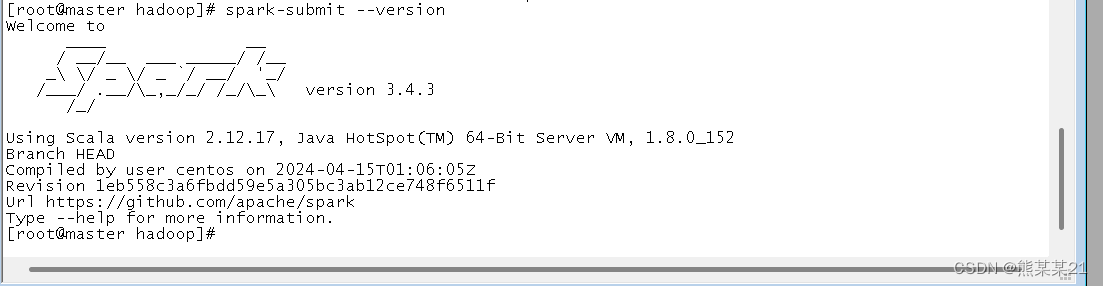

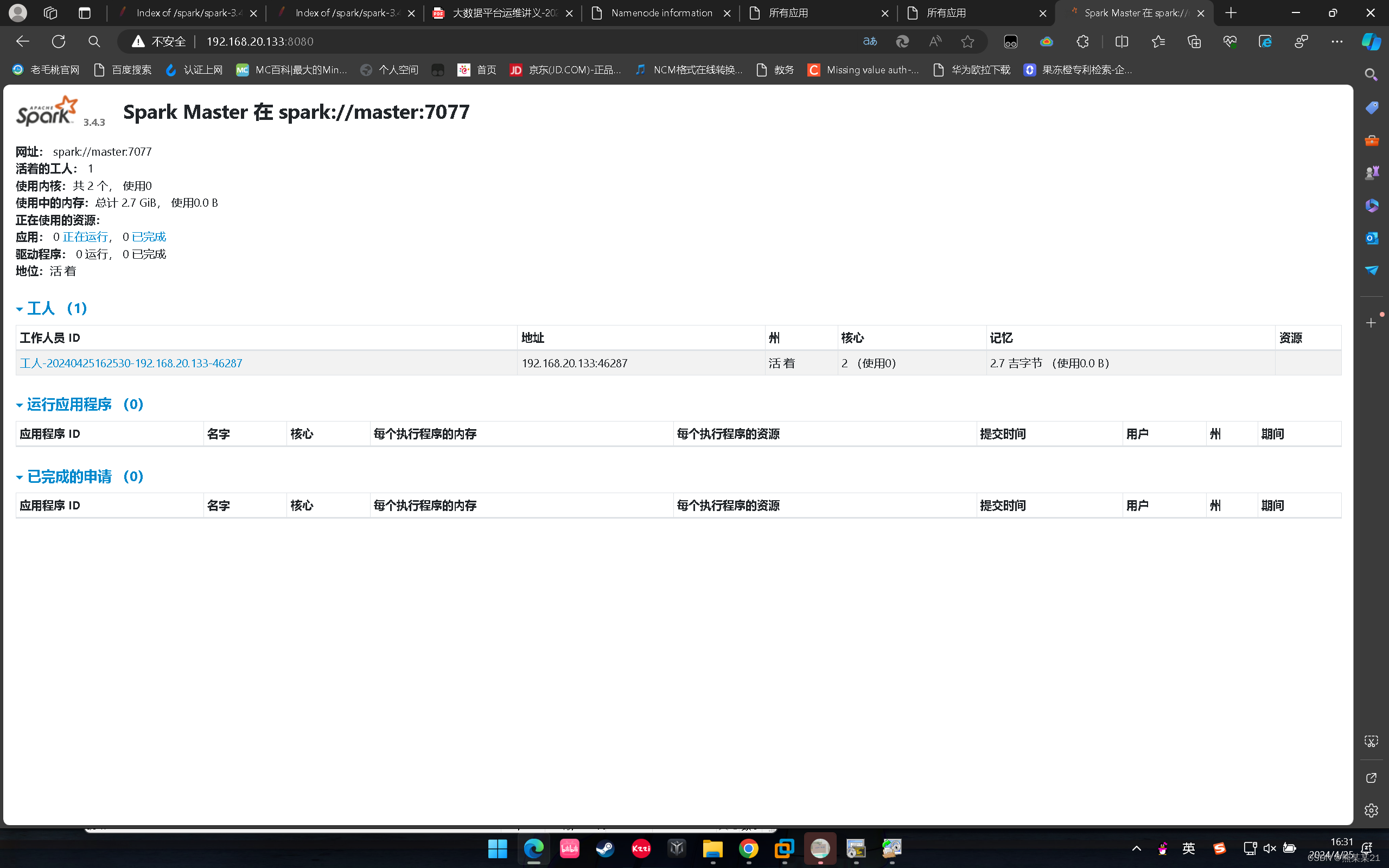

查看spark

进入网页查看

输入IP进入网页浏览

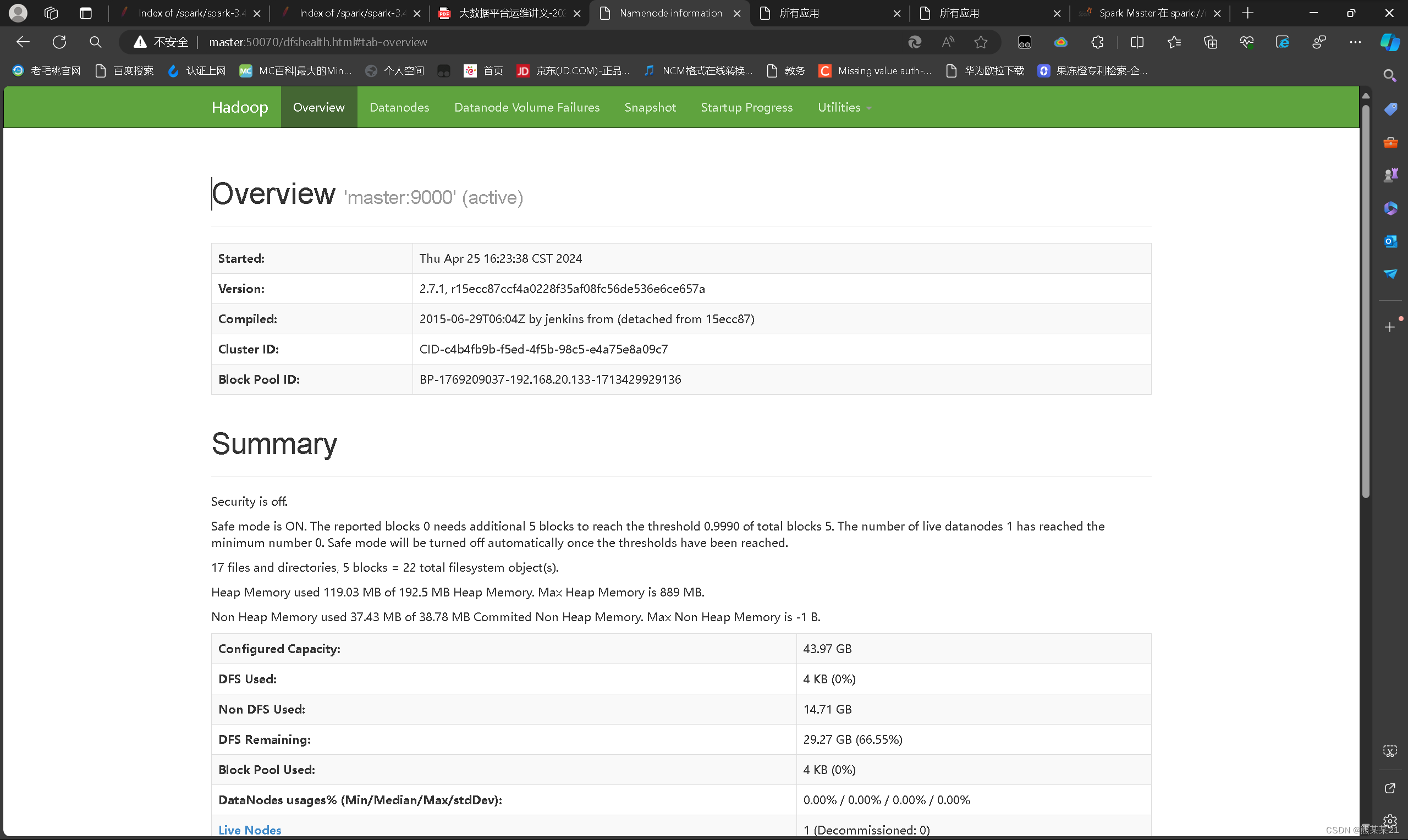

192.168.128.134:50070

进入spark网页界面查看

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?