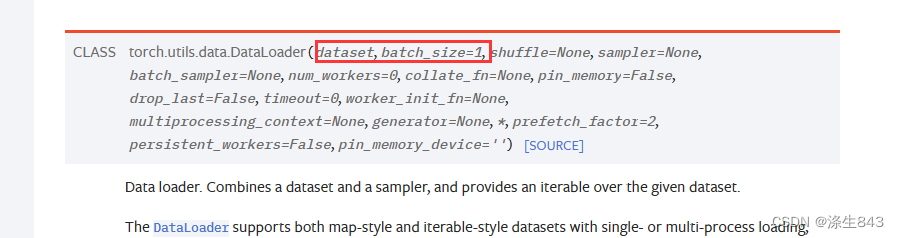

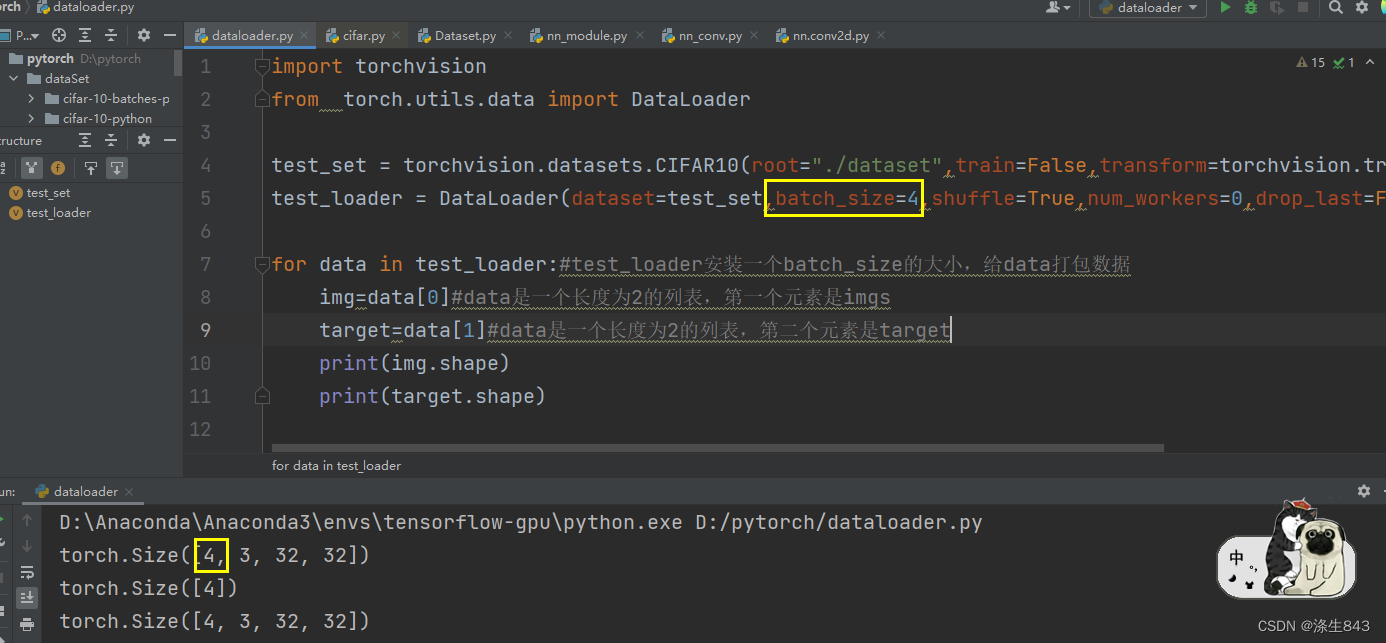

DataLoader类的作用是根据batch_size的尺寸,每次从dataset里面返回该尺寸大小的数据data。

该类实现了__iter__函数,所以它是一个可迭代对象。每次迭代返回的就是从dataset中取得batch_size大小的数据data(注意,这个data的长度不是batch_sieze,而是dataset的__getitem__函数返回值的数目。例如,如果__getitem__函数返回的是(img,target),则len(data)是2)

而dataset如果实现了__getitem__函数,那么就可以通过查看它的__getitem__函数返回值,来得知最后data中包含什么内容。

2163

2163

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?