一.准备工作

我们需要先做好如下准备工作。

1.安装好Python3,最低为3.6 版本,并能成功运行 Python3 程序。

2.了解 Python HTTP请求库requests 的基本用法。

3.了解正则表达式的用法和 Python 中正则表达式库 re 的基本用法。

二.爬取目标

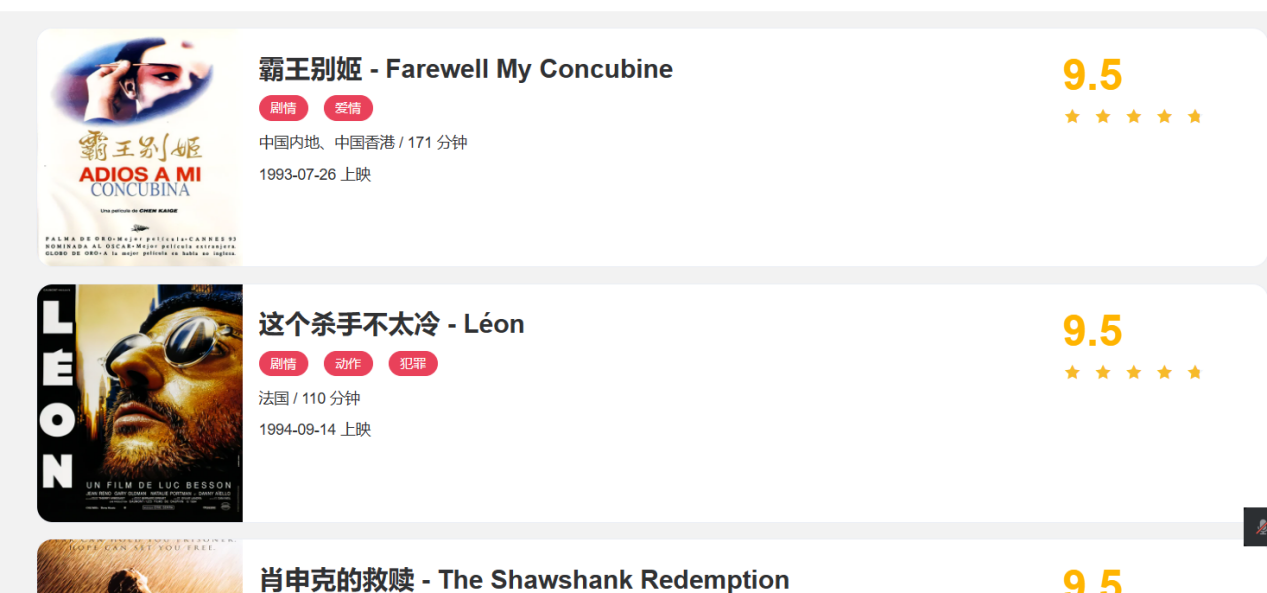

本节我们以一个基本的静态网站作为案例进行爬取,需要爬取的链接为 https://ssr1.scrape.center/,这个网站里面包含一些电影信息,界面如图所示。

我们本次爬虫要完成的目标有:

1.利用 requests 爬取这个站点每一页的电影列表,顺着列表再爬取每个电影的详情页;

2.用正则表达式提取每部电影的名称、封面、类别、上映时间、评分、刷情简介等内容

把以上爬取的内容保存为JSON 文本文件;

三.爬取列表页

第一步爬取肯定要从列表页人手,我们首先观察一下列表页的结构和翻页规则。在浏览器中访问https://ssrl.scrape.center/,然后打开浏览器开发者工具,如图所示。

每一个电影信息区块对应的 HTML 以及进入到详情页的 URL,可以发现每部电影对应的区块都是一个div节点,这些节点的 class 属性中都有 el-card这个值。每个列表页有 10个这样的 div节点,也就对应着 10 部电影的信息。

接下来再分析一下是怎么从列表页进入详情页的,我们选中第一个电影的名称,看下结果,如图所示。

这个名称实际上是一个 h2 节点,其内部的文字就是电影标题。h2 节点的外面包含一个a节点,这个a节点带有 href属性,这就是一个超链接,其中 href 的值为 /detail/1,这是一个相对网站的根 URL https://ssrl.scrape.center/ 的路径,加上网站的根 URL 就构成了 https://ssrl.scrape.center)detail/1,也就是这部电影的详情页的 URL。这样我们只需要提取这个 href 属性就能构造出详情页的URL 并接着爬取了。

接下来我们分析翻页的逻辑,拉到页面的最下方,可以看到分页页码,如图所示。

网页的URL变成了 https://ssrl.scrape.center/page/2,相比根 URL多了 /page/2 这部分内容。网页的结构还是和原来一模一样,可以像第 1页那样处理。

接着我们查看第3页、第4页等内容,可以发现一个规律,这些页面的URL最后分别为 /page/3/page/4。所以,/page 后面跟的就是列表页的页码,当然第 1 页也是一样,我们在根 URL后面加上/page/1 也是能访问这页的,只不过网站做了一下处理,默认的页码是1,所以第一次显示的是第1页内容。

首先,需要先定义一些基础的变量,并引人一些必要的库,写法如下

import requests

import logging

import re

from urllib.parse import urljoin

RESULT_DIR = 'result'

logging.basicConfig(level=logging.INFO,

format='%(asctime)s - %(levelname)s: %(message)s')

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3561

3561

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?