首先打开题目,看题目的提示Robots

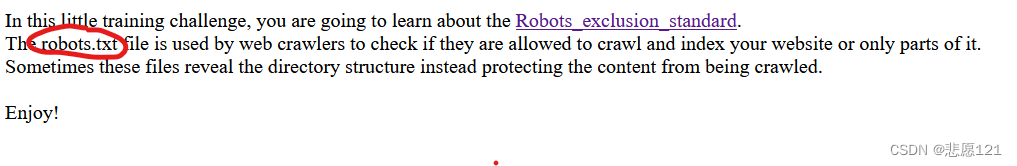

进入题目后 检查页面内容

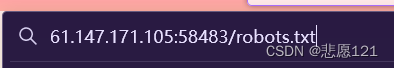

发现robots.txt 爬虫协议。如果想单独定义搜索引擎的漫游器访问子目录时的行为,那么可以将自定的设置合并到根目录下的robots.txt,即

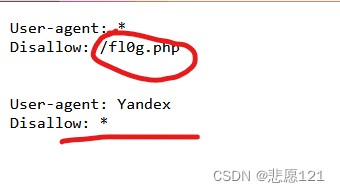

之后得到

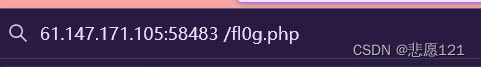

再将/fl0g.php 注入

最后得到flag

cyberpeace{4074e72d087780d5a5006265685d1cfa}

robots.txt是一个用于网站的文本文件,其中包含一些指令,告诉搜索引擎爬虫哪些页面可以被抓取和索引,以及哪些页面不应该被访问。

这个文件通常位于网站的根目录下,并且遵循一定的语法规则,以确保搜索引擎爬虫正确地解析和执行其中的指令。

robots.txt文件中有以下两个主要的属性:

1. User-agent:指定搜索引擎爬虫的名称,常见的有Googlebot、Bingbot等。

2. Disallow:指定不希望搜索引擎爬虫访问的页面或目录。

robots.txt文件的设置方法如下:

1. 打开文本编辑器,新建一个空白文件并命名为robots.txt。

2. 在文件开头添加User-agent属性和对应的搜索引擎爬虫名称,例如“User-agent: Googlebot”。

3. 在该搜索引擎爬虫名称下方添加Disallow属性,并指定不允许访问的页面或目录,例如“Disallow: /private/”。

4. 如果要添加多个搜索引擎爬虫的规则,重复以上步骤即可。

5. 保存文件并上传至网站根目录下。

需要注意的是,robots.txt文件只能约束遵循Robots协议的搜索引擎爬虫,而且不是一种安全措施。如果网站上的某些页面内容非常敏感,无法公开访问,就需要采取其他更加有效的安全措施来保护这些页面。

(作者:鸭梨讲IT

链接:https://www.zhihu.com/question/592488164/answer/2958376291

来源:知乎)

Robots.txt 是一个网站文件,它告诉搜索引擎蜘蛛不要抓取网站的某些页面或某些部分。大多数主流搜索引擎(包括谷歌、必应和雅虎)都承认并尊重 Robots.txt 请求。

大多数网站不需要 robots.txt 文件。

因为谷歌通常可以找到并索引你网站上所有重要的页面。

并且它们会自动不索引不重要的页面或者重复内容页面。

使用 robots.txt 文件有三个主要原因。

阻止非公开页面被搜索引擎索引: 有时你的网站上有不希望被索引的页面。例如,可能有一个网页的临时版本。或者登录页面。这些页面需要存在。但是你不希望其他人到这些页面上来。在这种情况下,你可以使用 robots.txt 来阻止搜索引擎爬虫和机器人访问这些页面。

最大化抓取预算: 如果你很难把所有页面都编入索引,那么你可能会遇到抓取预算问题。通过使用 robots.txt 屏蔽不重要的页面,让谷歌机器人可以花费更多的预算在真正重要的页面上。

防止对资源进行索引: 使用元指令可以像 Robots.txt 一样防止页面被索引。然而,元指令对于多媒体资源并不能有效地工作,比如 pdf 和图片。这就是 robots.txt 发挥作用的地方。

总之:Robots.txt 告诉搜索引擎蜘蛛不要在你的网站上抓取特定的页面。

你可以在谷歌搜索控制台中检查你网站已经索引了多少页面

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?