3.1.1决策树概念

决策树是一个预测模型,它代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表某个可能的属性值,而每个叶节点则对应从根节点到该叶节点所经历的路径所表示的对象的值。

3.1.2基本流程

1.数据准备:首先,需要收集和准备用于构建决策树的数据。这些数据应包括输入特征和相应的标签或输出。

2.特征选择:在构建决策树之前,需要选择最佳的特征来作为节点。常用的特征选择算法有信息增益、增益率、基尼不纯度等。

3.构建树:开始构建决策树。选择一个特征作为根节点,将数据集分成不同的子集。

4.剪枝:构建完整的决策树后,为了避免过拟合,可以进行剪枝操作。剪枝可以通过预剪枝或后剪枝实现,其中预剪枝在构建树的过程中进行剪枝,而后剪枝在构建完整树之后修剪无关的节点。

5.预测:使用构建好的决策树对新的未知样本进行分类或回归预测。从根节点开始,依次根据特征值选择相应的分支,直到到达叶子节点,得到预测结果。

6.评估:对构建的决策树进行评估,常用的指标包括准确率、精确度、召回率等。可以使用交叉验证等方法进行评估。

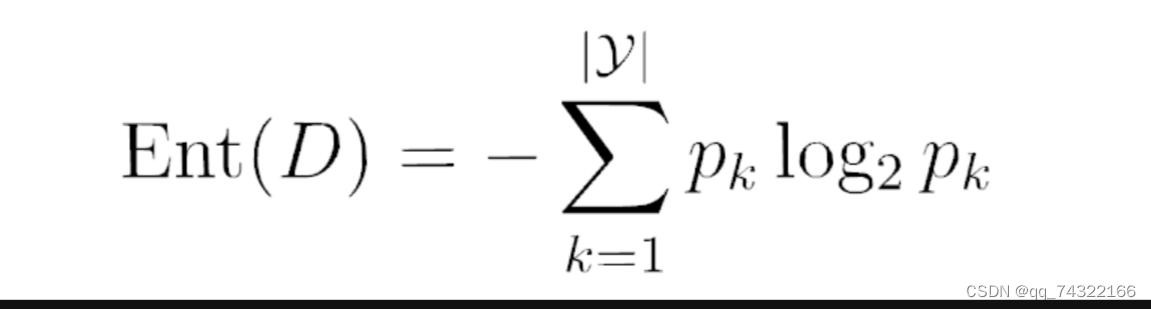

3.1.3信息熵

信息熵,其中这个“熵”(entropy)是指对复杂系统的刻画,可以理解为系统由不稳定态到稳定态所需要丢失的部分,信息熵可以理解为信息由不干净到干净所需要丢失的部分。信息熵满足公式:

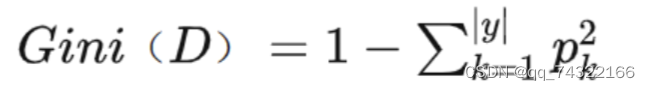

3.1.4基尼指数

基尼指数(Gini Index)或基尼不纯度(Gini Impurity)是评估决策树分裂质量的一个重要指标。不同于经济学中用于衡量收入分配均衡程度的基尼系数,这里的基尼指数反映了数据划分的不确定性或者混乱程度。基尼指数越小表示数据集的纯度越高,即分类越明确;反之,则表示数据集含有较多的不确定性,分类较为混乱。

3.1.5剪枝处理

“剪枝”是决策树学习算法对付“过拟合”的主要手段。

可通过“剪枝”来一定程度避免因决策分支过多,以致于把训练集自身的一些特点当做所有数据都具有的一般性质而导致的过拟合。剪枝通常分为两种,分别是预剪枝和后剪枝。

预剪枝:

是指在决策树的构建过程中,对每个节点进行划分前先进行估计。如果预测当前节点的划分不会带来决策树泛化性能的提升,则停止划分,并将该节点标记为叶节点。这相当于提前停止了树的生长,从而避免过度拟合训练数据。

后剪枝:

是先允许决策树完全生长,构成一棵完整的决策树,然后自底向上地对非叶节点进行考察。如果将某个节点对应的子树替换为叶节点能够提升决策树的泛化性能,那么就执行替换操作。这种方法通常会生成一个序列的剪枝树,从中选择最优的一棵树作为最终模型。

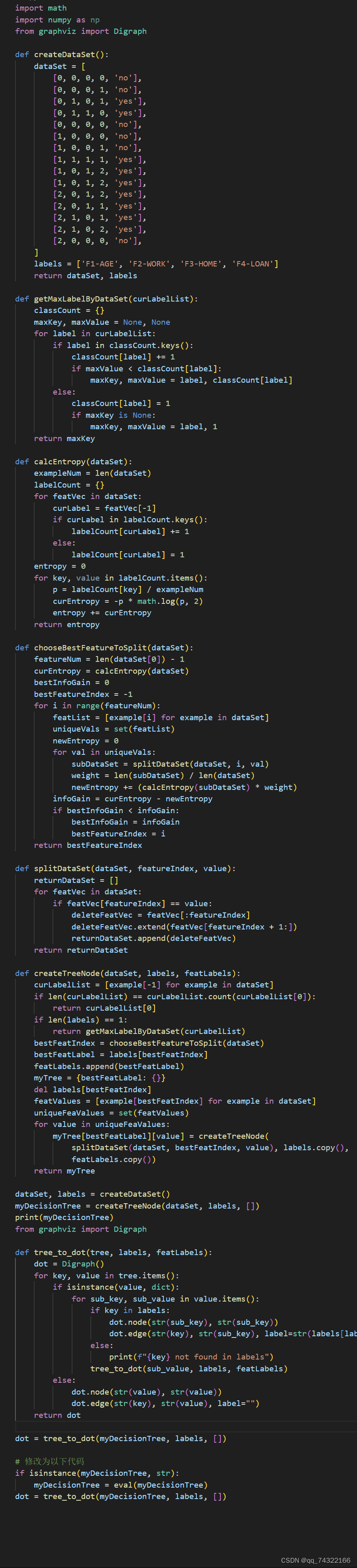

3.2决策树实现

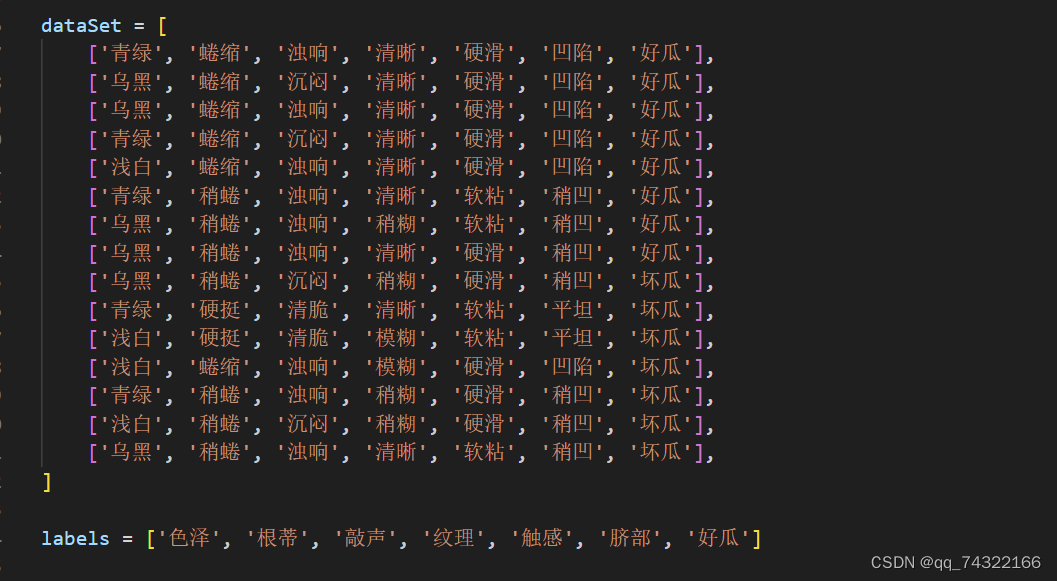

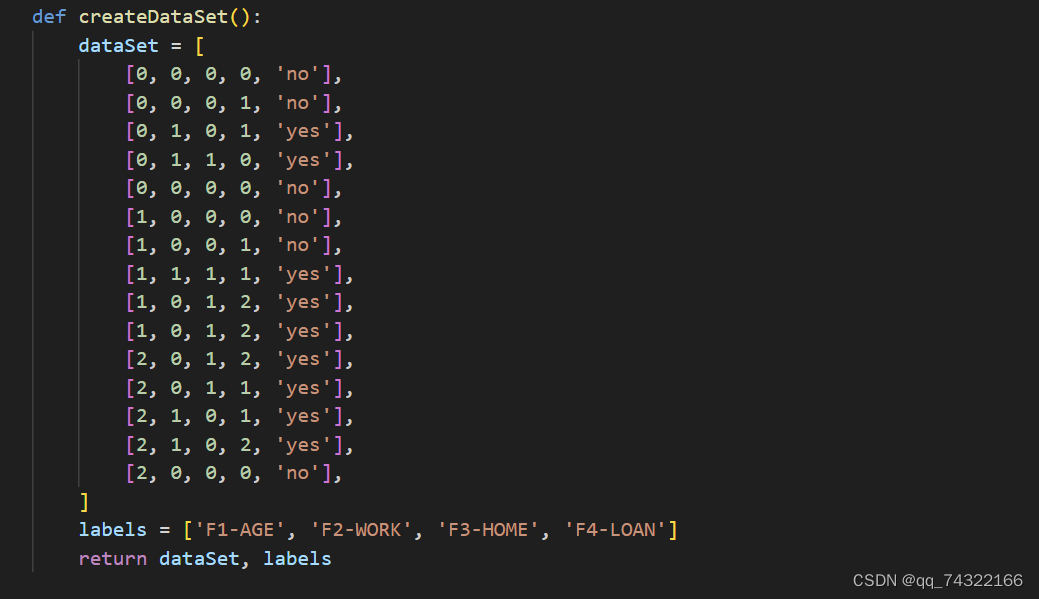

3.2.1数据集

3.2.2代码实现

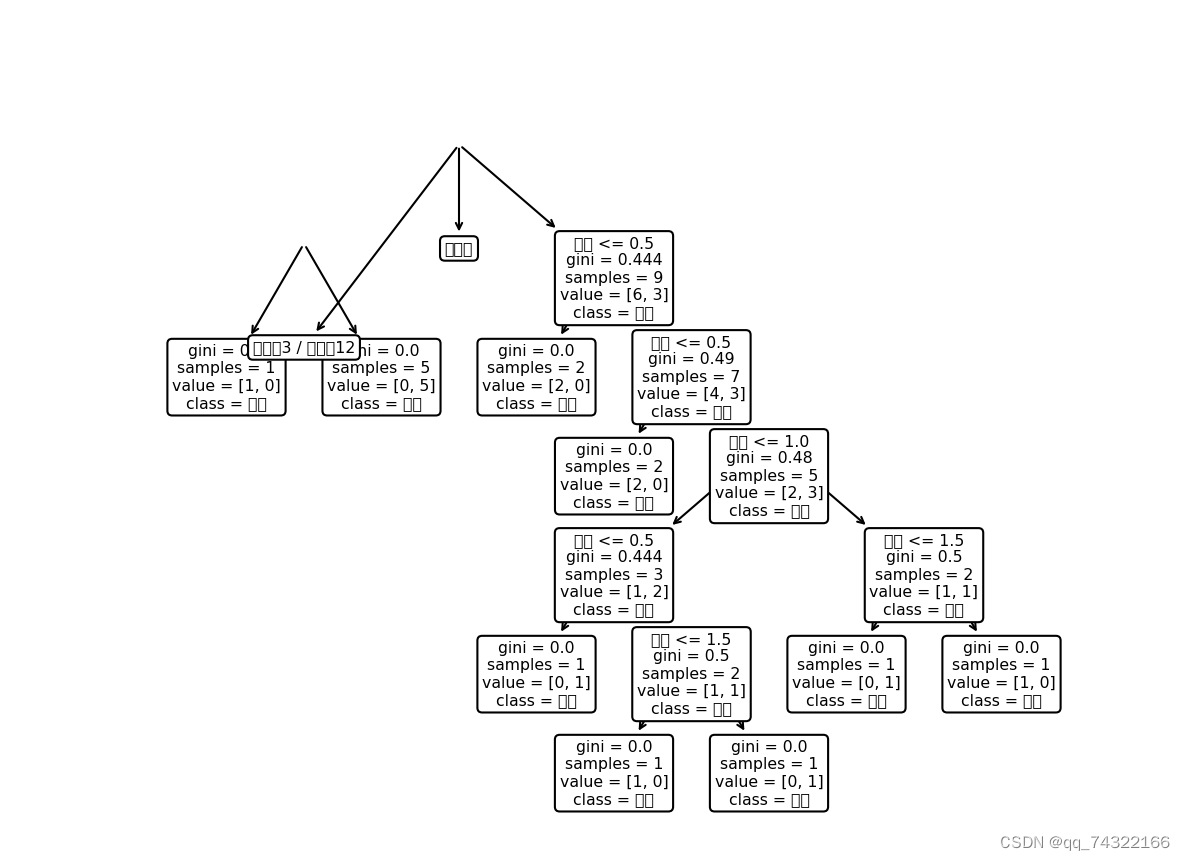

3.2.3运行结果

3.3实验小结

通过实验,可以更深入地理解决策树是如何根据特征进行分裂,以及如何通过节点的划分来进行预测。决策树虽然易于理解和解释,但也有局限性,比如容易过拟合、对噪声敏感等,可以更好地理解决策树模型的优缺点,不仅加深了对决策树算法的理解,还实际应用机器学习算法的能力,为解决实际问题奠定了基础。

803

803

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?