目录

线性模型:机器学习中应用最广泛的模型,指通过样本特征的线性组合来进行预测的模型。

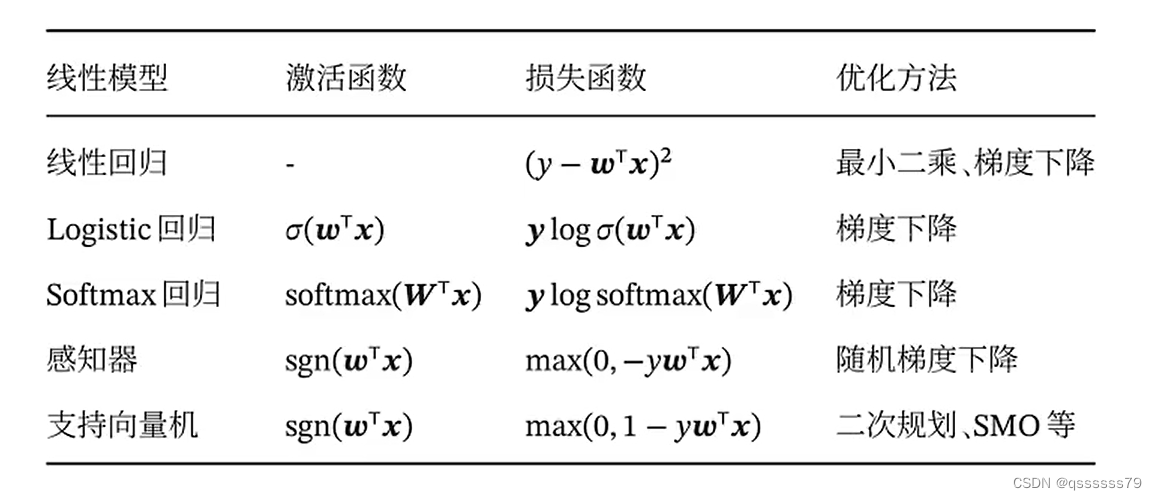

主要介绍四种不同的线性分类模型:logistic回归,softmax回归,感知器和支持向量机,这些模型区别主要在于使用了不同的损失函数。

3.1 线性判别函数和决策边界

一个线性分类器是由一个或多个线性的判别函数和非线性的决策函数组成。

线性模型的公式一般形式为:f(x;ω)=ω^T x+b;其中ω=[ω_1,⋯,ω_D]T为D维权重向量,b为偏置。在分类问题中,输出目标y是一些离散的标签,所以要引入其他函数来预测输出目标。

其中f(x;ω)为判别函数,决策函数g(·)。

例如:g(·)可以为符号函数:

当f(x;ω)=0时不预测。

3.1.1 两类分类

两类分类中,样本只有两种取值{-1,1},常用正例和负例来表示;二分类任务中,我们需要一个线性判别函数f(x;ω)=(ω^T)x+b.特征空间R^D中所有满足f(x;ω)=0的点组成一个分割超平面,称为决策边界或决策平面。将特征空间一分为二,每个区域对应一个类别。

其中决策边界与权重向量ω正交(因为f(x;ω)=0),特征空间中每个样本点到决策平面的有向距离为

γ也可以看作是点x在ω方向的投影。

在二分类问题中:在给定N个样本的训练集上,线性模型试图学习到参数ω*,使得每个样本(x^{(n)}, y^{(n)})尽量满足

联合上面两个式子,如果存在权重ω*,对所有样本有yf(x^{(n)};ω*)>0(当y=-1时满足yf(x^{(n)};ω*)>0即f(x^{(n)};ω*)<0 ; 当y=1时,f(x^{(n)};ω*)>0)则说明改训练集是线性可分的。

可以用0-1损失函数来度量模型的性能,但是在优化模型时,0-1模型就起不到应有的作用,因为其关于ω的导数为0。

3.1.2 多分类

多分类问题指问题类别数K≥3的情况{1,2,…,K},常用的分类方式主要有以下三种:

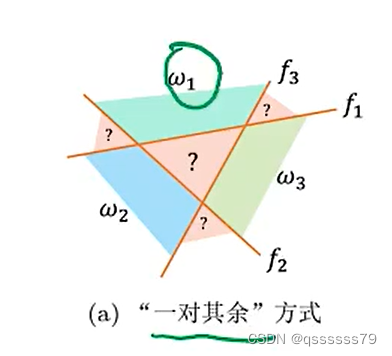

(1)“一对其他”:

把K个多类问题分成K个两类问题,每一个两类问题是一个一对多的问题(判断我是不是第i类),因此有K个判别函数,K组权向量。

如图中所示,每一类别可用一个简单的直线判别结面将它与其他类别分开。

例如:x∈ω1的模式,应同时满足:d 1 ( x ) > 0 , d 2 ( x ) < 0 , d 3 ( x ) < 0

IR(不确定区域):对某一区域, d i ( x ) > 0的条件超过一个,或者全部小于0时,无法判别出该区域到底属于哪一类。

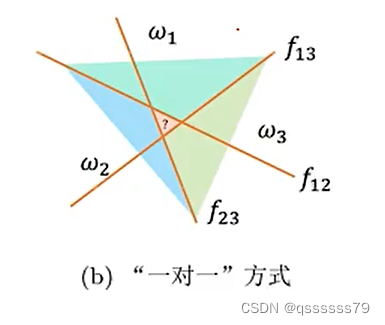

(2)“一对一方式”:

采用每对划分的方法,即ωi 、ωj两分法,此时一个判别面只能分开两种类别,不能把它与其余所有类别分开。因此有(K(K−1)/2)个判别函数(K类两两组合)

其判别函数为:

若d i j ( x ) > 0,对所有 j ≠ i 都成立,则 x∈ω_i类

如图所示, d_{12}=0 仅能分开ω_1和ω_2类,不能分开 ω_1 和 ω_3 类

图中不确定区域为: 若所有 d_{ij }(x) ,找不到任意∀ j ≠ i,d_{ij }(x)>0 的情况。(例如:在某一区域 d_{12}>0 但 d_{13}<0 这就不能判定该区域是否属于第一类。)

(3)“argmax方式”:

假若在“一对一方式”中的d_ij (x)可分解成:

则 d_{ij} (x)>0 相当于d i ( x ) > d j ( x ),即有K个类别则有K个判别函数,第i类就是 d_i (x)=(ω_i^T)·x,i=1,2,…,K

若 d_i (x)>d_j (x),对任意i ≠ j 都成立,则 x∈ω_i,也可写成:

di(x)=max(dk(x),k=1,2,…,K),则x∈ωi。(把样本x带入K个判别函数中,找出值最大的一个,他就属于那一类。)

如图所示,它不存在不确定区域。

3.2 Logistic回归

Logistic回归是一种常用的处理两类分类问题的线性模型。模型目标即分别预测:p(y=├ 1┤|x)和p ( y = 1 ∣ x ) 各子概率的问题,因为类别数为2所以 p(y=0∣x)+p(y=1∣x)=1,模型只要计算出其中一个的概率即可。

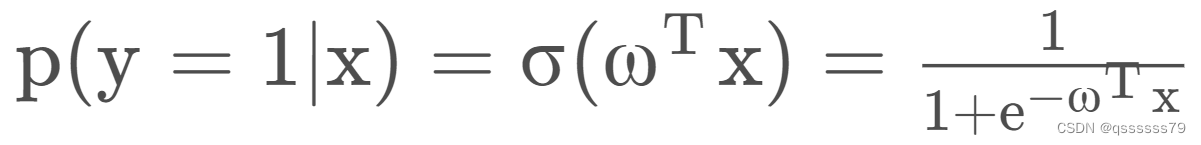

一般来说 p(y=1|x)=g(f(x;ω)) 其中g(·)通常称为激活函数,作用是把线性函数的值域从实数域压缩到了(0,1)区间。Logistic回归中一般用logistic函数,即:

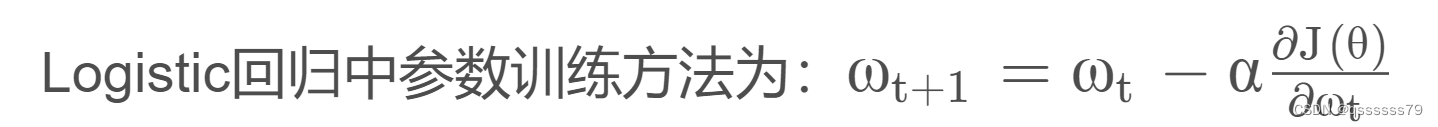

这里的x和ω分别为D+1维的增广特征向量和增广特征权重(x中增加了偏置1,权重中增加了b)。Logistic回归采用交叉熵作为损失函数,并使用梯度下降法对参数进行优化。其损失函数为:

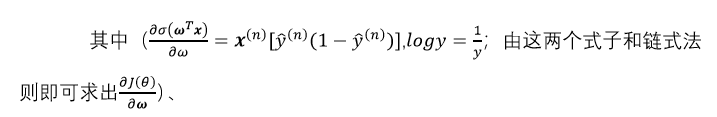

其中N为样本个数, y^{(n)} 为样本的真实值,{y}^{(n)} 为logistic函数输出值。根据求导法则可得:

3.3 Softmax回归

Softmax回归也称多项或多类的Logistic回归,是在多类分类问题上的推广。

3.4 感知器

感知器是最简单的人工神经网络,只有一个神经元,是一种简单的两类线性分类模型。

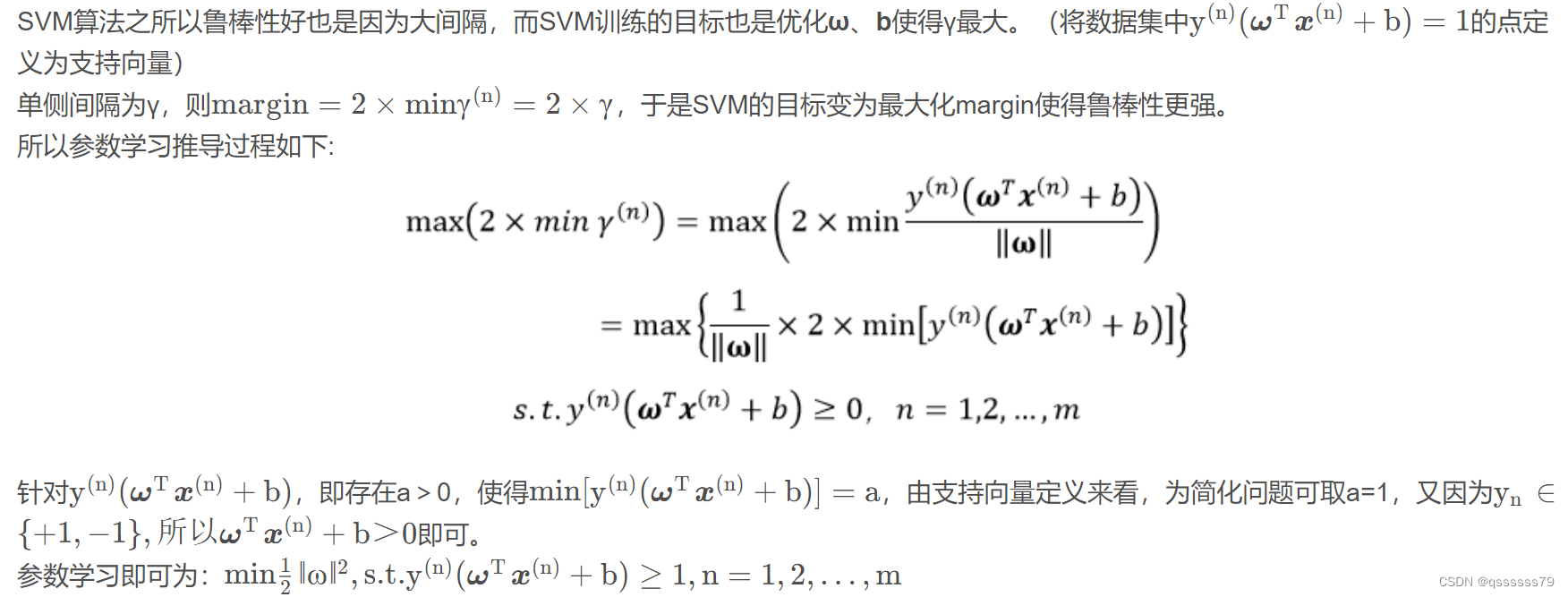

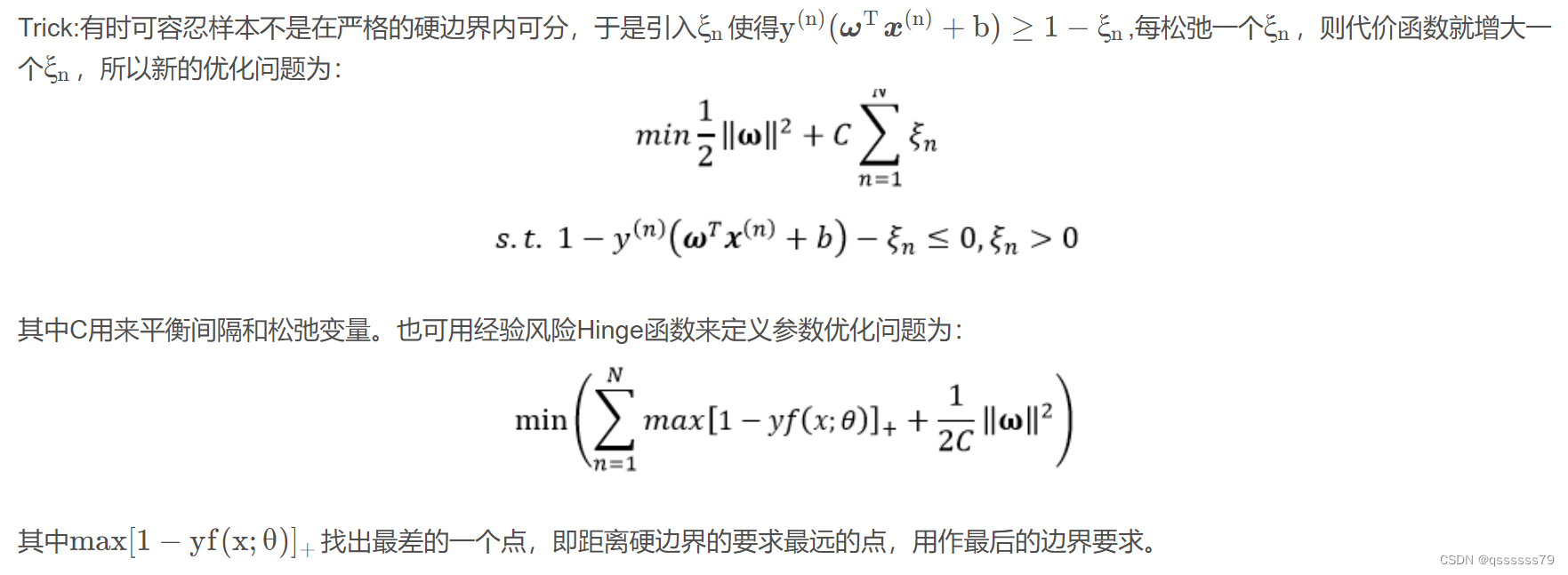

3.5 支持向量机

总结

694

694

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?