1. 简介

空间注意力(Spatial Attention)机制,特别是基于 Transformer 的注意力机制在最近取得了广泛的成功与应用,但是对该机制本身的理解和分析仍然匮乏。本论文对空间注意力机制进行了详尽的经验性分析,取得了更深入的理解与一些全新的观点,这些分析表明空间注意力机制的设计存在很大的改进空间。

2.

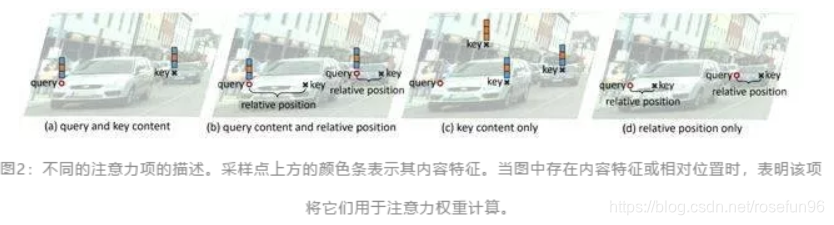

论文 Transformer-XL 中提出,注意力权重可以按使用的特征因子被拆解为四项:(E1)query 内容特征和 key 内容特征;(E2)query 内容特征和 query-key 相对位置;(E3)仅 key 的内容特征;(E4)仅 query-key 相对位置。

使用广义注意力形式来统一不同的注意力机制:

y q = ∑ m = 1 M W m [ ∑ k ∈ Ω q A m ( q , k , z q , x k ) ⊙ W m ′ x k ] y_{q}=\sum_{m=1}^{M} W_{m}\left[\sum_{k \in \Omega_{q}} A_{m}\left(q, k, z_{q}, x_{k}\right) \odot W_{m}^{\prime} x_{k}\right] yq=

空间注意力机制深入解析

空间注意力机制深入解析

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?