带有图像级标签的弱监督语义分割(WSSS)长期以来一直受到类激活图(CAM)导致的对象区域碎片化的困扰,无法生成用于语义分割的细粒度掩码。为了指导CAM找到更多的非歧视性对象模式,本文转向了智能体学习中一种有趣的工作机制,即互补学习系统(CLS)。CLS认为,新皮层建立了一般知识的感觉,而海马体专门学习特定的细节,完成了所学的模式。在这种简单而有效的学习模式的激励下,我们提出了一种通用特定学习机制(GSLM)来显式地将粗粒度CAM驱动为细粒度伪掩码。具体来说,GSLM开发了通用学习模块(General Learning Module, GLM)和特定学习模块(Specific Learning Module, SLM)。用图像级监督训练GLM,从CAM中提取粗糙和一般的定位表示。基于GLM中的一般知识,SLM逐步从定位表示中挖掘特定的空间知识,以显式的方式扩展CAM。为此,我们提出了种子再激活方法,通过设置激活值的边界来帮助SLM重新激活非区分区域,从而连续识别更多的CAM区域。无需额外的细化过程,我们的方法能够在PASCAL VOC 2012数据集上实现超过20.0% mIoU的CAM改进,在MS COCO 2014数据集上实现10.0% mIoU的CAM改进,代表了现有WSSS方法中最先进的新技术。

代码:https://github.com/tmlr-group/GSLM公开获取

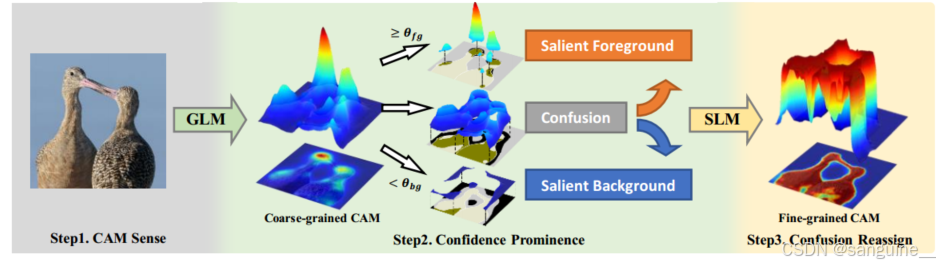

图一:我们的方法概述。通用学习模块(GLM)感知粗粒度CAM,通过θbg, θ fg的阈值将其分为三部分,相应的局部真值如下所示(棕色为前景,黑色为背景)。在标记CAM的指导下,特定学习模块(Specific Learning Module, SLM)支持混淆重新分配,以构建细粒度CAM

1.引言

互补学习系统(CLS) (McClelland et al ., 1995;Kumaran et al ., 2016)的假说认为,在人类的学习过程中,两种学习系统在新皮层和海马之间起着互补的作用。新皮层会遗漏一些细节,但通常会在目标知识中建立对模式的感知,而海马体则会反复巩固所学的模式并完成细节。

我们认为,CAM忽略的非歧视性区域的问题类似于新皮层中缺失的细节。如图1所示,CAM的置信度分布表明,CAM中大多数具有中性置信度的像素很难被分配为前景或背景。实际上,这些像素表示的混淆区域与真正的前景(图中的棕色像素)和真正的背景(黑色像素)混合在一起。由于突出的前景和背景是CAM已经学习到的,因此我们将混淆区域视为CAM缺失的细节。因此,我们提出了一种通用特异性学习机制(GSLM)来帮助CAM重新激活缺失的细节并重新分配这些混乱区域,类似于CLS中新皮层和海马的协同工作。在GSLM中,通用学习模块(GLM)学习图像级标签的模式并提供定位表示。特定学习模块(SLM)继承GLM并使用这些表征来调整网络权重,这些表征由提议的激活损失(Eq. 5)支持。这些表征被称为Confidence CAM,并由我们提议的粗生成(Eq. 3)从原始CAM中计算出来,它标记了具有边界约束的显着区域和混淆区域。为了实现混淆区域的重新分配,将Seed Reactivation (Eq. 4)集成到SLM中,使用有界函数抑制显著区域并激活非区分区域

4方法

4.1 GSLM总体框架

图三 GSLM框架。在一般学习中,使用图像级标签来训练GLM以生成Confidence CAM。在具体学习中,使用图像级标签和在前一个过程中生成的Confidence CAM来训练SLM。通过SLM的GLM多阶段改进cam,从而改进cam。

4.2通用学习模块(GLM)

一个Confidence CAM表示三个具有三个值的区域,其中突出前景设置为1,突出背景设置为0,其余混淆区域设置为-1作为要忽略的标志。如图3所示,一个示例Confidence CAM的可视化显示为SLM的输入

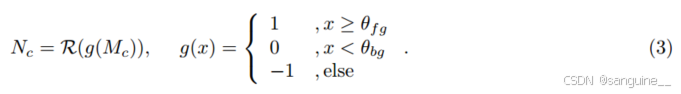

为了生成Confidence CAM,我们引入阈值θ fg和θbg,将CAM划分为显著前景(≥θ fg)、显著背景(< θbg)和混淆区。此外,采用条件随机场(conditional random fields, CRF) (Krähenbühl & Koltun, 2011),一种广泛使用的不可学习CAM细化方法,进一步细化显著区域,为这些知识表示引入边界约束信息。我们定义置信映射为g, CRF为R: R C×H×W→R C×H×W。对于第c类,可以由给定的CAM Mc生成置信CAM Nc,如下所示。

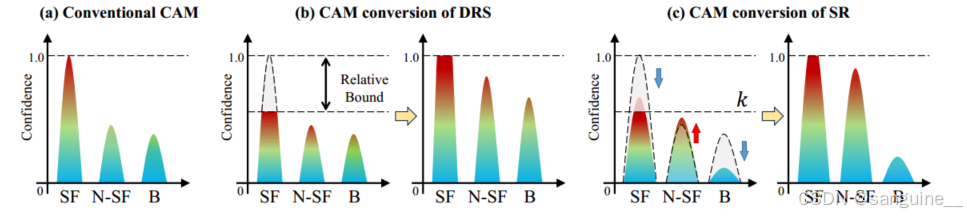

图四:提供了DRS(Discriminative Region Suppression,由Kim et al. 2021提出)和GSLM中的种子再激活(Seed Reactivation,SR)在CAM(Class Activation Map)精化原则上的比较。这里,SF代表突出前景(Salient Foreground),N-SF代表非突出前景(Non-Salient Foreground),B代表背景(Background)。

DRS(Kim et al., 2021):

- DRS的目标是通过抑制分类网络中的显著区域或特征,迫使CAM关注并识别其他潜在的对象区域。这种方法通过相对上界来抑制高置信度的像素,从而增加剩余像素的相对置信度。这可能导致背景区域被错误地分类为前景,导致过度激活(over-activation)。

GSLM中的种子再激活(SR):

- GSLM中的SR旨在解决传统CAM生成方法与基于置信度CAM的像素级监督不兼容的问题。SR通过引入一个有界的ReLU-k函数,为特征图中的区域设置一个常数上界k。这样,每个像素将独立地被激活(接近k)或抑制(接近0),与其他像素无关。这种方法避免了DRS中出现的过度激活问题,因为它不会因高置信度像素的截断而增加剩余像素的相对置信度。

4.3特定学习模块(SLM)

SLM的目的是重新调整基于特定学习的Confidence CAM生成网络的连接权值。具体而言,具体学习是指巩固已学习的突出区域的对象模式,并发现新的模式来补充CAM的注意。因此,我们引入激活损失,在Confidence CAM的指导下提供像素级监督。我们提出种子再激活来帮助网络激活更多的区域,而不受突出区域的挤压效应的影响。此外,保留了GLM的分类损失,巩固了学习到的模式。

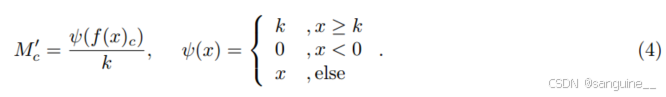

种子再激活一方面是为了解决传统CAM生成与基于置信度CAM的像素级监督不兼容的问题。具体来说,传统CAM是通过全局最大归一化(Eq. 2)生成的,其中所有像素都除以最大像素值。但也存在最大像素位于Confidence CAM的混淆区域,在训练时被忽略,导致模型收敛失败的情况:

- SLM可能使用与GLM不同的权重(甚至不同的网络结构),因此最大像素可能出现在CAM中的任何位置。

-

即使在训练开始时,SLM和GLM是相同的,并且最大像素是在Confidence CAM的显著前景区域绘制的。但是随着训练的进行,SLM会像预期的那样激活一些混淆区域作为前景,最大像素可能就在这里。

为了解决这个问题,我们引入了一个有界的ReLU-k函数ψ,使用常分母进行归一化,

另一方面,种子再激活(Eq. 4)取代了传统的CAM生成方法(Eq. 2),从而影响了生成的CAM。如图4 (a)(c)所示,Seed Reactivation为feature map中的区域设置了一个恒定的上限k。通过像素级训练,每个像素将独立于其他像素被激活(接近k)或被抑制(接近0)。类似地,DRS (Kim et al ., 2021)对网络特征映射应用相对上界,以高置信度抑制显著前景。

然而,截断高置信度像素会增加所有剩余像素的相对置信度,从而错误地激活背景区域,如图4 (b)所示。例如,0.5的边界会使所有区域的相对置信度增加2倍。高置信度的背景会被误分类为前景,导致过度激活。通过引入额外的监督显著性图作为背景掩模,DRS避免了过度激活的问题,但通过种子再激活,GSLM可以在没有显著性图的情况下实现这种效果。

激活损失(Activation Loss)缩小了由特定学习模块(SLM)产生的改进后的类激活图(CAM)M'与由通用学习模块(GLM)或前一阶段的特定学习模块(SLM)产生的置信度CAM(Confidence CAM)N之间的差距。具体来说,我们忽略了置信度CAM中的非区分区域(即置信度CAM中值为-1的区域)。通过使用平滑L1范数来衡量这一差距,激活损失被定义为:

![]()

这里的 ∣∣⋅∣∣1表示平滑L1范数,Mi′Mi′ 是SLM产生的改进后的CAM的第i个像素值,NiNi 是置信度CAM的第i个像素值,而 RH×W 表示图像的空间维度。简而言之,激活损失通过比较改进后的CAM和置信度CAM之间的差异,来指导模型学习如何更好地激活前景区域并抑制背景区域。

总损失

实验

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?