NVIDIA AI Workbench 是一款免费的、用

目录

户友好型开发环境管理器,可在您选择的系统(PC、工作站、数据中心或云)上简化数据科学、ML 和 AI 项目。在 Windows、macOS 和 Ubuntu 上,您可以本地开发、测试项目和构建项目原型,并在系统(本地和远程)之间轻松传输开发环境和计算工作,以优化成本、可用性和规模。

AI Workbench 专注于简化开发者体验,而不会阻碍高级用户所需的自定义类型。那是 AI Workbench 处理容器的主要原因。它们是提供和修改 GPU 加速工作所需环境的最简单方法。

这一重点还意味着与生态系统合作伙伴合作,以改善用户体验。例如,与 Canonical 的协作有助于使用 Ubuntu WSL 发行版在 Windows 上安装 AI Workbench。

最近,NVIDIA 与 Docker Desktop 团队合作创建了一项功能,允许 AI Workbench 直接安装 Docker Desktop。这项功能在最新的 AI Workbench 版本中提供,可显著简化 Windows 和 macOS 上的体验。

这种简化使AI Workbench成为在您自己的系统上入门的最简单方式,从笔记本电脑和工作站一直到服务器和VM。

托管式 Docker 桌面安装

Docker Desktop 是 NVIDIA AI Workbench 上适用于 Windows 和 macOS 的推荐容器运行时。然而,在选择 Docker 之前需要手动设置步骤。为了消除这些手动步骤,NVIDIA 与 Docker 合作,为本地系统安装了支持 NVIDIA AI Workbench 的 Docker Desktop。

这是 Docker 首次支持另一个应用程序为 Docker Desktop 执行托管安装。得益于此次合作,安装适用于 NVIDIA AI Workbench 的 Docker Desktop 现在变得非常简单。有关更多信息,请参阅使用 Docker Desktop 和 NVIDIA AI Workbench 优化 AI 应用程序开发(Docker 网站)。

选择 AI Workbench 的 Docker 容器运行时,系统将自动完成以下任务:

- 安装 Docker Desktop:以前,如果尚未安装 AI Workbench 安装程序,您必须退出 AI Workbench 安装程序并手动安装 Docker Desktop。现在,您可以让 AI Workbench 安装 Docker Desktop,而无需退出 AI Workbench 安装程序。

- 在 Windows 上配置 Docker Desktop:AI Workbench 使用其自己的 WSL 发行版,NVIDIA-Workbench。以前,Windows 用户必须手动配置 Docker Desktop 才能使用此发行版,现在,这将自动实现。

新的 AI 工作台项目

在此版本中包含一组新的示例项目,为您使用和构建。AI Workbench 项目是一个结构化的 Git 存储库,在 AI Workbench 中定义了容器化的开发环境。

这些项目支持 Jupyter 和 Visual Studio Code 等 IDE 以及用户配置的 Web 应用程序。所有内容都是容器化的、隔离的和易于修改的。你可以从 GitHub 或 GitLab 克隆项目,然后 AI Workbench 会处理所有内容,包括连接到 GPUs。

迄今为止,这方面的最佳示例是 GitHub 上的 Hybrid-RAG 项目。借助 AI Workbench,您只需克隆项目并单击几下,即可运行 RAG 应用程序。如果您没有本地 GPU,该项目允许您使用云端点或自托管 NIM 容器为您运行推理。

此版本在 GitHub 上提供了一些示例 AI 工作台项目,这些项目将继续开发 RAG 主题。此外,还有一些基于 Jupyter 的新微调项目和支持 NVIDIA RTX AI 工具包的 LlamaFactory 项目。

智能 RAG

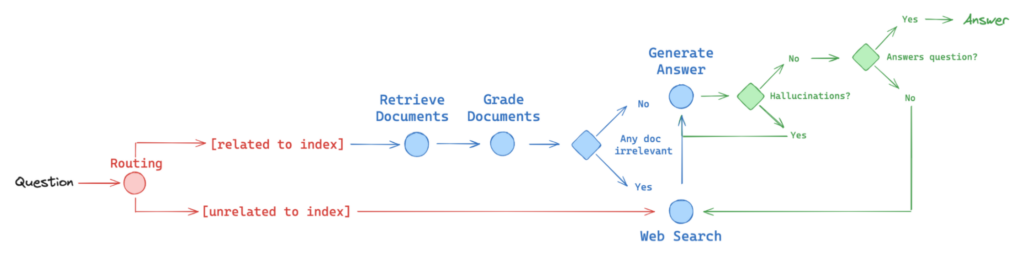

借助 Agentic RAG AI Workbench 项目,您可以与 AI 智能体合作,将 Web 搜索工具调用纳入 RAG 工作流。智能体不仅可以处理数据库中的文档,还可以在线动态搜索新文档作为后备,以更好地响应查询。

Figure 1. Structure of the agentic RAG example project.

LLM 代理是专为感知环境并作出反应而设计的系统,通常通过工具调用来更好地采取相关行动。这项项目实现了基于 LangGraph 的 RAG 代理,其中包含以下代理元素,以改进响应生成:

- 路由:根据查询主题将相关问题路由到不同的工作流程。

- Fallback:如果检索到的文档与查询无关,则返回 Web 搜索。

- 自我反射:修复无法解决问题的幻觉和答案。

图 2. 具有可自定义 Gradio 聊天 UI 的 Agentic RAG 示例项目。

此项目包含可定制的 Gradio 聊天应用,使您能够使用远程运行的端点和微服务运行推理,无论是在云端使用 NVIDIA API 目录、使用 NVIDIA NIM 的自托管端点,还是第三方自托管微服务。您可以通过聊天应用轻松切换推理模式。

随时随地进行 NIM

NIM Anywhere 是一个一体化项目,用于构建包含预配置 RAG 聊天机器人的基于 NIM 的 RAG 应用程序。

图 3.NIM Anywhere 示例项目

- Docker 自动化:将 NIM、Milvus 和 Redis 等服务作为持久容器与主项目一起运行。

- 用户可配置模型:在使用 NVIDIA API 目录上的 NIM 微服务或本地运行的自托管 NIM 微服务之间切换 RAG 的运行方式。

- 可自定义前端:将视图添加到前端Gradio应用程序,以扩展项目并构建新的用例。

NIM 微服务作为 NVIDIA AI Enterprise 的一部分提供,但您也可以加入 NVIDIA 开发者计划,免费开始使用 NVIDIA NIM。

微调项目

最后,我们介绍了一些针对令人兴奋的新模型的微调工作流程。每个项目都具有可以量化的模型,以适应单个GPU:

- Mixtral 8x7B: AI Workbench 的第一个示例项目,演示了专家混合模型 (Mixture of Experts, MoE) 的微调。

- Llama 3 8B:一个示例项目,展示两种方法:监督式完全微调(Supervised Full Fine-tuning,SFT)和直接偏好优化(Direct Preference Optimization,DPO)。

- Phi-3 Mini:一个小巧的模型,具备量化能力,是一个高度易于访问的微调示例。

- RTX AI 工具包:为 Windows 应用程序开发者提供端到端工作流。您可以使用热门的基础模型,使用 Workbench 项目使用微调技术对其进行自定义,并将模型部署到 Windows 应用程序中,以在各种 NVIDIA GPU(从 NVIDIA RTX PC 和工作站到云)上获得峰值性能。您可以通过使用 AI Workbench 和 LlamaFactory 图形用户界面开始使用。

其他新功能

我们的开发流程包括用户提出的直接功能请求。以下功能基于这些用户反馈:

- SSH 代理

- Ubuntu 24.04

- 日志记录

SSH 代理

Ai Workbench 的一些企业用户需要使用受密码保护的 SSH 密钥来访问遥控器。这通过在 2024.07 版本中添加 SSH 代理支持来解决这一问题。你还可以选择使用早期的 SSH 密钥功能。

Ubuntu 24.04

以前,Ubuntu 22.04 是唯一支持安装 AI Workbench 的 Linux 发行版。2024.07 版本增加了 Ubuntu 24.04 的支持。

日志记录

AI Workbench 具有多个日志文件,这些文件的查找和解释十分复杂。为了解决此问题,AI Workbench CLI 现在提供了一个支持命令,让您可以将元数据和日志导出到 zip 文件中。这消除了查找文件的需求,并包含可发送至 NVIDIA 支持部门以加快诊断和补救速度的元数据。

即将推出

以下是 AI Workbench 的发展方向:应用分享和多容器支持。

应用共享

目前,只有运行 Workbench 项目的用户才能访问该 Workbench 项目中正在运行的应用程序。一些用户已请求能够共享正在运行的应用程序。

在下一个版本中,AI Workbench 用户将能够通过链接在 Workbench 项目中安全地共享 Web 应用程序。经过身份验证的用户可以直接在 Web 浏览器中访问应用程序,而无需使用 AI Workbench。

多容器支持

当前使用 NIM Anywhere 项目的多容器方法有点变通。即将发布的 AI Workbench 版本将简化对多容器应用程序的支持。

125

125

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?