数据挖掘算法之支持向量机(SVM)(二)

在第一篇中我们讲解了线性可分下的硬间隔分类器,但那只是SVM算法的起点。现实中许多问题并不是线性可分的,如果样本不能被完全分开,那么就是:间隔为负,原问题的可行域为空,对偶问题的目标函数无限,这将导致相应的最优化问题无解。

今天我们就讲下针对近似线性可分情况下的软间隔优化。

软间隔分类器简介

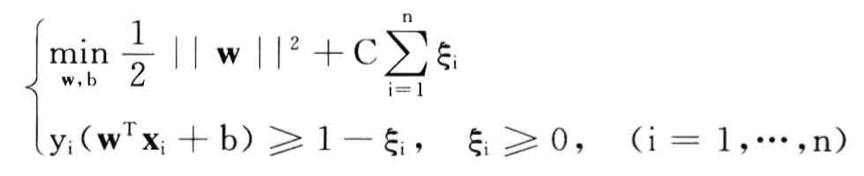

在软间隔分类器中,允许存在少量的“噪音数据”,这些样本点被认为是训练错误。具体地说,就是引入松弛变量 ξ i ξ_i ξi来量化分类器的违规行为:

其中参数C用来平衡机器的复杂度和不可分数据点的数量,是一个用户设定的“正则化”参数。

松弛变量的一个直接几何解释是:一个错分实例到超平面的距离。这个距离度量的是错分实例相对于理想的可分模式的偏差程度。

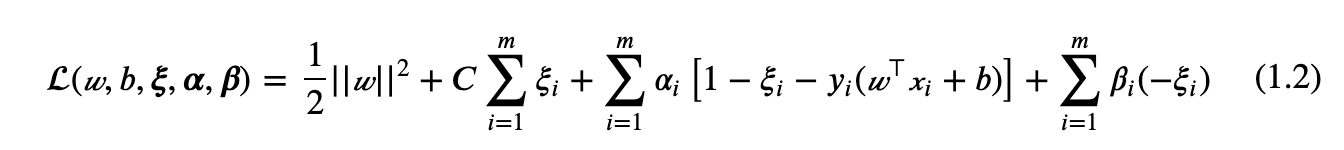

该优化问题的解法和前篇类似,这是一个包含两个不等式约束的极值问题,直接套用拉格朗日乘子法,为两个不等式约束引入两个拉格朗日乘子 ɑ i , ( ɑ i ⩾ 0 ) ɑ_i,(ɑ_i ⩾0) ɑi,(ɑi⩾0)、 β i ( β i ⩾ 0 ) β_i(β_i⩾0) βi(βi⩾0) :

其对偶问题为:

简单说就是将min、max互换。但是值得注意的是,第一个问题,也就是原问题是关于w、b、和ξ的函数,对偶问题是关于ɑ、β的函数。

现在带约束的最优化问题就转化成了无约束的优化问题(其实仍然有约束,但是是对拉格朗日乘子的约束,对变量已经没有约束了,所以我们称之为无约束)。求解这样的拉格朗日函数,就是对w、b和ξ求偏导数:

将求得的结果带入拉格朗日函数,得:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1184

1184

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?