环境

- CUDA 11.3

- CUDNN 8.1

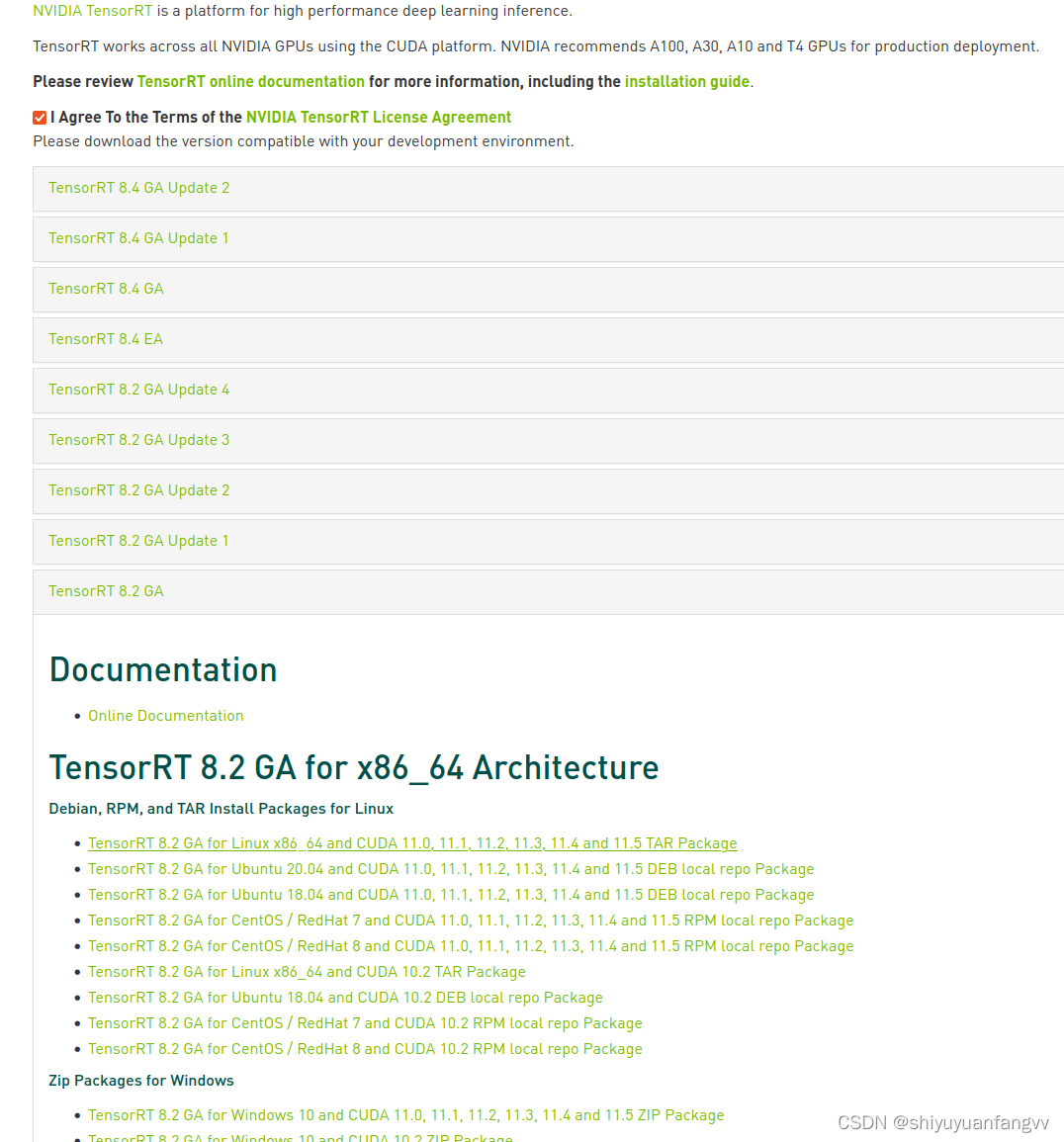

下载安装tensorRT (匹配相应的版本)

官网地址 :https://developer.nvidia.com/nvidia-tensorrt-8x-download

选择合适的版本下载,本人下载如图所示:

安装

解压

tar zxf TensorRT-8.2.1.8.Linux.x86_64-gnu.cuda-11.4.cudnn8.2.tar.gz

添加环境

将下面的环境变量 添加到.bashrc文件并保存

gedit ~/.bashrc

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/zvv/Downloads/software/TensorRT-8.2.1.8/lib

source ~/.bashrc

复制tensorRT目录下 lib、include文件夹到系统文件夹(或者将这两个文件夹路径添加到.bashrc文件中)

sudo cp -r /home/zvv/Downloads/software/TensorRT-8.2.1.8/lib/* /usr/lib

sudo cp -r /home/zvv/Downloads/software/TensorRT-8.2.1.8/include/* /usr/include

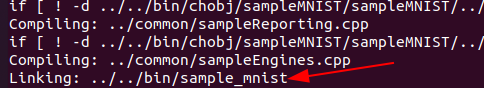

C++测试是否成功

测试代码:TensorRT-8.0.1.6/samples/sampleMNIST

在tensorRT目录下samples文件夹下 用sampleMNIST示例测试

编译

make clean && make

编译成功,执行bin目录下的可执行文件

执行

./../../bin/sample_mnist

安装Python 环境的TensorRT

在tensorRT目录下 python文件夹下 安装相应的whl文件(前提时你有python环境),如下图:

pip install pycuda

pip install tensorrt-8.2.1.8-cp38-none-linux_x86_64.whl

下载安装torchtrt

1.2 安装 torch2trt

#安装依赖

sudo apt-get install libprotobuf* protobuf-compiler ninja-build

## 适用于 TRT7

git clone https://github.com/NVIDIA-AI-IOT/torch2trt

## 适用于 TRT8,如果安装了TensorRT8.x版本就用这个

git clone -b support_trt_8 https://gitee.com/jeremyjj/torch2trt-trt8.git

cd torch2trt

(不要用这个)sudo python setup.py install --plugins

(一直报错:ModuleNotFoundError: No module named 'torch)

最后:

(用这个)python setup.py install 成功

如果遇到:Illegal instruction的问题

1.'''修改环境变量'''

sudo gedit /etc/profile

把 export OPENBLAS_CORETYPE=ARMV8 加入最后面一行,然后保存

'''更新环境变量'''

source /etc/profile

参考:NVIDIA Jetson xavier上面安装完llvmlite后,import torch时报错,Illegal instruction (core dumped)-CSDN博客

2. 由于环境变量和路径权限可能因用户不同而有所不同,这可能是导致问题的原因之一

去掉 sudo

619

619

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?