引言

随着ChatGPT的爆发性增长,大型语言模型(Large Language Model, LLM)已成为人工智能领域最耀眼的明珠。从代码生成到文学创作,从数据分析到情感交互,LLM正在重塑人机协作的边界。本文将深度解析LLM的技术内核、应用场景、核心挑战及未来趋势,帮助开发者与技术决策者建立系统性认知。

一、技术架构解析:LLM的底层密码

1.1 Transformer革命

- 自注意力机制:通过Query-Key-Value计算实现长程依赖捕捉,突破RNN的序列限制

- 并行计算优势:相比传统循环网络,Transformer可并行处理序列数据,训练速度提升百倍

- 架构演进:从原始Transformer到GPT/BERT的编码器-解码器分离,再到LLaMA的多阶段预训练

1.2 预训练范式转移

| 预训练策略 | 代表模型 | 核心创新 |

|---|---|---|

| 自监督学习 | BERT | Masked Language Model |

| 自回归学习 | GPT系列 | 单向语言建模 |

| 指令微调 | Flan-T5 | 零样本任务泛化 |

| 强化学习 | ChatGPT | 人类反馈强化学习(RLHF) |

1.3 关键技术创新

- 上下文窗口扩展:Flash Attention优化长文本处理(如GPT-4的32K token支持)

- 混合专家系统:Google PaLM 2的MoE架构实现参数高效利用

- LoRA低秩适配:参数高效微调技术,降低大模型落地成本

二、应用场景爆发:从文本到生产力工具

2.1 开发者工具链

- 代码生成:GitHub Copilot日均生成代码量超40亿行

- 自动测试:Amazon CodeWhisperer生成单元测试案例

- 文档工程:Notion AI自动生成技术文档

2.2 企业级应用

- 智能客服:Jasper实现多轮对话上下文保持

- 市场分析:BloombergGPT解析金融文本生成投资洞察

- HR自动化:八爪鱼AI完成候选人简历初筛

2.3 科研加速

- 数学猜想:AlphaTensor发现新型矩阵乘法算法

- 蛋白质设计:RFdiffusion结合LLM生成新型酶结构

- 文献综述:ScholarAI自动生成领域发展报告

三、核心挑战与应对

3.1 伦理与安全

- 幻觉问题:通过事实性数据增强(如WebGPT的检索增强)

- 偏见控制:对抗性训练与多源数据平衡

- 隐私保护:差分隐私技术与数据脱敏处理

3.2 工程化难题

- 推理能力瓶颈:Chain-of-Thought技术提升复杂推理

- 计算资源消耗:模型量化(如INT4精度)与稀疏化训练

- 实时性要求:边缘部署框架(如TensorRT优化)

四、未来发展趋势

4.1 多模态融合

- 视觉语言模型:GPT-4V理解图像生成描述

- 具身智能:LLM与机器人控制结合(如具身GPT)

- 三维场景理解:Neural Scene Graph技术演进

4.2 认知科学启发

- 神经符号系统:结合符号主义推理与神经网络

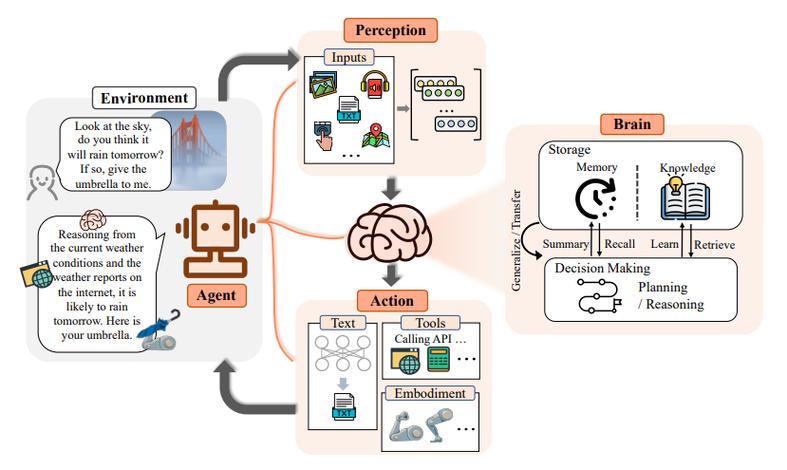

- 世界模型构建:LLM作为智能体的认知地图

- 元学习能力:自主改进模型架构与训练策略

4.3 产业生态重构

- MaaS模式:模型即服务(Model-as-a-Service)

- 开源生态:Llama 2、Falcon等模型的社区驱动演化

- 监管框架:欧盟AI法案对LLM的合规要求

结语

大型语言模型正在经历从"文本生成工具"到"通用智能基础设施"的质变。对于开发者而言,掌握LLM的prompt工程、模型微调、多模态融合等技术已成为必备技能;对于企业,构建基于LLM的AI中台将成为数字化转型的关键。在这个技术范式转移的时代,持续关注架构创新、伦理边界与产业应用,方能在AI浪潮中占据先机。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?