背景:

不久前认知计算课上留了一个作业:用Spark完成一个机器学习的程序。我也因此第一次接触Spark和机器学习,记录下关于Spark环境配置和安装的一些细节,顺便记录下这个过程中一个小白所遭遇的种种小困难。

- 在安装Spark之前需要先安装Hadoop

详见:MAC下Hadoop安装与使用

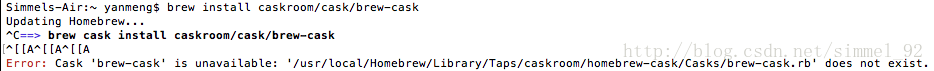

这里边第一步我就遇到了报错,无法成功安装homebrew cask。我的报错是这样的:

后来找到了方法,将命令改为如下即可安装成功:

brew install brew-cask-completion

这一步修改参考的博文是MAC下安装homebrew cask报错及对策

注* 在安装过程中遇到报错:

/usr/local/spark/bin/spark-class: line 71: /usr/libexec/java_home/bin/java: Not a directory

后来发现是我所看的那篇安装Java JDK的博文中所设置的JAVA_HOME环境变量与我实际的安装路径不匹配,后来按照Mac OS 下配置Java环境中介绍的也许是正确的配置方法在/etc/profile中重新配置了一下。

3436

3436

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?