mechanize介绍

mechanize是对urllib2的部分功能的替换,能够更好的模拟浏览器行为,在Web访问控制方面做得更全面。

它对protocol, cookie, redirection都做了比较好的支持,再结合beautifulsoup和re模块,

可以非常有效的解析web页面。

常用函数

.CookieJar():设置cookie

.Browser():打开浏览器

.addheaders():User-Agent,用来欺骗服务器的

.open():打开网页,按照官网描述可以打开任意网页,不仅限于http

.select_form():选择表单的,选择表单的ID的时候需要注意。

.form[]:填写信息

.submit():提交

1.初始化并建立一个浏览器对象

如果没有mechanize需要easy_install安装,以下代码建立浏览器对象并作了一些初始化设置,实际使用过程可以按需开关。

其实只用默认的设置也可以完成基本任务。

import mechanize

br = mechanize.Browser() # 创建一个浏览器实例

br.set_handle_equiv(True) # 设置是否处理HTML http-equiv标头

br.set_handle_redirect(True) # 设置是否处理重定向

br.set_handle_referer(True) # 设置是否向每个请求添加referer头

br.set_handle_robots(False) # 设置是否遵守robots中的规则

br.set_handle_gzip(True) # 设置是否处理giz传输编码

br.addheaders = [...] # 设置浏览器的头部信息

br.set_handle_refresh(mechanize._http.HTTPRefreshProcessor(), max_time=1)

#debugging?

br.set_debug_http(True)

br.set_debug_redirects(True)

br.set_debug_responses(True)

2.模拟浏览器行为

浏览器对象建立并初始化完毕之后即可使用了,下面给出几个例子(代码承接以上部分)

获取web网页

分行打印可以逐个查看详细信息,就不赘述

- r = br.open(sys.argv[1])

- html = r.read()

- print html

- print br.response().read()

- print br.title()

- print r.info()

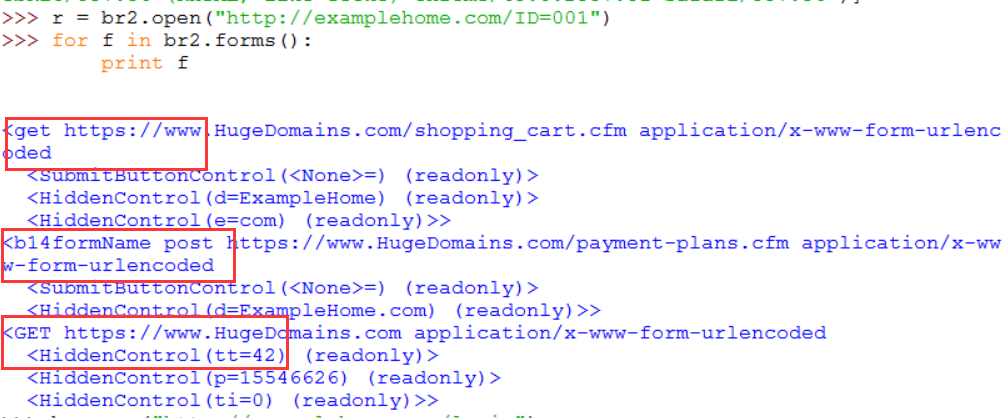

模拟谷歌和百度查询

打印和选择forms,然后填写相应键值,通过post提交完成操作

- for f in br.forms():

- print f

- br.select_form(nr=0)

- br.form['q'] = 'football'

- br.submit()

- print br.response().read()

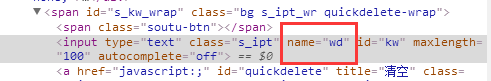

百度查询football

- br.form['wd'] = 'football'

- br.submit()

- print br.response().read()

相应键值名,可以通过打印查出

回退(Back)---浏览器历史

非常简单的操作,打印url即可验证是否回退

- # Back

- br.back()

- print br.geturl()

3.http基本认证

- br.add_password('http://xxx.com', 'username', 'password')

- br.open('http://xxx.com')

4.form认证

以登陆人人网为例,打印forms可以查出用户名和密码键信息

- br.select_form(nr = 0)

- br['email'] = username

- br['password'] = password

- resp = self.br.submit()

5.cookie支持

通过导入cookielib模块,并设置浏览器cookie,可以在需要认证的网络行为之后不用重复认证登陆。通过保存session cookie即可重新访问,Cookie Jar完成了该功能。

- #!/usr/bin/env python

- import mechanize, cookielib

- br = mechanize.Browser()

- cj = cookielib.LWPCookieJar()

- br.set_cookiejar()

6.proxy设置

设置http代理

- #Proxy

- br.set_proxies({"http":"proxy.com:8888"})

- br.add_proxy_password("username", "password")

- #Proxy and usrer/password

- br.set_proxies({"http":"username:password@proxy.com:8888"})

7.下载

# Download

f = br.retrieve('http://www.google.com.br/intl/pt-BR_br/images/logo.gif')[0]

print f

fh = open(f)

8.简单的打开网页

import urllib2

print urllib2.urlopen('http://stockrt.github.com').read()

# With password?

import urllib

opener = urllib.FancyURLopener()

print opener.open('http://user:password@stockrt.github.com').read()

http://blog.csdn.net/zhaodedong/article/details/46432921

http://www.jb51.net/article/65518.htm

637

637

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?