一个新模型横空出世,值得注意!

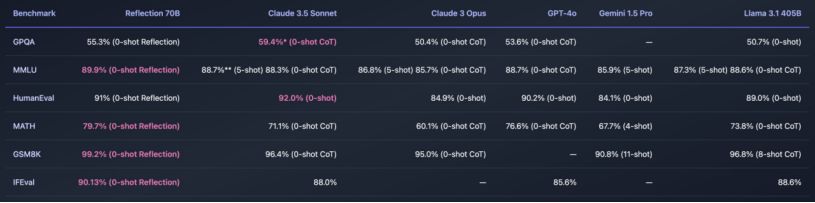

世界顶级开源模型 Reflection 70B,在诸多指标上打败了 Claude 3.5/GPT4o.特别是推理能力超强.重模型使用 Reflection-Tuning 进行训练,使 LLM 能够修复自己的错误。这个模型的技术有可能和GPT5相似。

而 405B 版本将于下周上市——它有望成为世界上最好的型号。

一、背景

1.1 开源大语言模型的发展历程

开源大语言模型的兴起始于几年前,随着计算能力的提升和数据集的丰富,多个知名的模型相继问世,如 OpenAI 的 GPT 系列、Google 的 BERT 和 T5,以及 Meta 的 LLaMA 系列。这些模型不仅在自然语言处理的各个领域取得了显著的成果,也为研究人员和开发者提供了强大的工具。

在此背景下,HyperWrite 决定推出 Reflection 70B,旨在为用户提供一个更高效、更灵活的开源解决方案,以满足日益增长的需求。

1.2 Reflection 70B 的开发目标

Reflection 70B 的开发目标是创建一个能够在多种语言任务中表现出色的模型,特别是在推理、对话生成和文本理解等方面。HyperWrite 希望通过引入创新的技术和方法,提升模型的准确性和可靠性,同时保持开源的特性,鼓励社区的参与和贡献。

二、技术特点

2.1 模型架构

Reflection 70B 基于 Meta 的 Llama 3.1 70B Instruct 构建,采用了最新的 Transformer 架构。这种架构在处理长文本和复杂语义时表现优异,使得模型能够更好地理解上下文关系。

2.2 训练数据

Reflection 70B 在训练过程中使用了海量的多样化数据集,包括书籍、文章、对话记录和网页内容。这种多样性使得模型能够掌握丰富的语言知识和背景信息,从而在生成文本时更加自然流畅。

2.3 性能表现

在多个基准测试中,Reflection 70B 的表现令人瞩目。具体来说:

- MMLU(Massive Multitask Language Understanding):Reflection 70B 在 MMLU 测试中的得分高达 90.5%,显示出其强大的语言理解能力。

- GSM8K:在数学推理任务 GSM8K 中,Reflection 70B 的得分为 99.2%,超越了许多同类模型,展现了其在逻辑推理方面的优势。

- MATH:在 MATH 测试中,模型的表现同样出色,能够解决复杂的数学问题。

- IFEval:在 IFEval 测试中,Reflection 70B 的表现也相当优异,证明了其在信息提取和理解方面的能力。

2.4 Reflection-Tuning 技术

Reflection 70B 的一大亮点是其独特的“Reflection-Tuning”技术。这一技术通过在生成回答前自动检测和纠正推理中的错误,显著提高了模型的准确性。具体而言,Reflection-Tuning 过程包括以下几个步骤:

- 错误检测:模型在生成回答时,会使用特定的 token 来标记可能的错误。

- 自我纠正:在识别到错误后,模型会自动调整生成的内容,以确保最终输出的准确性。

- 用户反馈:用户可以通过简单的指令引导模型进行反思和调整,从而实现更高效的交互。

这种技术不仅提升了模型的表现,也为用户提供了更为直观和灵活的使用体验。

三、应用场景

3.1 教育领域

Reflection 70B 在教育领域的应用潜力巨大。它可以用于:

- 个性化学习:根据学生的学习进度和需求,生成定制化的学习材料和练习题。

- 智能辅导:提供实时的答疑服务,帮助学生解决学习中的难题。

3.2 内容创作

在内容创作方面,Reflection 70B 可以为作家、博主和营销人员提供支持。具体应用包括:

- 文本生成:根据给定主题生成高质量的文章、博客和社交媒体内容。

- 创意写作:帮助作家激发灵感,提供情节、角色和对话的建议。

3.3 客户服务

Reflection 70B 也可以在客户服务领域发挥重要作用。其应用包括:

- 智能客服:通过自然语言处理技术,提供快速、准确的客户支持。

- 情感分析:分析客户反馈,帮助企业改进产品和服务。

3.4 研究与开发

在研究与开发领域,Reflection 70B 可以辅助研究人员进行数据分析、文献综述和实验设计。

四、优势与挑战

4.1 优势

- 开源特性:Reflection 70B 的开源特性使得用户可以自由使用、修改和分发模型,促进了社区的参与和创新。

- 高性能:在多个基准测试中的优异表现证明了模型的强大能力,适用于各种复杂的语言任务。

- 灵活性:通过 Reflection-Tuning 技术,用户可以根据需求灵活调整模型的输出,提高了交互的效率和准确性。

4.2 挑战

- 计算资源需求:尽管 Reflection 70B 在性能上表现出色,但其训练和推理过程对计算资源的需求较高,可能限制了某些用户的使用。

- 数据偏见:与许多大语言模型一样,Reflection 70B 可能会受到训练数据中潜在偏见的影响,这需要在使用过程中加以注意和修正。

- 安全性与伦理问题:在生成内容时,模型可能会产生不当或有害的输出,因此在实际应用中需要建立有效的监控和审核机制。

五、未来发展趋势

5.1 技术创新

随着技术的不断进步,未来的开源大语言模型将会更加智能和高效。Reflection 70B 可能会在以下几个方面进行技术创新:

- 多模态学习:结合文本、图像和音频等多种数据形式,提升模型的理解和生成能力。

- 自适应学习:根据用户的反馈和需求,模型能够自我调整和优化,提供更个性化的服务。

5.2 社区参与

开源社区的参与将是 Reflection 70B 未来发展的重要推动力。通过鼓励用户贡献数据、模型和算法,HyperWrite 可以不断改进和优化模型,提升其在实际应用中的表现。

5.3 应用扩展

Reflection 70B 的应用场景将不断扩展,未来可能会在医疗、法律、金融等更多领域发挥重要作用。通过与行业专家的合作,模型可以针对特定领域进行定制化训练,提升其专业性和准确性。

结论

Reflection 70B 的发布标志着开源大语言模型领域的又一重要进展。凭借其卓越的性能、创新的技术和广泛的应用潜力,Reflection 70B 不仅为开发者和研究人员提供了强大的工具,也为各行各业的用户带来了新的机遇。尽管面临一些挑战,但通过技术创新和社区合作,Reflection 70B 有望在未来继续引领开源大语言模型的发展潮流。

1057

1057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?