摘要

本文研究场景图中人-物交互问题。其核心思想是人或物体实例的外观包含指示线索,利用这些信息可以注意到图像中可以促进交互预测的部分。为了利用这些线索,研究者提出了一个以实例为中心的注意力模块,学习根据每个实例的外观动态突出显示图像中的区域。这种基于注意力的网络允许研究者选择性地聚合与识别 HOI相关的特征。

一、引言

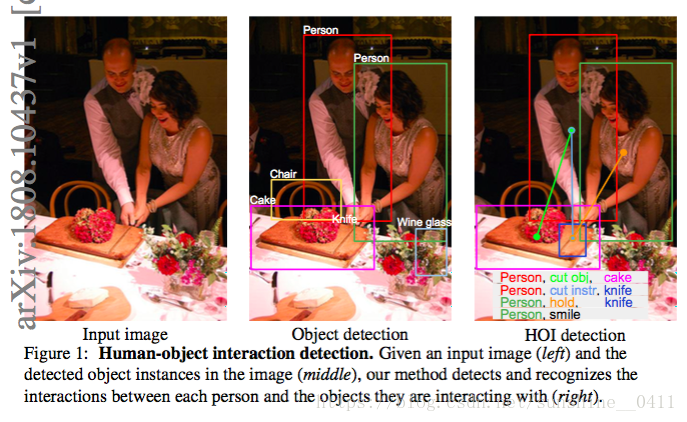

HOI:人-物交互检测,旨在定位人、物体并识别人与物体之间的交互。图 1 中展示了 HOI 检测问题的一个例子。给定输入图像和物体检测器检测到的实例,研究者的目标是识别出所有的“人-动词-物体”三元关系组。检测和识别 HOI 是朝着更深入理解场景迈出的重要一步。而不是“哪里有什么?”(即,在图像中定位物体实例),HOI 检测的目标是回答“发生了什么?”的问题。研究 HOI 检测问题也为其他相关的高级视觉任务提供了重要线索,例如姿态估计 [2,40],图像标注 [24,39] 和图像检索 [21]。

Why attention? 加入人体姿势可能有助于识别“骑行”和“投掷”等行为,加入交互点可能有助于识别涉及手 - 物体交互行为,例如“用杯子喝水”和“用勺子吃饭”,加入背景可能有助于区分“用网球拍击中”和“用棒球棍击中”。

本文提出了一种以实例为中心的端到端可训练注意力模块,学习使用人或物体实例的外观来突出信息区域。实例(人或物体)的外观暗示了我们应该注意图像中的哪些位置。例如,为了更好地确定一个人是否拿有物体,应该将注意力集中在人手周围。另一方面,对于图像中的自行车,知道附近人的姿势有助于消除关于物体实例(例如,骑或推自行车)的潜在交互的歧义。本文提出的以实例为中心的注意力网络(iCAN)动态地为每个检测到的人或物体实例生成注意力映射,突出显示与该任务相关的区域。

贡献:

- 引入了一个以实例为中心的注意力模块,它允许网络动态突出信息区域以改进 HOI 检测。

- 在两个大型 HOI 基准数据集上取得了新的当前最佳性能。

- 进行了详细的对比实验和误差分析,以确定各个组成部分的相对贡献,并量化不同类型的错误。

- 发布了源代码和预训练模型,以促进将来的研究。

二、相关工作

对象检测:是场景理解的基础。本文使用现有的 faster R-CNN来定位人和物体实例。

视觉关系检测:。。。

Attention:。。。

Human-object interactions :。。。

三、以实例为中心的注意力网络(Instance-Centric Attention Network)

模型概述。研究者提出的模型包括以下三个主要流:(1)基于人类外观检测交互的人流; (2)基于物体外观预测交互的物体流;(3)用于编码人类和物体边界框之间的空间布局的配对流。基于现有的 Faster R-CNN 检测到的对象实例,使用所有的人 - 物体对生成 HOI 假设。然后融合来自各个流的动作分数以产生最终预测。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1297

1297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?