摘要:近十年来,基于脑电图(EEG)的情绪识别(ER)在脑机接口(BCI)中的应用越来越受欢迎。情绪识别系统包括预处理和特征提取,然后是分类。深度学习最近被用于BCI系统中的情绪分类,与经典分类方法相比,结果有所改善。本研究的主要目的是利用不同的递归神经网络架构从脑电图信号中对情绪进行分类。在这项工作中使用了三种架构来使用EEG信号识别情绪:RNN(循环神经网络),LSTM(长短期记忆网络)和GRU(门控循环单元)。实验数据证实了这些网络在性能度量方面的效率。使用EEG脑电波数据集:感受情绪进行实验,RNN的平均准确率为95%,LSTM的平均准确率为97%,GRU的平均准确率为96%。

关键词:脑机接口;深度学习;RNN;LSTM;GRU

1. 介绍

人机交互的一个重要分支是脑机接口(brain-computer interface, BCI)[1]。在脑机接口系统中,残疾人可以通过心理活动来操作设备。在脑机接口技术中,获取来自大脑的脑电图记录,并分析信号以推断受试者的目的。近十年来,基于脑电图的情感识别技术在脑机接口(BCI)中的应用越来越受欢迎。脑机接口的工作原理是获取受试者大脑的脑电图信号,并利用它们提取受试者意图的知识。每天,情绪都会影响我们互动、决策和思考的方式。认知脑机接口(BCI)是通过情绪分类发展和完善的。许多领域,如电子医疗、基于脑电图的音乐播放、电子学习、基于脑电图的音乐治疗[2]和营销等,都可以通过基于脑电图的情绪识别实时增强。各种疾病,如中风、脑肿瘤和睡眠障碍可以通过监测脑电图活动来诊断或治疗。从心理学的角度来看,情绪状态可以用离散(喜悦、恐惧、愤怒、快乐、悲伤、惊讶)或维度(效价和唤醒)模型来建模。

脑电信号可以使用机器学习(ML)算法和深度学习(DL)算法进行分析。传统的机器学习算法通常包括预处理和特征提取,然后是分类。尽管如此,人工提取并不能覆盖所有的隐藏特征,提取时频域特征的公式往往极其复杂[3]。此外,脑电图信号可能受到肌电图伪影的污染,对传统的机器学习技术造成严重干扰。基于所有这些问题,我们的主要目的是建立一个低复杂度情感识别系统,具有低错误率和高分类率。由于上述情况,采用某些深度学习方法来克服这些问题。机器学习允许系统根据以前的经验自动学习和改进。深度学习是一种机器学习,涉及使用复杂的算法和深度神经网络来训练模型。深度学习的重要性在于它可以处理结构化和非结构化数据,而机器学习只能处理有组织和半结构化数据。随着数据量的增加,机器学习算法的性能下降;因此,我们需要一种深度学习的方法来保持模型的性能。

深度学习在许多行业都有广泛的应用。尽管自动驾驶汽车是一项冒险的尝试,但它最近离成为现实又近了一步。基于深度学习的模型在模拟情况下进行训练和测试,以评估从识别停车标志到识别道路上的行人的一切进展。一个非常熟悉的深度学习应用是虚拟助手。在我们的日常生活中,我们都在使用虚拟助手,比如Alexa,微软的Cortana,苹果的Siri,谷歌的Assistant[4]。深度学习在制药和医疗公司中非常有价值,原因有很多,包括快速诊断和图像分割[5]。例如,MRI数据、x射线和其他图像可以使用传统的神经网络(CNN)进行分析。深度学习在几乎所有行业都已崭露头角。它被应用于各种行业,包括电子商务、广告、聊天机器人、机器人、视觉识别、自然语言处理、欺诈检测和制造业等[6]。本文对卷积神经网络和递归神经网络在情绪识别中的性能进行了实现和分析。选择深度学习技术的动机是自动特征提取的优势,这是传统ML技术无法做到的。在这项研究中,我们探讨了提高卷积和递归神经网络性能的可能性,重点是情绪识别。

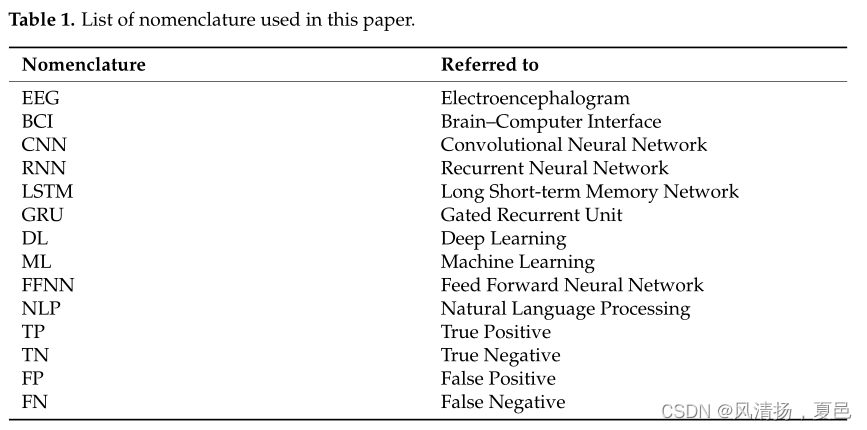

下面的表1列出了本文中使用的术语表。

本文进一步细分为几节。第2节解释了方法和数据库;第3节解释了递归神经网络的架构;第4节和第5节解释了长短期记忆网络和门控递归神经网络的结构;第6节描述了在这项工作中使用的基于脑电图的情感识别模型:RNN, LSTM和GRU;第7节讨论了实验结果;第8节为比较分析;第九部分是结论。

2. 方法

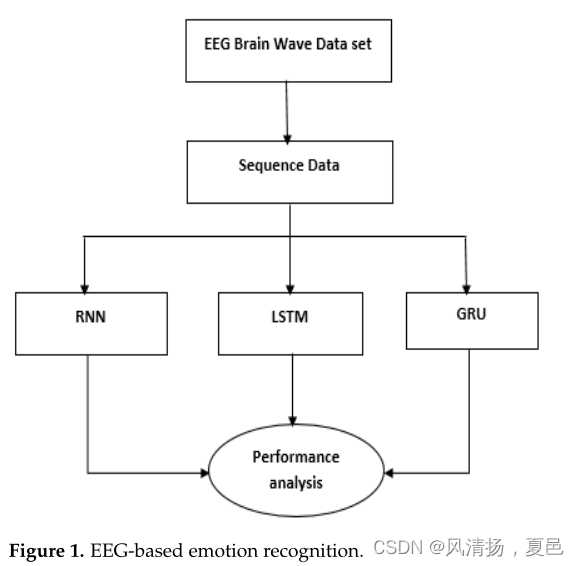

完整的情绪识别过程包括数据预处理,自动特征提取,最后使用深度学习模型进行分类。图1描述了本研究的总体结构

数据库(脑电波数据集:感觉情绪)

从两名成员,一男一女,在阳性、中性和阴性三种状态下收集数据3分钟。干电极使用Muse EEG头戴设备记录TP9、AF7、AF8和TP10 EEG位置。同时记录6分钟静息数据。该数据集通过统计提取重新采样,因为波必须以时间方式在数学上定义[7]。数据库的网页链接如下

https://www.kaggle.com/datasets/birdy654/eeg-brainwave-dataset-feeling-emotions(2022年5月1日访问)。(2022年5月1日访问)。

3.循环神经网络(RNN)

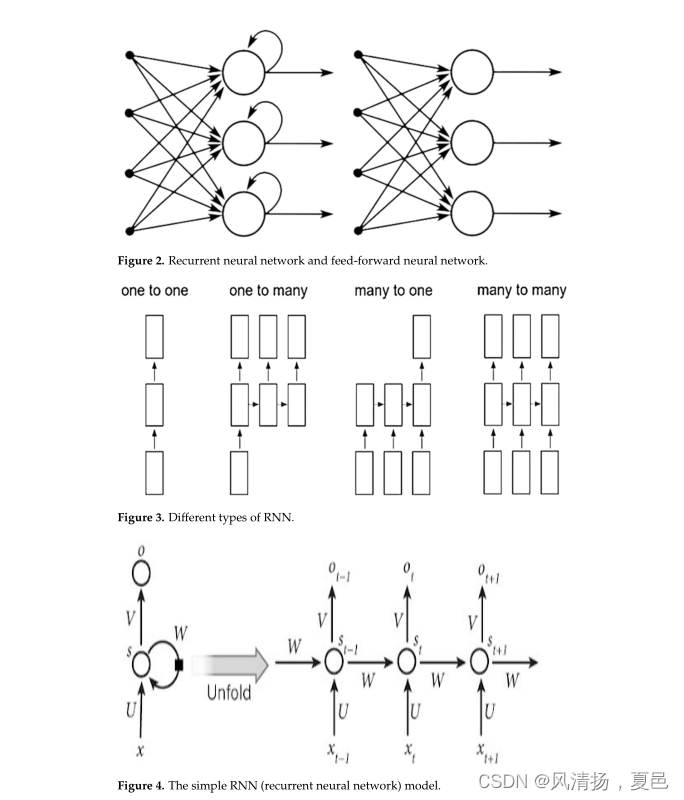

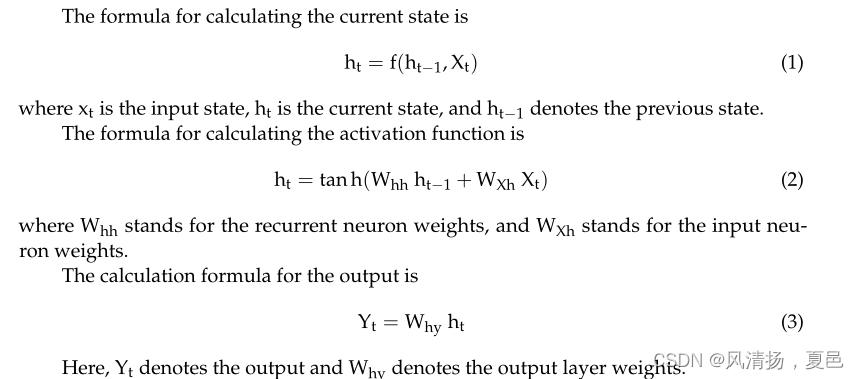

当前的神经网络(RNN)前馈神经网络(FFNN)有一些缺陷,导致了RNN的发展:不能处理序列数据,只考虑当前输入,而不记住先前的输入。RNN是解决这些困难的方法。RNN可以通过考虑当前和过去的输入来处理序列数据。由于内部存储器,rnn可以记住过去的输入。图2描述了RNN和FFNN之间信息流的变化。

RNN的一些应用有图像字幕[8]、时间序列预测[9]、机器翻译[10]和自然语言处理[11,12]等。rnn分为四类:一对一、多对一、一对多和多对多[13]。图3显示了RNN的类别,图4解释了简单的RNN。

一对一:这种类型的神经网络用于解决只有一个输入和输出的一般机器学习问题。

多对一:这个RNN基于输入序列生成一个单一的输出。这种类型的网络用于情感分析,其中给定的句子可以根据其情感内容分类为积极或消极。

一对多:这种类型的神经网络有一个输入和几个输出。图片说明就是一个很好的例子。

多对多:使用这个RNN,一系列输入产生一系列输出。机器翻译过程就是一个例子。

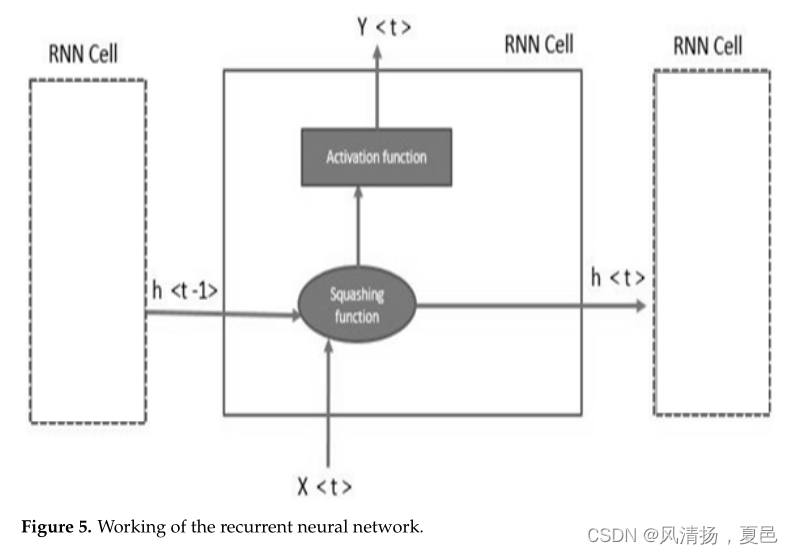

在上图中,x为输入状态,s为隐藏状态,O为输出状态[14,15]。网络的权重为U、V和w。RNN单元的内部架构如图5所示。

递归神经网络在反向传播过程中存在梯度消失和梯度爆炸的问题。梯度消失的一个例子是,当梯度太小时,模型就会停止学习,或者需要很长时间来学习。当方法在没有明显原因的情况下为权重分配一个高得离谱的值时,就会发生梯度爆炸。一个带有门控循环单元和长短期记忆网络的rnn稍加修改的版本可以解决这个问题。下一节将解释LSTM网络和GRU网络的体系结构和工作功能。

4. 长短时记忆网络(LSTM)

长短期记忆网络,也被称为LSTM,是一种先进的RNN,可以长时间存储信息。它可以处理rnn遇到的梯度消失问题。根据数据,网络可能会,也可能不会保留记忆。

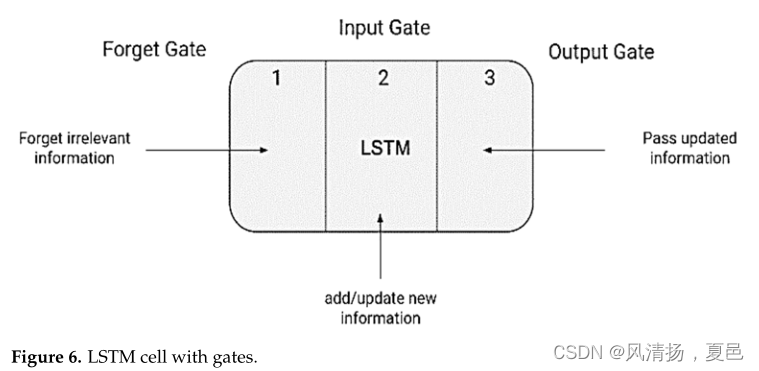

通过其门控机制,网络维持其长期依赖关系。在网络中,基于门控机制,内存可以按需释放或存储。门是LSTM细胞的三个基本组成部分[16,17]。遗忘门是第一部分,输入门是第二部分,输出门是第三部分,如图6所示。

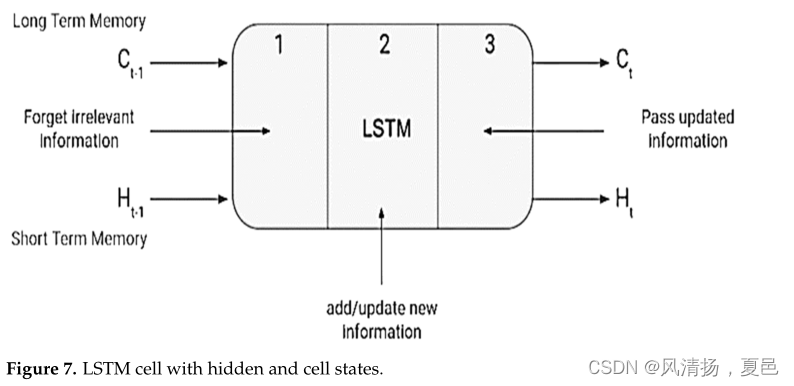

LSTM就像一个简单的RNN,包含一个隐藏状态,Ht−1表示上一个时间戳的隐藏状态,Ht表示当前时间戳的隐藏状态。lstm还包含一个单元状态,分别用Ct−1和Ct表示过去和当前的时间戳[18,19],如图7所示。

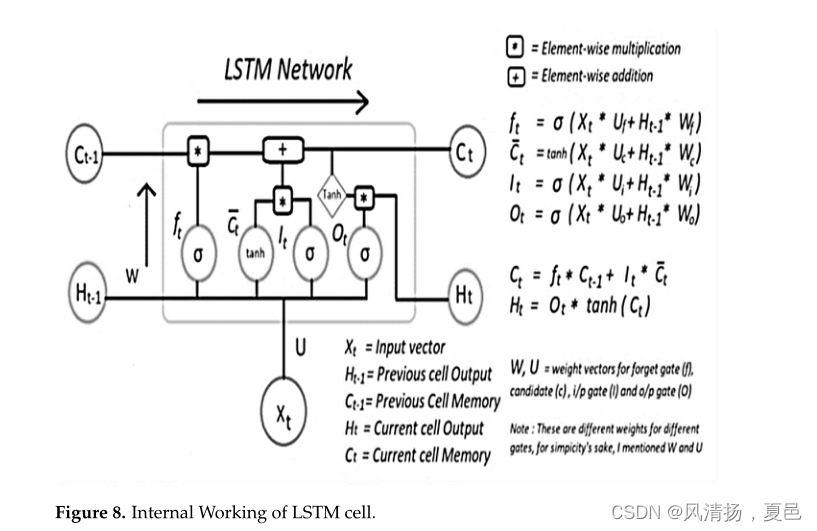

这里,隐藏状态指的是短期记忆,而细胞状态指的是长期记忆。图8显示了LSTM工作原理的概述。

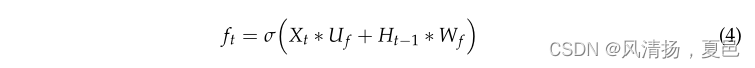

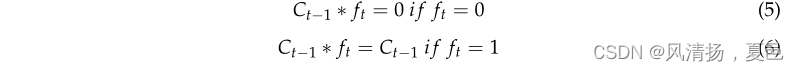

遗忘门:遗忘门是第一扇门。如果你关闭它,以前的记忆将不会被保存。如果你完全打开这扇门,所有的旧记忆都会穿过。它实际上是一个元素对元素的乘法。遗忘门方程如下:

如果将旧内存与接近0的向量相乘,则尝试擦除大部分旧内存。如果您想让旧内存通过,请将忘记门设置为1。

其中Xt和Ht−1是当前时间戳的输入和前一个时间戳的隐藏状态。U f和Wf是与输入和隐藏状态相关联的权重。

输入门:输入门是第二个门。第二个门决定了应该允许多少新输入。通过调整这个门,新记忆和旧记忆会受到不同的影响。输入门用于测量输入端携带的新数据的重要性。输入门的方程如下:

![]() 其中,Ui和Wi是与当前输入和之前隐藏状态相关联的权重。

其中,Ui和Wi是与当前输入和之前隐藏状态相关联的权重。

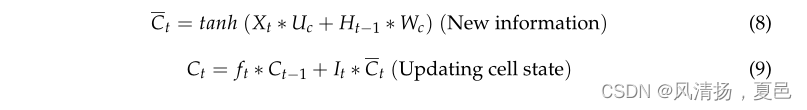

单元状态:下一个是+操作符。分段求和就是这个运算符的含义。这个动作将混合当前的输入和旧的记忆。为了形成St.,使用旧记忆和当前输入的逐个求和。

输出门:必须生成该LSTM单元的输出。在这个阶段,新的存储器、先前的输出和当前的输入都控制着输出门。这个门调节应该发送到下一个LSTM单元的新内存的数量。

![]()

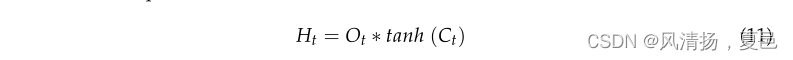

由于是sigmoid函数,它的值也将在0到1之间。现在,我们将利用修改后的细胞状态Ot和tanh来确定当前的隐藏状态,如下面的等式所示。

隐藏状态是长期记忆(Ct)和电流输出的函数。如果您需要获得当前时间戳的输出,请将SoftMax激活应用于隐藏状态Ht。

5. 门控循环网络(GRU)

gru是RNN架构的变体,它利用门控机制来控制神经网络细胞之间的信息流。lstm和gru在相同的概念上运行。与LSTM相比,它们是相当新的。这就是为什么gru优于lstm并拥有更直接的架构的原因。lstm由两种非常不同的状态组成,即单元状态和隐藏状态,它们提供长期和短期存储[20]。

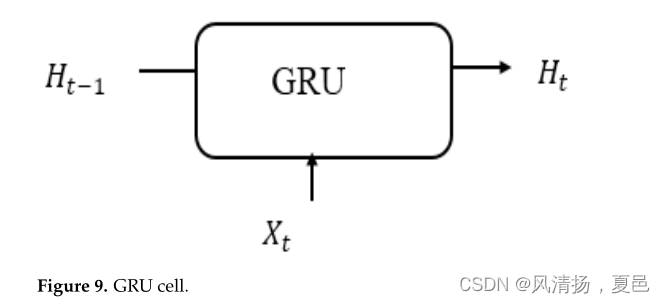

在gru中,只有一个隐藏状态从一个时间步长转移到另一个时间步长。由于隐藏状态和输入数据经历的门控机制和计算,它可以同时保持长期和短期依赖关系。GRU的一些应用包括语音识别、股票价格预测、机器翻译和情感分析等。图9显示了GRU单元的结构。在每个时间戳t处,它接受输入Xt和前一个时间戳t−1的隐藏状态Ht−1。稍后,它输出一个新的隐藏状态Ht,它再次传递给下一个时间戳。

GRU架构

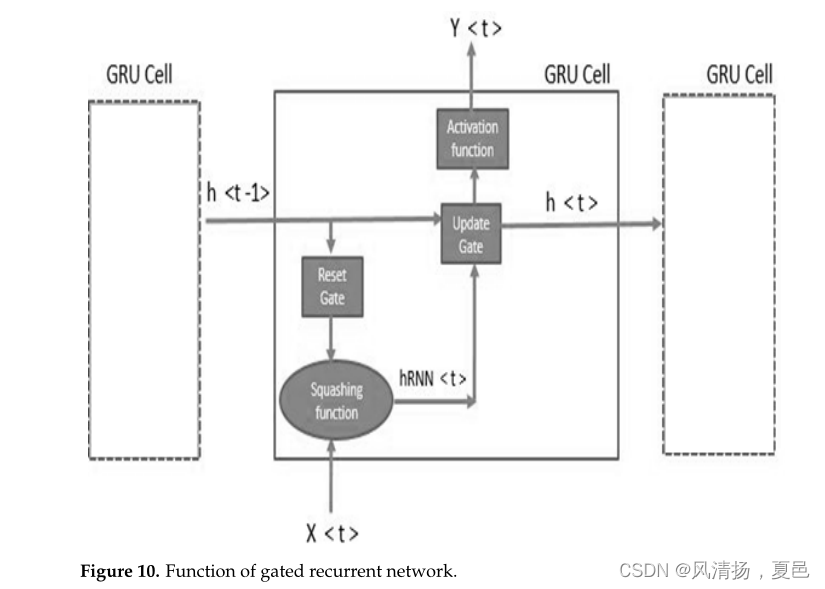

门控循环单元,简称GRU,具有与RNN相同的工作流程,但门控操作不同。GRU通过集成两个门来解决标准RNN的问题:更新门和复位门,对此进行了解释[21]。图10解释了GRU单元的内部架构。

更新门:更新门的功能类似于LSTM的输入和遗忘门。它确定应该丢弃或包含的信息。下面是管理长期记忆的更新门的方程式。

更新门的权值矩阵为Uu和Wu。

此外,使用sigmoid函数对该值进行压缩,以保持0到1的范围。这样,更新门就缓解了梯度消失的问题。

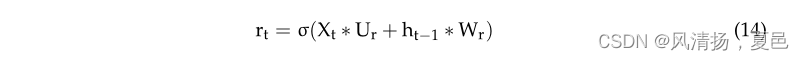

复位门:使用复位门,我们可以决定多少过去的数据必须被忽略;简单地说,它决定前一个单元格状态是否相关。下面是管理短期记忆的重置门的方程式。

复位门的权值矩阵为Ur和Wr。

sigmoid函数对0到1范围内的值进行变换,更接近于0的值被忽略,更接近于1的值被进一步处理。

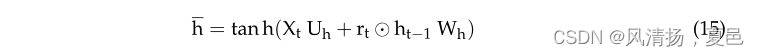

候选隐藏状态:作为第一步,计算复位门和前一个时间戳的隐藏状态之间的Hadmard积。然后将其输入tanh函数以确定候选对象的隐藏状态。候选隐藏状态的公式如下所示。

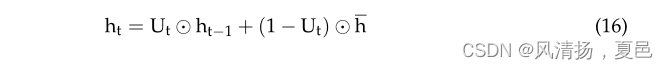

当前隐藏状态:计算更新门和前一个时间戳的隐藏状态向量之间的Hadmard积。从1中减去更新门以创建新向量,然后计算新向量与候选隐藏状态的Hadmard积。最后,将两个向量相加以生成当前隐藏的状态向量。

其中ht表示当前隐藏状态。

6. 本研究中使用的架构

在这项基于脑电图的情感识别研究中,使用了三种架构:RNN(循环神经网络)、LSTM(长短期记忆网络)和GRU(门控循环单元)。实验使用EEG脑电波数据集:感觉情绪进行。

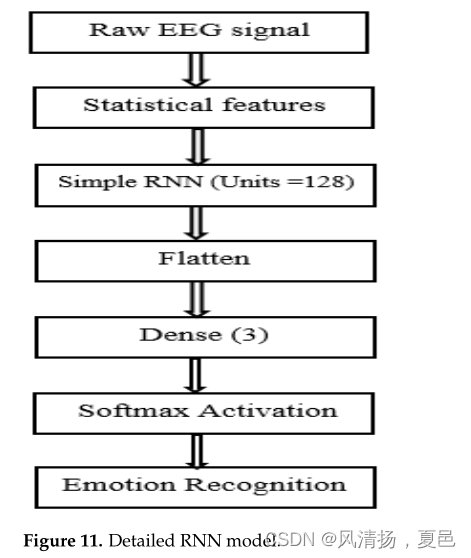

6.1. RNN架构

在这项工作中使用的RNN算法包括一个具有128个单元的RNN层,一个平坦层,最后是一个具有softmax激活的密集层。

使用RNN层确定学习特征,并使用密集层将其从原始EEG信号中分类为情绪。本研究采用简单RNN。它是Keras中真实RNN的简化版本。损失函数是稀疏分类交叉熵,使用的优化器是Adam优化器。图11显示了这项工作中用于基于脑电图的情感识别的RNN模型。

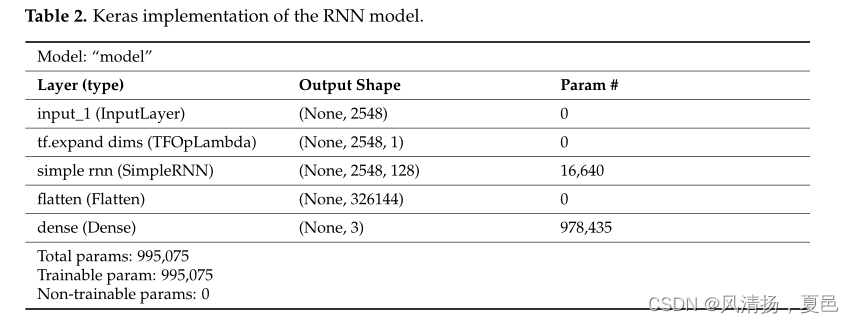

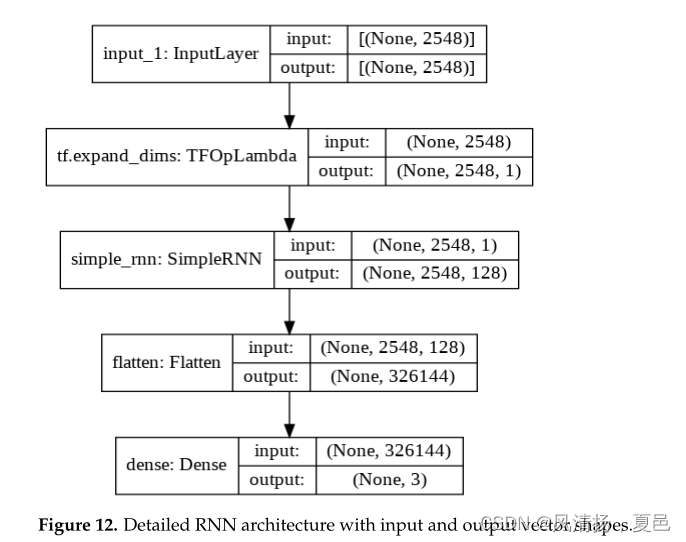

表2显示了RNN架构的Keras实现,以及带有输入和输出矢量形状的RNN模型的详细说明,如图12所示。

6.2. LSTM架构

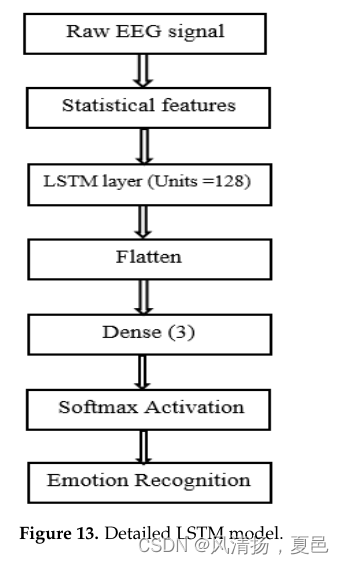

本文使用的LSTM算法由一个128个单元的LSTM层、一个平坦层和一个具有softmax激活的密集层组成。

使用LSTM层确定学习特征,并使用密集层将其从原始EEG信号中分类为情绪。图13显示了基于脑电图的情感识别的LSTM模型。从Keras API层中导入LSTM层和密集层。这里,我们使用具有128个内部单元的LSTM层,并且返回序列保持为真。对于每个输入时间步,返回序列生成隐藏状态输出。损失函数为稀疏分类交叉熵,使用的优化器为Adam优化器。

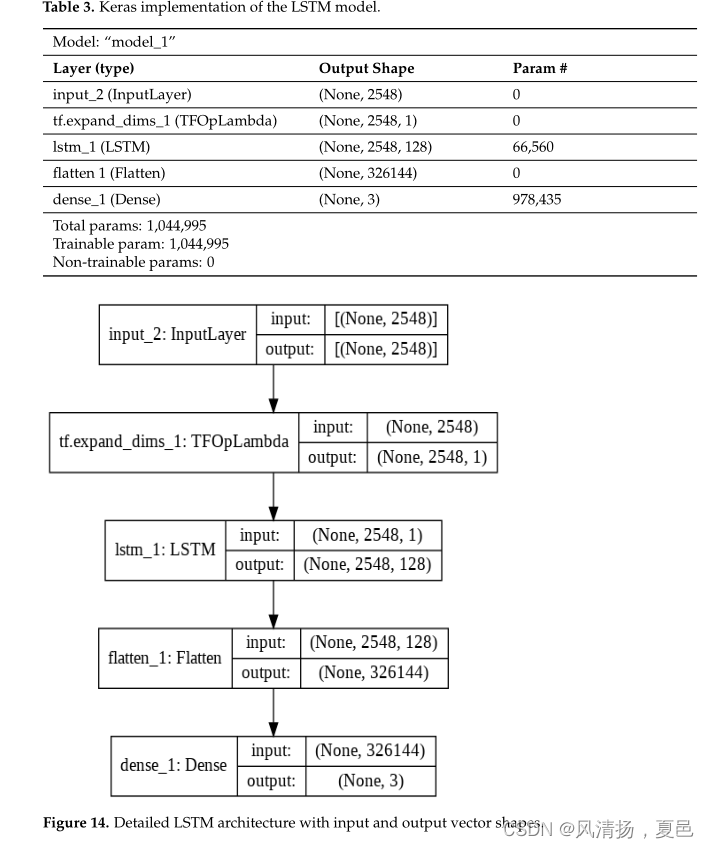

表3显示了LSTM体系结构的Keras实现,以及使用输入和输出矢量形状的LSTM模型的详细说明,如图14所示。

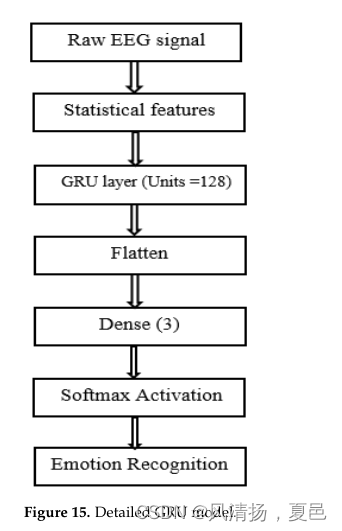

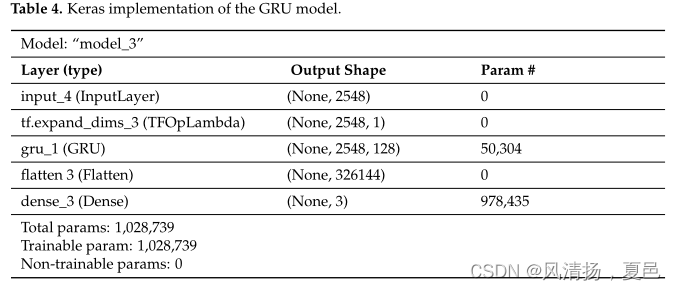

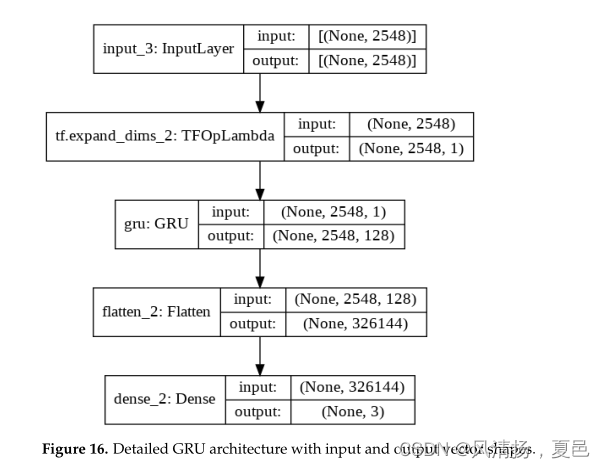

6.3GRU架构

本研究使用的GRU算法由一个128个单元的GRU层、一个平坦层和一个具有softmax激活的致密层组成。使用GRU层确定学习特征,并使用密集层将其从原始EEG信号中分类为情绪。图15显示了本研究中用于基于脑电图的情绪识别的GRU模型。

表4显示了GRU体系结构的Keras实现,以及带有输入和输出矢量形状的GRU模型的详细说明,如图16所示。

在训练数据较少的情况下,gru比lstm表现得更好,特别是在应用于语言建模任务时。在网络需要额外输入的情况下,gru更容易修改,因此更简单,代码更少。gru的参数也比LSTM少,正如模型摘要所证明的那样。在128个内部单元中,LSTM模型的参数总数为1,044,995,GRU模型的参数总数为1,028,739。

7. 实验结果与讨论

本数据库共有三种情绪2132个样本:积极(708个样本)、消极(708个样本)和中性(716个样本)。每个状态的数据收集时间为3分钟。在这个数据集中,1492个样本用于训练目的,640个样本用于测试目的。所有的实现都使用了带有Tensor flow后端的Keras库。

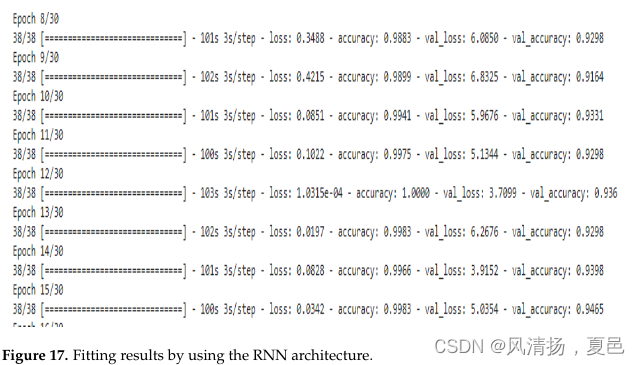

7.1. RNN架构的结果

图17显示了使用RNN架构的数据拟合结果。

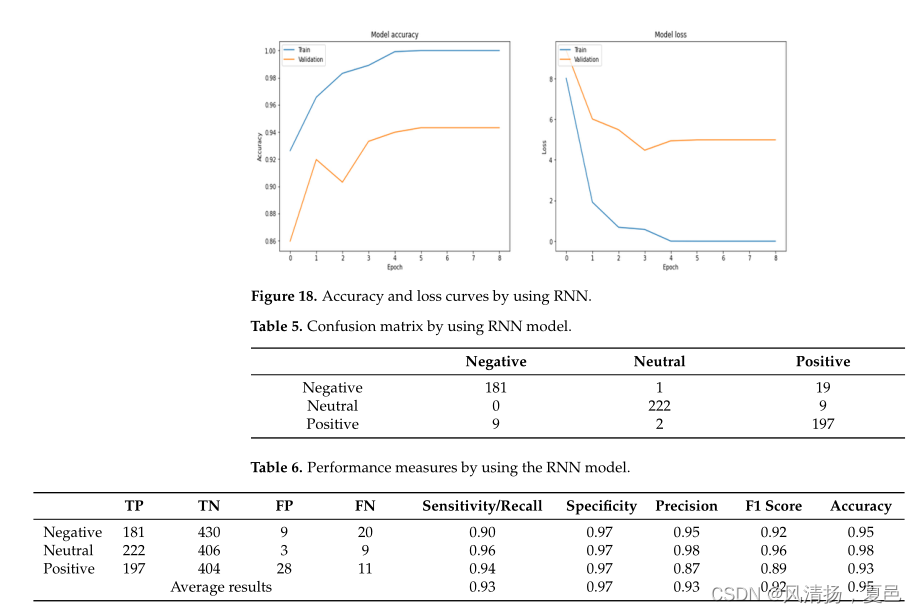

图18显示了RNN模型的精度和损失。当历元数改变时,损耗值和精度值也随之改变。表5显示了640个样本的测试数据的混淆矩阵,表6显示了使用混淆矩阵计算的模型的性能指标。

通过使用真阳性(TP)、假阳性(FP)、假阴性(FN)和真阴性(TN)值来计算模型准确性、特异性和敏感性的指标。

由以上计算可知,F1得分为0.92,使用RNN建立的模型准确率为95%。

7.2. LSTM架构的结果

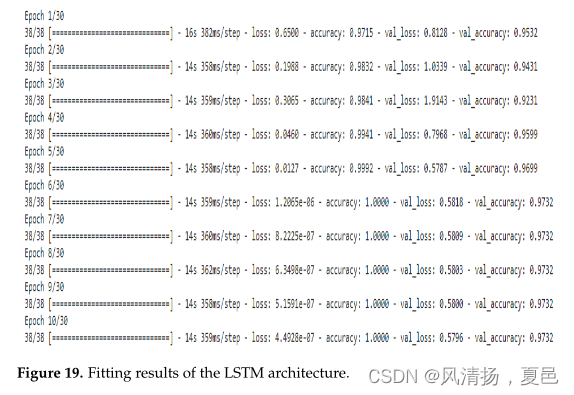

图19显示了LSTM体系结构的数据拟合结果。

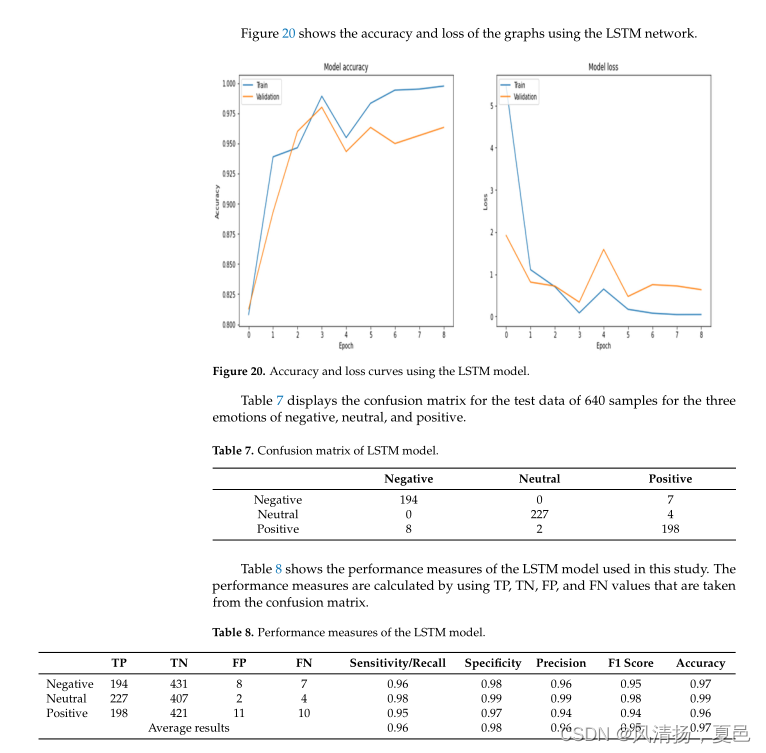

由以上计算可知,F1得分为0.95,使用LSTM模型的准确率为97%。

由以上计算可知,F1得分为0.95,使用LSTM模型的准确率为97%。

7.3. GRU架构的结果

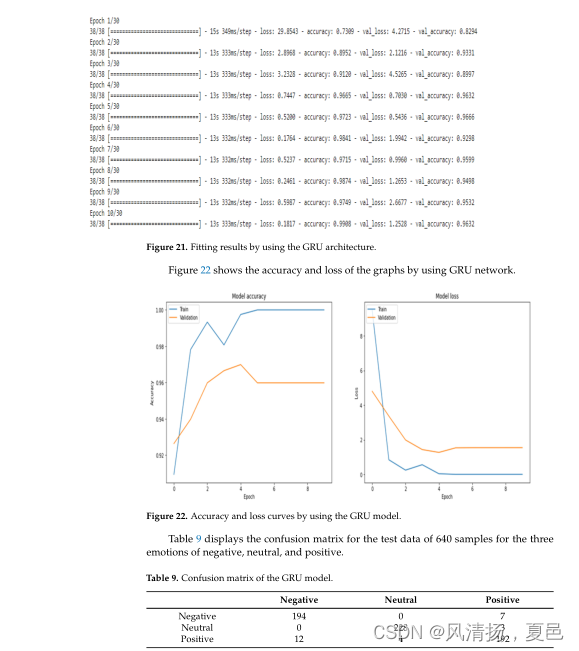

图21显示了使用GRU体系结构的数据拟合结果。

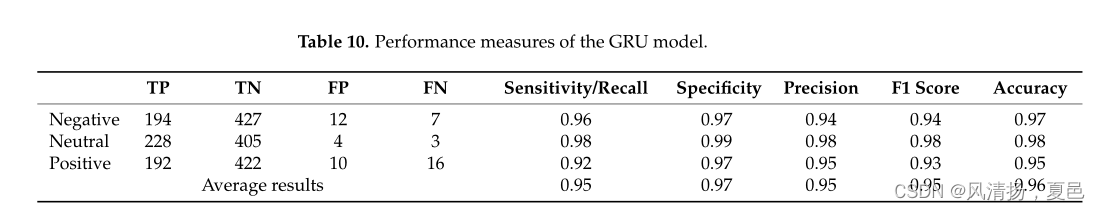

采用TP、TN、FP、FN计算敏感性、特异度、精密度、F1评分和准确度。表10显示了GRU模型的性能度量。

由以上计算可知,F1得分为0.95,使用GRU建立的模型准确率为96%。

8. 基于递归神经网络的情绪识别与脑电信号的对比分析

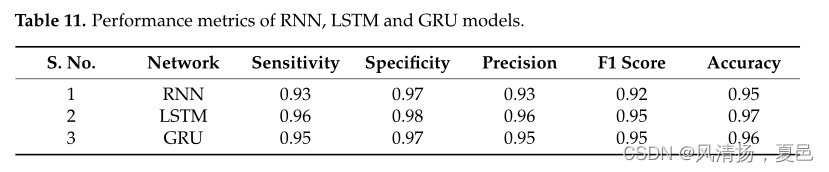

对于EEG情绪检测,本工作使用了EEG脑电波数据集。该数据集共包含三种情绪的2134个样本:积极(708个样本),消极(708个样本)和中性(716个样本)。在这个数据集中,1492个样本用于训练目的,640个样本用于测试目的。表11显示了RNN、LSTM和GRU模型的性能指标。计算每个模型的灵敏度、特异性、精度、F1评分和准确性等性能指标。使用从混淆矩阵中获得的TP、TN、FP和FN值来计算性能度量。

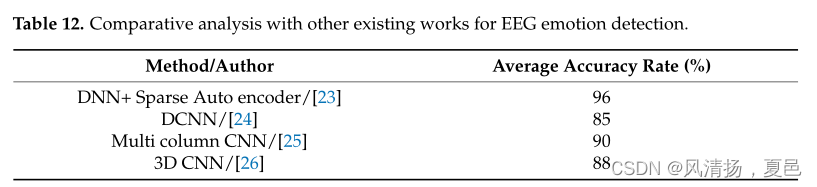

RNN具有梯度消失和爆炸的缺点,因此与RNN网络相比,LSTM和GRU网络都取得了较高的精度。与LSTM相比,GRU使用的参数更少[22],因此它占用的内存更少,速度更快。然而,LSTM在更大的数据集中更准确。当处理大序列时,选择LSTM算法,但当需要更少的内存和更快的结果时,可以使用GRU算法。在本研究中,LSTM的准确率比GRU高1%。表12给出了基于脑电图的情绪识别的其他现有工作的对比分析。

9. 结论和未来的范围

提出了基于脑电信号的情绪识别的三种模型:RNN、LSTM和GRU模型。实验采用脑电图脑电波数据库进行。

使用RNN模型达到的准确率为95%,使用LSTM模型达到97%,使用GRU模型达到96%。与RNN模型相比,LSTM和GRU模型都取得了较高的精度。在本研究中,LSTM的准确率比GRU高1%。这项研究的一个局限性是缺乏数据集,因为大多数脑电图数据集没有公开可用。如果有更多的样本可用,就有可能识别更多的情绪。未来,这些网络将用于多模态数据集和实时数据来识别情绪。

数据可用性声明:“脑电图脑电波数据集:感觉情绪”在 https://www.kaggle. com/datasets/birdy654/eeg-brainwave-dataset-feeling-emotions(于2022年5月1日访问)。

1169

1169

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?