来源:专知

本文约1000字,建议阅读5分钟

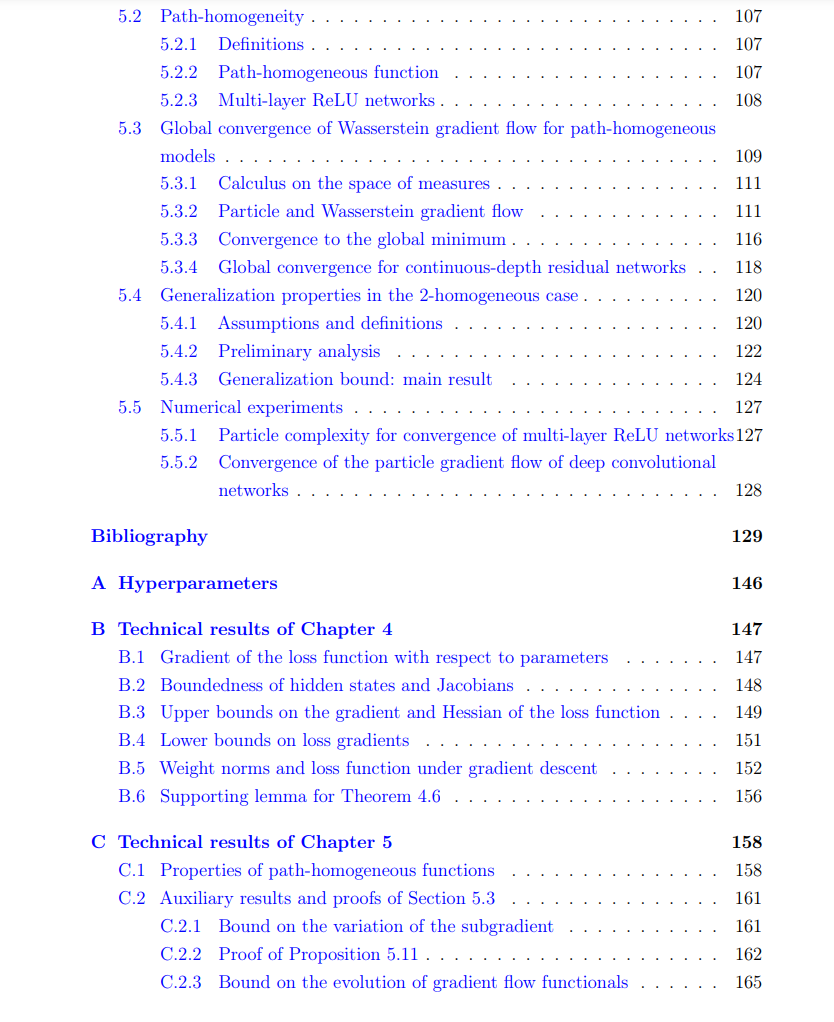

本论文旨在通过研究系统在某个参数趋近极限时的行为,即渐近分析,探索深度学习的各种重要理论方面。

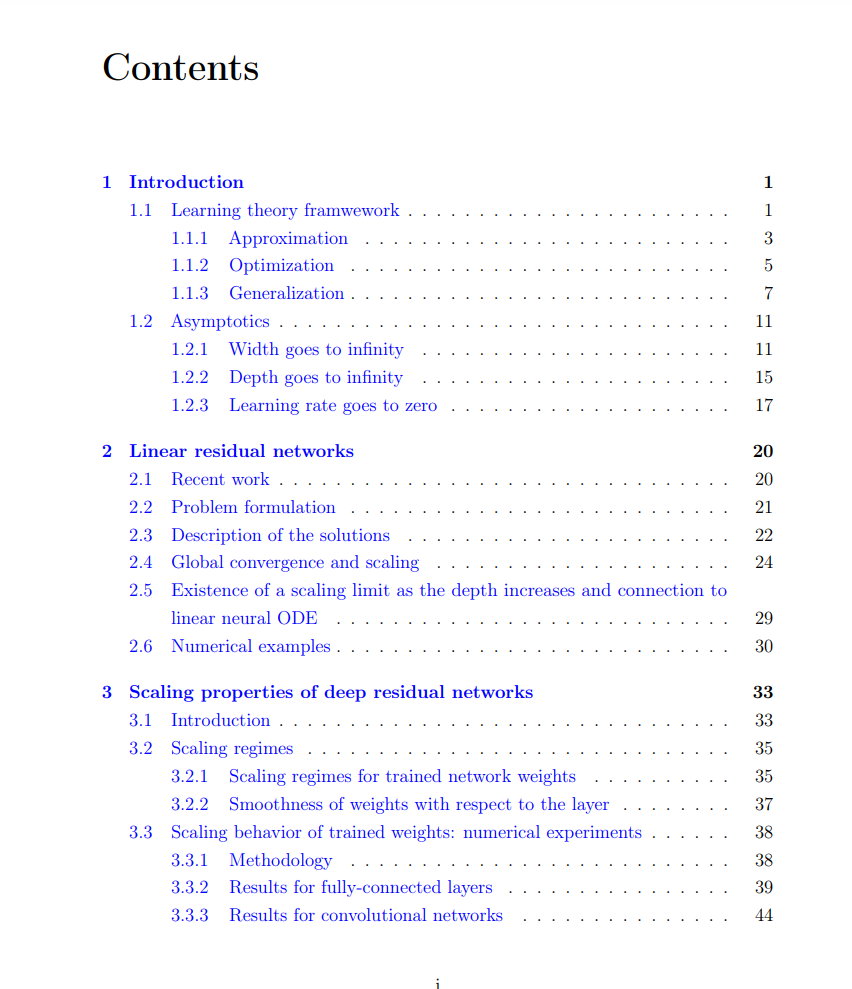

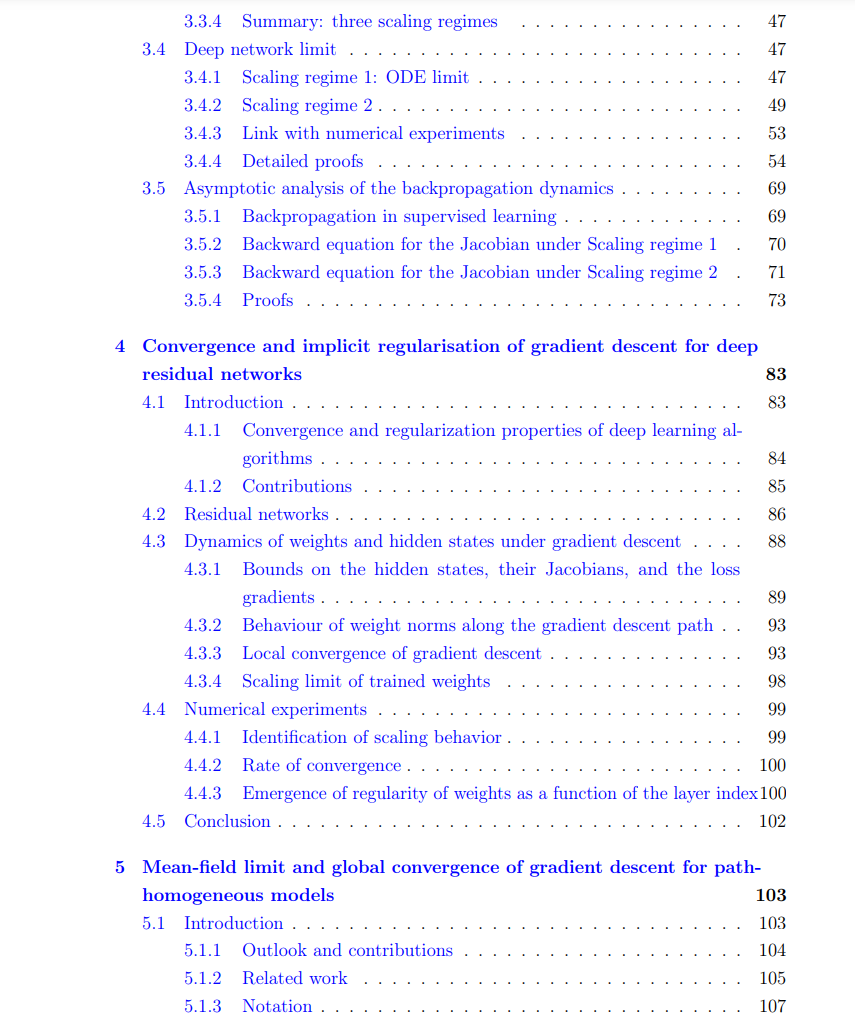

我们研究了深度残差网络在层数增加时的渐近性质。首先,我们展示了训练权重的缩放机制,这与神经ODE文献中隐含假设的缩放机制显著不同。我们研究了在这些缩放机制下隐藏状态动态的收敛性,表明可以得到常微分方程(ODE)、随机微分方程(SDE)或两者皆不是。此外,我们推导了相应的反向传播动态的缩放极限。最后,我们证明了在使用平滑激活函数的情况下,缩放机制是使用梯度下降法的结果。特别是,我们证明了梯度下降法在训练深度残差网络时线性收敛到全局最小值。我们还表明,如果训练权重作为层索引的函数,随着深度的增加承认一个缩放极限,那么该极限具有有限的p-变差,其中p=2。

本工作还研究了路径同质神经架构的平均场极限。我们证明了Wasserstein梯度流的收敛性,并推导出基于优化算法稳定性的泛化界,用于具有ReLU激活的两层神经网络。

近年来,深度神经网络在人工智能(AI)的各个领域取得了重大进展,例如图像识别、图像生成、文本生成和强化学习。这些进展已经彻底改变了许多行业,包括自动驾驶汽车、创意设计、自然语言处理和游戏。其中,自动驾驶汽车在图像识别上严重依赖深度神经网络,DALL-E根据文本描述生成图像,GPT-4生成连贯的文本,而AlphaGo Zero通过强化学习成为历史上最强的围棋选手。这些突破展示了深度神经网络在解决复杂问题和推动AI领域创新方面的强大能力和潜力。

深度学习之所以取得巨大成功,是因为拥有丰富的数据、强大的计算资源和先进的优化技术。然而,尽管深度学习在实践中取得了显著进展,但在理论上的理解仍处于初级阶段。我们仍然无法完全解释深度学习实践者使用的相对简单工具的有效性。本论文旨在通过研究系统在某个参数趋近极限时的行为,即渐近分析,探索深度学习的各种重要理论方面。

601

601

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?