目录

1 U-net简介

1.1 U-net是什么

Ronneberger等人于2015年基于FCN(全卷积神经网络)下提出的U型结构语义分割模型,提出时主要用于医学图像分割。

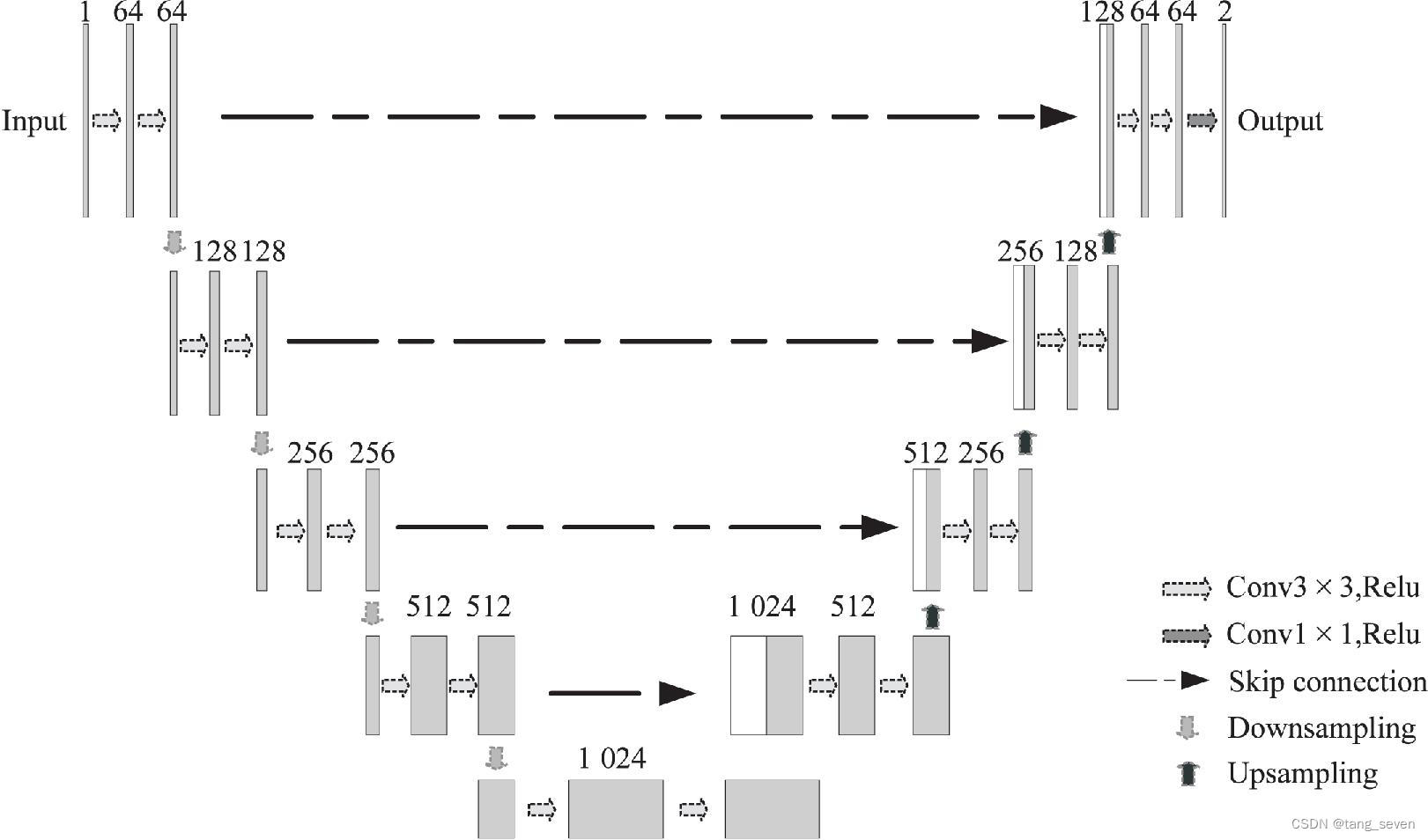

其结构如下图所示,左右对称,由网络左侧的编码器)路径、右侧的解码器路径和跳跃连接路径3部分组成:

(此图引用自 宋杰,李彩霞,李慧婷. 基于U-Net网络的医学图像分割研究综述[J]. 计算机技术与发展,2024, 34(01): 9-16.)

编码器(Encoder)路径:编码器路径又被称为收缩网络,通过4个连续的下采样(Downsampling)操作,达到图像尺寸变小,通道数翻倍的目的。而每一个下采样操作都有2个连续的3*3卷积+ReLU函数和1个最大池化操作组成。在这不断的下采样过程中,网络可以获取到图像的浅层特征信息。

解码器(Decoder)路径:解码器路径又被称为扩张网络,通过4个连续的上采样(Upsampling)操作,达到图像尺寸变大,通道数减半的目的。同理,每一个下采样操作都由对应2个连续的3*3反卷积组成,实现对图像尺寸的扩大。在这不断的上采样过程中,网络可以获取到图像的深层特征信息。

跳跃连接(Skip connection)路径:U-net在每一层的编码器和解码器之间设立了跳跃连接路径对二者进行连接,帮助模型将同一层相同尺寸的图像特征进行拼接。

最后,网络会进行一次1*1卷积,输出最后的分割图像。

因此,我们一般把U-net称之为基于Encoder-Decoder 架构下的语义分割网络。这种架构下Encoder 负责特征提取,Decoder 恢复原始分辨率。简单,但很有效,所以U-net在小样本数据集中也能发挥良好的效果。

1.2 U-net的创新点及优势

对比于同样基于Encoder-Decoder 架构进行设计的语义分割网络Segnet,U-net的创新点在于跳跃连接路径的设立,帮助模型成功将深层特征信息和浅层特征信息融合起来,实现粗粒度特征与细粒度特征的有效融合。

所以U-net最大的优势就在于可以跳跃连接路径为网络提供了更精细的图像特征,帮助网络实现像素级别的语义分割。

同时,U-net网络结构简单,所以运行速度快,针对小数据集进行训练不容易出现过拟合的问题。

再者,Encoder-Decoder 架构

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

492

492

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?