**1、安装MySQL**

```powershell

ocker run -p 3306:3306 --name mysql \

-v /idata/mysql/log:/var/log/mysql \

-v /idata/mysql/data:/var/lib/mysql \

-v /idata/mysql/conf:/etc/mysql \

-e MYSQL_ROOT_PASSWORD=root \

-d mysql:5.7

docker exec -it mysql mysql -uroot -proot

#配置MySQL主从复制

#创建master

docker run -p 3306:3306 --name mysql-master

-v /idata/mysql/log:/var/log/mysql

-v /idata/mysql/data:/var/lib/mysql

-v /idata/mysql/conf:/etc/mysql

-e MYSQL_ROOT_PASSWORD=root

-d mysql:5.7

##配置文件

vim /idata/mysql/conf/my.cnf

[client]

default-character-set=utf8

[mysql]

default-character-set=utf8

[mysqld]

init_connect=‘SET collation_connection = utf8_unicode_ci’

init_connect=‘SET NAMES utf8’

character-set-server=utf8

collation-server=utf8_unicode_ci

skip-character-set-client-handshake

skip-name-resolve

server_id=1

log-bin=mysql-bin

read-only=0

binlog-do-db=icoding_test

replicate-ignore-db=mysql

replicate-ignore-db=sys

replicate-ignore-db=information_schema

replicate-ignore-db=performance_schema

#创建Slaver,和master一致,配置文件修改如下即可

server_id=2

log-bin=mysql-bin

read-only=1

binlog-do-db=icoding_test

replicate-ignore-db=mysql

replicate-ignore-db=sys

replicate-ignore-db=information_schema

replicate-ignore-db=performance_schema

#配置matser

1、添加用来同步的用户

GRANT REPLICATION SLAVE ON . to ‘backup’@’%’ identified by ‘123456’;

2、查看master状态

show master status\G;

#配置slaver

1、change master to master_host=‘mysql-master’,master_user=‘backup’,master_password=‘123456’,master_log_file=‘mysql-bin.000003’,master_log_pos=0,master_port=3306;

2、start slave;

3、show slave status\G;

**2、安装Redis**

```powershell

mkdir -p /idata/redis/conf

touch /idata/redis/conf/redis.conf

docker run -p 6379:6379 --name redis -v /idata/redis/data:/data \

-v /idata/redis/conf:/etc/redis \

-d redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

redis 自描述文件:

#安装redis-cluster;3主3从方式,从为了同步备份,主进行slot数据分片

##单机情况下可以这样做。

cluster-announce-ip 192.168.56.10 为自己服务器的ip

for port in $(seq 7001 7006); \

do \

mkdir -p /mydata/redis/node-${port}/conf

touch /mydata/redis/node-${port}/conf/redis.conf

cat << EOF >/mydata/redis/node-${port}/conf/redis.conf

port ${port}

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

cluster-announce-ip 172.26.65.131

cluster-announce-port ${port}

cluster-announce-bus-port 1${port}

appendonly yes

EOF

docker run -p ${port}:${port} -p 1${port}:1${port} --name redis-${port} \

-v /mydata/redis/node-${port}/data:/data \

-v /mydata/redis/node-${port}/conf/redis.conf:/etc/redis/redis.conf \

-d redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf; \

done

docker stop $(docker ps -a |grep redis-700 | awk '{ print $1}')

docker rm $(docker ps -a |grep redis-700 | awk '{ print $1}')

##建立集群

docker exec -it redis-7001 /bin/sh

redis-cli --cluster create 172.26.65.131:7001 172.26.65.131:7002 172.26.65.131:7003 172.26.65.131:7004 172.26.65.131:7005 172.26.65.131:7006 --cluster-replicas 1

redis-cli -c -h 192.168.56.10 -p 7006 # -c方式连接

cluster info ,cluster node;测试

#模拟网络分离的

docker network create redis --subnet 172.38.0.0/16

for port in $(seq 1 6); \

do \

mkdir -p /mydata/redis/node-${port}/conf

touch /mydata/redis/node-${port}/conf/redis.conf

cat << EOF >/mydata/redis/node-${port}/conf/redis.conf

port 6379

bind 0.0.0.0

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

cluster-announce-ip 172.38.0.1${port}

cluster-announce-port 6379

cluster-announce-bus-port 16379

appendonly yes

EOF

done

docker run -p 637${port}:6379 -p 1637${port}:16379 --name redis-${port} \

-v /mydata/redis/node-${port}/data:/data \

-v /mydata/redis/node-${port}/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 192.168.0.1${port} redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf; \

docker run -p 6371:6379 -p 16371:16379 --name redis-1 \

-v /mydata/redis/node-1/data:/data \

-v /mydata/redis/node-1/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.11 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6376:6379 -p 16376:16379 --name redis-6 \

-v /mydata/redis/node-6/data:/data \

-v /mydata/redis/node-6/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.16 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker exec -it redis-1 /bin/sh

redis-cli --cluster create 172.38.0.11:6379 172.38.0.12:6379 172.38.0.13:6379 172.38.0.14:6379 172.38.0.15:6379 172.38.0.16:6379 --cluster-replicas 1

3、安装ElasticSearch

mkdir -p /idata/es/config

mkdir -p /idata/es/data

echo "http.host: 0.0.0.0" >> /idata/es/config/elasticsearch.yml

chmod -R 777 /idata/es/ #保证权限

docker run --name elasticsearch -p 9200:9200 -p 9300:9300 \

-e "discovery.type=single-node" \

-e ES_JAVA_OPTS="-Xms64m -Xmx512m" \

-v /idata/es/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml \

-v /idata/es/data:/usr/share/elasticsearch/data \

-v /idata/es/plugins:/usr/share/elasticsearch/plugins \

-d elasticsearch:7.4.2

docker run --name kibana -e ELASTICSEARCH_HOSTS=http://192.168.0.10:9200 -p 5601:5601 \

-d kibana:7.4.2

#安装Es集群

所有之前先运行:sysctl -w vm.max_map_count=262144

我们只是测试,所以临时修改。永久修改使用下面

#防止 JVM 报错

echo vm.max_map_count=262144 >> /etc/sysctl.conf

sysctl -p

##############3-master##########################

for port in $(seq 1 3); \

do \

mkdir -p /mydata/elasticsearch/master-${port}/config

mkdir -p /mydata/elasticsearch/master-${port}/data

chmod -R 777 /mydata/elasticsearch/master-${port}

cat << EOF >/mydata/elasticsearch/master-${port}/config/elasticsearch.yml

cluster.name: my-es #集群的名称,同一个集群该值必须设置成相同的

node.name: es-master-${port} #该节点的名字

node.master: true #该节点有机会成为 master 节点

node.data: false #该节点可以存储数据

network.host: 0.0.0.0

http.host: 0.0.0.0 #所有 http 均可访问

http.port: 920${port}

transport.tcp.port: 930${port}

discovery.zen.ping_timeout: 10s #设置集群中自动发现其他节点时 ping 连接的超时时间

discovery.seed_hosts: ["172.18.12.21:9301", "172.18.12.22:9302", "172.18.12.23:9303"] #设置集群中的 Master 节点的初始列表,可以通过这些节点来自动发现其他新加入集群的节点,es7的新增配置;

cluster.initial_master_nodes: ["172.18.12.21"] #新集群初始时的候选主节点,es7 的新增配置

EOF

docker run --name elasticsearch-node-${port} \ -p 920${port}:920${port} -p 930${port}:930${port} \ --network=mynet --ip 172.18.12.2${port} \

-e ES_JAVA_OPTS="-Xms300m -Xmx300m" \ -v

/mydata/elasticsearch/master-${port}/config/elasticsearch.yml:/usr/share/elasticsearch/config/el

asticsearch.yml \ -v /mydata/elasticsearch/master-${port}/data:/usr/share/elasticsearch/data \ -v /mydata/elasticsearch/master-${port}/plugins:/usr/share/elasticsearch/plugins \ -d elasticsearch:7.4.2

done

#######################3-node#######################

for port in $(seq 4 6); \

do \

mkdir -p /mydata/elasticsearch/node-${port}/config

mkdir -p /mydata/elasticsearch/node-${port}/data

chmod -R 777 /mydata/elasticsearch/node-${port}

cat << EOF >/mydata/elasticsearch/node-${port}/config/elasticsearch.yml

cluster.name: my-es #集群的名称,同一个集群该值必须设置成相同的

node.name: es-node-${port} #该节点的名字

node.master: false #该节点有机会成为 master 节点

node.data: true #该节点可以存储数据

network.host: 0.0.0.0

#network.publish_host: 192.168.56.10 #互相通信 ip,要设置为本机可被外界访问的 ip,否则

无法通信

http.host: 0.0.0.0 #所有 http 均可访问

http.port: 920${port}

transport.tcp.port: 930${port}

#discovery.zen.minimum_master_nodes: 2 #设置这个参数来保证集群中的节点可以知道其

它 N 个有 master 资格的节点。官方推荐(N/2)+1

discovery.zen.ping_timeout: 10s #设置集群中自动发现其他节点时 ping 连接的超时时间

discovery.seed_hosts: ["172.18.12.21:9301", "172.18.12.22:9302", "172.18.12.23:9303"] #设置集群中的 Master 节点的初始列表,可以通过这些节点来自动发现其他新加入集群的节点,es7

的新增配置

cluster.initial_master_nodes: ["172.18.12.21"] #新集群初始时的候选主节点,es7 的新增配置

EOF

docker run --name elasticsearch-node-${port} \ -p 920${port}:920${port} -p 930${port}:930${port} \ --network=mynet --ip 172.18.12.2${port} \ -e ES_JAVA_OPTS="-Xms300m -Xmx300m" \ -v

/mydata/elasticsearch/node-${port}/config/elasticsearch.yml:/usr/share/elasticsearch/config/ela

sticsearch.yml \ -v /mydata/elasticsearch/node-${port}/data:/usr/share/elasticsearch/data \ -v /mydata/elasticsearch/node-${port}/plugins:/usr/share/elasticsearch/plugins \ -d elasticsearch:7.4.2

done

##检查

_nodes/process?pretty 查看节点状况

_cluster/stats?pretty 查看集群状态

_cluster/health?pretty 查看集群健康状况

_cat/nodes 查看各个节点信息

- discovery.seed_hosts=es01,es03

- cluster.initial_master_nodes=es01,es02,es03

#还可以只开放一个实例端口.其他的都用集群内访问就可以啦。

#也可以使用自定义Docker网络的方式

docker network create --driver bridge --subnet 172.21.0.0/16 --gateway 172.21.0.1 mynet

#运行容器的时候,使用 --ip --network指定网络

4、安装Nginx

-

随便启动一个 nginx 实例, 只是为了复制出配置

docker run -p 80:80 --name nginx -d nginx:1.10 -

将容器内的配置文件拷贝到当前目录:

- mkdir -p /idata/nginx/conf

- docker container cp nginx:/etc/nginx/. /idata/nginx/conf

- 创建新的 nginx; 执行以下命令

docker run -p 80:80 --name nginx \

-v /idata/nginx/html:/usr/share/nginx/html \

-v /idata/nginx/logs:/var/log/nginx \

-v /idata/nginx/conf:/etc/nginx \

-d nginx:1.10

- 给 nginx 的 html 下面放的所有资源可以直接访问;

5、安装RabbitMQ

#简单安装

```powershell

docker run -d --name rabbitmq -p 5671:5671 -p 5672:5672 -p 4369:4369 -p

25672:25672 -p 15671:15671 -p 15672:15672 -v /idata/rabbitmq:/var/lib/rabbitmq rabbitmq:management

4369, 25672 (Erlang发现&集群端口)

5672, 5671 (AMQP端口)

15672 (web管理后台端口)

61613, 61614 (STOMP协议端口)

1883, 8883 (MQTT协议端口)

https://www.rabbitmq.com/networking.html

#安装RabbitMQ镜像集群

#三台机器分别运行

mkdir -p /idata/rabbitmq

vi /idata/rabbitmq/hosts

192.168.0.48 rabbit1 rabbit1

192.168.0.47 rabbit2 rabbit2

192.168.0.46 rabbit3 rabbit3

#注意修改每个-h 参数,修改为正确的hostname

docker run -d --name rabbitmq -h rabbit1 -v /idata/rabbitmq:/var/lib/rabbitmq -v /idata/rabbitmq/hosts:/etc/hosts -p 5671:5671 -p 5672:5672 -p 4369:4369 -p 25672:25672 -p 15671:15671 -p 15672:15672 -e RABBITMQ_ERLANG_COOKIE=‘icodingedu’ rabbitmq:management

#上面这种方式匹配主机名适用于完全分布式情况,单机模拟集群,大家觉得还有更好的方式吗?(请使用自定义网络的方式)

#RABBITMQ_ERLANG_COOKIE 节点认证作用,部署集成时 需要同步该值

#节点加入集群

#初始化第一个节点

docker exec -it rabbitmq /bin/bash

rabbitmqctl stop_app

rabbitmqctl reset

rabbitmqctl start_app

Exit

#设置集群内的其他节点

docker exec -it rabbitmq /bin/bash

rabbitmqctl stop_app

rabbitmqctl reset

rabbitmqctl join_cluster --ram rabbit@rabbit1 #master的ip

rabbitmqctl start_app

exit

#实现镜像集群

#进入主节点进行操作

docker exec -it rabbitmq bash

rabbitmqctl set_policy -p / ha “^” ‘{“ha-mode”:“all”,“ha-sync-mode”:“automatic”}’

可以使用 rabbitmqctl list_policies -p /;查看vhost/下面的所有policy

在cluster中任意节点启用策略,策略会自动同步到集群节点

rabbitmqctl set_policy -p / ha-all “^” ‘{“ha-mode”:“all”}’

策略模式 all 即复制到所有节点,包含新增节点,策略正则表达式为 “^” 表示所有匹配所有队列名称。“^hello”表示只匹配名为hello开始的队列

**六、Docker进阶**

**1、Docker仓库(私有仓库)**

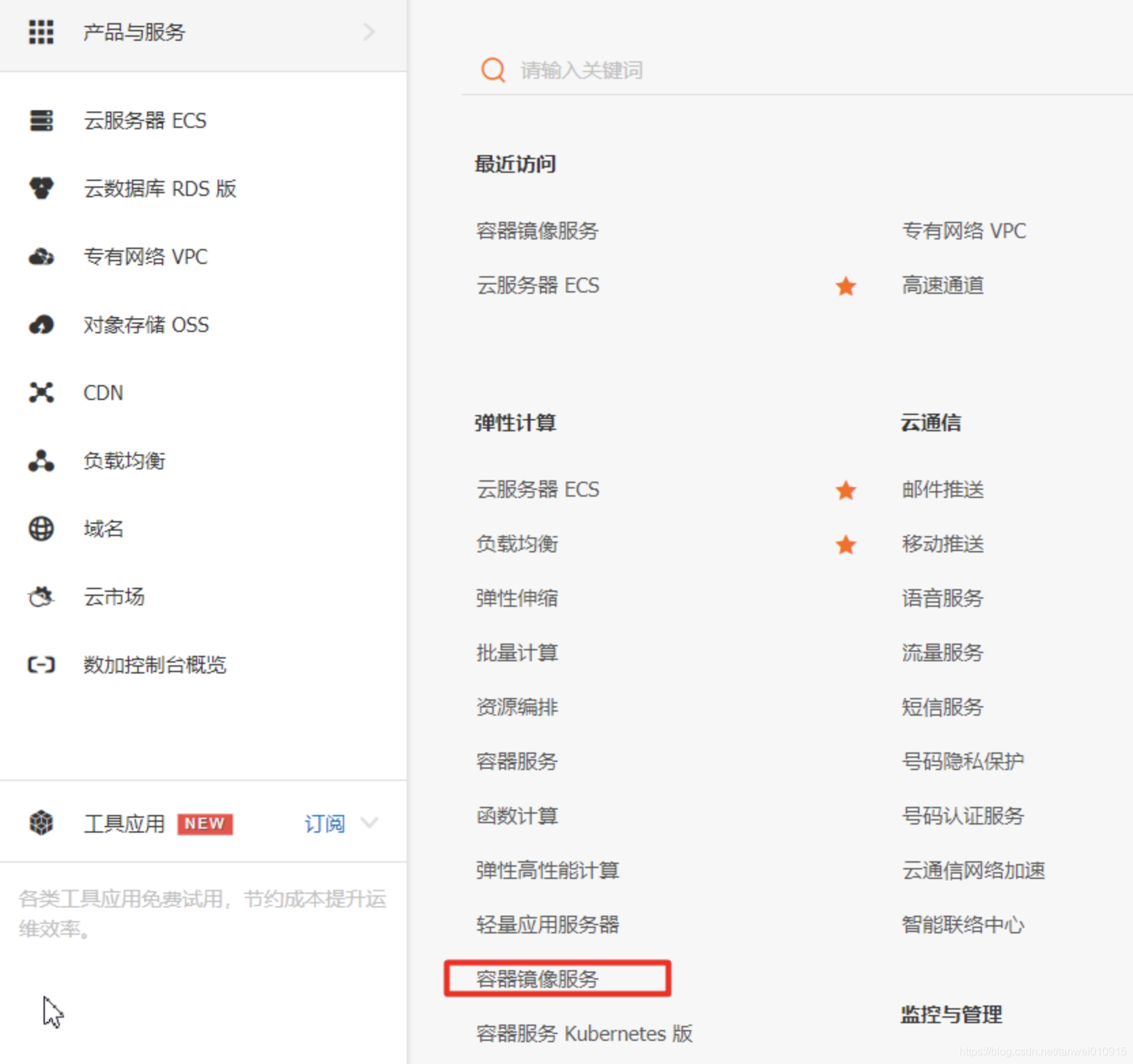

### 1、阿里云

**开通阿里云容器镜像服务**

#阿里云下载镜像,需要填写前缀

```powershell

docker pull registry.cn-shenzhen.aliyuncs.com/ali/mysql:[镜像版本号]

ali:命名空间

mysql:镜像仓库

- 创建命名空间

- 创建镜像仓库

- 2、Harbor

2、网络高级

#安装Es+kibana;kibana得指定es地址,

#sb-book-crud-service mysql

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP直接通信。

Linux虚拟网络技术。

Docker容器网络就很好的利用了Linux虚拟网络技术,在本地主机和容器内分别创建一个虚拟接口,并让他们彼此联通(这样一对接口叫veth pair);

Docker中的网络接口默认都是虚拟的接口。虚拟接口的优势就是转发效率极高(因为Linux是在内核中进行数据的复制来实现虚拟接口之间的数据转发,无需通过外部的网络设备交换),对于本地系统和容器系统来说,虚拟接口跟一个正常的以太网卡相比并没有区别,只是他的速度快很多。

原理:

1、每一个安装了Docker的linux主机都有一个docker0的虚拟网卡。桥接网卡

2、没启动一个容器linux主机多了一个虚拟网卡。

3、docker run -d -P --name tomcat --net bridge tomcat:8

#1、docker0网络的特点。,

默认

域名访问不通

–link 域名通了,但是删了又不行

#2、可以让容器创建的时候使用自定义网络

1、自定义创建的默认default “bridge”

2、自定义创建一个网络网络

docker network create --driver bridge --subnet 192.168.0.0/16 --gateway 192.168.0.1 mynet

所有东西实时维护好,直接域名ping同

3、理解网络。

docker network connect [OPTIONS] NETWORK CONTAINER

跨网络连接别人就用

docker network connect mynet tomcat

效果:

1、自定义网络,默认都可以用主机名访问通

2、跨网络连接别人就用 docker network connect mynet tomcat

1、容器启动,指定容器ip。 docker run --ip 192.168.0.3 --net 自定义网络

2、网络。docker network create --subnet 指定子网范围 --driver bridge 所有东西实时维护好,直接域名ping同

1、网络的创建过程

Docker创建一个容器的时候,会具体执行以下操作:

- 创建一对虚拟接口,分别放到本地主机和新容器的命名空间中

- 本地主机一段的虚拟接口连接到默认的docker0网桥或者指定网桥上,并具有一个以veth开头的唯一名字

- 容器一段的虚拟接口将放到新创建的容器中,并修改名字为eth0。这个接口只在容器的命名空间可见

- 从网桥的可用地址段中获取一个空闲的地址分配给容器的eth0(如:172.17.0.2/16),并配置默认路由网关为docker0网卡的内部接口docker0的IP地址(如:172.17.42.1/16)

完成以上,容器就可以使用它所能看到的eth0虚拟网卡来连接其他容器和访问外部网络。

2、网络模式

3、实验测试网络互连

- 大家重点理解veth pair技术

- –link是容器在默认网络模式下,可以互相使用容器名ping通的

- 如果容器创建时使用自定义网络,不使用–link也是可以ping通相互的容器名

- –link 生产一般不用,我们可以使用自定义网络的方式

- docker network connect

4、部署一个集群(redis)

443

443

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?