前面章节我们讲解了单层神经网络的正向传播,今天讲讲深层神经网络的正向传播。

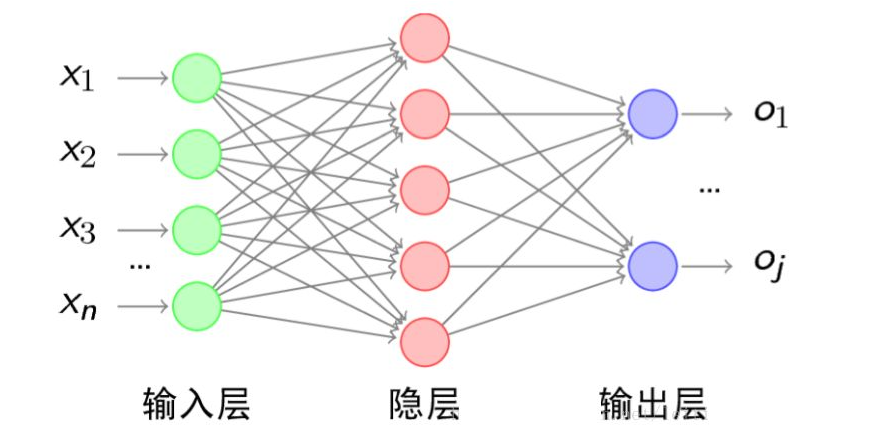

通过前面的例子我们可以看到所谓单层神经网络正向传播就是通过torch.nn.Linear把输入转输出,那多层也很简单,就是把第一层的输出作为第二层的输入,以此传播下去。而中间的那些层统称为隐藏层。

但是如果简单的用torch.nn.Linear来处理输入输出,那深层神经网络就跟单层的没啥区别了,只能处理线性问题,这时就要轮到激活函数登场了。激活函数就是前面章节提到的分类函数,它在隐藏层每次输入前处理下数据,会有神奇的功效。

假设我们有500条数据,20个特征,标签为3分类。我们现在要实现一个三层神经网络,这个神经网络的架构如下:第一层有13个神经元,第二层有8个神经元,第三层是输出层。其中,第一层的激活函数是第二层是sigmoid。我们要如何实现它呢?来看代码:

import torch

import torch.nn as nn

torch.manual_seed(420)

x = torch.rand((500,20),dtype=torch.float32) #定义数据,500条数据20个特征

class Model(nn.Module):

def __init__(self, in_features, out_features): #初始化方法

super(Model, self).__init__() #调用父类初始化方法,固定写法

#定义模型

self.liner1 = nn.Linear(in_features, 13, bias=True) #输入层不用写,隐藏层第一层

self.liner2 = nn.Linear(13, 8, bias=True) #隐藏层第二层

self.output = nn.Linear(8, out_features, bias=True) #输出层

def forward(self, x):

#输入数据,向前传播

z1 = self.liner1(x)

sigma1 = torch.relu(z1)

z2 = self.liner2(sigma1)

sigma2 = torch.sigmoid(z2)

z3 = self.output(sigma2)

sigma3 = torch.softmax(z3, dim=1)

return sigma3我们自定义了一个类,继承自nn.Module,在初始化方法中定义网络层级,我们定义了两个隐藏层liner1和liner2,一个输出层output

在forward方法中定义正向传播过程,同时指定激活函数

最后看下调用结果

net = Model(in_features=20, out_features=3)

net(x)

sigma = net.forward(x)

print(sigma)

690

690

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?