DataX日志压缩并定期清理:优化数据处理流程

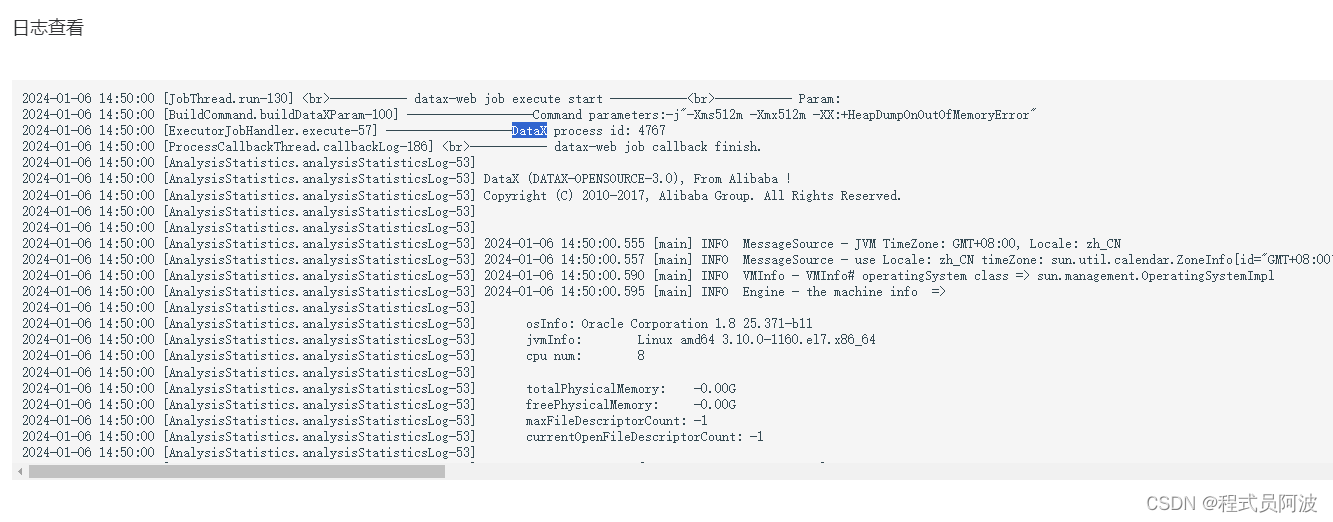

在大数据处理中,DataX是一个常用的数据传输工具。然而,随着数据量的不断增长,DataX的日志文件可能会变得非常大,占用大量的磁盘空间。因此,对DataX的日志进行压缩和定期清理是非常必要的。本文将详细介绍如何对DataX的日志进行压缩和清理,并提供相关的实例代码。

1. DataX日志压缩

DataX的日志文件通常以.log为扩展名,这些文件包含了DataX在执行过程中的所有信息。如果这些日志文件过大,可能会导致系统性能下降,甚至导致磁盘空间不足。因此,我们需要对这些日志文件进行压缩。

步骤1.1:安装gzip工具

首先,我们需要在系统中安装gzip工具。在Linux系统中,可以使用以下命令进行安装:

sudo apt-get install gzip

在Windows系统中,可以从官方网站下载并安装gzip工具。

步骤1.2:压缩日志文件

使用gzip工具可以方便地对日志文件进行压缩。假设我们的日志文件名为datax.log,我们可以使用以下命令将其压缩为datax.log.gz:

gzip datax.log

这将生成一个名为datax.log.gz的压缩文件。

2. DataX日志定期清理

虽然我们可以通过压缩日志文件来减小其大小,但是随着时间的推移,这些压缩文件的数量可能会变得非常多。因此,我们需要定期清理这些压缩文件。

步骤2.1:设置清理策略

我们可以设置一个清理策略,例如每天清理一次旧的压缩文件。这个策略可以在DataX的配置文件中进行设置。

步骤2.2:编写清理脚本

我们可以编写一个脚本来自动执行清理操作。以下是一个简单的Python脚本示例:

import os

import time

def clean_logs(directory, days):

now = time.time()

for filename in os.listdir(directory):

if filename.endswith('.log.gz'):

filepath = os.path.join(directory, filename)

if os.stat(filepath).st_mtime < now - days * 86400:

os.remove(filepath)

clean_logs('/path/to/logs', 30)

这个脚本会删除指定目录下所有超过指定天数的压缩文件。

3. 实例:使用DataX进行数据处理

现在我们已经有了压缩和清理日志的方法,我们可以使用DataX进行数据处理。以下是一个简单的DataX配置文件示例:

{

"job": {

"setting": {

"speed": {

"channel": 1

}

},

"content": [

{

"reader": {

"name": "hdfsreader",

"parameter": {

"defaultFS": "hdfs://localhost:9000",

"path": "/user/hadoop/input",

"fileType": "text",

"column": [

{

"name": "id",

"type": "string"

},

{

"name": "value",

"type": "string"

}

],

"fieldDelimiter": ","

}

},

"writer": {

"name": "hdfswriter",

"parameter": {

"defaultFS": "hdfs://localhost:9000",

"path": "/user/hadoop/output",

"fileType": "text"

}

}

}

]

}

}

在这个配置文件中,我们使用了HDFS作为数据源和目标。我们还设置了日志压缩和清理策略。具体来说,我们在每个任务完成后都会压缩日志文件,并在每天凌晨自动清理超过30天的压缩文件。

254

254

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?