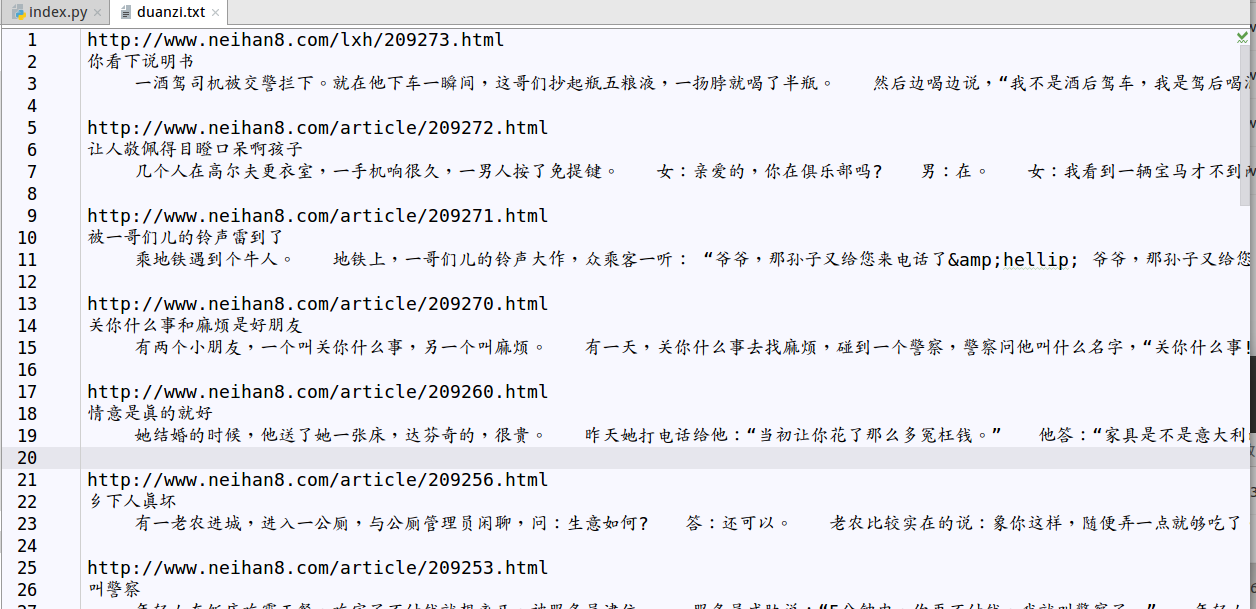

源码

# !/usr/bin/env python

# -*- coding:utf-8 -*-

"""

爬去内涵吧的段子

关键点:

1.分析url

2.分析html源码中段子的标题和内容,构建正则表达式

3.findall()方法

"""

import urllib.request

import re

class Spider(object):

def __init__(self):

"""

page:页码

"""

self.page=1

self.url="http://www.neihan8.com/wenzi/index.html"

def load_page(self):

"""加载网页数据"""

request_header={

"User-Agent":"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.108 Safari/537.36",

}

req=urllib.request.Request(self.url,headers=request_header)

resp=urllib.request.urlopen(req)

html=resp.read().decode('utf-8')

# print(html)

self.parse_page(html)

self.page+=1

if self.page!=1:

self.url=re.sub(r'index\w*\.html$','index_'+str(self.page)+'.html',self.url)

# print(self.url)

def parse_page(self,html):

"""解析网页数据,提取段子标题和内容"""

"""

<h3><a href="/article/209245.html" class="title" title="弹壳">弹壳</a></h3>

<div class="desc"> 70年代,有一天,我们村里要放电影,村里人大字不识一个,很多小孩没上过学,放的是打仗的片子,到电影队收幕的时候,村里的小孩都去扒那个幕布。 电影队的人很奇怪,就问小孩:“你</div>

"""

# re.S,全文匹配

patern=re.compile(r'<h3><a\shref="(.*?)"\sclass="title"\stitle="\w*?">(.*?)</a></h3>.*?<div class="desc">(.*?)</div>',re.S)

items=patern.findall(html)

# print(items.__len__())

for item in items:

href='http://www.neihan8.com'+item[0]

title=item[1]

desc=item[2]

data=href+'\n'+title+'\n'+desc+'\n\n'

print(data)

self.save(data)

def save(self,data):

"""保存数据到本地磁盘"""

with open('duanzi.txt',mode='a') as f:

f.write(data)

f.flush()

def work(self):

"""爬虫调度器"""

while True:

key=input("继续请按回车键,退出请按q键 >>>")

if key=="q":

break

else:

print("加载中...")

self.load_page()

if __name__ == '__main__':

spider=Spider()

spider.work()

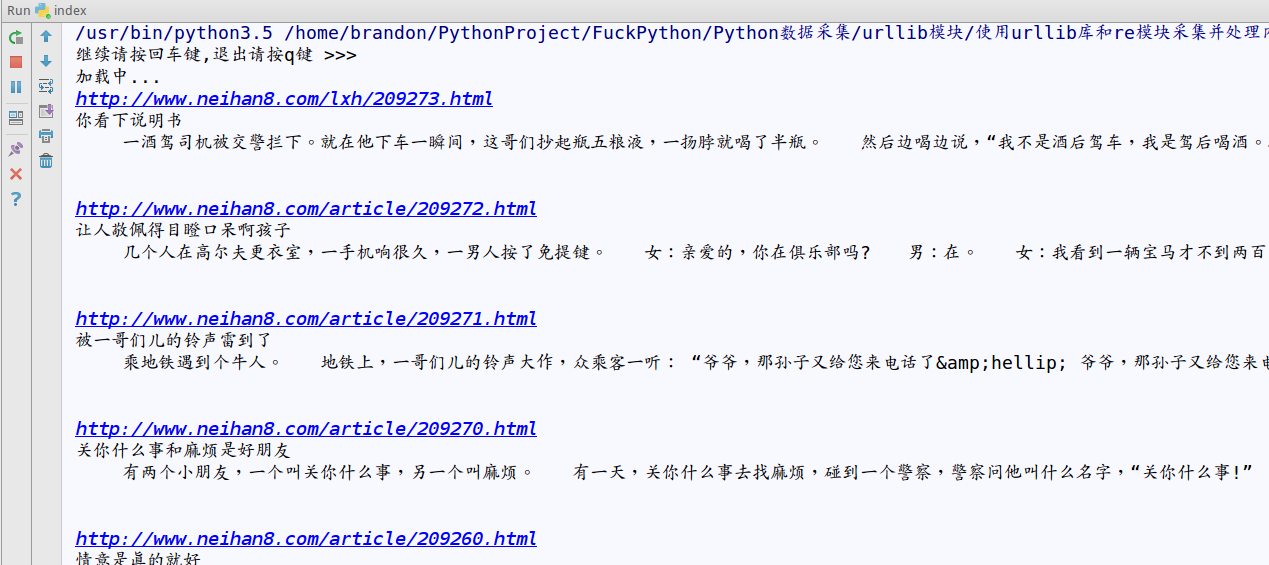

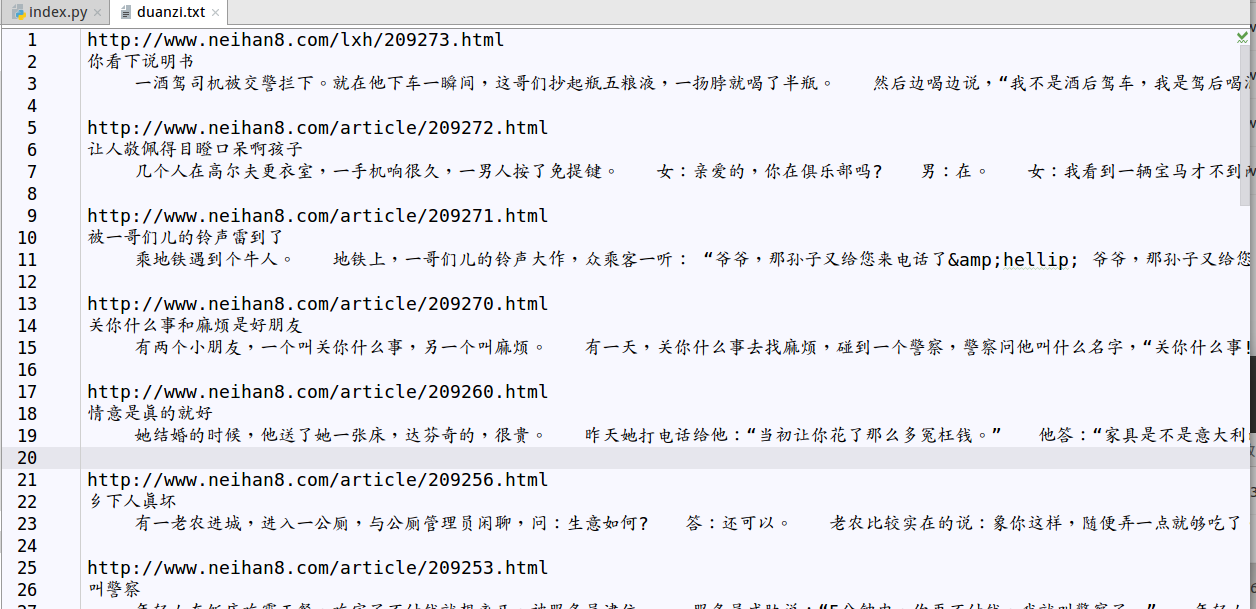

运行效果

783

783

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?