今天为大家带来一个图像生成领域令人兴奋的新力量:Flux.1 Krea Dev!这款模型由 Black Forest Labs (BFL) 携手知名创意平台 Krea 共同开发,代表了当前开源文本生成图像模型权重(Text-to-Image)的顶尖水平。它不仅仅是又一个图像生成工具,其核心设计目标直指生成结果的独特美学与自然质感。

Flux.1 Krea Dev 最令人称道之处在于它有效规避了常见的“AI感”图像缺陷。它擅长生成细节丰富、光影自然的画面,不会产生那种突兀的过曝高光,让图像整体观感更贴近真实世界的细腻与和谐。无论是追求卓越的真实感,还是希望获得独特艺术风格的输出,这款模型都能提供令人惊叹的图像质量。

对于开发者或熟悉 FLUX 生态的用户来说,另一个好消息是:Flux.1 Krea Dev 采用了与 FLUX.1 [dev] 完全兼容的架构。这意味着您可以轻松地将其集成到现有工作流中,或基于之前的经验快速上手探索其强大潜力。

星海智算平台已经为大家部署好这个镜像,开箱即用,下面为大家介绍一下,如何在星海智算平台上使用。星海智算-GPU算力云平台编辑https://gpu.spacehpc.com/user/register?inviteCode=57833422![]() https://gpu.spacehpc.com/user/register?inviteCode=57833422

https://gpu.spacehpc.com/user/register?inviteCode=57833422

具体操作:

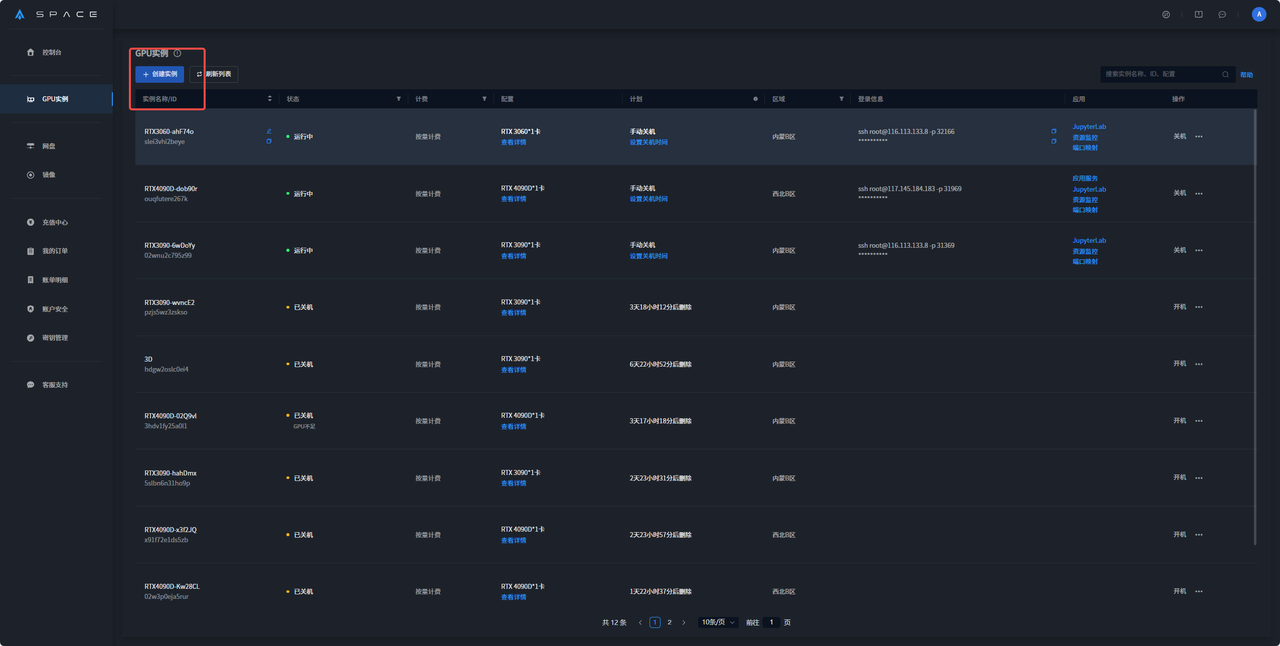

1、进入官网后在GPU实例界面中选择创建实例

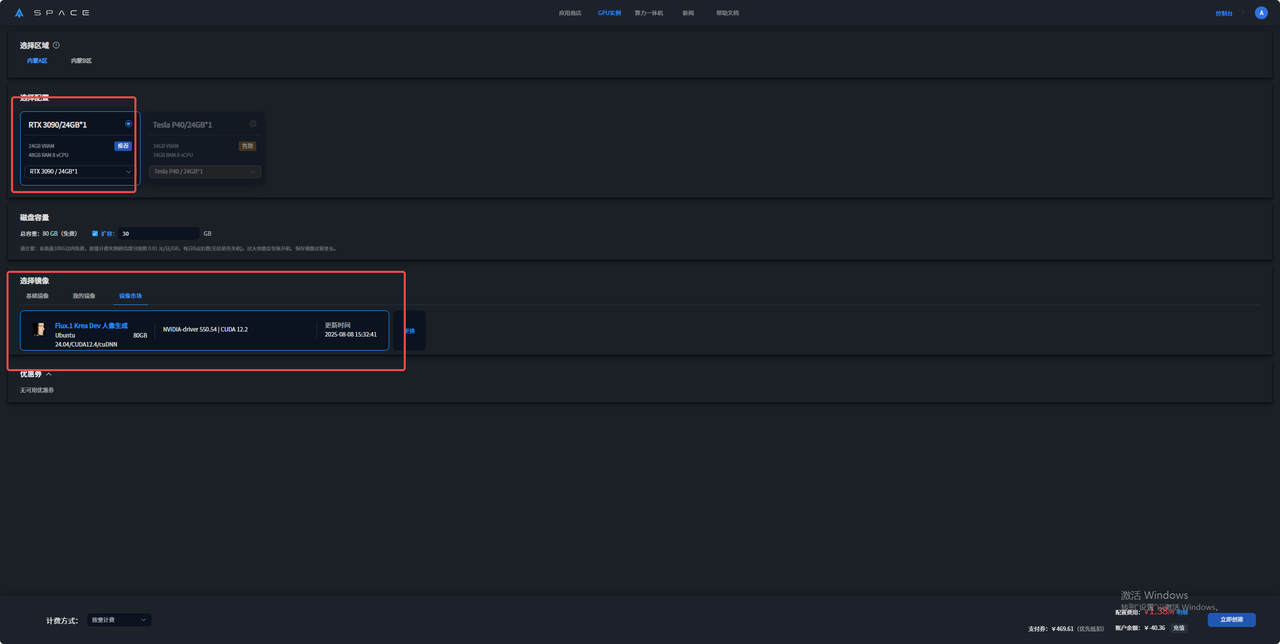

2、选择好所在区域、所需配置、计费方式后在镜像市场搜索Flux.1 Kontext Dev镜像

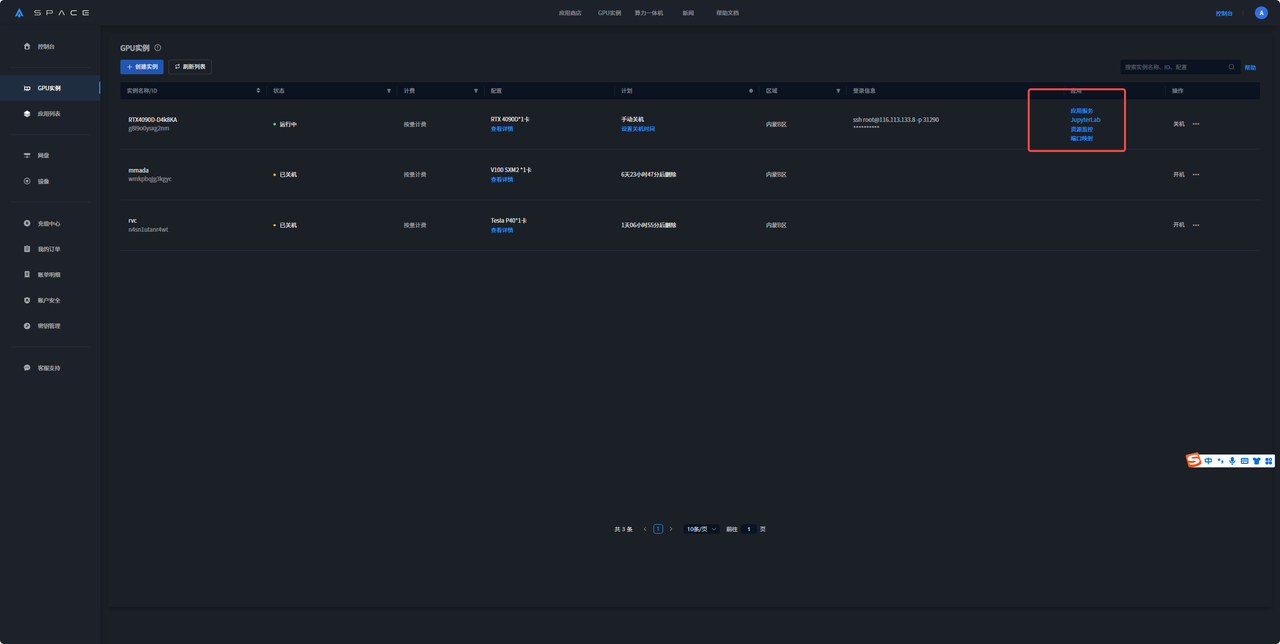

3、开机后等模型加载几分钟 点击应用服务

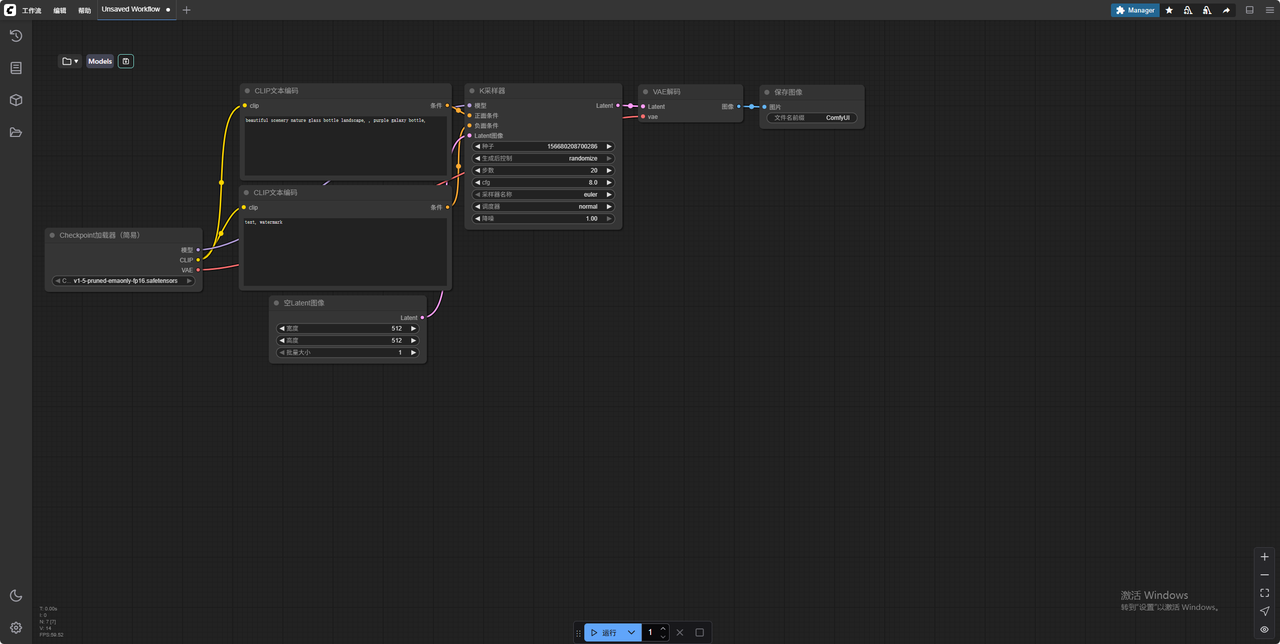

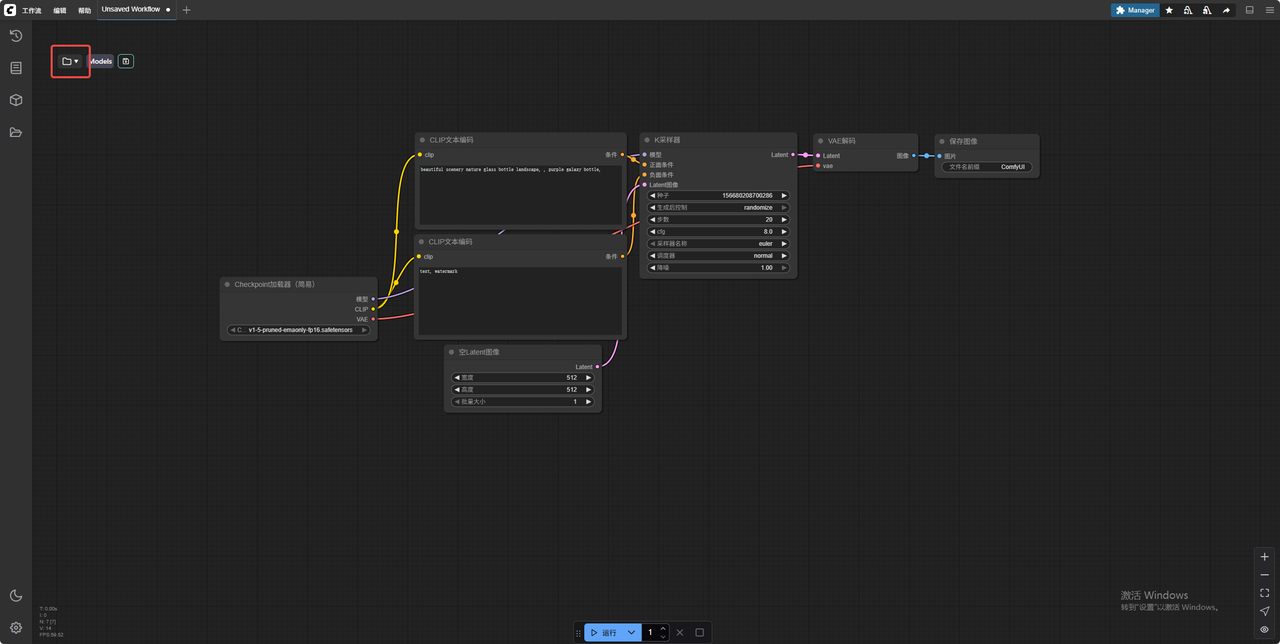

打开界面如下:

4、点击文件夹图标

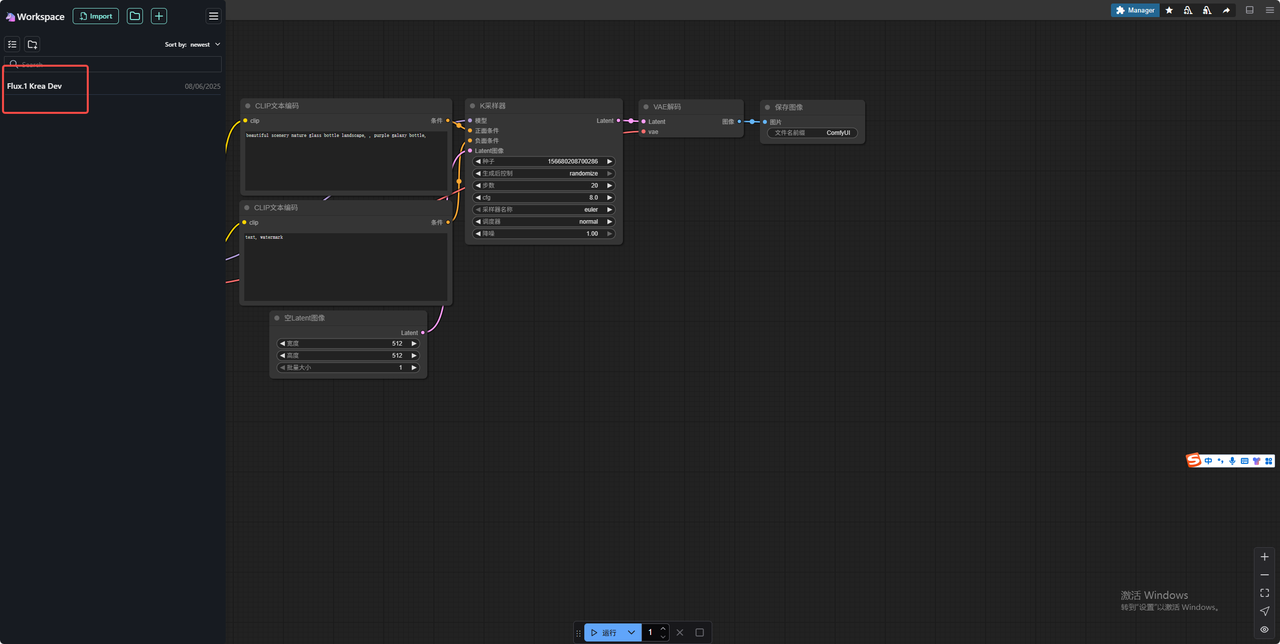

5、选择工作流

打开界面如下

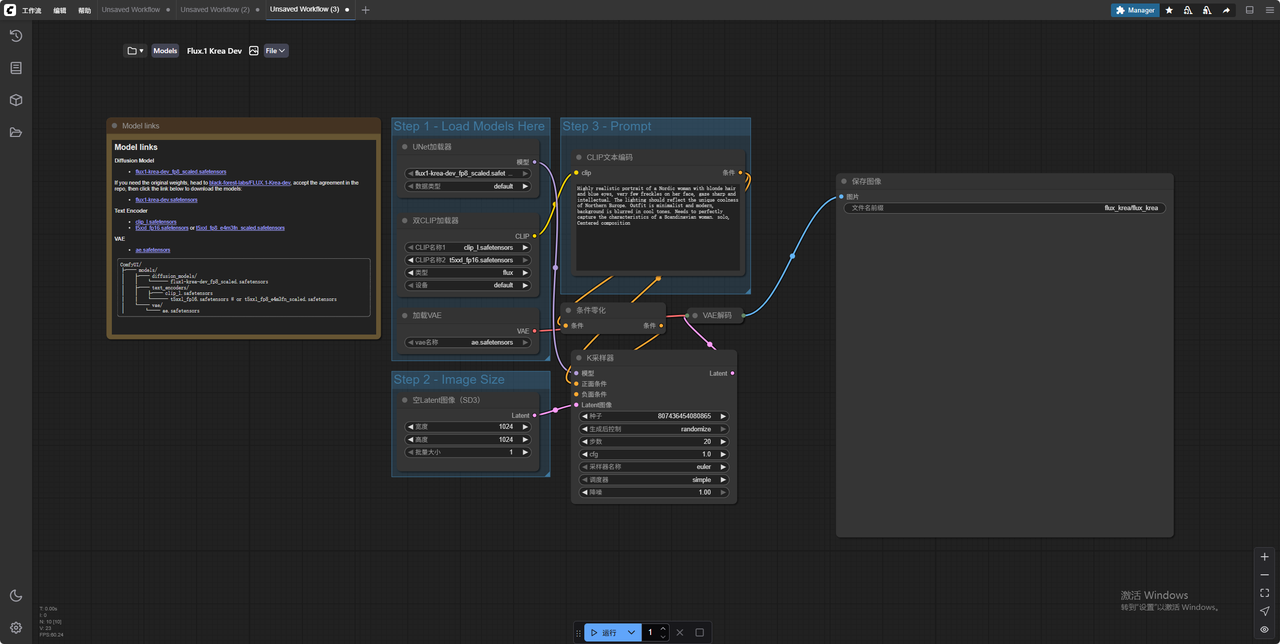

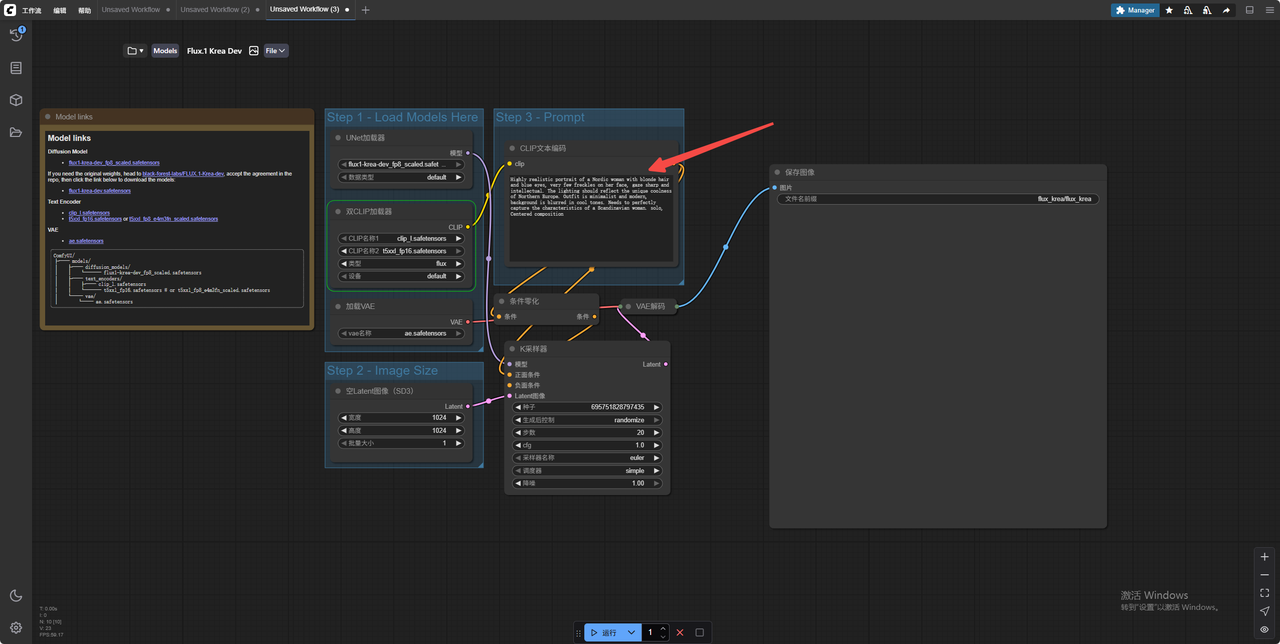

6、输入提示词 点击运行

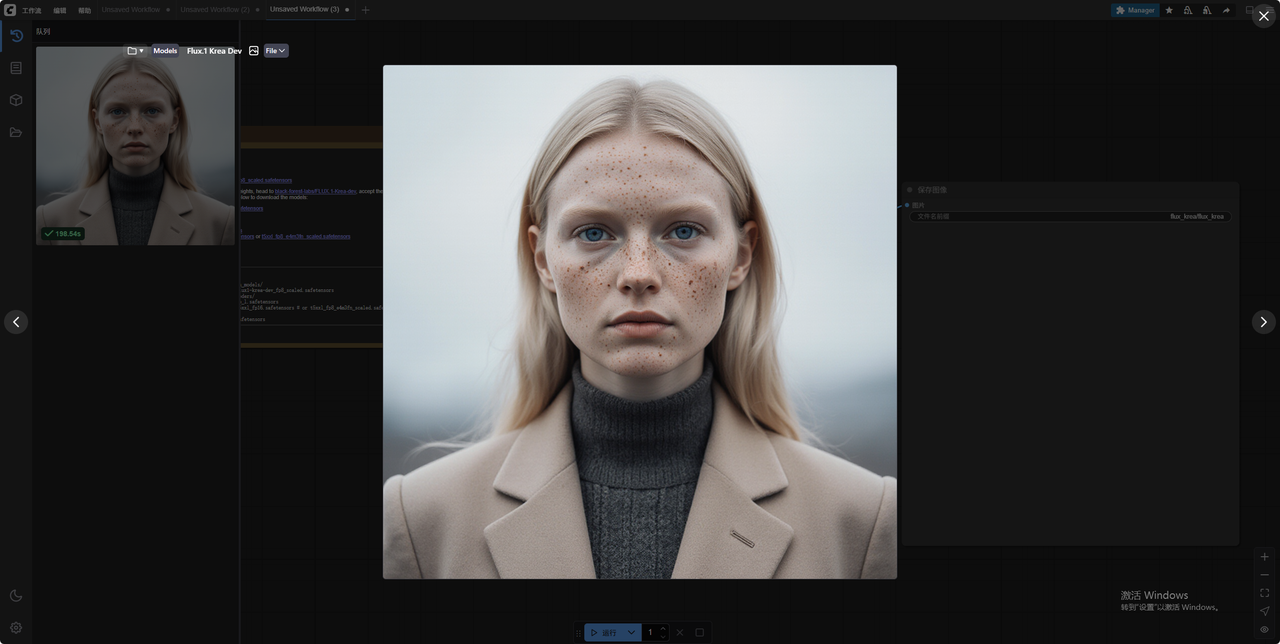

7、生成结果

1352

1352

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?