贝叶斯定理

贝叶斯定理是关于随机事件A和B的条件概率(或边缘概率)的一则定理。其中P(A|B)是在B发生的情况下A发生的可能性。

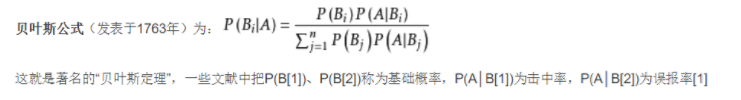

贝叶斯定理也称贝叶斯推理,早在18世纪,英国学者贝叶斯(1702~1763)曾提出计算条件概率的公式用来解决如下一类问题:假设H[1],H[2]…,H[n]互斥且构成一个完全事件,已知它们的概率P(H[i]),i=1,2,…,n,现观察到某事件A与H[1],H[2]…,H[n]相伴随机出现,且已知条件概率P(A|H[i]),求P(H[i]|A)。

定理定义

在引出贝叶斯定理之前,先学习几个定义:

-

边缘概率(又称先验概率):某个事件发生的概率。边缘概率是这样得到的:在联合概率中,把最终结果中那些不需要的事件通过合并成它们的全概率,而消去它们(对离散随机变量用求和得全概率,对连续随机变量用积分得全概率),这称为边缘化(marginalization),比如A的边缘概率表示为P(A),B的边缘概率表示为P(B)。

-

联合概率表示两个事件共同发生的概率。A与B的联合概率表示为P(A∩B)或者P(A,B)。

-

条件概率(又称后验概率):事件A在另外一个事件B已经发生条件下的发生概率。条件概率表示为P(A|B),读作“在B条件下A的概率”,。

接着,考虑一个问题:P(A|B)是在B发生的情况下A发生的可能性。

-

首先,事件B发生之前,我们对事件A的发生有一个基本的概率判断,称为A的先验概率,用P(A)表示;

-

其次,事件B发生之后,我们对事件A的发生概率重新评估,称为A的后验概率,用P(A|B)表示;

-

类似的,事件A发生之前,我们对事件B的发生有一个基本的概率判断,称为B的先验概率,用P(B)表示;

-

同样,事件A发生之后,我们对事件B的发生概率重新评估,称为B的后验概率,用P(B|A)表示。

为什么贝叶斯?

现实世界本身就是不确定的,人类的观察能力是有局限性的。

我们日常所观察到的只是事物表面上的结果,因此我们需要提供一个猜测。

垃圾邮件过滤实例:

问题:给定一封邮件,判定它是否属于垃圾邮件 D 来表示这封邮件,注意 D 由 N 个单词组成。我们用 h+ 来表示垃圾邮件,h- 表示正常邮件.

P(h+|D) = P(h+) * P(D|h+) / P(D)

P(h- |D) = P(h- ) * P(D|h- ) / P(D)

先验概率:P(h+) 和 P(h-) 这两个先验概率都是很容易求出来的,只需要计算一个邮件库里面垃圾邮件和正常邮件的比例就行了。

D 里面含有 N 个单词 d1, d2, d3,P(D|h+) = P(d1,d2,…,dn|h+)P(d1,d2,…,dn|h+) 就是说在垃圾邮件当中出现跟我们目前这封邮件一模一样的一封邮件的概率是多大!

P(d1,d2,…,dn|h+) 扩展为: P(d1|h+) * P(d2|d1, h+) * P(d3|d2,d1, h+) * …

假设 di 与 di-1 是完全条件无关的(朴素贝叶斯假设特征之间是独立,互不影响),事实上是相关的,然而这里为了求解,必须这样做,并且会对结果造成影响,但是产生的对最终结果的影响是我们可以接受的。

简化为 P(d1|h+) * P(d2|h+) * P(d3|h+) * …

对于P(d1|h+) * P(d2|h+) * P(d3|h+) * …只要统计 di 这个单词在垃圾邮件中出现的频率即可.

通过上面给出的思路,我们就只需要通过一些统计过程,计算P(h+)、P(D|h+) 、P(h- )、P(D|h- )这几个先验概率的值就可以得到相关的概率值。另外的P(D)是一个定值,对结果不会造成影响,可以忽略不统计。

那么怎么统计P(h+)、P(D|h+) 、P(h- )、P(D|h- )呢?

这么说吧,假如有一个邮件库,包含10000份邮件,其中垃圾邮件1000份,正常邮件9000份,则P(h+)=1000/10000、P(h- )=9000/10000;P(D|h+)=P(d1|h+) * P(d2|h+) * P(d3|h+) * … ;同理P(D|h-)=P(d1|h-) * P(d2|h-) * P(d3|h-) * …

这样就能够得到最终的结果。

贝叶斯拼写检查器-代码实现

import re, collections

def words(text): return re.findall('[a-z]+', text.lower())

def train(features):

model = collections.defaultdict(lambda: 1)

for f in features:

model[f] += 1

return model

NWORDS = train(words(open(r'..\big.txt').read()))

alphabet = 'abcdefghijklmnopqrstuvwxyz'

def edits1(word):

n = len(word)

return set([word[0:i]+word[i+1:] for i in range(n)] + # deletion

[word[0:i]+word[i+1]+word[i]+word[i+2:] for i in range(n-1)] + # transposition

[word[0:i]+c+word[i+1:] for i in range(n) for c in alphabet] + # alteration

[word[0:i]+c+word[i:] for i in range(n+1) for c in alphabet]) # insertion

def known_edits2(word):

return set(e2 for e1 in edits1(word) for e2 in edits1(e1) if e2 in NWORDS)

def known(words): return set(w for w in words if w in NWORDS)

def correct(word):

candidates = known([word]) or known(edits1(word)) or known_edits2(word) or [word]

return max(candidates, key=lambda w: NWORDS[w])

#appl #appla #learw #tess #morw

correct('learW')

求解:argmaxc P(c|w) -> argmaxc P(w|c) P© / P(w)

- P©, 文章中出现一个正确拼写词 c 的概率, 也就是说, 在英语文章中, c 出现的概率有多大

- P(w|c), 在用户想键入 c 的情况下敲成 w 的概率. 因为这个是代表用户会以多大的概率把 c 敲错成 w

- argmaxc, 用来枚举所有可能的 c 并且选取概率最大的

# 把语料中的单词全部抽取出来, 转成小写, 并且去除单词中间的特殊符号

def words(text): return re.findall('[a-z]+', text.lower())

def train(features):

model = collections.defaultdict(lambda: 1)

for f in features:

model[f] += 1

return model

NWORDS = train(words(open('big.txt').read()))

要是遇到我们从来没有过见过的新词怎么办. 假如说一个词拼写完全正确, 但是语料库中没有包含这个词, 从而这个词也永远不会出现在训练集中. 于是, 我们就要返回出现这个词的概率是0. 这个情况不太妙, 因为概率为0这个代表了这个事件绝对不可能发生, 而在我们的概率模型中, 我们期望用一个很小的概率来代表这种情况. lambda: 1

编辑距离:

两个词之间的编辑距离定义为使用了几次插入(在词中插入一个单字母), 删除(删除一个单字母), 交换(交换相邻两个字母), 替换(把一个字母换成另一个)的操作从一个词变到另一个词.

#返回所有与单词 w 编辑距离为 1 的集合

def edits1(word):

n = len(word)

return set([word[0:i]+word[i+1:] for i in range(n)] + # deletion

[word[0:i]+word[i+1]+word[i]+word[i+2:] for i in range(n-1)] + # transposition

[word[0:i]+c+word[i+1:] for i in range(n) for c in alphabet] + # alteration

[word[0:i]+c+word[i:] for i in range(n+1) for c in alphabet]) # insertion

上面是所有的编辑距离为1的单词的集合,但是这些单词不一定都是存在的。

与 something 编辑距离为2的单词居然达到了 114,324 个

优化:在这些编辑距离小于2的词中间, 只把那些正确的词作为候选词,只能返回 3 个单词: ‘smoothing’, ‘something’ 和 ‘soothing’

# 返回所有与单词 w 编辑距离为 2 的集合

#v在这些编辑距离小于2的词中间, 只把那些正确的词作为候选词

def edits2(word):

return set(e2 for e1 in edits1(word) for e2 in edits1(e1))

正常来说把一个元音拼成另一个的概率要大于辅音 (因为人常常把 hello 打成 hallo 这样); 把单词的第一个字母拼错的概率会相对小, 等等.但是为了简单起见, 选择了一个简单的方法: 编辑距离为1的正确单词比编辑距离为2的优先级高, 而编辑距离为0的正确单词优先级比编辑距离为1的高.

def known(words): return set(w for w in words if w in NWORDS)

#如果known(set)非空, candidate 就会选取这个集合, 而不继续计算后面的

def correct(word):

candidates = known([word]) or known(edits1(word)) or known_edits2(word) or [word]

return max(candidates, key=lambda w: NWORDS[w])

3508

3508

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?