之前主要是对真实的数字货币数据,进行基本的数据处理、分析、可视化,并基于light GBM进行了收益率的预测。两篇文章分享了源代码和数据集,但是还是比较侧重于实践。

所以从这篇开始,我也会同步记录自己阅读时间序列论文的笔记。但根据我的经验,由于相关论文太多,刚刚入坑的同学大多是不知道该从哪篇读起的,这是因为新手(包括我自己)往往对当前的研究的发展脉络是没有整体概念的。

这时候,理清整体发展脉络,找到重点论文,并跟踪到最新的研究进展就极其重要。我前期已经阅读了一些论文,包括(Transformer, Informer, Autoformer, Pyraformer, FEDformer, PatchTST, Non-stationary Transformers, LTSF-Linear),这些论文多数是时间序列重要的baseline,我希望通过笔记有个很好的总结,并进行长期的更新,如能帮助大家则是更好。

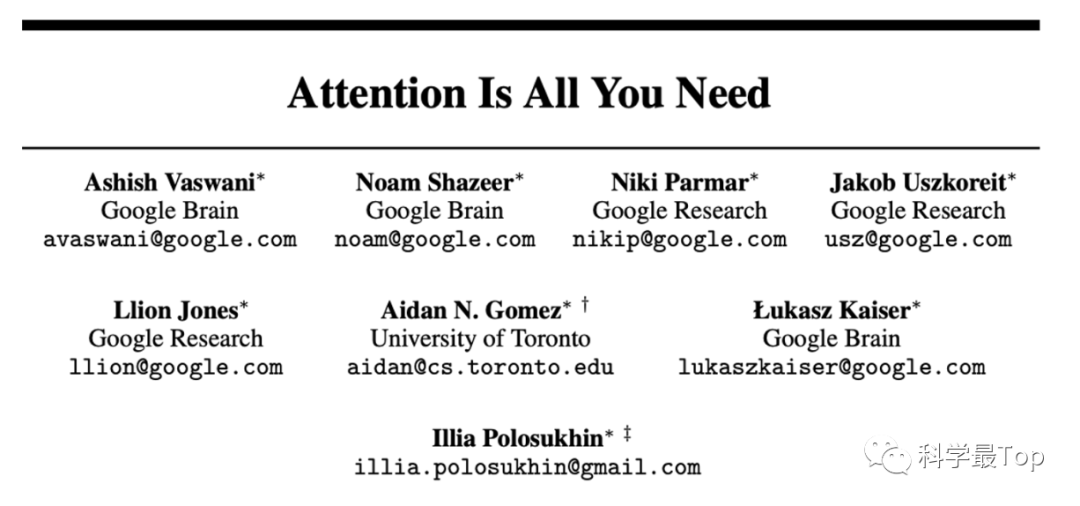

Transformer|NeurIPS17

Transformer 是开山之作,可是说在大多数研究领域,你都无法绕开它,在时间序列的领域也不例外。你会发现大量以研究“**former”命名的时序研究文章。Transformer的自注意力和多头注意力机制让表征特征的能力提升了一个台阶。但是,今天我们不关心它的优点,当把transformer直接应用到时间序列研究领域,我们发现它的效果并不好,事实上它有并不

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?