Flink启动脚本

在flink的bin目录下找到一个flink脚本,使用vim命令打开如下内容

#!/usr/bin/env bash

target="$0"

# For the case, the executable has been directly symlinked, figure out

# the correct bin path by following its symlink up to an upper bound.

# Note: we can't use the readlink utility here if we want to be POSIX

# compatible.

iteration=0

while [ -L "$target" ]; do

if [ "$iteration" -gt 100 ]; then

echo "Cannot resolve path: You have a cyclic symlink in $target."

break

fi

ls=`ls -ld -- "$target"`

target=`expr "$ls" : '.* -> \(.*\)$'`

iteration=$((iteration + 1))

done

# Convert relative path to absolute path

bin=`dirname "$target"`

# get flink config

. "$bin"/config.sh

if [ "$FLINK_IDENT_STRING" = "" ]; then

FLINK_IDENT_STRING="$USER"

fi

CC_CLASSPATH=`constructFlinkClassPath`

# 以上内容忽略

# 日志输出文件名

log=$FLINK_LOG_DIR/flink-$FLINK_IDENT_STRING-client-$HOSTNAME.log

# 指定日志配置文件

log_setting=(-Dlog.file="$log" -Dlog4j.configuration=file:"$FLINK_CONF_DIR"/log4j-cli.properties -Dlog4j.configurationFile=file:"$FLINK_CONF_DIR"/log4j-cli.properties -Dlogback.configurationFile=file:"$FLINK_CONF_DIR"/logback.xml)

# 指定flink环境的java参数

FLINK_ENV_JAVA_OPTS="${FLINK_ENV_JAVA_OPTS} ${FLINK_ENV_JAVA_OPTS_CLI}"

# Add HADOOP_CLASSPATH to allow the usage of Hadoop file systems

# ${JAVA_RUN}引用的是java/bin/java

# 最终指定的类是CliFrontend 以及后面跟的数组参数"$@"

exec "${JAVA_RUN}" $JVM_ARGS $FLINK_ENV_JAVA_OPTS "${log_setting[@]}" -classpath "`manglePathList "$CC_CLASSPATH:$INTERNAL_HADOOP_CLASSPATHS"`" org.apache.flink.client.cli.CliFrontend "$@"

CliFrontend(客户端启动类)

从上面客户端启动脚本,紧接着去代码中查看org.apache.flink.client.cli.CliFrontend 这个类。

如果没有编译成功,请自行操作,也可参考小编之前写过的两篇文章(地址就不贴了)。

代码调试

这一节有参考博客。

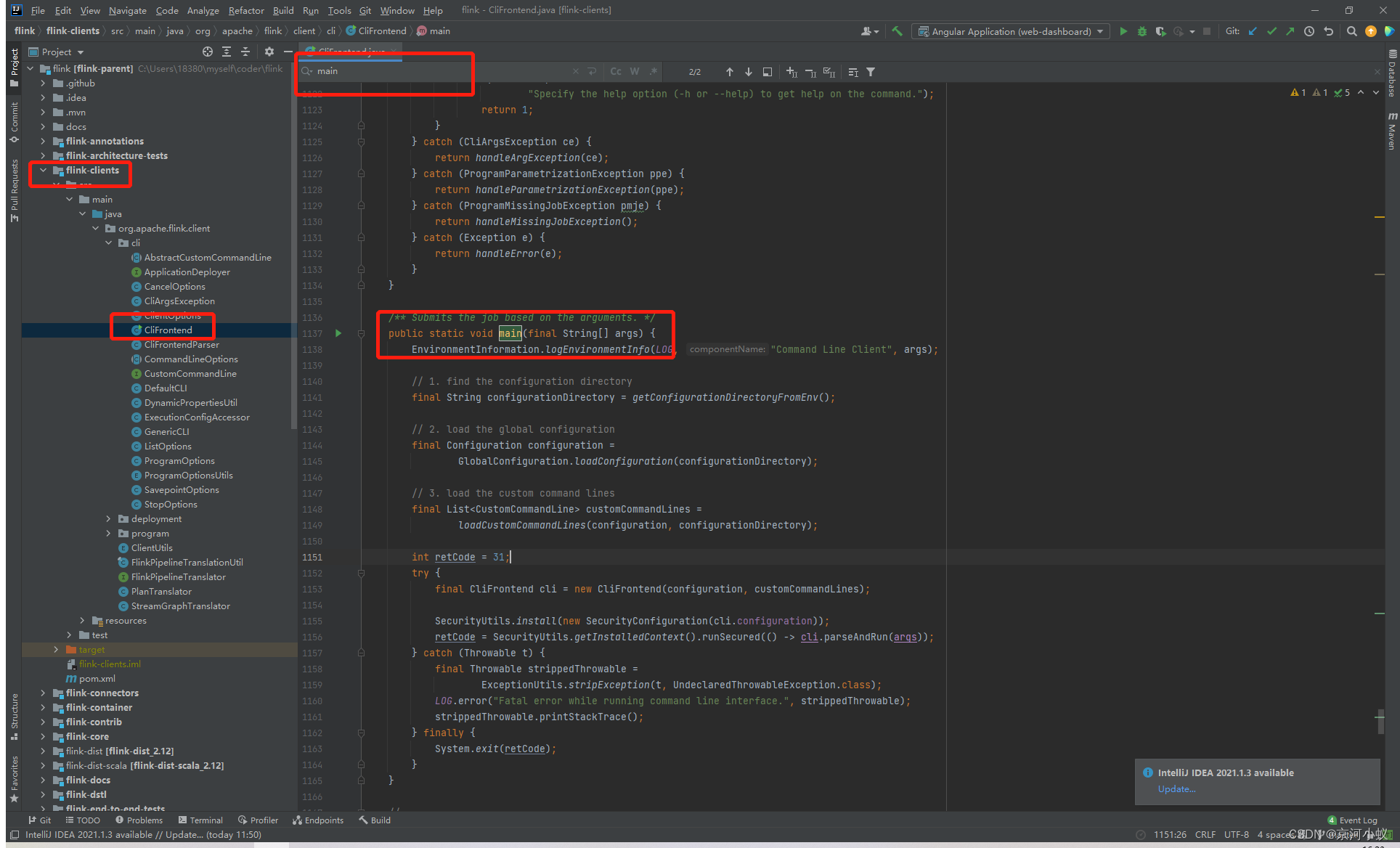

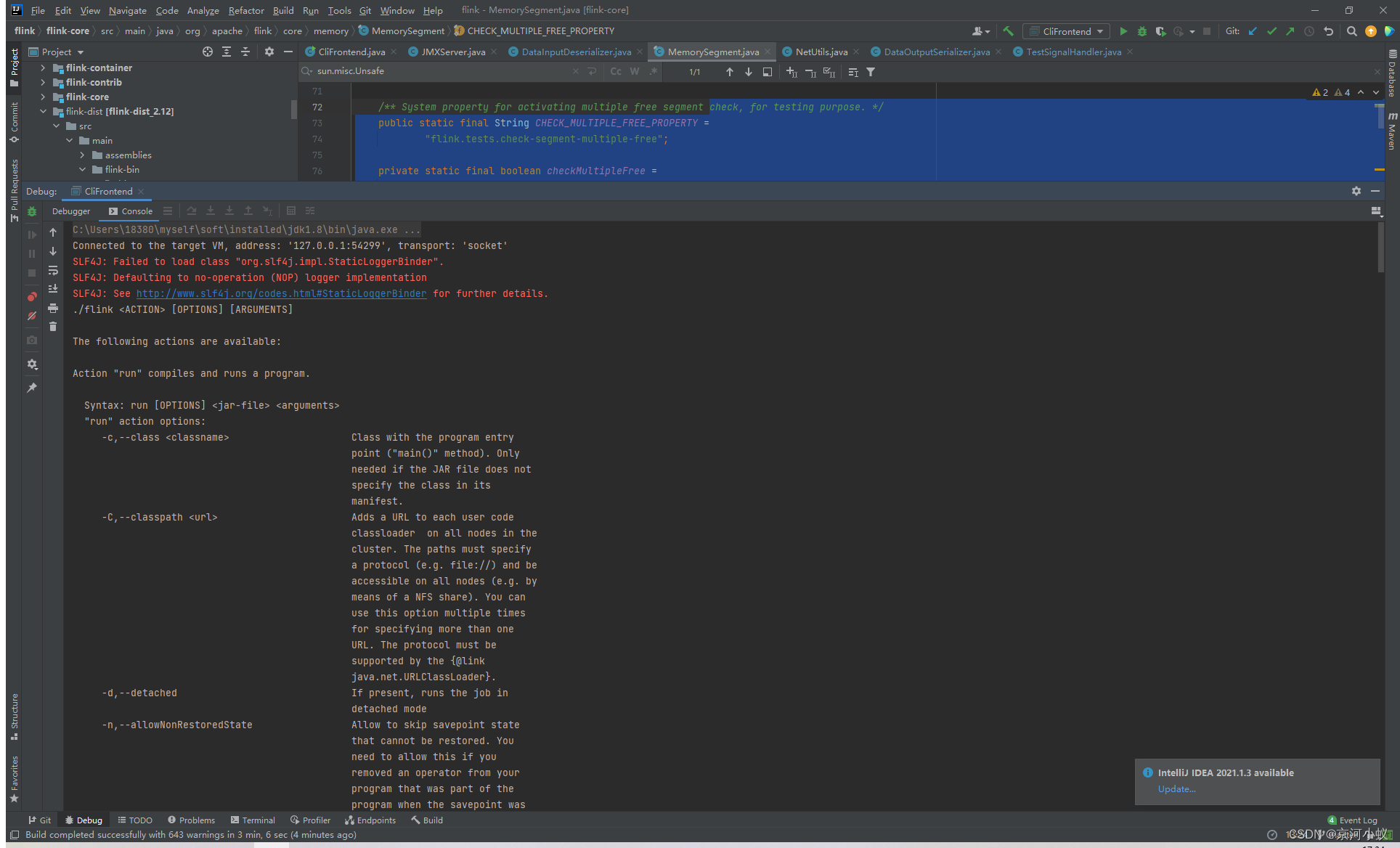

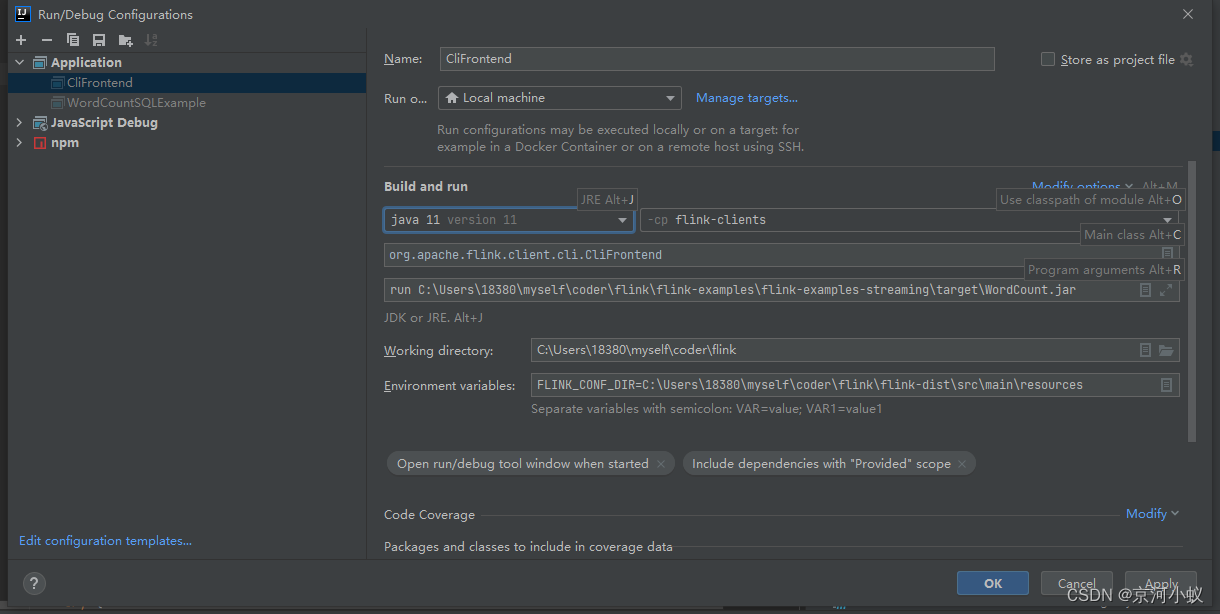

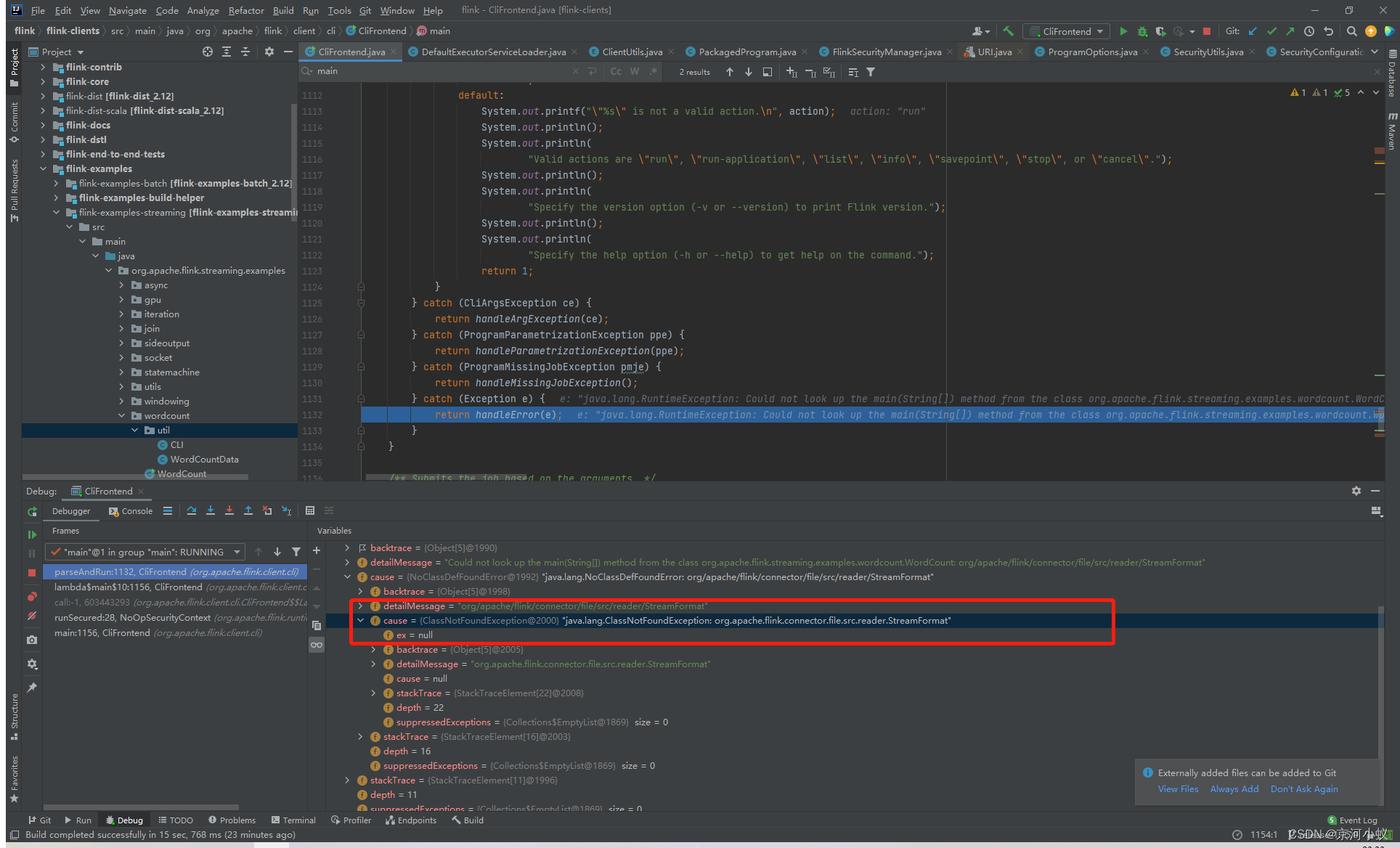

根据上面截图,提交flink app程序入口找到了,我们先来调试下,ide基于idea version2021.1

直接debug main方法,如下图所示

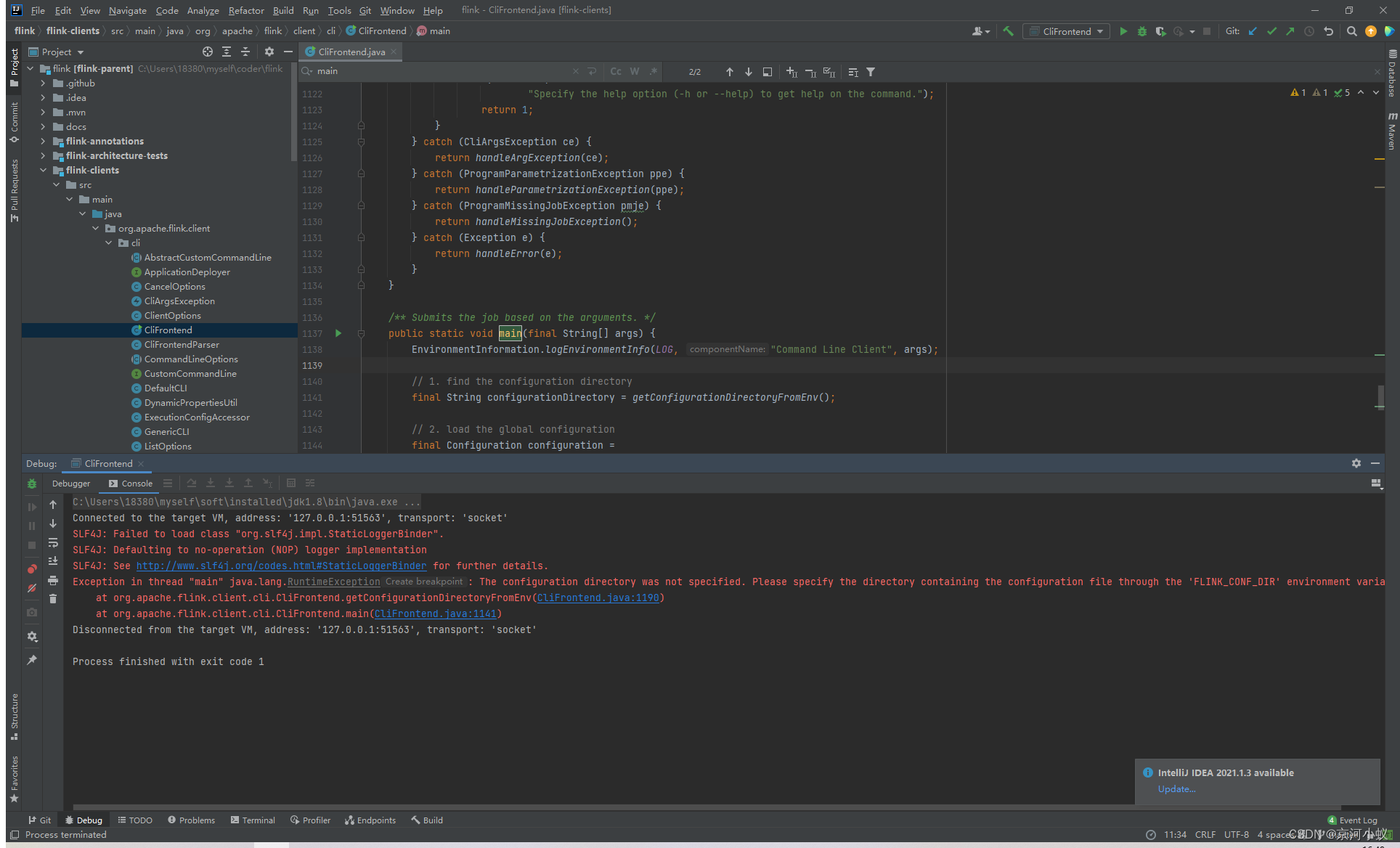

退出code为1,具体是下面的错误

Exception in thread "main" java.lang.RuntimeException: The configuration directory was not specified. Please specify the directory containing the configuration file through the 'FLINK_CONF_DIR' environment variable.

说在环境变量中,没有找到 FLINK_CONF_DIR 配置,也就是 flink 配置文件没有找到,就是那个 flink-conf.yml 文件

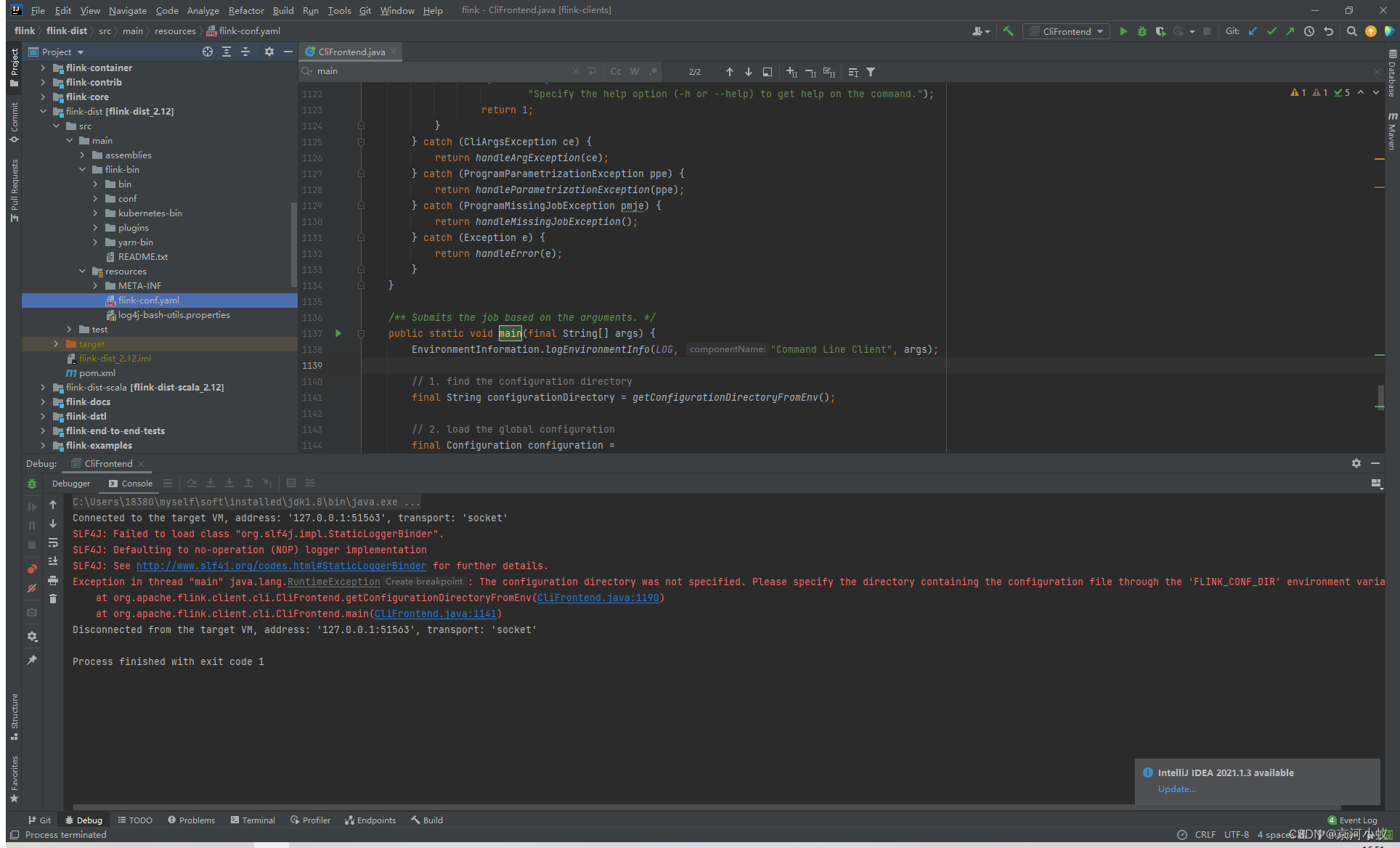

这个文件其实是在发行目录下:

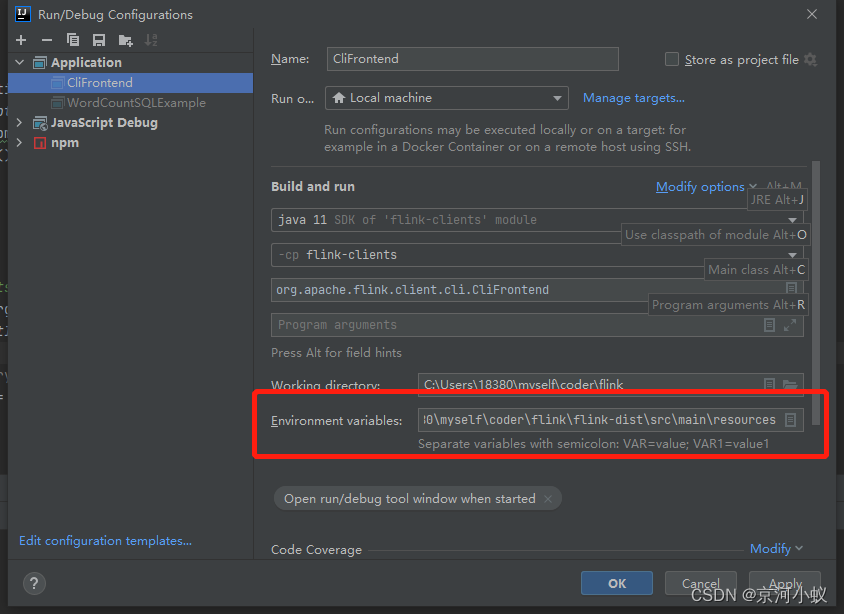

然后配置一个

FLINK_CONF_DIR=C:\Users\18380\myself\coder\flink\flink-dist\src\main\resources

再运行一遍,报错如下

原来是因为,我们之前在运行命令的时候,后面还有一坨参数,现在什么参数都没有往 main 方法传,当然报错了。

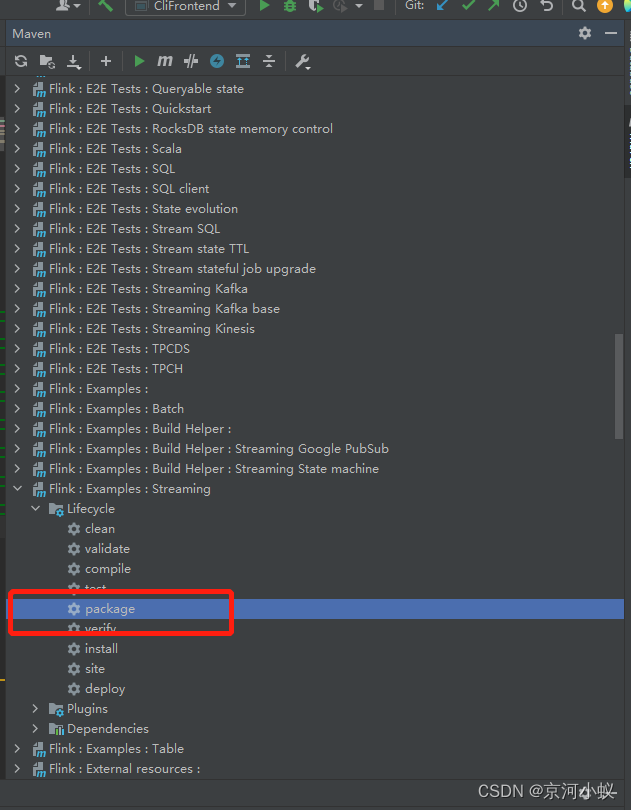

这里我们还需要一个 WordCount.jar 包,源码都有了,直接从源码打包一个出来,就是这么的任性了。

直接把 Flink : Examples : Streaming 模块打个包

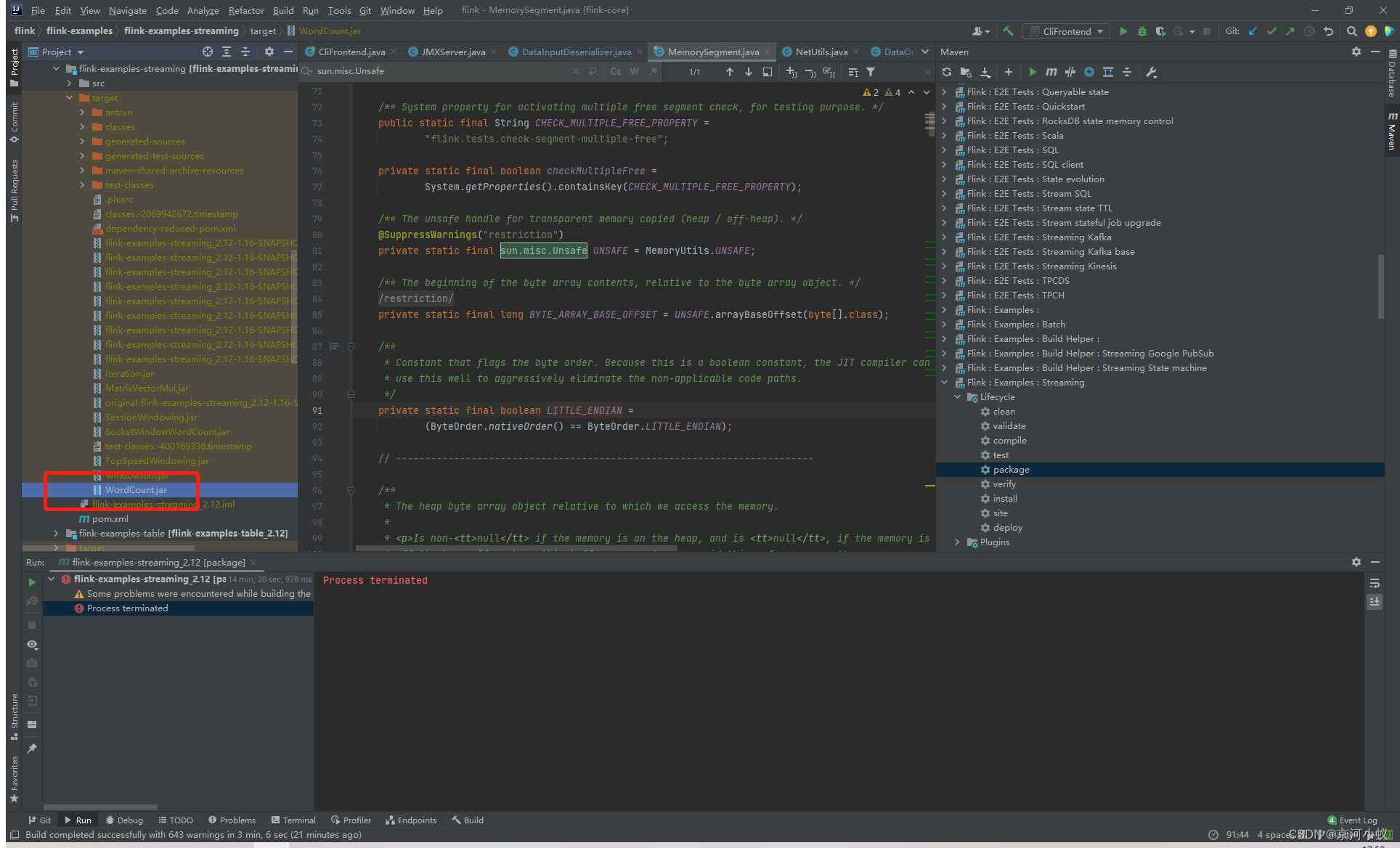

打完包之后,在 target 目录下,就会有一个 WordCount.jar 包了

填写传入参数

run C:\Users\18380\myself\coder\flink\flink-examples\flink-examples-streaming\target\WordCount.jar

一定要带上run哦,不然会有下面 提示信息

Valid actions are "run", "run-application", "list", "info", "savepoint", "stop", or "cancel".

然后再 Debug 看一下,应该会报一个错误,具体如下,这里是因为源码打包的时候缺少依赖,暂时不管,后面我会补上。

现在已经可以调试了,接下来开始逐步调试源码。

遇到的问题

虽然flink1.15官方所需的jdk版本是jdk1.11,但是现在flink-core源码里面还有部分代码使用了sun.misc.*,源码起初使用的jdk11,后来因为编译遇到sun.misc问题,又切换成了jdk1.8 ,等看到flink-core源码的时候,我会尝试着把那些引用sun.misc包的修改了。

3062

3062

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?