0.概述

线性回归属于机器学习中的回归问题,因为线性回归是根据数据预测一个准确的输出值,而不是分类结果。

注意:”机器学习教程之1”里的感知器讲的是分类问题,它是寻找超平面将数据分为正、负两类。

优点:非常简单、易于建模、应用广泛

缺点:

1.模型表示

数据集:数据的集合

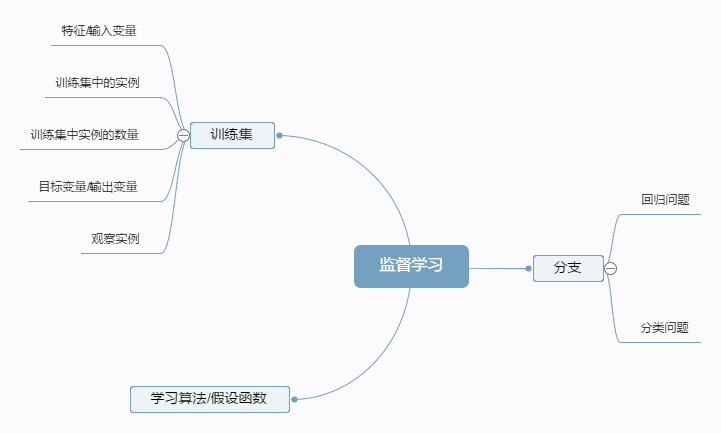

监督学习:从已有数据中发现关系:由多个输入映射一个输出。并用数学模型表示,将新数据用这数学模型运算得到新的输出。

监督学习的方式:回归问题和分类问题。

回归问题:根据之前的数据预测出一个准确的输出值。

训练集:在监督学习中的数据集

特征/输入变量:用x表示

目标变量/输出变量:用y表示

训练集中的实例:(x,y)

观察实例:第i个观察实例用(x(i),y(i))表示,注意(i)是上标

训练集中实例的数量:用m表示

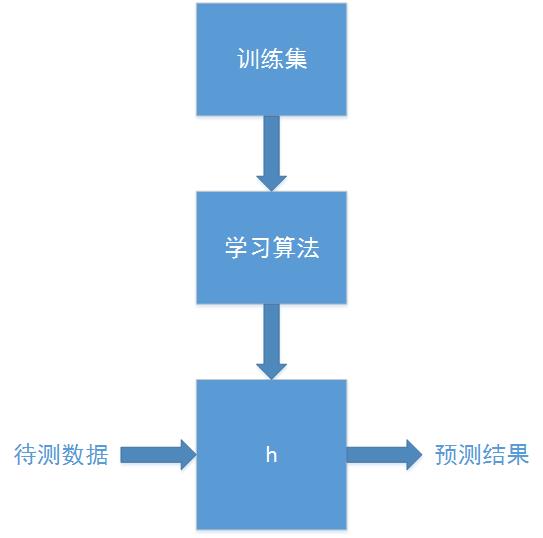

学习算法的解决方案或函数也称为假设(hypothesis):用h表示

监督学习完整流程如下图所示:

假设函数实例:

因为只含有一个特征/输入变量,因此这样的问题叫作单变量线性回归问题。

2.代价函数

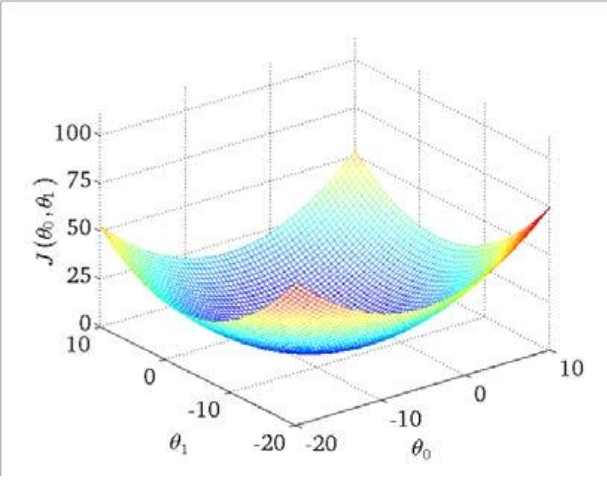

代价函数表示数据的理论值和实际值的拟合程度,代价函数越小,拟合度越高。

选择的参数决定了得到的直线相对于训练集的准确程度,模型所预测的值与训练集中实际值之间的差距叫建模误差(modeling error)(下图中蓝线所指):

代价函数/平方误差代价函数:

代价函数的作用是帮助寻找到最佳的假设函数,即找到上式的最小值,上式的代价函数对于大多数问题,特别是回归问题,是一个合理的选择。

代价函数的示意图如下:

3.梯度下降(gradient descent)

直接找到代价函数是困难。梯度下降是一个用来求函数最小值的算法,我们将使用梯度下降算法来求出代价函数的最小值。

批量梯度下降(batch gradient descent)算法公式为:

上式中的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5238

5238

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?