2024-10-10,由德国NCT/UCC Dresden、DKFZ Heidelberg等机构联合创建Multi-class Surgical Anatomy Dataset,通过使用解剖学感知的扩散模型,有效地解决了在生成过程中保持器官结构和纹理的挑战,为手术场景的语义分割和其他下游任务提供了宝贵的资源。

一、研究背景:

随着计算机辅助手术(CAS)的发展,对手术场景中解剖结构的准确识别和分割变得越来越重要。这不仅有助于提高手术的安全性和效率,还能为手术导航、动作识别和手术技能评估等下游任务提供支持。

目前遇到困难和挑战:

1、缺乏大规模、多样化且带有解剖标注的手术数据集,限制了深度学习模型在手术数据科学中的应用。

2、现有的图像生成方法在保持器官结构和纹理一致性方面存在挑战,尤其是在多类别器官的同时生成上。

3、医学专家标注多类别解剖数据集耗时且资源有限,导致公开的多类别解剖数据集数量有限。

数据集地址:手术图像处理数据集|计算机辅助手术数据集

二、让我们一起来看一下数据集

多类别手术解剖数据集(Multi-class Surgical Anatomy Dataset):一个通过解剖学感知的扩散模型合成的多类别手术数据集,包含了详细的解剖标注,用于提高手术场景的理解能力。数据集的特点在于其能够从真实的二进制数据集和模拟的手术掩模中生成多类别数据集,同时在生成的图像中保持了器官的形状和纹理一致性。

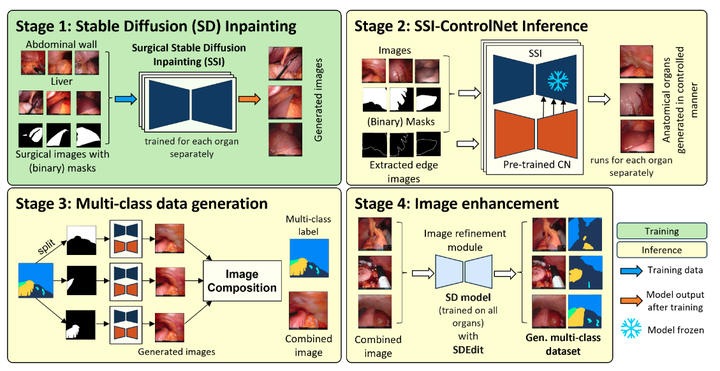

数据集的构建过程包括训练特定器官的扩散模型,使用预训练的ControlNet进行推理,以及通过图像融合方法生成包含多种解剖结构的多类别手术图像。

研究人员可以使用该数据集来训练和评估手术场景分割模型,以及进行其他下游手术任务的研究。

基准测试 :

在基准测试中,该数据集生成的图像在图像质量和下游分割任务上表现出色,与真实图像结合使用时,分割分数提高了15%。

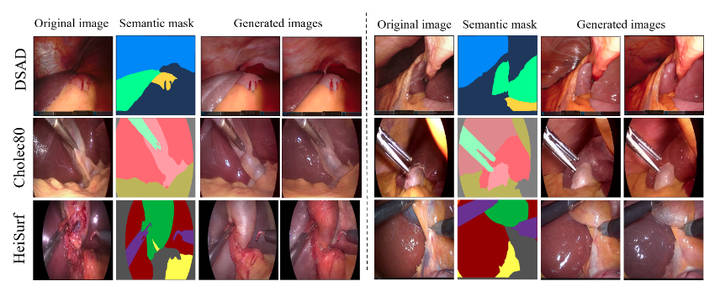

使用我们的扩散方法为三个不同的手术数据集(由左侧名称表示)生成的多类手术图像(生成图像列)及其相应的语义掩码。我们的方法可以使用分割掩码作为掩码和调节信号来生成逼真和多样化的器官纹理。

生成多类数据集的扩散方法概述。阶段- 1 涉及分别使用每个器官的真实图像和蒙版来训练 SD 修复模型。在 stage- 2 ,将预先训练的 ControlNet 插入 SSI 模型 (SSI-CN) 中,以使用从分割掩码中提取的边缘精确生成每个解剖结构。舞台中的图像构图- 3 包括从生成的图像中切下每个器官并将它们组合在一起

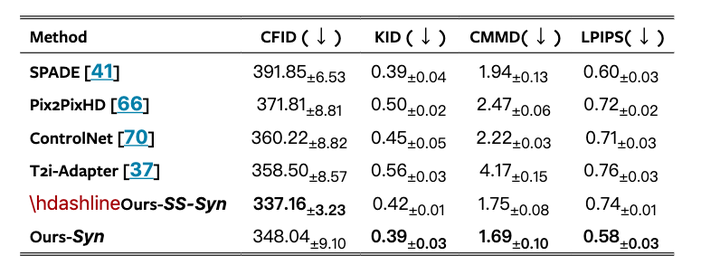

CholecSeg8K 数据集的图像质量比较。我们的合成数据集显示出比 GAN 或基于扩散的方法更好的质量。

三、展望数据集的场景应用:

外科医生的培训和技能评估大多是通过实地手术观摩和资深医生的经验传授来进行的。年轻医生们需要在手术室里跟着师傅,一点一滴地学习各种手术技巧。但是,这样的学习方式有很多局限性。

首先,手术室里的空间有限,不是所有的实习医生都能有机会近距离观察每一次手术。其次,每个医生的手术风格都不尽相同,实习医生很难从一位医生那里学到所有的东西。而且,真实的手术过程中涉及到患者安全,不可能让实习医生随意尝试。

现在,有了这个多类别手术解剖数据集,情况就有所改变。

这个数据集通过扩散模型合成了大量逼真的手术场景图像,这些图像包含了各种解剖结构,就像是真实手术中的快照一样。利用这些数据,我们训练出一个智能系统,专门用来评估外科医生的技能。

想象一下,现在有一个虚拟现实的手术训练室。实习医生戴上VR头盔,就仿佛置身于一个真实的手术室中。他们可以看到高清的解剖图像,包括各种器官和组织。智能系统会根据这些合成的图像,生成各种手术场景,让实习医生进行模拟手术。

在这个过程中,智能系统会密切观察实习医生的每一个动作。比如,当实习医生在模拟切除胆囊时,系统会评估他们的手部移动是否准确,切割的路径是否符合最佳实践,甚至还能判断他们使用的力度是否恰到好处。所有这些数据都会被记录下来,用于反馈和改进。

最棒的是,这个系统可以提供个性化的反馈。如果实习医生在某个特定的手术步骤上遇到了困难,系统可以提供针对性的建议,甚至可以生成更多类似的场景,让他们多加练习。而且,由于这些图像是合成的,实习医生可以大胆尝试,不必担心造成真正的伤害。

这样的话,外科医生的培训就变得更加高效、安全和个性化。这样的培训方式,不仅让年轻医生们受益,资深医生则可以利用这个系统来更客观地评估和指导他们的进步。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?