多语言预训练模型在机器翻译中的应用

机器翻译路线图:从统计机器翻译发展到多语言神经机器的翻译。

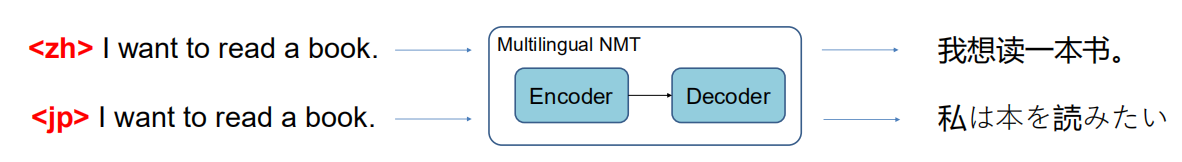

多语言神经机器的翻译:

训练:

多语言语言对的组合

根据数据大小抽样训练数据

模型构建:

一个统一的模型:所有语言共享相同的参数

跨语言可变性:高资源语言可以帮助低资源语言

在输入前准备一个语言标记:指示要翻译的目标语言

预训练模型:DeltaLM

一种预先训练好的用于生成和平译的编码器-解码器模型。

DeltaLM:解码器作为任务层

我们可以通过编码器-解码器的预训练来统一两部分。

如何初始化解码器?

解码器的结构不同于编码器,解码器的初始化研究不足。

要预训练编码器-解码器的哪些任务?

大多数情况下都保留了预先训练好的编码器的能力

有效地利用双语数据。

DeltaLM:初始化

一种由预训练好的译码器完全初始化的新型交错解码器

香草解码器:

一个self-attn层,一个Cross-attn层,一个FFN层。

初始化:

预训练的编码器→Self-attn+FFN

随机初始化Cross-attn

结果:

与预先训练好的编码器不一致(FFN在attn之后)

我们的交错解码器:

一个atten后接一个FFN

以交错的方式初始化Self-attn/Cross-attn

预训练模型的奇数层使用→ Self-attn + FFN

预训练模型的偶数层使用→Cross-attn + FFN

充分使用预先训练好的编码器的权重

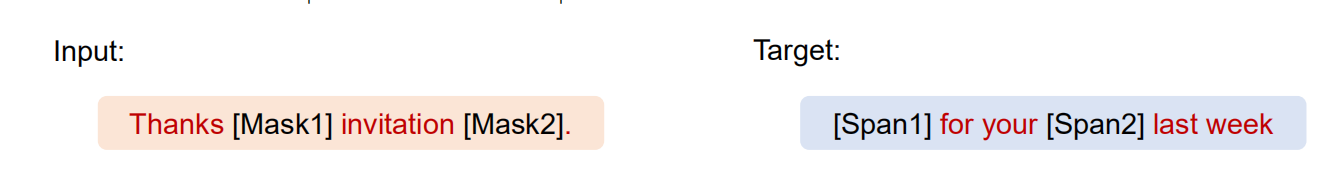

DeltaLM:预训练任务

一个新的预训练任务,利用单语文本+双语文本。

根据输入的文档重建文本跨度:

根据输入的掩码翻译对预测文本跨度:

DeltaLM for MNMT

对于MNMT,我们可以直接微调DeltaLM:

实验:多语言机器翻译

DeltaLM在X->E和E->X翻译上均达到SOTA结果:

实验:跨语言总结

DeltaLM与mt5相比,具有竞争力。

维基语言数据集:

输入:西班牙语、俄语、越南语、土耳其语文件

输出:英文摘要

实验:数据到文本的生成

DeltaLM的性能优于mt5XL(3.7B)。

实验:多语言的语言生成

DeltaLM在不同的任务/语言中实现了一致的改进。

问题生成(XQG):

输入:中文答案及相应文件

输出:中文问题

抽象的总结(XGiga):

输入:法语文件

输出:法语摘要

实验:零镜头跨语言传输

DeltaLM对NLG具有良好的零镜头传输能力。

抽象总结(XGiga):

训练:

英文文件→英文摘要

测试:

法语文件→法语摘要

中文文件→中文摘要

NMT的零射跨语言传输

训练:

一种语言对,例如,德语->英语

模型:

一个统一的MT模型,具有跨语言可变性

测试(0-shot):

没见过的语言,如日语->英语

两阶段微调方法

阶段1:

冻结编码器和解码器嵌入:保留预训练模型的跨语言可转移性

微调解码器层:将解码器自适应到预先训练好的编码器中

阶段2:

微调编码器层和解码器:提高翻译质量,我们的初步实验发现,这种策略是最好的。

移除self-attn的剩余连接:使编码器的输出具有更少的位置和语言特定性。

实验细节及结果

数据集:

在去并行数据集上进行训练:WMT19 43M并行数据

对多对英语的语言对进行测试:德语组、罗曼语组、斯拉夫语组、乌拉尔语组和突厥语组,德语(De)、荷兰语(Nl)、西班牙语(Es)、罗马尼亚语(Ro)、芬兰语(Fi)、拉脱维亚语(Lv)、土耳其语(Tr)、俄语(Ru)、波兰语(Pl)。

实验结果:

可变性vs语言相似性

使用不同语言进行训练:德语(De)、西班牙语(Es)、印地语(Hi)。

对不同语言族系的测试:德语族系(De、Nl)、罗马族系(Es、Ro、It)、印度-雅利安人族系(Hi、Ne、Si、Gu)。

NMT模型的传输能力在相似的语言上比在遥远的语言上更有利。

在只有一个语言对的语言系中转移的预期结果。

结论

预训练的语言模型有利于机器翻译。

多语言神经机器翻译的监督学习

零射的跨语言转换

DeltaLM具有良好的跨语言传输和语言生成能力,以帮助机器翻译。

450

450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?