点击上方“AI公园”,关注公众号,选择加“星标“或“置顶”

作者:Zixuan Zhang

编译:ronghuaiyang

导读

神经网络过参数化的一个很好的应用。

基本思想

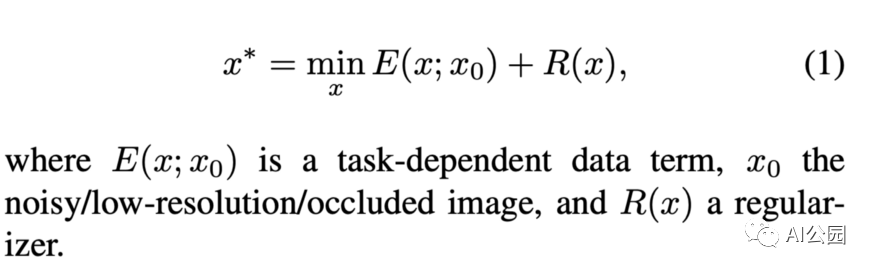

图像重建是一项具有挑战性的学习任务,因为没有人知道原始图像的样子。因此,似乎唯一实用和合乎逻辑的方法是发展一些关于图像的先验知识,并选择最大概率(最大先验估计)的重建。例如,我们希望在MNIST数据集上训练的模型能够开发一些关于手写数字的先验知识,从而可以用于恢复模糊的数字。

我看过一篇论文:Deep Image Prior,发表于2017年。链接:https://sites.skoltech.ru/app/data/uploads/sites/25/2018/04/deep_image_prior.pdf

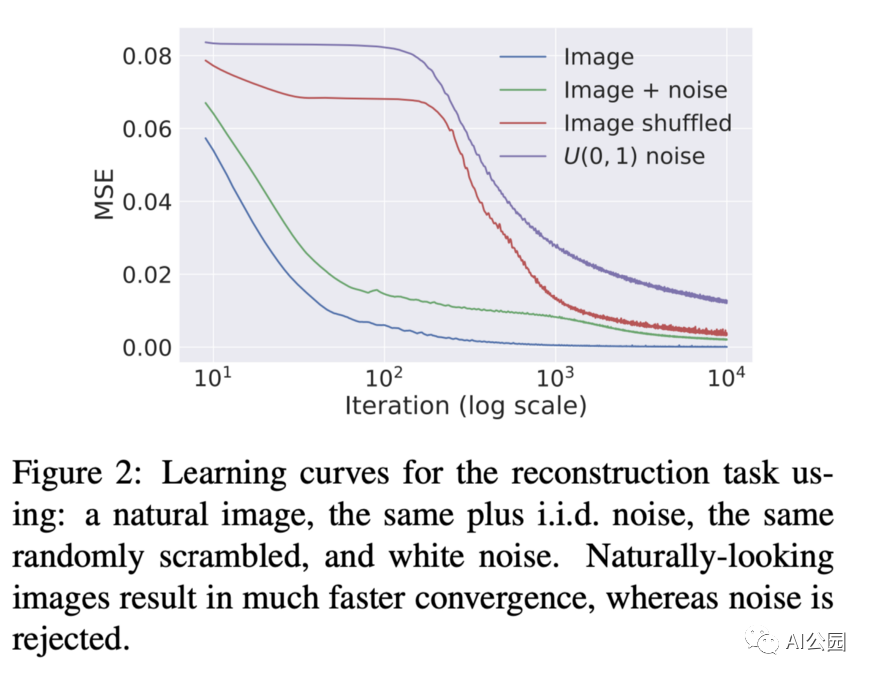

研究人员发现深度CNN有一个有趣的特性 —— 随机初始化的网络比纯噪声能更快的拟合自然图像。换句话说,CNN对自然图像有自然的“优先”偏好,可以利用这一点在没有任何数据的情况下去除图像中的人工痕迹!

为了对图像去噪(去除水印,修复等),随机初始化一个CNN并将图像输入到模型中(input=image, output=image,就像一个自动编码器)。不出所料,模型逐渐达到零训练损失(参数数量>>图像中的像素数量)。然而,当训练被适当地提前停止时,网络产生了去噪的图像。

结果

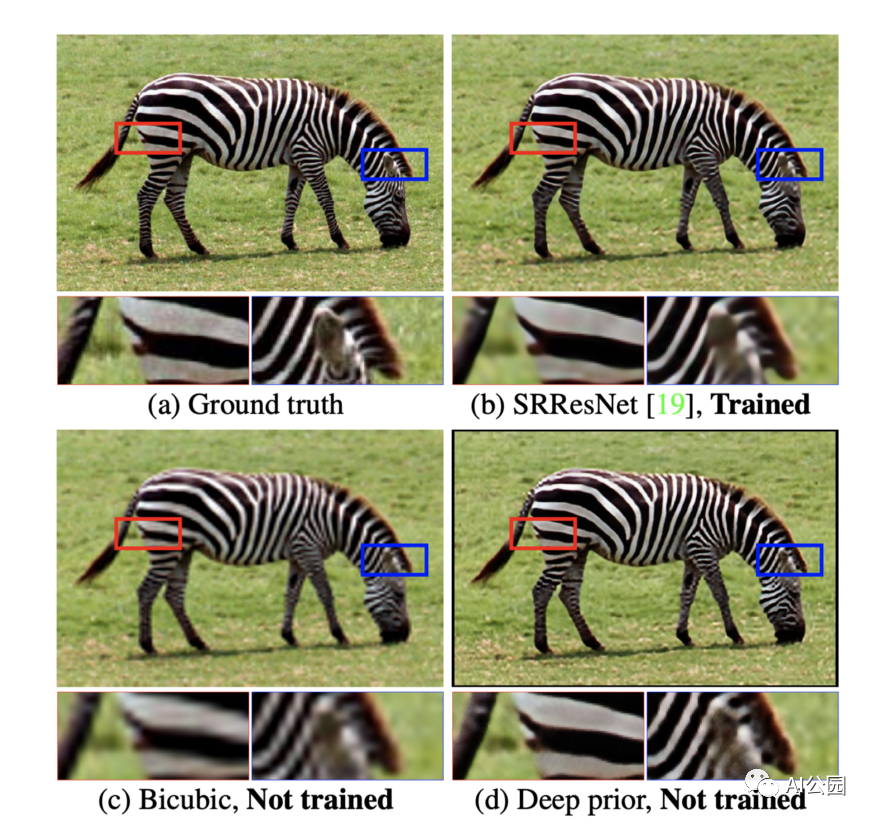

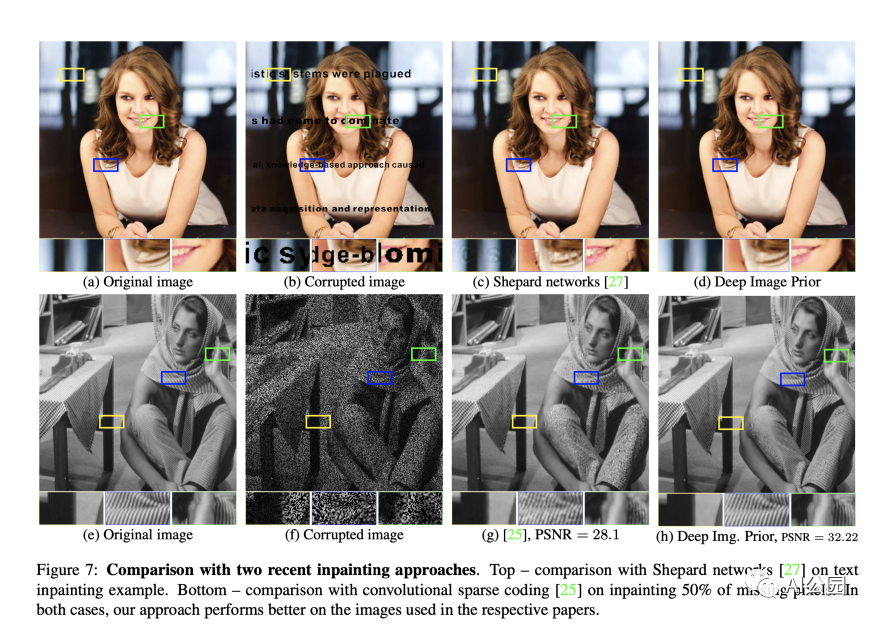

图像重建可以采取多种形式 —— 去噪、修复恢复、超分辨率等。研究人员证明,神经网络结构在无训练的图像重建中起着重要的作用。

当选择了合适的网络架构时,DIP会产生惊人的重建性能,可以匹配甚至超过监督模型:

一些思考

DIP是另一个证明过度参数化(重量数据)的力量被完全低估的证据。在我的ML课上,我的教授警告我们不要在“小”数据集上使用巨型模型,因为可能会出现过拟合。然而,过度参数化的网络有许多有趣的特性可供利用! 如果我们可以使用一个未经训练的模型对图像去噪,谁知道一个训练好的模型有无数参数可以做什么呢?

—END—

英文原文:https://towardsdatascience.com/paper-tuesday-image-reconstruction-without-data-c2acdba1aa53

请长按或扫描二维码关注本公众号

喜欢的话,请给我个在看吧!

741

741

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?