1.introduction

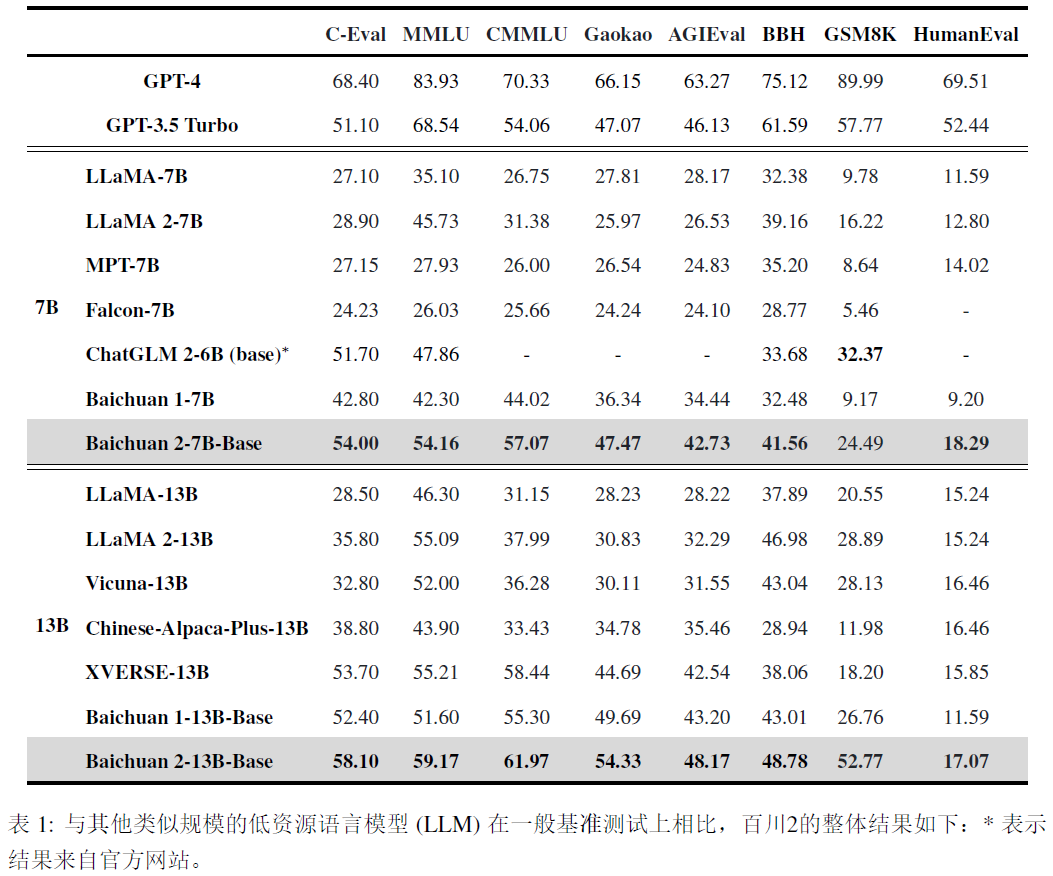

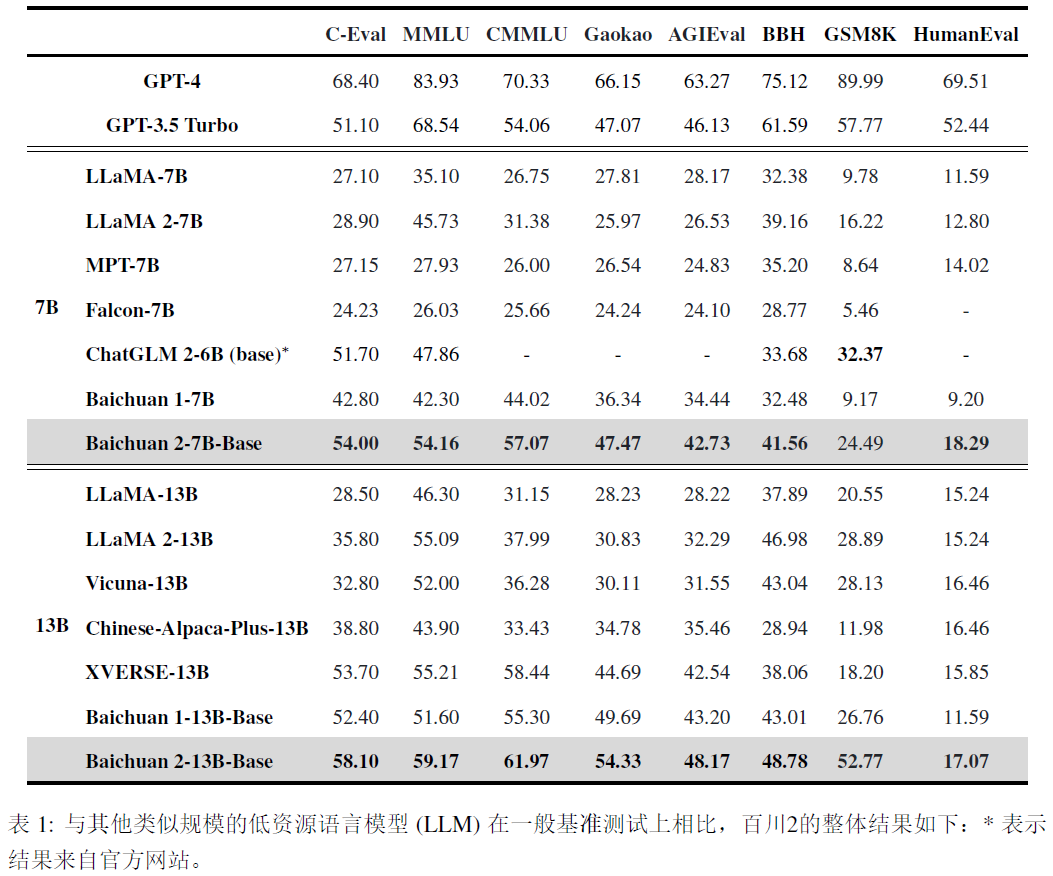

baichuan2基于2.6万亿个token进行训练。

2.pre-training

2.1 pre-training data

数据处理:关注数据频率和质量。数据频率依赖于聚类和去重,构建了一个支持LSH型特征和稠密embedding特征的大规模去重和聚类系统,单个文档、段落和句子被去重评分,这些评分然后用于预训练中的数据采样。

2.3 Tokenizer

分词器需要平衡两个关键因素:高压缩率以实现高效的推理,并适当大小的词汇表以确保每个词embedding的充

1.introduction

baichuan2基于2.6万亿个token进行训练。

2.pre-training

2.1 pre-training data

数据处理:关注数据频率和质量。数据频率依赖于聚类和去重,构建了一个支持LSH型特征和稠密embedding特征的大规模去重和聚类系统,单个文档、段落和句子被去重评分,这些评分然后用于预训练中的数据采样。

2.3 Tokenizer

分词器需要平衡两个关键因素:高压缩率以实现高效的推理,并适当大小的词汇表以确保每个词embedding的充

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?