文件读取解析

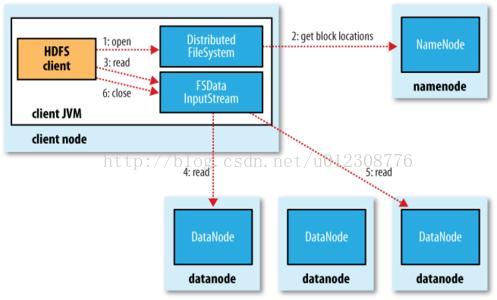

为了了解客户端及与之交互的HDFS、namenode和datanode之间的数据流是什么样的,我们可以参考图1,该图显示了在读取文件时一些事件的主要顺序。

图1 客户端读取HDFS中的数据

1. 客户端通过调用FileSystem对象的open()方法来打开希望读取的文件,对于HDFS来说,这个对象是分布式文件系统(图1的步骤1)的一个实例。

2. DistributedFileSystem通过使用RPC来调用namenode,以确定文件起始块的位置(步骤2)。对于每一块,namenode返回存有该块复本的datanode地址。此外,这些datanode根据他们与客户端的距离来排序。如果该客户端本身就是一个datanode,并保存有相应数据块的一个复本时,该节点将从本地datanode中读取数据。

3. 接着,客户端对这个输入流调用read()方法(方法3)。存储这文件起始块的datanode地址的DFSInputStream随即连接距离最近的datanode。通过对数据流反复调用read()方法,可以将数据从datanode传输到客户端(步骤4)。 达到块的末端时,DFSInputStream会关闭与该datanode的连接,然后寻找下一块的最佳datanode(步骤5)。客户端只需要读取连续的流,并且对于客户端都是透明的。

4. 客户端从流中读取数据时,块是按照打开DFSInputStream与datanode新建连接的顺序读取的。它也需要询问namenode来检索下一批所需块的datanode的位置。一旦客户端完成读取,就对FSDataInputStream调用close()方法(步骤6)。

在读取数据的时候,如果DFSInputStream在与datanode通信时遇到错误,他便会尝试从这个块的另外一个最近邻datanode读取数据。它也会记住那个故障datanode,以保证以后不会反复读取该节点上的后续的块。 DFSInputStream也会通过校验和确认从datanode发来的数据是否完整。如果发现一个损坏的块,它就会在DFSInputStream试图从其他datanode读取一个块的复本之前通知namenode。

这个设计的一个重点是,namenode告知客户端每个块中最佳的datanode,并让客户端直接联系该datanode且读取数据。由于数据分散在集群中的所有datanode,所以这种设计能使HDFS可扩展到大量的并发客户端,而namenode仅需要相应块位置的请求(这些信息存储在内存中,因而非常高效)。

文件写入解析

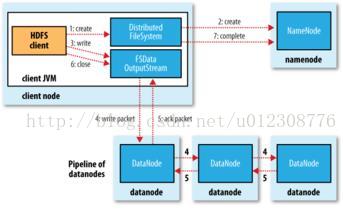

接下来我们看看文件是如何写入HDFS的。我们要考虑的情况是如何创建一个新文件,并把数据写入该文件,最后关闭该文件。如图2。

客户端通过对DistributedFileSystem对象调用create() 函数来创建文件(步骤1)。DistributedFileSystem对namenode创建一个RPC调用,在文件系统的命名空间中创建一个新文件,此时该文件还没有相应的数据块(步骤2)。namenode执行各种检查,确保这个文件不存在,并且客户端有创建该文件的权限。如果这些检查均通过,namenode就会为创建新文件记录一条记录;否则,文件创建失败并向客户端抛出一个IOException异常。DistributedFileSystem向客户端返回一个FSDataOutputStream对象,由此客户端可以开始写入数据。

在客户端写入数据时(步骤3),DFSOutputStream将它分成一个个的数据包,并写入内部队列,称为"数据队列" (data queue)。DataStreamer处理数据队列,它的责任是根据datanode列表来要求namenode分配适合的新块来存储数据备份。这一组datanode构成一个管线---我们假设复本数为3,所以管线中有3个节点。DataStreamer将数据包流式传输到管线中的第一个datanode,该datanode存储数据包并将它发送到管线中的第二个datanode。同样的,第二个datanode存储该数据包并且发送给管线中的第三个datanode(步骤4)。

DFSOutputStream也维护着一个内部数据包队列来等待datanode的收到确认回执,成为"确认队列"(ack queue)。当收到管道中的所有datanode确认信息后,该数据包才会从确认队列中删除(步骤5)。

客户端完成数据的写入后,会对数据流调用close()方法(步骤6)。该操作将剩余的所有数据包写入datanode管线中,并在联系namenode且发送文件写入完成信号前,等待确认(步骤7)。

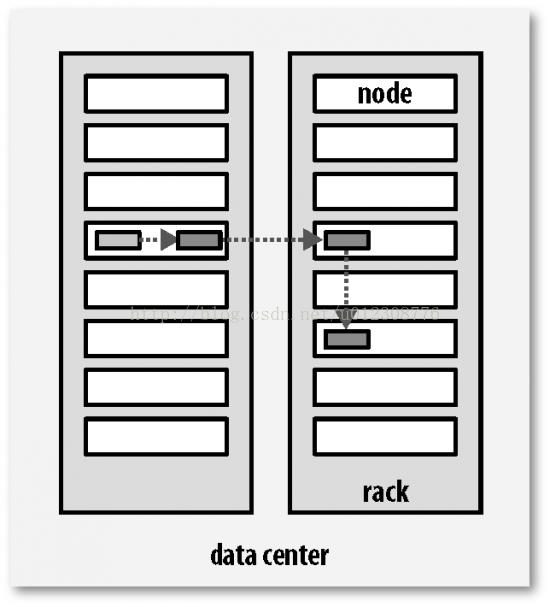

复本的布局

hadoop的默认布局策略是在运行客户端的节点上放第1个复本(如果客户端运行在集群之外,就随机选择一个节点,不过系统会避免挑选那些存储太满或太忙的节点)。第2个复本放在与第一个不同且随机另外选择的机架中节点上。第3个复本放在与第2个复本放在相同的机架,且随机选择另一个节点。如图3。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?