在以上的概念之中实际上只有以下几个名词:

· HDFS:分布式文件系统,是负责信息保存的操作;

· 有一个最为重要的概念就是所有的数据(默认)会保存有三份。

· 低廉硬件:512M内存可以跑,在整个的大数据的集群设计里面,可以不去使用小型机来进行配置,也可以使用一些便宜的电脑。

在Linux操作系统下:

为了保证整个的Hadoop可以正常执行,需要考虑以下几个问题:

· 你的主机名称是什么,如果需要修改主机名称,则执行:vim /etc/hostname,本次设置的主机名称为:“hadoop-alone”,如果修改完成主机名称之后请使用“reboot”重新启动,否则无效;

· 在Hadoop操作的过程之中必须有一个前提:你的IP地址不允许发生变更,一旦有变更,配置失效;

1、 配置hosts文件,设置ip地址与主机名称的映射,输入:vim /etc/hosts

当前ip hadoop-alone2、配置SSH连接(免登陆密码)

rm -r ~/.ssh

ssh-keygen -t rsa3、将生成ssh的公钥信息保存在授权文件之中:

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys4、安装Hadoop

对于Hadoop而言,其安装的过程实际上是比较简单,

①使用wget取得:wget http://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.7.3/hadoop-2.7.3.tar.gz

②如果无法通过wget取得相应开发包则可以通过ftp上传取得,将上传后的hadoop开发包文件解压缩。

本次测试安装的路径为:/usr/local/hadoop

5、修改环境属性将hadoop主目录以及相关的可执行目录配置到系统之中;

vim /etc/profile;

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:bin:$HADOOP_HOME/bin: $HADOOP_HOME/sbin:修改保存后退出,并让配置立即生效

6、编辑Hadoop配置文件hadoop-env.sh;

export JAVA_HOME=/usr/local/jdk

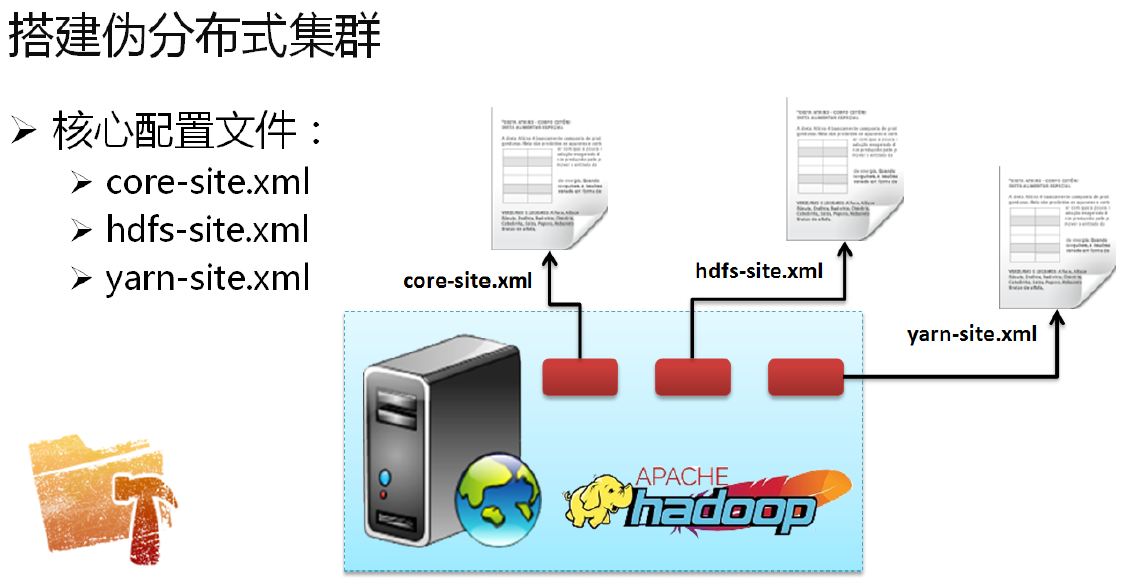

7、修改“core-site.xml”文件,该文件作为整个的Hadoop的核心配置文件:

· 建立Hadoop临时的保存路径:mkdir -p /usr/data/hadoop/tmp;

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/data/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop-alone:9000</value>

</property>

</configuration>本配置文件的主要目的是设置hadoop的临时保存目录,但是这个目录绝对不允许使用“/tmp”目录,因为这个目录会被自动清空,一旦清空了你的配置就完了;

“fs.defaultFS”描述的是默认的文件系统的操作路径:

修改“hdfs-site.xml”文件,进行存储的配置;

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///usr/data/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///usr/data/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop-alone:50070</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop-alone:50090</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>在此配置文件之中有如下几个重要的项:

· “dfs.replication”:文件保存的副本数量,副本保存在DataNode之中,现在只有一个主机,所以只存1份;

· “dfs.namenode.name.dir”:保存namenode节点信息的相关操作;

· “dfs.datanode.data.dir”:保存真实数据;

· “dfs.namenode.http-address”:Hadoop启动之后会自动启动有一个HTTP服务,通过浏览器可以访问;

· “dfs.namenode.secondary.http-address”:SecondaryNameNode节点的HTTP访问;

· “dfs.permissions”:表示的是hdfs操作权限,设置为false表示不验证。

修改“yarn-site.xml”文件;

<configuration>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>hadoop-alone:8033</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce_shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>hadoop-alone:8025</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>hadoop-alone:8030</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>hadoop-alone:8050</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>hadoop-alone:8030</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>hadoop-alone:8088</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.https.address</name>

<value>hadoop-alone:8090</value>

</property>

</configuration>修改slaves配置信息

hadoop/etc/hadoop/slaves

hadoop-alone8、此时相关的配置环境配置完成,随后需要对namenode节点进行格式化处理;

hdfs namenode -format提示 Exiting with status 0 则表示配置成功

如果现在服务已经启动,则可以在外部通过浏览器的模式来观察,连接地址:http:// 服务器IP :50070

1369

1369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?