Partitioner编程

Partition简介

shuffle是通过分区partitioner 分配给Reduce的 一个Reducer对应一个记录文件

Partitioner是shuffle的一部分

partitioner执行时机:在mapper执行完成,Reducer还没有执行的时候,mapper的输出就是partitioner的输入 即<k2,v2>

partitioner 分区主要是用来提高效率的 例如从全国基站的数据中查找北京基站的数据,如果计算时不分区全国的数据都放在一起,查询的时候就相当于全表扫描 效率非常低,如果在第一次进行Mapreducer计算的时候按照省市进行分区,每个城市的基站数据都存储在对应的每个文件,那么下次再进行查询的时候直接从北京分区里直接查找 效率很高。

分区的依据是具体业务需求,可以按照省市分区,时间进行分区等。

如果不手动进行分区,Hadoop有一个默认的分区规则

Partitioner是shuffle的一部分

partitioner执行时机:在mapper执行完成,Reducer还没有执行的时候,mapper的输出就是partitioner的输入 即<k2,v2>

partitioner 分区主要是用来提高效率的 例如从全国基站的数据中查找北京基站的数据,如果计算时不分区全国的数据都放在一起,查询的时候就相当于全表扫描 效率非常低,如果在第一次进行Mapreducer计算的时候按照省市进行分区,每个城市的基站数据都存储在对应的每个文件,那么下次再进行查询的时候直接从北京分区里直接查找 效率很高。

分区的依据是具体业务需求,可以按照省市分区,时间进行分区等。

如果不手动进行分区,Hadoop有一个默认的分区规则

Partitioner是partitioner的基类,如果需要定制partitioner也需要继承该类。HashPartitioner是mapreduce的默认partitioner。计算方法是which reducer=(key.hashCode() & Integer.MAX_VALUE) % numReduceTasks,得到当前的目的reducer。

Partitioner原理

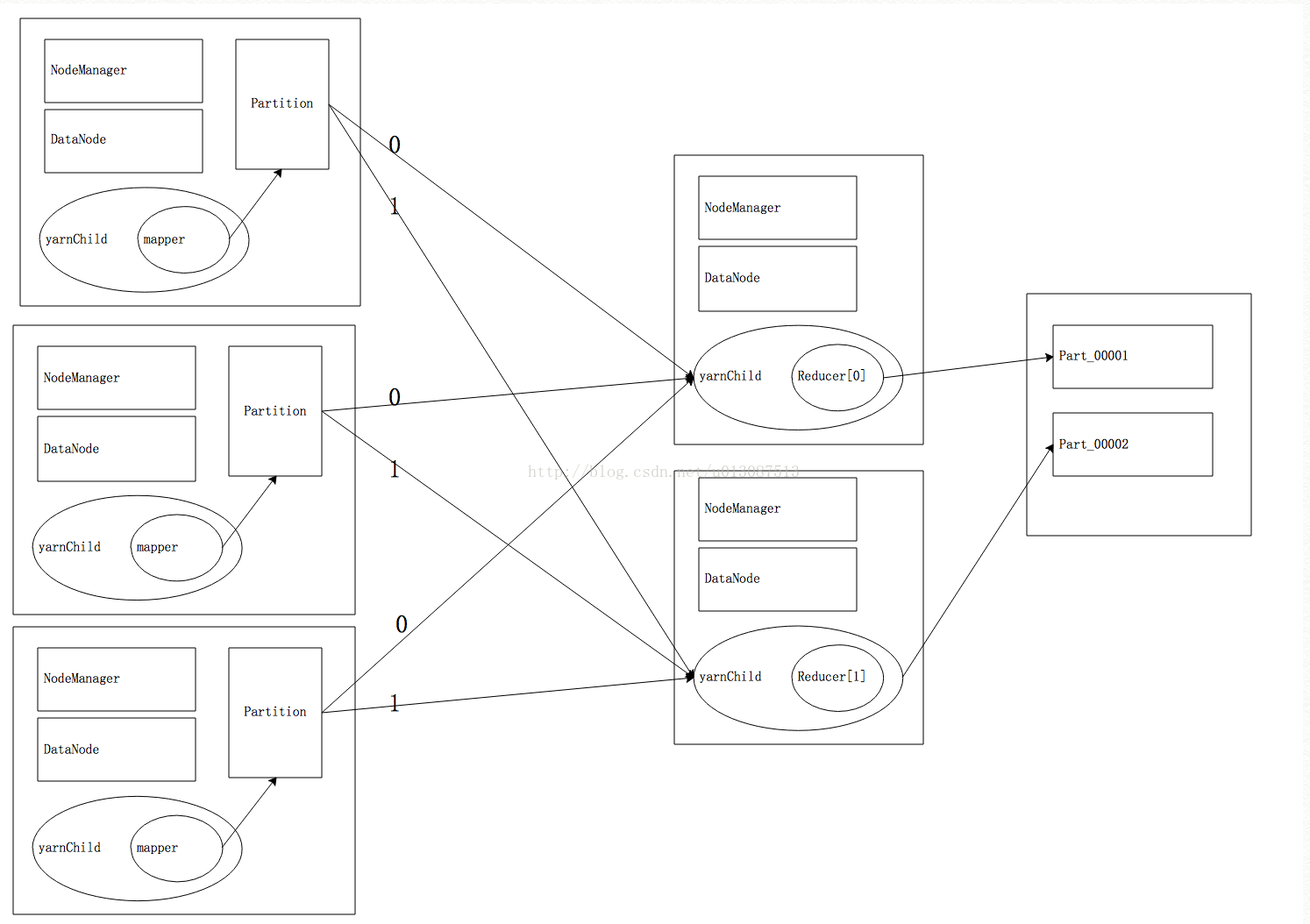

以上流程省略了shuffle的过程

DataNode在此处用于下载jar

NodeManager用于运行Yarn 由YarnChild运行Mapper或Reducer

当启动一个Reducer时会分配一个分区号 默认是按数字分区

Partitioner是Shuffle的一部分,当Partition的返回值是N时 会将shuffle的结果输出给对应的分区号为N的Reducer

一个Reducer对应一个分区文件 Reducer计算完毕后就会按照分区号写入对应的分区文件

DataNode在此处用于下载jar

NodeManager用于运行Yarn 由YarnChild运行Mapper或Reducer

当启动一个Reducer时会分配一个分区号 默认是按数字分区

Partitioner是Shuffle的一部分,当Partition的返回值是N时 会将shuffle的结果输出给对应的分区号为N的Reducer

一个Reducer对应一个分区文件 Reducer计算完毕后就会按照分区号写入对应的分区文件

Partitioner编程

① 先分析一下具体的业务逻辑,确定大概有多少个分区

② 首先书写一个类,它要继承org.apache.hadoop.mapreduce.Partitioner这个类

③ 重写public int getPartition这个方法,根据具体逻辑,读数据库或者配置返回相同的数字

④ 在main方法中设置Partioner的类,job.setPartitionerClass(DataPartitioner.class);

⑤ 设置Reducer的数量,job.setNumReduceTasks(6);

② 首先书写一个类,它要继承org.apache.hadoop.mapreduce.Partitioner这个类

③ 重写public int getPartition这个方法,根据具体逻辑,读数据库或者配置返回相同的数字

④ 在main方法中设置Partioner的类,job.setPartitionerClass(DataPartitioner.class);

⑤ 设置Reducer的数量,job.setNumReduceTasks(6);

实例如下:

日志数据:HTTP_20130313143750.dat

1363157985066 13726230503 00-FD-07-A4-72-B8:CMCC 120.196.100.82 i02.c.aliimg.com 24 27 2481 24681 200

1363157995052 13826544101 5C-0E-8B-C7-F1-E0:CMCC 120.197.40.4 4 0 264 0 200

1363157991076 13926435656 20-10-7A-28-CC-0A:CMCC 120.196.100.99 2 4 132 1512 200

1363154400022 13926251106 5C-0E-8B-8B-B1-50:CMCC 120.197.40.4 4 0 240 0 200

1363157993044 18211575961 94-71-AC-CD-E6-18:CMCC-EASY 120.196.100.99 iface.qiyi.com 视频网站 15 12 1527 2106 200

1363157995074 84138413 5C-0E-8B-8C-E8-20:7DaysInn 120.197.40.4 122.72.52.12 20 16 4116 1432 200

1363157993055 13560439658 C4-17-FE-BA-DE-D9:CMCC 120.196.100.99 18 15 1116 954 200

1363157995033 15920133257 5C-0E-8B-C7-BA-20:CMCC 120.197.40.4 sug.so.360.cn 信息安全 20 20 3156 2936 200

1363157983019 13719199419 68-A1-B7-03-07-B1:CMCC-EASY 120.196.100.82 4 0 240 0 200

1363157984041 13660577991 5C-0E-8B-92-5C-20:CMCC-EASY 120.197.40.4 s19.cnzz.com 站点统计 24 9 6960 690 200

1363157973098 15013685858 5C-0E-8B-C7-F7-90:CMCC 120.197.40.4 rank.ie.sogou.com 搜索引擎 28 27 3659 3538 200

1363157986029 15989002119 E8-99-C4-4E-93-E0:CMCC-EASY 120.196.100.99 www.umeng.com 站点统计 3 3 1938 180 200

1363157992093 13560439658 C4-17-FE-BA-DE-D9:CMCC 120.196.100.99 15 9 918 4938 200

1363157986041 13480253104 5C-0E-8B-C7-FC-80:CMCC-EASY 120.197.40.4 3 3 180 180 200

1363157984040 13602846565 5C-0E-8B-8B-B6-00:CMCC 120.197.40.4 2052.flash2-http.qq.com 综合门户 15 12 1938 2910 200

1363157995093 13922314466 00-FD-07-A2-EC-BA:CMCC 120.196.100.82 img.qfc.cn 12 12 3008 3720 200

1363157982040 13502468823 5C-0A-5B-6A-0B-D4:CMCC-EASY 120.196.100.99 y0.ifengimg.com 综合门户 57 102 7335 110349 200

1363157986072 18320173382 84-25-DB-4F-10-1A:CMCC-EASY 120.196.100.99 input.shouji.sogou.com 搜索引擎 21 18 9531 2412 200

1363157990043 13925057413 00-1F-64-E1-E6-9A:CMCC 120.196.100.55 t3.baidu.com 搜索引擎 69 63 11058 48243 200

1363157988072 13760778710 00-FD-07-A4-7B-08:CMCC 120.196.100.82 2 2 120 120 200

1363157985066 13726238888 00-FD-07-A4-72-B8:CMCC 120.196.100.82 i02.c.aliimg.com 24 27 2481 24681 200

1363157993055 13560436666 C4-17-FE-BA-DE-D9:CMCC 120.196.100.99 18 15 1116 954 200这种映射关系在实际开发中一般存储在数据库中,通过web项目的Service查询数据库得到

需求:统计每个手机号的上行总流量,下行总流量,总流量,并按照手机号进行分区存储。

代码如下:

DataBean(自定义Bean)

package liuxun.hadoop.mr.dc;

import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException;

import org.apache.hadoop.io.Writable;

public class DataBean implements Writable {

private String tel;

private long upPayLoad;

private long downPayLoad;

private long totalPayLoad;

public DataBean() {

}

public DataBean(String tel, long upPayLoad, long downPayLoad) {

this.tel = tel;

this.upPayLoad = upPayLoad;

this.downPayLoad = downPayLoad;

this.totalPayLoad = upPayLoad + downPayLoad;

}

@Override

public String toString() {

return this.upPayLoad + "\t" + this.downPayLoad + "\t" + this.totalPayLoad;

}

public void readFields(DataInput in) throws IOException {

this.tel = in.readUTF();

this.upPayLoad = in.readLong();

this.downPayLoad = in.readLong();

this.totalPayLoad = in.readLong();

}

// 注意两点:写入的顺序和写入的类型

public void write(DataOutput out) throws IOException {

out.writeUTF(tel);

out.writeLong(upPayLoad);

out.writeLong(downPayLoad);

out.writeLong(totalPayLoad);

}

public String getTel() {

return tel;

}

public void setTel(String tel) {

this.tel = tel;

}

public long getUpPayLoad() {

return upPayLoad;

}

public void setUpPayLoad(long upPayLoad) {

this.upPayLoad = upPayLoad;

}

public long getDownPayLoad() {

return downPayLoad;

}

public void setDownPayLoad(long downPayLoad) {

this.downPayLoad = downPayLoad;

}

public long getTotalPayLoad() {

return totalPayLoad;

}

public void setTotalPayLoad(long totalPayLoad) {

this.totalPayLoad = totalPayLoad;

}

}

DataCountPartition (编写计算模型)

package liuxun.hadoop.mr.dc;

import java.io.IOException;

import java.util.HashMap;

import java.util.Map;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Partitioner;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.map

本文详细探讨了Hadoop MapReduce中的关键概念,包括Partitioner的工作原理,如何进行Partitioner编程,以及Combiner在优化MapReduce性能中的作用。还介绍了Shuffle阶段的流程,特别是默认的分区规则和从Hadoop1.0到Hadoop2.0的演进。最后,通过实例展示了如何利用MR实现倒排序索引。

本文详细探讨了Hadoop MapReduce中的关键概念,包括Partitioner的工作原理,如何进行Partitioner编程,以及Combiner在优化MapReduce性能中的作用。还介绍了Shuffle阶段的流程,特别是默认的分区规则和从Hadoop1.0到Hadoop2.0的演进。最后,通过实例展示了如何利用MR实现倒排序索引。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1275

1275

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?