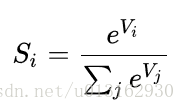

Softmax在机器学习中有着非常广泛的应用,他计算简单而且效果显著。

假设有两个数a和b,且a>b > c

如果取max,结果是a

如果取softmax,则softmax(a) > softmax(b)

> softmax(c),softmax把所有的选项都给出概率。

MNIST手写数字识别是一个使用softmax回归(softmax regression)模型的经典案例。softmax模型可以用来给不同的对象分配概率。即使在之后,我们训练更加精细的模型时,最后一步也需要用softmax来分配概率。

下面我们用tensorflow来实现他

import tensorflow as tf

#获取MNIST数据集

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets("F:/MNIST/data/", one_hot=True)

#使用更加方便的InteractiveSession类。

# 通过它可以更加灵活地构建代码。它能让你在运行图的时候,插入一些计算图。

# 如果你没有使用InteractiveSession,那么你需要在启动session之前构建整个计算图,然后启动该计算图。

sess = tf.InteractiveSession()

#x和y并不是特定的值,只是一个占位符,可以在TensorFlow运行某一计算时根据该占位符输入具体的值。

x = tf.placeholder("float", shape=[None, 784])

y_ = tf.placeholder("float", shape=[None, 10])

#一个变量表示TensorFlow计算图中的一个值,能够在计算过程中使用、修改。在机器学习的应用过程中模型参数一般用Variable来表示。

W = tf.Variable(tf.zeros([784, 10]))

b = tf.Variable(tf.zeros([10]))

#计算每个分类的softmax概率值

y = tf.nn.softmax(tf.matmul(x,W) + b)

#损失函数是目标类别和预测类别之间的交叉熵。

#tf.reduce_sum把minibatch里的每张图片的交叉熵值都加起来了。我们计算的交叉熵是指整个minibatch的。

cross_entropy = -tf.reduce_sum(y_*tf.log(y))

# 首先,开始初始化所有的变量

init = tf.global_variables_initializer()

sess.run(init)

#最速下降法让交叉熵下降,步长为0.01.

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy)

for i in range(2000):

batch = mnist.train.next_batch(50)

#在计算图中可以用feed_dict来替代任何张量,并不仅限于替换占位符

train_step.run(feed_dict={x: batch[0], y_: batch[1]})

#tf.argmax 能给出某个tensor对象在某一维上的其数据最大值所在的索引值。

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

#将布尔值转换为浮点数来代表对、错,然后取平均值。

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))

print(accuracy.eval(feed_dict={x: mnist.test.images, y_: mnist.test.labels}))

最终训练出来的结果大概在0.92左右。

下面是一些tensorflow官方文档中对以上代码的解释:

①tensorflow依赖于一个高效的C++后端来进行计算。与后端的连接叫做session。这里我们使用更加方便的InteractiveSession类。通过它我们可以更加方便的构建代码。他能让我们在运行图的时候插入一些计算图。

如果没有使用InteractiveSession,那么则需要在启动Session之前构建整个计算图,然后再启动他。

import tensorflow as tf

sess = tf.InteractiveSession()

②我们把向量化后的图片x和权重矩阵W相乘,再加上偏置量b,然后计算每个分类的softmax概率值

y = tf.nn.softmax(tf.matmul(x,W) + b)

2266

2266

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?