迭代加深搜索

自己看的时候第一遍更本就看不懂。。是很水,但智商捉急也是没有办法的事情。

好在有几个同学已经是做过了这道题并且对迭代加深搜索的思路有了一定的了解,所以在某些不理解的地方询问了一下他们的见解,

真的是很有帮助,也许自己想要想很久才能想明白,还会很痛苦,稍微问一下别人的想法,点上一个方向,剩下的自己就能想得明白了。

迭代加深。

把answer(需要的步数或其他)在主函数里面从零往上递加,此之谓 “层数”,亦可谓之“深度”。用书上的话就是:

从小到大枚举深度上限maxd,每次只考虑深度不超过maxd的节点。

对于可以使用回溯法求解,但是解答树的深度没有明显上限的题目,可以考虑使用迭代加深搜索。

设深度上的上限为maxd(或是设成lim),当前结点n的深度为dep,需要一个乐观估价函数,此函数的作用判断有没有继续dfs下去的必要:

如果在理想乐观状况下,此结点往下dfs都不能达到最终目标要求,则果断需要剪枝。

(妈蛋就是干啊,写到这个地方发现自己的思路有点不清晰,可能有漏洞就回头去研究了一下代码,然后就哭了……自己原来根本没有理解透彻,需要来理清楚~所以又用掉了好长的时间来搞明白某一步是用来干神马的,真是很二。。。)

对于下面这个代码来讲,我迷乱的地方在于每次都是重新递归还是就继续了原来的状态递归。。我一直以为是延续了原来的状态(当然之前还有其他的理解误区……太水了我当时跟本就完全没弄明白啊),但是我发现我想不通,然后一阵狂想,最后还是想不通。。然后就郁闷的从D区回到了宿舍。。然后洗漱之后开始和某小朋友沟通交流了一些事情,某小朋友还是太懂事了搞得自己不开心了,真是笨。。

咳咳扯偏了,,

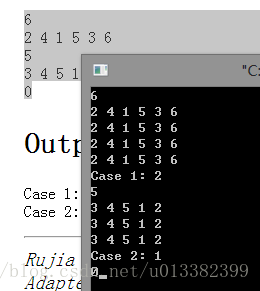

然后我在某小朋友赶我去睡觉之后,偷偷找来代码看了一眼,然后加了如下一组输出判断自己认知上是否有错误,然后特么果然是有错误。。。人家本就是每次重新遍历,根本没有延续状态。。那个类里面的内容我将其误当做全局变量真是要死啊。。

好吧那几行全是一样的输出。。

然后一切问题就算是解决完了,把代码就给出如下。。

卧槽还是很蛋疼这个理解误区,这尼玛太水了吧。。菜鸟果然是菜鸟哦,不知道啥时候能进化。。。。。

#include <iostream>

#include <cstdio>

#include <cstring>

using namespace std;

class Board

{

public:

int a[16];

int h;

int n;

bool readIn()

{

int i;

scanf("%d",&n);

if (n == 0)

return false;

for (i=0; i<n; i++)

{

scanf("%d",a+i);

}

return true;

}

void printOut()

{

int i;

for (i=0; i<n; i++)

{

printf("%d ", a[i]);

}

printf("\n");

printf("h=%d\n",h);

}

void move(int s,int e,int p)

{

int t[16],i,j;

if (p < s)

{

for (i=0; i<p; i++)

{

t[i]=a[i];

}

for (j=s; j<=e; j++,i++)

{

t[i]=a[j];

}

for (j=p; j<s; j++,i++)

{

t[i]=a[j];

}

for (j=e+1; j<n; j++,i++)

{

t[i]=a[j];

}

}

else

{

for (i=0; i<s; i++)

{

t[i]=a[i];

}

for (j=e+1; j<p; j++,i++)

{

t[i]=a[j];

}

for (j=s; j<=e; j++,i++)

{

t[i]=a[j];

}

for (j=p; j<n; j++,i++)

{

t[i]=a[j];

}

}

memcpy(a,t,sizeof(t));

}

int getH()

{

int cnt,i;

cnt=0;

for (i=0; i<n-1; i++)

{

if (a[i+1] != a[i]+1)

cnt++;

}

if (a[i] != n)

cnt++;

h=cnt;

return cnt;

}

};

int lim;

int f(int dep,int h)

{

return dep*3+h;

}

bool IDDFS(int dep,Board b)

{

int i,j,k;

Board tb;

b.getH();

if (f(dep,b.h) > lim*3)

return false;

if (b.getH() == 0)

return true;

for (i=0; i<b.n; i++)

{

for (j=i; j<b.n; j++)

{

for (k=0; k<i; k++)

{

tb=b;

tb.move(i,j,k);

if (IDDFS(dep+1,tb) == true)

return true;

}

for (k=j+2; k<b.n; k++)

{

tb=b;

tb.move(i,j,k);

if (IDDFS(dep+1,tb) == true)

return true;

}

}

}

return false;

}

int main()

{

Board b;

int prob;

prob=1;

while (b.readIn() == true)

{

for (lim=0; ; lim++)

{

for(int i=0;i<b.n;i++)

printf("%d ",b.a[i]);

printf("\n");

if (IDDFS(0,b) == true)

break;

}

printf("Case %d: %d\n",prob,lim);

prob++;

}

}

102

102

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?